天生一对有实证:超融合系统与虚拟化应用

在上一篇文章中,企事录实验室验证了华为FusionCube 9000在关键业务数据库的性能表现:使用三个全NVMe SSD节点作为存储(2副本),搭配两个计算节点作为应用(HA)服务器分离部署,分别满足存储与计算的高可用情况下,在Oracle RAC环境中,取得了270万TPM的数据库性能,并且平均响应时间低至20ms,这样的性能水平几乎能够满足绝大部分企业关键业务提出的苛刻性能需求。

数据库是FusionCube 9000面向的两大应用场景之一,另一个典型应用场景则是高端虚拟化,即可以像市场上的大多数其他超融合产品一样,计算与存储部署在同一节点之上,每一个物理服务器节点上同时运行计算应用和存储服务,利用基于hypervisor的服务器虚拟化技术予以隔离,存储服务可以运行在hypervisor内核层面或单独的虚拟机(VM)中。

与基于物理节点的裸机(bare-metal)方案相比,(基于hypervisor的)虚拟化将计算资源切分为更细的颗粒度,为工作负载提供了更高的灵活性。而安装于虚拟机(VM)中的软件应用,可以在不同物理节点之间迁移,不但便于负载均衡,还可以享受虚拟化平台提供的保障可用性的措施,在高可用性方面往往比物理机环境更为便利。

由于其“生于虚拟化”的特性,超融合系统通常已经为虚拟化场景优化。并且,相对于传统的计算与存储(SAN)分别采购部署的虚拟化方案,超融合系统采用经过厂商验证的一体化交付方式,可以省却多方采购带来的采购周期较长、需要在客户现场整合、维护多方推诿扯皮等各种困扰:

λ 快速部署:超融合系统都支持出厂预装预配置,在用户现场只需简单配置即可投入使用,采购部署周期由原来的数月缩短至以周为单位,单纯部署环节更可以在一天内完成;

λ 统一管理:计算、存储,乃至网络的管理,还有虚拟化的部分管理功能,都统一在同一个管理界面内,利于管理,提高维护效率;

λ 便于扩展:利用分布式技术,超融合系统的计算能力和存储性能均能够随节点数增加而近乎线性的提高,这种横向扩展(Scale-out)能力明显优于传统SAN存储的纵向扩展(Scale-up)方式。

性能满足所需,且运维管理对用户更加友好,至少在虚拟化环境中,传统SAN存储逐渐被超融合系统取代也就水到渠成了。华为在推出FusionCube 9000之后,在已有经验基础上,接连推出了4U4节点形态的FusionCube 6000和2U4节点形态的FusionCube 6000C,以及基于2U通用机架服务器设计的FusionCube 2000等超融合产品,这三大产品都与大多数超融合系统一样面向虚拟化环境(FusionCube 2000还可以用在大容量数据库场景)。

本文将以FusionCube 6000为例,介绍企事录实验室在计算与存储一体的主流“节点级超融合”系统方面的评估实践。

FusionCube 6000:4U4有容乃大

华为FusionCube 6000所基于的服务器硬件平台,是最早符合天蝎多节点服务器规范的产品,支持4U8节点配置——使用全高单槽双路节点XH620 V3,计算密度与传统2U4节点服务器相当。

就超融合系统而言,对存储能力的要求不弱于计算密度,所以FusionCube采用4U4(胖)节点配置,全高双槽双路节点XH628 V3的内部可用空间明显大于常见的2U4节点,特别是4U的高度允许3.5英寸硬盘垂直安装(竖插),这意味着可以容纳更多的硬盘。

华为FusionCube 6000超融合系统,使用4U机箱设计,内部竖插4个XH628 V3全高双槽服务器节点, 每节点均配备了一块双端口万兆网卡,和一个用于iBMC管理的RJ-45网口,同时设计了两个用于安装操作系统的2.5英寸硬盘仓(RAID 1)

华为FusionCube 6000超融合系统,使用4U机箱设计,内部竖插4个XH628 V3全高双槽服务器节点, 每节点均配备了一块双端口万兆网卡,和一个用于iBMC管理的RJ-45网口,同时设计了两个用于安装操作系统的2.5英寸硬盘仓(RAID 1)

XH628实际上由一台双路至强E5服务器+(12盘位)JBOD组成,支持2颗Intel Xeon E5-2600 v3/v4处理器,16根DDR4 DIMM插槽,其JBOD支持最大12个(3.5/2.5英寸)SAS/SATA 硬盘或SSD。在FusionCube 6000中,使用2个SSD作为缓存(Cache/Buffer),10个(3.5/2.5英寸)硬盘作为数据存储;也可在背面的PCIe插槽使用更高速的PCIe (NVMe) SSD作为缓存,单个4U机箱最大支持48(Data)+8(操作系统)个硬盘

XH628实际上由一台双路至强E5服务器+(12盘位)JBOD组成,支持2颗Intel Xeon E5-2600 v3/v4处理器,16根DDR4 DIMM插槽,其JBOD支持最大12个(3.5/2.5英寸)SAS/SATA 硬盘或SSD。在FusionCube 6000中,使用2个SSD作为缓存(Cache/Buffer),10个(3.5/2.5英寸)硬盘作为数据存储;也可在背面的PCIe插槽使用更高速的PCIe (NVMe) SSD作为缓存,单个4U机箱最大支持48(Data)+8(操作系统)个硬盘

FusionCube 6000背部,除了共享的冗余电源和散热设计之外,其还有8个PCIe扩展槽位,每节点最大支持2个PCIe (NVMe) SSD

FusionCube 6000背部,除了共享的冗余电源和散热设计之外,其还有8个PCIe扩展槽位,每节点最大支持2个PCIe (NVMe) SSD

FusionCube 6000最大48个硬盘仓位的设计,是传统2U服务器(12个3.5英寸硬盘仓位)的2倍(4U可容纳24个);如果以节点计,每节点12个3.5英寸硬盘仓位,则是常见2U4节点服务器的4倍(每节点3个)。当然,如果换成2.5英寸SSD,FusionCube 6000相比主流2U4节点服务器的优势就没有那么明显了。

企事录实验室通过合作伙伴借到一台FusionServer X6800服务器平台,在华为的支持下,安装上FusionCube软件,小幅度“改造”为一套FusionCube 6000超融合系统。

企事录实验室基于FusionCube 6000“改造”后的系统,最右三个XH628 V3双槽服务器节点安装FusionCube软件,形成三节点的FusionCube 6000超融合系统;左侧两个为XH620 V3单槽服务器(不带JBOD)

同时,在XH628 V3服务器上进行了部分硬件升级。将原来配置的E5-2609 v3处理器升级为了最新的E5-2650 v4处理器(特别鸣谢Intel公司的大力支持),64GB内存升级为128GB内存。XH628 V3服务器的JBOD部分最多支持12块3.5英寸硬盘,企事录实验室共使用了24个硬盘仓位,每节点8个,其中6个为3.5英寸的希捷4TB大容量磁盘(实际使用5个,作为数据存储),2个为美光480GB SSD(用作缓存)。

安装:一键搞定

目前大多数的超融合系统都基于虚拟化环境,天生就适合运行VDI这样典型的虚拟化应用。一方面是因为超融合的线性扩展能力,只要计算与存储的配比适当,当用户需要增加虚拟桌面的数量时,只需部署或者加入相应数量的FusionCube 6000,接通网络,并简单配置即可。

即使是在用户现场全新部署(比如企事录实验室这套环境),借助华为的配套部署软件,也能实现无人值守一键安装。

华为配套的用于FusionCube超融合系统安装的Builder工具,实际是一个模板虚机,只需要导入这个虚机,然后将其接入到FusionCube同一个网络,就可以一键安装FusionCube系统

华为配套的用于FusionCube超融合系统安装的Builder工具,实际是一个模板虚机,只需要导入这个虚机,然后将其接入到FusionCube同一个网络,就可以一键安装FusionCube系统

此处为FusionCube 6000安装完毕后,其分布式存储的后台管理界面,红框中显示3个节点共15块用作数据存储的SATA HDD

此处为FusionCube 6000安装完毕后,其分布式存储的后台管理界面,红框中显示3个节点共15块用作数据存储的SATA HDD

本次测试的FusionCube 6000分布式存储配置示意图,整个存储池共有15个4TB硬盘作为数据存储,每节点5个SATA HDD;实际共有6个SSD用作缓存,每节点2个,因为2副本数据保护,所以实际1.4TB可用容量

本次测试的FusionCube 6000分布式存储配置示意图,整个存储池共有15个4TB硬盘作为数据存储,每节点5个SATA HDD;实际共有6个SSD用作缓存,每节点2个,因为2副本数据保护,所以实际1.4TB可用容量

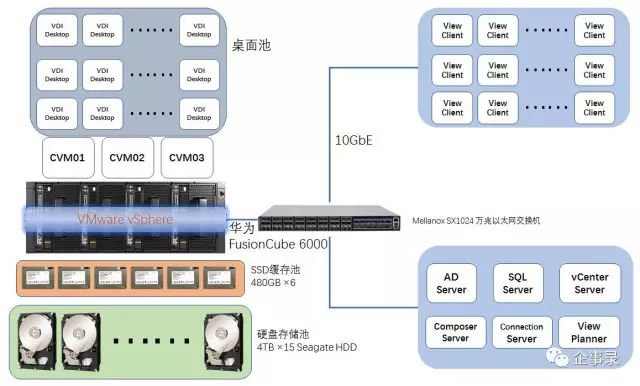

在安装FusionCube 6000超融合系统的同时,企事录实验室在另外两台XH620 V3服务器上安装ESXi系统,并构建VMware Horizon虚拟桌面环境,整个测试架构如下图所示:

企事录实验室构建的VDI测试环境,三节点的FusionCube 6000超融合系统用于构建VDI所需的桌面池。另外两台XH620 V3服务器中的一台用于构建vSphere以及Horizon(图右下部分),另一台则用于生成测试中用于登录VDI的客户端(图右上的View Client),客户端通过网络登录VDI Desktop,其数量等于Desktop的数量

企事录实验室构建的VDI测试环境,三节点的FusionCube 6000超融合系统用于构建VDI所需的桌面池。另外两台XH620 V3服务器中的一台用于构建vSphere以及Horizon(图右下部分),另一台则用于生成测试中用于登录VDI的客户端(图右上的View Client),客户端通过网络登录VDI Desktop,其数量等于Desktop的数量

基于FusionCube 6000的VDI测试点评

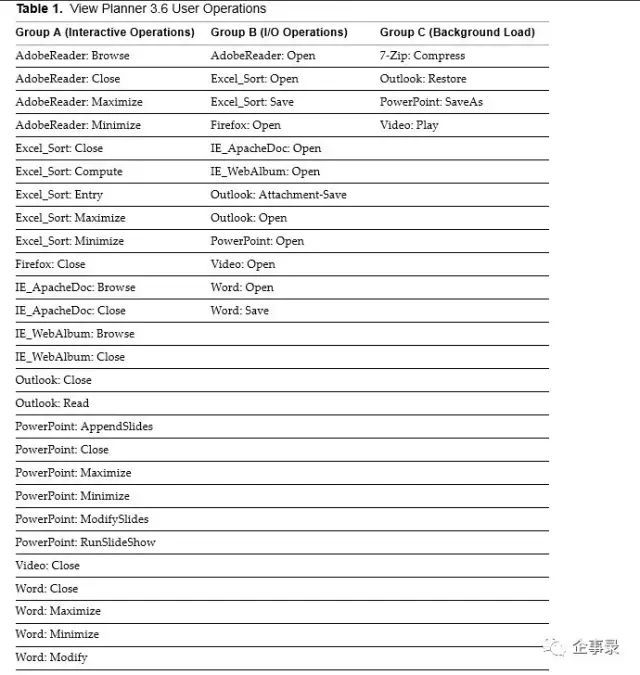

View Planner是VMware公司推出的一个可用于规划Horizon虚拟桌面的工具,同时也可以用于VDI测试以评估基础设施的性能是否满足既定目标数量桌面的需求。View Planner测试主要由9种工作负载,混合模拟44种用户操作行为,并分为三大类:

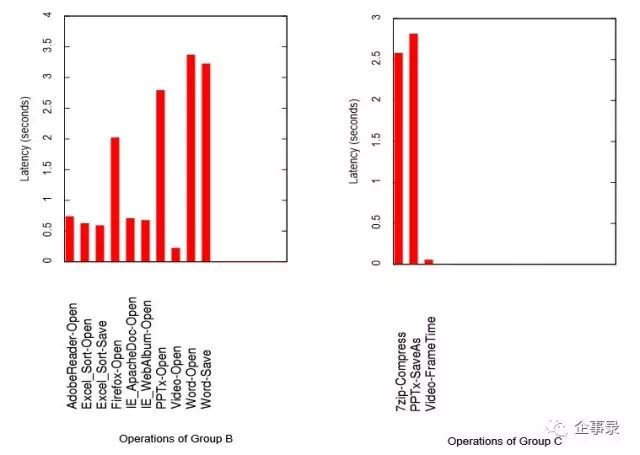

View Planner测试工作负载由Office、视频以及解压缩等9种应用构成,并分为三组考核,A组和B组被用于考察服务质量(QoS),C组用于产生额外负载(可选)。其中A组默认标准的操作响应时间小于1秒,B组小于6秒,被认为测试有效

View Planner测试工作负载由Office、视频以及解压缩等9种应用构成,并分为三组考核,A组和B组被用于考察服务质量(QoS),C组用于产生额外负载(可选)。其中A组默认标准的操作响应时间小于1秒,B组小于6秒,被认为测试有效

企事录实验室按照View Planner基准测试标准进行评估,但需要说明的是,因为服务器数量和配置限制,在本次测试中并没有安装邮件服务器,所以缺失Outlook工作负载。此外,在开始测试时,View Planner会首先下发命令,所有虚机(主要是VDI Desktop和View Client)都会首先执行重启操作,因此测试也有针对“启动风暴”问题进行评估,但并不计入测试成绩。

需要注意的是,在用于VDI场景时,华为建议的FusionCube 6000每节点配置2颗英特尔至强E5-2658A v3(或同级别)处理器,12条32GB内存,总计384GB内存。而企事录实验室中并没有如此多的内存,每节点128GB内存容量只有384GB的三分之一,其中的一半还要划归FusionCube分布式存储调用。正是因为这一限制,导致测试中VDI桌面数量相当有限,三节点共生成100个VDI桌面(1核1GB规格),内存容量就接近上限。

在企事录进行的VDI测试中共使用了100个VDI桌面,通过PCoIP协议从Client登录到VDI Desktop进行测试(网络质量也是影响VDI应用的一大关键)

在企事录进行的VDI测试中共使用了100个VDI桌面,通过PCoIP协议从Client登录到VDI Desktop进行测试(网络质量也是影响VDI应用的一大关键)

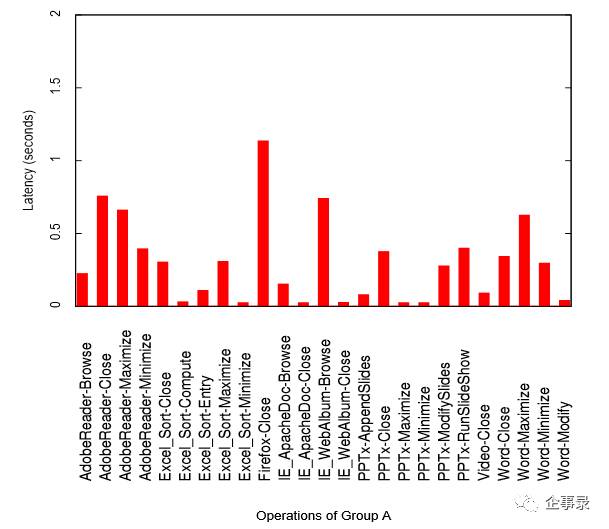

在整个测试过程中,完全由View Planner控制器掌控运行,在运行一段时间之后(VDI桌面数量不同,其运行时间不同),获得测试结果 A、B两组操作行为的平均延时,A组为0.75秒,小于既定的1秒默认标准时间;B组平均延时为3.71秒,小于既定的6秒默认标准时间。上图中的横线(红色线和橙色线)为默认标准时间

A、B两组操作行为的平均延时,A组为0.75秒,小于既定的1秒默认标准时间;B组平均延时为3.71秒,小于既定的6秒默认标准时间。上图中的横线(红色线和橙色线)为默认标准时间

测试结果表明,尽管是较低配置的FusionCube 6000系统,其也能支持100个VDI桌面用户,不管是A还B组的操作响应时间都低于标准响应时间,具有较好的用户体验。这表明计算、存储以及网络均满足VDI所需。尤其是存储子系统,尽管FusionCube分布式存储系统使用相对慢速的3.5英寸磁盘,但有SATA SSD作为高速缓存,显著提高了整个存储系统的性能表现。

以下为各用户操作负载打开、关闭的延时:

从上图可以看出,在A组操作延时中,除了FireFox在关闭时的延时超过1秒之外,其他负载的延时均小于1秒

从上图可以看出,在A组操作延时中,除了FireFox在关闭时的延时超过1秒之外,其他负载的延时均小于1秒

上图为A组测试中各项操作的平均响应时间,除了在FireFox浏览器关闭操作响应时间超过了1秒,其他包括AdobeReader、IE以及Office(Word、Excel和PowerPoint)等操作时间都小于1秒,所有操作行为的平均响应时间仅为0.75秒,具有很好的用户体验。

B组与C组的操作延迟,均小于3.5秒,远低于默认标准的6秒延时

B组与C组的操作延迟,均小于3.5秒,远低于默认标准的6秒延时

在B组操作中,响应时间较长的几个行为分别是打开和保存一个较大的Word文档,以及打开一个较大的PowerPoint文档,这几个操作的响应时间都在3秒左右,相对于在PC端打开一个超过3MB大小的Word或者PowerPoint文件,VDI也不落下风。同样,C组主要是压缩文件和保存PowerPoint文件这两个操作耗时较长,但并未超过3秒,并不弱于传统PC机。能够获得不弱于传统(单机部署)桌面环境的用户体验,证明这套VDI环境具有很好的性能。

除了View Planner提供的测试结果之外,企事录还附录了FusionCube 6000后台管理界面和vSphere vCenter服务器中的部分监控截图:

FusionCube 6000后台监控中所显示的存储性能状况,根据企事录实验室的观察和推测,上图中的第一个I/O波峰(持续时间较短)应为所有VDI桌面在短时间内并发重启产生的I/O尖峰;第二个波峰(持续时间较长)应为VDI测试正常运行,所有VDI桌面同时运行用户负载导致

FusionCube 6000后台监控中所显示的存储性能状况,根据企事录实验室的观察和推测,上图中的第一个I/O波峰(持续时间较短)应为所有VDI桌面在短时间内并发重启产生的I/O尖峰;第二个波峰(持续时间较长)应为VDI测试正常运行,所有VDI桌面同时运行用户负载导致

在VMware vCenter服务器监控的FusionCube 6000集群总CPU负载情况。其中23点~1点的波峰主要是生成100台VDI桌面导致的性能波峰,生成完毕,CPU占用率下降;7点后的波峰为VDI测试导致的

在VMware vCenter服务器监控的FusionCube 6000集群总CPU负载情况。其中23点~1点的波峰主要是生成100台VDI桌面导致的性能波峰,生成完毕,CPU占用率下降;7点后的波峰为VDI测试导致的

上图为VMware vCenter服务器中监控到FusionCube 6000集群已消耗的内存总量,可以看出,内存消耗已经接近物理内存极限

上图为VMware vCenter服务器中监控到FusionCube 6000集群已消耗的内存总量,可以看出,内存消耗已经接近物理内存极限

从本次测试来看,由于内存容量配置较低,导致不能生成更多的VDI桌面。从各方面获得的数据进行统计分析,整个FusionCube 6000系统的计算能力还有大量富余,View Planner测试结果也显示,FusionCube存储子系统的性能也应有富余(A/B两组操作均小于标准时间),但由于内存达到上限,无法生成更多VDI桌面。

结语

华为FusionCube 6000采用4U4节点设计,在FusionCube分布式存储软件的支持下,即使是SATA SSD作为低速大容量磁盘缓存层使用的配置,也已能满足虚拟环境下的性能需求,还能有效缓解虚拟化环境需要更高存储容量的问题。对FusionCube 6000超融合系统进行的VDI测试结果显示,三节点共100VDI桌面(受内存限制无法生成更多桌面)的性能良好,Office、视频以及浏览器等应用都能正常运行,且响应时间远低于设定的阈值。我们估计,如果能够提升内存容量(例如使用FusionCube 6000推荐配置),能够支持的VDI桌面应该可以达到数倍之多。

青云QingCloud & 企事录 混合云实验室

本次测试在企事录技术服务公司(简称“企事录”,网址:testlab.com.cn)与企业级基础云服务商青云QingCloud(qingcloud.com)共同建立的混合云实验室进行。以此联合实验室为基础,双方将通过对各类软件、硬件进行科学研究和探索,探索不同行业用户上云的最佳实践,助力混合云解决方案落地。