Caffe 代码解读之全连接层 inner product layer

今天来看一下全连接层的代码。首先,我们要知道全连接层在做什么。先来看一下caffe的官方文档,介绍如下:

可以看到,输入为n c h w,输出为n c_o 1 1

那么,它究竟做了什么那?

假设conv2的输入是256*27*27,那么conv2的输出即50*22*22,conv2的输入即

pool2的输入,pool2的输出为50*11*11,即ip1的输入,ip1的输出为500*1*1,那

么pool2->ip1的参数个数是多少呢?这里就要理解好什么是fully_connected了,

即wTx,x为列向量,w的长度与x相同。在本文的例子中x的维度为50*11*11,那么

pool2->ip1的参数个数为500*50*11*11 。50*11*11即是一个有50个通道大小为

11*11的图片,那么在做完全卷积的时候,需要把对所有通道一起作卷积,即把图

片转化成一个50*11*11的向量

上段话转自http://www.cnblogs.com/dupuleng/articles/4312149.html

我们再来看一下它的头文件,其中有以下参数:

同大部分layer层一样,它也必须实现setup、reshape、Forward_cpu、Backward_cpu。

* 其中,setup定义参数:M_样本个数、K_单个样本特征长度、N_全连接之后神经元的个数。

* Forward_cpu,主要是计算y=W’*x + b, X表示输入,y表示输出 。x为输入,维度 M_*K_ 、 y为输出,维度 M_*N_ 、W为权重,维度 N_*K_, W_diff权重的梯度维度也为N_*K_ 、 b为偏置,维度 N_*1_ 。

* Backward_cpu:反向传播就是在更新w、b,计算delta。

我们来具体看一下代码:

#include ::LayerSetUp(const vector(weight_shape));

// fill the weights

//根据配置文件中的权重核( weight_filler )的类型初始化填充权重矩阵blobs_[0];

shared_ptr > weight_filler(GetFiller(

this->layer_param_.inner_product_param().weight_filler()));

weight_filler->Fill(this->blobs_[0].get());

// If necessary, intiialize and fill the bias term

//填充偏置矩阵blobs_[1],每个输出单元对应一个偏置,共N_个

if (bias_term_) {

vector<int> bias_shape(1, N_);

this->blobs_[1].reset(new Blob(bias_shape));

shared_ptr > bias_filler(GetFiller(

this->layer_param_.inner_product_param().bias_filler()));

bias_filler->Fill(this->blobs_[1].get());

}

} // parameter initialization

this->param_propagate_down_.resize(this->blobs_.size(), true);

}

template <typename Dtype>

//一批次处理多个样本,在每一批次中权重矩阵与偏置矩阵是不变的

void InnerProductLayer::Reshape(const vector::Forward_cpu(const vector(CblasNoTrans, CblasTrans, M_, N_, K_, (Dtype)1.,

bottom_data, weight, (Dtype)0., top_data);

// 表示y= y + b (bias_multiplier维度为M_*1, b为1*N_(b实际上是N_*1,但是存储方式与1*N_等价,

// top_data为M_*N_)

// 实际是相当于将b复制成了M_*N_的矩阵,类似matlab的repmat(b, [M_, 1]),然后和top_data相加

if (bias_term_) {

caffe_cpu_gemm(CblasNoTrans, CblasNoTrans, M_, N_, 1, (Dtype)1.,

bias_multiplier_.cpu_data(),

this->blobs_[1]->cpu_data(), (Dtype)1., top_data);

}

}

template <typename Dtype>

void InnerProductLayer::Backward_cpu(const vector(CblasTrans, CblasNoTrans, N_, K_, M_, (Dtype)1.,

top_diff, bottom_data, (Dtype)0., this->blobs_[0]->mutable_cpu_diff());

}

if (bias_term_ && this->param_propagate_down_[1]) {

const Dtype* top_diff = top[0]->cpu_diff();

// Gradient with respect to bias

// top_diff(M_*N_), bias_multiplier(M_*1), b_diff(N_1)

// b_diff = top_diff' * bias_multiplier, 注意和gemm接口的区别

caffe_cpu_gemv(CblasTrans, M_, N_, (Dtype)1., top_diff,

bias_multiplier_.cpu_data(), (Dtype)0.,

this->blobs_[1]->mutable_cpu_diff());

}

if (propagate_down[0]) {

const Dtype* top_diff = top[0]->cpu_diff();

// Gradient with respect to bottom data

// A(top_diff) M_*N_ , B(weight) N_*K_, C(bottom_diff) M_*K_

// bottom_diff = top_diff * weight

caffe_cpu_gemm(CblasNoTrans, CblasNoTrans, M_, K_, N_, (Dtype)1.,

top_diff, this->blobs_[0]->cpu_data(), (Dtype)0.,

bottom[0]->mutable_cpu_diff());

}

}

#ifdef CPU_ONLY

STUB_GPU(InnerProductLayer);

#endif

INSTANTIATE_CLASS(InnerProductLayer);

REGISTER_LAYER_CLASS(InnerProduct);

} // namespace caffe

这里有三点要介绍一下:

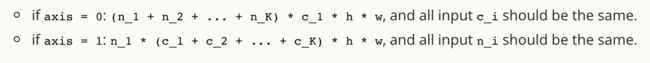

(1)axis的理解,这里,在官方文档中介绍如下:

在这里,axis=1,也就是说,我们从c开始暂开,这里n代表的是样本个数。

(2)这里涉及到一个函数,caffe_cpu_gemm,它的实现如下:

void caffe_cpu_gemm<float>(const CBLAS_TRANSPOSE TransA,

const CBLAS_TRANSPOSE TransB, const int M, const int N, const int K,

const float alpha, const float* A, const float* B, const float beta,

float* C) {

int lda = (TransA == CblasNoTrans) ? K : M;

int ldb = (TransB == CblasNoTrans) ? N : K;

cblas_sgemm(CblasRowMajor, TransA, TransB, M, N, K, alpha, A, lda, B,

ldb, beta, C, N);

}也就是矩阵相乘后相加,功能: C(vetor)←alpba*AB+ beta*C. This function multiplies A * C (after transposing A, if needed) and multiplies the resulting matrix by alpha. It then multiplies vector C by beta. It stores the sum of these two products in vector C.

(3)caffe_cpu_gemv,是矩阵相乘,功能: C(vetor)←alpba*AB+ beta*C. This function multiplies A * C (after transposing A, if needed) and multiplies the resulting matrix by alpha. It then multiplies vector C by beta. It stores the sum of these two products in vector C.