(10)Java爬虫框架webmagic学习笔记

Java爬虫框架webmagic学习笔记

参考自:webmagic文档

webmagic简介

webmagic的github网址:https://github.com/code4craft/webmagic

使用webmagic的原因:

- webmagic是一个无须配置、便于二次开发的爬虫框架,它提供简单灵活的API,只需少量代码即可实现一个爬虫。

- webmagic采用完全模块化的设计,功能覆盖整个爬虫的生命周期(链接提取、页面下载、内容抽取、持久化),支持多线程抓取,分布式抓取,url自动去重,并支持自动重试、自定义UA/cookie等功能。

- webmagic包含强大的页面抽取功能,开发者可以便捷的使用css selector、xpath和正则表达式进行链接和内容的提取,支持多个选择器链式调用。

- webmagic也可以很方便的作为一个模块,嵌入Java项目中运行。

- 文档相对齐全。

webmagic的主要特色:

- 完全模块化的设计,强大的可扩展性。

- 核心简单但是涵盖爬虫的全部流程,灵活而强大,也是学习爬虫入门的好材料。

- 提供丰富的抽取页面API。

- 无配置,但是可通过POJO+注解形式实现一个爬虫。

- 支持多线程。

- 支持分布式。

- 支持爬取js动态渲染的页面。

- 无框架依赖,可以灵活的嵌入到项目中去。

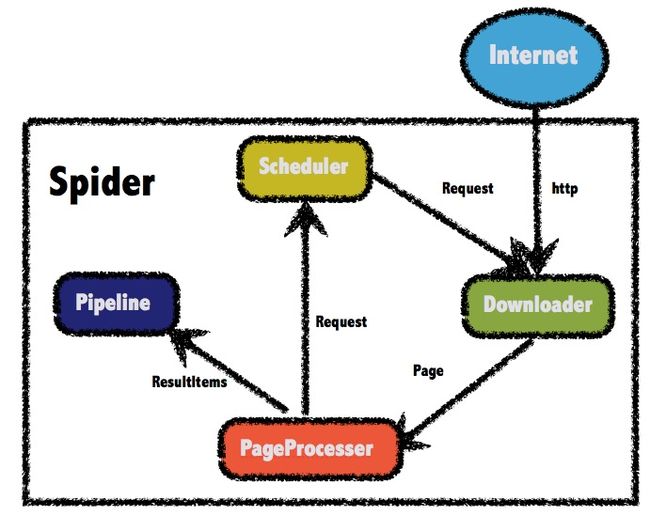

总体架构

WebMagic的结构分为Downloader、PageProcessor、Scheduler、Pipeline四大组件,并由Spider将它们彼此组织起来,让它们可以互相交互,流程化地执行。这四大组件对应爬虫生命周期中的下载、处理、管理和持久化等功能。

WebMagic总体架构图如下:

WebMagic的四个组件

1. Downloader

Downloader负责从互联网上下载页面,以便后续处理。WebMagic默认使用了Apache HttpClient作为下载工具。

2. PageProcessor

PageProcessor负责解析页面,抽取有用信息,以及发现新的链接。WebMagic使用Jsoup作为HTML解析工具,并基于其开发了解析XPath的工具Xsoup。

在这四个组件中,PageProcessor对于每个站点每个页面都不一样,是需要使用者定制的部分。

3. Scheduler

Scheduler负责管理待抓取的URL,以及一些去重的工作。WebMagic默认提供了JDK的内存队列来管理URL,并用集合来进行去重。也支持使用Redis进行分布式管理。

除非项目有一些特殊的分布式需求,否则无需自己定制Scheduler。

4. Pipeline

Pipeline负责抽取结果的处理,包括计算、持久化到文件、数据库等。WebMagic默认提供了“输出到控制台”和“保存到文件”两种结果处理方案。

Pipeline定义了结果保存的方式,如果你要保存到指定数据库,则需要编写对应的Pipeline。对于一类需求一般只需编写一个Pipeline。

用于数据流转的对象

1. Request

Request是对URL地址的一层封装,一个Request对应一个URL地址。

它是PageProcessor与Downloader交互的载体,也是PageProcessor控制Downloader唯一方式。

除了URL本身外,它还包含一个Key-Value结构的字段extra。你可以在extra中保存一些特殊的属性,然后在其他地方读取,以完成不同的功能。例如附加上一个页面的一些信息等。

2. Page

Page代表了从Downloader下载到的一个页面——可能是HTML,也可能是JSON或者其他文本格式的内容。

Page是WebMagic抽取过程的核心对象,它提供一些方法可供抽取、结果保存等。在第四章的例子中,我们会详细介绍它的使用。

3. ResultItems

ResultItems相当于一个Map,它保存PageProcessor处理的结果,供Pipeline使用。它的API与Map很类似,值得注意的是它有一个字段skip,若设置为true,则不应被Pipeline处理。

使用maven安装webmagic框架

webmagic使用maven管理依赖,在项目中添加对应的依赖即可使用webmagic:

us.codecraft

webmagic-core

0.7.3

us.codecraft

webmagic-extension

0.7.3

WebMagic 使用slf4j-log4j12作为slf4j的实现.如果你自己定制了slf4j的实现,请在项目中去掉此依赖。

org.slf4j

slf4j-log4j12

项目结构

webmagic主要包括两个包:

-

webmagic-core

webmagic核心部分,只包含爬虫基本模块和基本抽取器。webmagic-core的目标是成为网页爬虫的一个教科书般的实现。

-

webmagic-extension

webmagic的扩展模块,提供一些更方便的编写爬虫的工具。包括注解格式定义爬虫、JSON、分布式等支持。

webmagic还包含两个可用的扩展包,因为这两个包都依赖了比较重量级的工具,所以从主要包中抽离出来,这些包需要下载源码后自己编译::

-

webmagic-saxon

webmagic与Saxon结合的模块。Saxon是一个XPath、XSLT的解析工具,webmagic依赖Saxon来进行XPath2.0语法解析支持。

-

webmagic-selenium

webmagic与Selenium结合的模块。Selenium是一个模拟浏览器进行页面渲染的工具,webmagic依赖Selenium进行动态页面的抓取。

在项目中,你可以根据需要依赖不同的包。

通过PageProcessor实现基本的爬虫

PageProcessor的定制分为三个部分,分别是爬虫的配置、页面元素的抽取和链接的发现。

public class GithubRepoPageProcessor implements PageProcessor {

// 部分一:抓取网站的相关配置,包括编码、抓取间隔、超时时间、重试次数等,也包括一些模拟的参数,例如User Agent、cookie,以及代理的设置

private Site site = Site.me().setRetryTimes(3).setSleepTime(1000);

@Override

// process是定制爬虫逻辑的核心接口,在这里编写抽取逻辑

public void process(Page page) {

// 部分二:定义如何抽取页面信息,并保存下来

page.putField("author", page.getUrl().regex("https://github\\.com/(\\w+)/.*").toString());

page.putField("name", page.getHtml().xpath("//h1[@class='entry-title public']/strong/a/text()").toString());

if (page.getResultItems().get("name") == null) {

//skip this page

page.setSkip(true);

}

page.putField("readme", page.getHtml().xpath("//div[@id='readme']/tidyText()"));

// 部分三:从页面发现后续的url地址来抓取

page.addTargetRequests(page.getHtml().links().regex("(https://github\\.com/[\\w\\-]+/[\\w\\-]+)").all());

}

@Override

public Site getSite() {

return site;

}

public static void main(String[] args) {

Spider.create(new GithubRepoPageProcessor())

//从"https://github.com/code4craft"开始抓

.addUrl("https://github.com/code4craft")

//开启5个线程抓取

.thread(5)

//启动爬虫

.run();

}

}

1. 配置Site

通过设置Site对象来配置爬虫的编码、抓取间隔、超时时间、重试次数等,以及一些模拟的参数,例如User Agent、cookie,和代理的设置等。

| 方法 | 说明 | 示例 |

|---|---|---|

| setCharset(String) | 设置编码 | site.setCharset(“utf-8”) |

| setUserAgent(String) | 设置UserAgent | site.setUserAgent(“Spider”) |

| setTimeOut(int) | 设置超时时间,单位是毫秒 | site.setTimeOut(3000) |

| setRetryTimes(int) | 设置重试次数 | site.setRetryTimes(3) |

| setCycleRetryTimes(int) | 设置循环重试次数 | site.setCycleRetryTimes(3) |

| addCookie(String,String) | 添加一条cookie | site.addCookie(“dotcomt_user”,“code4craft”) |

| setDomain(String) | 设置域名,需设置域名后,addCookie才可生效 | site.setDomain(“github.com”) |

| addHeader(String,String) | 添加一条addHeader | site.addHeader(“Referer”,“https://github.com”) |

| setHttpProxy(HttpHost) | 设置Http代理 | site.setHttpProxy(new HttpHost(“127.0.0.1”,8080)) |

循环重试cycleRetry机制会将下载失败的url重新放入队列尾部重试,直到达到重试次数,以保证不因为某些网络原因漏抓页面。

2. 抽取页面元素

WebMagic里主要使用了三种抽取技术:XPath、正则表达式和CSS选择器。另外,对于JSON格式的内容,可使用JsonPath进行解析。

page.getHtml()返回的是一个Html对象,它实现了Selectable接口。使用Selectable接口,你可以直接完成页面元素的链式抽取,而无需去关心抽取的细节。这个接口的方法可分为两类:抽取元素API和获取结果API。

抽取元素API

| 方法 | 说明 | 示例 |

|---|---|---|

| xpath(String xpath) | 使用XPath选择 | html.xpath("//div[@class=‘title’]") |

| $(String selector) | 使用Css选择器选择 | html.$(“div.title”) |

| $(String selector,String attr) | 使用Css选择器选择 | html.$(“div.title”,“text”) |

| css(String selector) | 功能同$(),使用Css选择器选择 | html.css(“div.title”) |

| links() | 选择所有链接 | html.links() |

| regex(String regex) | 使用正则表达式抽取 | html.regex(" (.*?)") |

| regex(String regex,int group) | 使用正则表达式抽取,并指定捕获组 | html.regex(" (.*?)",1) |

| replace(String regex, String replacement) | 替换内容 | html.replace("","") |

抽取元素API返回的都是一个Selectable接口,意思是说,抽取是支持链式调用的。

获取结果API

当链式调用结束时,我们一般都想要拿到一个字符串类型的结果。这时候就需要用到获取结果的API了。我们知道,一条抽取规则,无论是XPath、CSS选择器或者正则表达式,总有可能抽取到多条元素。WebMagic对这些进行了统一,你可以通过不同的API获取到一个或者多个元素。

| 方法 | 说明 | 示例 |

|---|---|---|

| get() | 返回一条String类型的结果 | String link= html.links().get() |

| toString() | 功能同get(),返回一条String类型的结果 | String link= html.links().toString() |

| all() | 返回所有抽取结果 | List links= html.links().all() |

| match() | 是否有匹配结果 | if (html.links().match()){ xxx; } |

3. 链接的发现

发现后续的链接,是一个爬虫不可缺少的一部分。

page.addTargetRequests(page.getHtml().links().regex("(https://github\\.com/\\w+/\\w+)").all());

page.addTargetRequests()用于将新链接加入到待抓取的队列中去。

4. 启动爬虫Spider

Spider是爬虫启动的入口。在启动爬虫之前,我们需要使用一个PageProcessor创建一个Spider对象,然后使用run()进行启动。同时Spider的其他组件(Downloader、Scheduler、Pipeline)都可以通过set方法来进行设置。

| 方法 | 说明 | 示例 |

|---|---|---|

| create(PageProcessor) | 创建Spider | Spider.create(new GithubRepoProcessor()) |

| addUrl(String…) | 添加初始的URL | spider .addUrl(“http://webmagic.io/docs/”) |

| addRequest(Request…) | 添加初始的Request | spider .addRequest(“http://webmagic.io/docs/”) |

| thread(n) | 开启n个线程 | spider.thread(5) |

| run() | 启动,会阻塞当前线程执行 | spider.run() |

| start()/runAsync() | 异步启动,当前线程继续执行 | spider.start() |

| stop() | 停止爬虫 | spider.stop() |

| test(String) | 抓取一个页面进行测试 | spider .test(“http://webmagic.io/docs/”) |

| addPipeline(Pipeline) | 添加一个Pipeline,一个Spider可以有多个Pipeline | spider .addPipeline(new ConsolePipeline()) |

| setScheduler(Scheduler) | 设置Scheduler,一个Spider只能有个一个Scheduler | spider.setScheduler(new RedisScheduler()) |

| setDownloader(Downloader) | 设置Downloader,一个Spider只能有个一个Downloader | spider .setDownloader(new SeleniumDownloader()) |

| get(String) | 同步调用,并直接取得结果 | ResultItems result = spider .get(“http://webmagic.io/docs/”) |

| getAll(String…) | 同步调用,并直接取得一堆结果 | List results = spider .getAll(“http://webmagic.io/docs/”, “http://webmagic.io/xxx”) |

5. 使用Pipeline保存结果

WebMagic用于保存结果的组件叫做Pipeline。例如我们通过“控制台输出结果”这件事也是通过一个内置的Pipeline完成的,它叫做ConsolePipeline。如果想把结果用Json的格式保存下来,只需将Pipeline的实现换成"JsonFilePipeline"就可以了。

public static void main(String[] args) {

Spider.create(new GithubRepoPageProcessor())

//从"https://github.com/code4craft"开始抓

.addUrl("https://github.com/code4craft")

.addPipeline(new JsonFilePipeline("D:\\webmagic\\"))

//开启5个线程抓取

.thread(5)

//启动爬虫

.run();

}

WebMagic中已经提供了将结果输出到控制台、保存到文件和JSON格式保存的几个Pipeline:

| 类 | 说明 | 备注 |

|---|---|---|

| ConsolePipeline | 输出结果到控制台 | 抽取结果需要实现toString方法 |

| FilePipeline | 保存结果到文件 | 抽取结果需要实现toString方法 |

| JsonFilePipeline | JSON格式保存结果到文件 | |

| ConsolePageModelPipeline | (注解模式)输出结果到控制台 | |

| FilePageModelPipeline | (注解模式)保存结果到文件 | |

| JsonFilePageModelPipeline | (注解模式)JSON格式保存结果到文件 | 想要持久化的字段需要有getter方法 |

6. 处理非HTTP GET请求

采用在Request对象上添加Method和requestBody来实现POST请求。

Request request = new Request("http://xxx/path");

request.setMethod(HttpConstant.Method.POST);

request.setRequestBody(HttpRequestBody.json("{'id':1}","utf-8"));

HttpRequestBody内置了几种初始化方式,支持最常见的表单提交、json提交等方式。

| API | 说明 |

|---|---|

| HttpRequestBody.form(Map |

使用表单提交的方式 |

| HttpRequestBody.json(String json, String encoding) | 使用JSON的方式,json是序列化后的结果 |

| HttpRequestBody.xml(String xml, String encoding) | 设置xml的方式,xml是序列化后的结果 |

| HttpRequestBody.custom(byte[] body, String contentType, String encoding) | 设置自定义的requestBody |

使用Scheduler

Scheduler是WebMagic中进行URL管理的组件。一般来说,Scheduler包括两个作用:

- 对待抓取的URL队列进行管理。

- 对已抓取的URL进行去重。

WebMagic内置了几个常用的Scheduler。

| 类 | 说明 | 备注 |

|---|---|---|

| DuplicateRemovedScheduler | 抽象基类,提供一些模板方法 | 继承它可以实现自己的功能 |

| QueueScheduler | 使用内存队列保存待抓取URL | |

| PriorityScheduler | 使用带有优先级的内存队列保存待抓取URL | 耗费内存较QueueScheduler更大,但是当设置了request.priority之后,只能使用PriorityScheduler才可使优先级生效 |

| FileCacheQueueScheduler | 使用文件保存抓取URL,可以在关闭程序并下次启动时,从之前抓取到的URL继续抓取 | 需指定路径,会建立.urls.txt和.cursor.txt两个文件 |

| RedisScheduler | 使用Redis保存抓取队列,可进行多台机器同时合作抓取 | 需要安装并启动redis |

使用注解编写爬虫

WebMagic支持使用独有的注解风格编写一个爬虫,引入webmagic-extension包即可使用此功能。

在注解模式下,使用一个简单对象加上注解,可以用极少的代码量就完成一个爬虫的编写。

注解模式的开发方式是这样的:

- 首先定义你需要抽取的数据,并编写类。

- 在类上写明

@TargetUrl注解,定义对哪些URL进行下载和抽取。 - 在类的字段上加上

@ExtractBy注解,定义这个字段使用什么方式进行抽取。 - 定义结果的存储方式。

定义Model类来实现爬虫

定义一个Model类来抽取一个github项目的名称、作者和简介三个信息。

@TargetUrl("https://github.com/\\w+/\\w+")

@HelpUrl("https://github.com/\\w+")

public class GithubRepo {

@ExtractBy(value = "//h1[@class='entry-title public']/strong/a/text()", notNull = true)

private String name;

@ExtractByUrl("https://github\\.com/(\\w+)/.*")

private String author;

@ExtractBy("//div[@id='readme']/tidyText()")

private String readme;

public static void main(String[] args) {

OOSpider.create(Site.me().setSleepTime(1000)

, new ConsolePageModelPipeline(), GithubRepo.class)

.addUrl("https://github.com/code4craft").thread(5).run();

}

}

1. 定义抓取的Url

HelpUrl/TargetUrl是一个非常有效的爬虫开发模式,TargetUrl是我们最终要抓取的URL,最终想要的数据都来自这里;而HelpUrl则是为了发现这个最终URL,我们需要访问的页面。WebMagic定制了适合HelpUrl/TargetUrl的URL的正则表达式,主要有两点改动:

- 将URL中常用的字符

.默认做了转义,变成了\. - 将"*“替换成了”.*",直接使用可表示通配符。

2. 抽取页面元素

@ExtractBy是一个用于抽取元素的注解,它描述了一种抽取规则。@ExtractBy注解主要作用于字段,它表示“使用这个抽取规则,将抽取到的结果保存到这个字段中”。

@ExtractByUrl是一个单独的注解,它的意思是“从URL中进行抽取”。它只支持正则表达式作为抽取规则。

3. 爬虫的创建和启动

注解模式的入口是OOSpider,它继承了Spider类,提供了特殊的创建方法,其他的方法是类似的。创建一个注解模式的爬虫需要一个或者多个Model类,以及一个或者多个PageModelPipeline——定义处理结果的方式。

public static OOSpider create(Site site, PageModelPipeline pageModelPipeline, Class... pageModels);

4. PageModelPipeline

注解模式下,处理结果的类叫做PageModelPipeline,通过实现它,你可以自定义自己的结果处理方式。

public interface PageModelPipeline {

public void process(T t, Task task);

}

PageModelPipeline与Model类是对应的,多个Model可以对应一个PageModelPipeline。除了创建时,你还可以通过

public OOSpider addPageModel(PageModelPipeline pageModelPipeline, Class... pageModels)

方法,在添加一个Model的同时,可以添加一个PageModelPipeline。

Formatter类型转换

因为抽取到的内容总是String,而我们想要的内容则可能是其他类型。Formatter可以将抽取到的内容,自动转换成一些基本类型,而无需手动使用代码进行转换。

自动转换支持所有基本类型和装箱类型。另外,还支持java.util.Date类型的转换。但是在转换时,需要指定Date的格式。格式按照JDK的标准来定义。

@Formatter("yyyy-MM-dd HH:mm")

@ExtractBy("//div[@class='BlogStat']/regex('\\d+-\\d+-\\d+\\s+\\d+:\\d+')")

private Date date;

显式指定转换类型

一般情况下,Formatter会根据字段类型进行转换,但是特殊情况下,我们会需要手动指定类型。这主要发生在字段是List类型的时候。

@Formatter(value = "",subClazz = Integer.class)

@ExtractBy(value = "//div[@class='id']/text()", multi = true)

private List ids;

自定义Formatter(TODO)

实际上,除了自动类型转换之外,Formatter还可以做一些结果的后处理的事情。例如,我们有一种需求场景,需要将抽取的结果作为结果的一部分,拼接上一部分字符串来使用。在这里,我们定义了一个StringTemplateFormatter。

public class StringTemplateFormatter implements ObjectFormatter {

private String template;

@Override

public String format(String raw) throws Exception {

return String.format(template, raw);

}

@Override

public Class clazz() {

return String.class;

}

@Override

public void initParam(String[] extra) {

template = extra[0];

}

}

那么,我们就能在抽取之后,做一些简单的操作了!

@Formatter(value = "author is %s",formatter = StringTemplateFormatter.class)

@ExtractByUrl("https://github\\.com/(\\w+)/.*")

private String author;

AfterExtractor

有的时候,注解模式无法满足所有需求,我们可能还需要写代码完成一些事情,这个时候就要用到AfterExtractor接口了。

public interface AfterExtractor {

public void afterProcess(Page page);

}

afterProcess方法会在抽取结束,字段都初始化完毕之后被调用,可以处理一些特殊的逻辑。

//TargetUrl的意思是只有以下格式的URL才会被抽取出生成model对象

//这里对正则做了一点改动,'.'默认是不需要转义的,而'*'则会自动被替换成'.*',因为这样描述URL看着舒服一点...

//继承jfinal中的Model

//实现AfterExtractor接口可以在填充属性后进行其他操作

@TargetUrl("http://my.oschina.net/flashsword/blog/*")

public class OschinaBlog extends Model implements AfterExtractor {

//用ExtractBy注解的字段会被自动抽取并填充

//默认是xpath语法

@ExtractBy("//title")

private String title;

//可以定义抽取语法为Css、Regex等

@ExtractBy(value = "div.BlogContent", type = ExtractBy.Type.Css)

private String content;

//multi标注的抽取结果可以是一个List

@ExtractBy(value = "//div[@class='BlogTags']/a/text()", multi = true)

private List tags;

@Override

public void afterProcess(Page page) {

//jfinal的属性其实是一个Map而不是字段,没关系,填充进去就是了

this.set("title", title);

this.set("content", content);

this.set("tags", StringUtils.join(tags, ","));

//保存

save();

}

public static void main(String[] args) {

C3p0Plugin c3p0Plugin = new C3p0Plugin("jdbc:mysql://127.0.0.1/blog?characterEncoding=utf-8", "blog", "password");

c3p0Plugin.start();

ActiveRecordPlugin activeRecordPlugin = new ActiveRecordPlugin(c3p0Plugin);

activeRecordPlugin.addMapping("blog", OschinaBlog.class);

activeRecordPlugin.start();

//启动webmagic

OOSpider.create(Site.me().addStartUrl("http://my.oschina.net/flashsword/blog/145796"), OschinaBlog.class).run();

}

}