tessorflow实战

文章目录

- tessorflow实战

- TensorFlow 实现Softmax Regression识别手写数字

tessorflow实战

TensorFlow 实现Softmax Regression识别手写数字

数据集下载链接地址https://my.oschina.net/chkui/blog/888346

(扩展:tessorflow模型下载地址 https://github.com/tensorflow/models )

i 代表第几类,

x 一张图片

j一张图片的第几个像素

下面的代码下载的数据集位置与执行文件在同一个文件夹中。

步骤:

首先在训练集上训练模型,

然后在验证集上检验效果并决定何时完成训练,

最后在验证集测评模型的效果。

"""

作者:FLY

功能:实现softmax regression 识别手写数字

2.0:数据集位置与执行文件在同一个文件夹中

版本:2.0

日期:05/23/2019

"""

import tensorflow.examples.tutorials.mnist.input_data as input_data

mnist = input_data.read_data_sets("D:/software/pycharm/shizhan/softmax/MNIST_data/", one_hot=True) # 读取数据集

print(mnist.train.images.shape, mnist.train.labels.shape) # 训练集

print(mnist.test.images.shape, mnist.test.labels.shape) # 测试集

print(mnist.validation.images.shape, mnist.validation.labels.shape) # 验证集

import tensorflow as tf

x = tf.placeholder(tf.float32, [None, 784]) # 创建输入数据的地方,数据类型float32,数据尺寸[None, 784]。None表示不限条数的输入,784是每条输入是一个784维的向量

W = tf.Variable(tf.zeros([784, 10])) # 创建权值参数矩阵,尺寸[784, 10]

b = tf.Variable(tf.zeros([10])) # 创建bias参数向量,尺寸[10],python执行结果是一行10列,matlab执行结果是10行10列

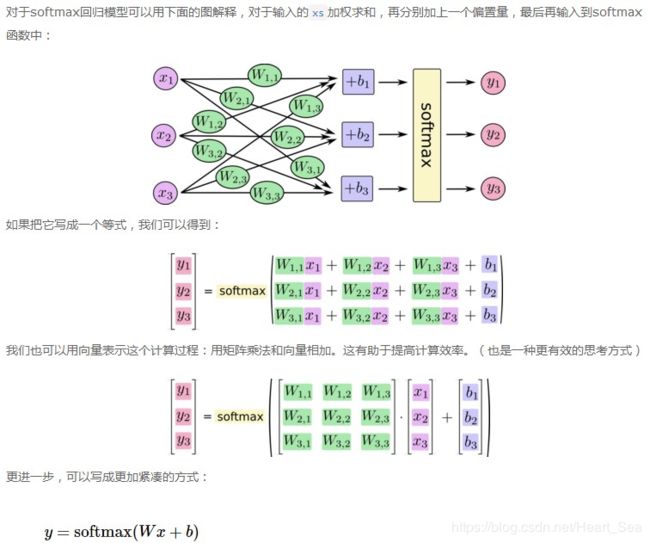

y = tf.nn.softmax(tf.matmul(x, W) + b) # 进行Softmax Regression算法,y是预测的概率分布,y的shape为(None, 10)

# softmax是tf.nn下面的一个函数,而tf.nn则包含了大量神经网络的组件。

# 训练模型

# 对多分类问题,经常使用交叉熵作为loss function

# 计算交叉熵,判断模型对真实概率分布估计的准确程度,用 tf.reduce_sum 根据 reduction_indices=[1] 指定的参数,计算y中第二个维度所有元素的总和,tf.reduce_mean 用于计算该批次的一个平均值

y_ = tf.placeholder(tf.float32, [None, 10]) # 定义placeholder,y_是真实的概率分布

cross_entropy = tf.reduce_mean(-tf.reduce_sum(y_ * tf.log(y), reduction_indices=[1]))#tf.reduce_mean用来对每个batch数据求均值

train_step = tf.train.GradientDescentOptimizer(0.5).minimize(cross_entropy) # 选择随机梯度下降SGD以0.5的学习速率最小化交叉熵

init = tf.initialize_all_variables()

sess = tf.Session()

sess.run(init)

# 上面三行可改写为下面一行

# tf.global_variables_initiallizer().run()

for i in range(1000): # 模型循环训练1000次,从0开始

batch_xs, batch_ys = mnist.train.next_batch(100) # 随机抓取训练数据中的100个批处理数据点

sess.run(train_step, feed_dict={x: batch_xs, y_: batch_ys})

# 评估模型

# tf.argmax是从一个tensor中寻找最大值的序号,tf.argmax(y,1)求预测数字中概率最大的那一个,tf.argmax(y_,1)求样本的真实数字类别

# tf.equal 判断预测的数字类别是否就是正确的类别

correct_prediction = tf.equal(tf.argmax(y,1), tf.argmax(y_,1))

# 用tf.cast将之前的correct_prediction输出的bool值转换为float32,再求平均值

accuracy = tf.reduce_mean(tf.cast(correct_prediction, "float"))

print(sess.run(accuracy, feed_dict={x: mnist.test.images, y_: mnist.test.labels})) #输入数据,计算准确率

输出结果:0.9195

4个步骤:1、定义算法公式,也就是神经网络forward时的计算

2、定义loss,选定优化器,并指定优化器优化loss。

3、迭代地对数据进行训练

4、在测试集或验证集上对准确率进行评测。

注意:只有调用run方法,并feed数据时计算才真正执行。