在上一篇中(传送门:http://maomaostyle.blog.51cto.com/2220531/1362410 )介绍了SCVMM有关逻辑网络和VM网络的概念,后面有介绍了两种端口配置文件的作用,结尾部分创建了一个逻辑交换机,在下面的内容中将延续之前的部分,继续从逻辑交换机说起

####################################################################################

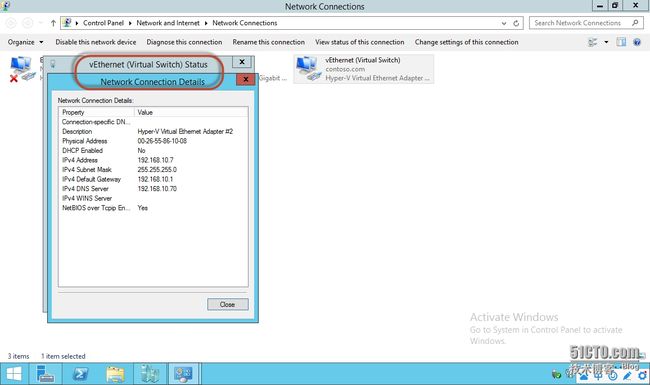

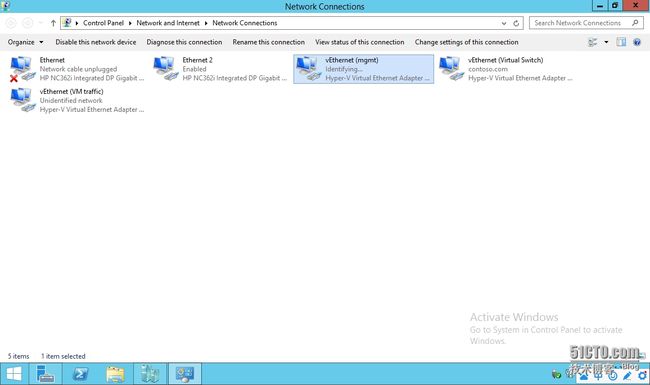

让我们先从操作系统回顾一下,当服务器安装好hyper-v功能后通常会做一些简单的配置,下图中是我创建了一个虚拟交换机后在操作系统网卡连接中看到的状态;可见我的ethernet没有连,而那个叫做“virtual switch”的“虚拟网卡”是由ethernet2映射过来的

同样我们在ethernet2里面已经找不到任何网络连接属性了,因为它的所有配置都被转移到了“虚拟网卡”上,即“virtual switch”

下图是virtual switch上面的信息,一目了然

正如下图所示,在一个非常简单的环境中,物理主机的网卡会被转化成一个“可扩展虚拟交换机”,所有虚拟机将会通过物理主机这台“大交换”来通信;这台大交换不仅仅可以处理数据交换还能支持一些高阶功能,并且可以兼容第三方的软件(例如cisco nexus)

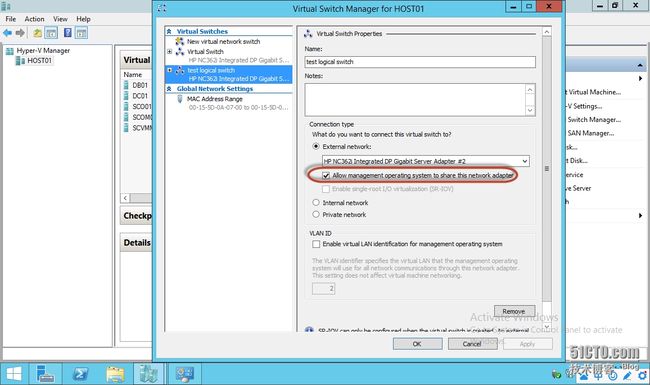

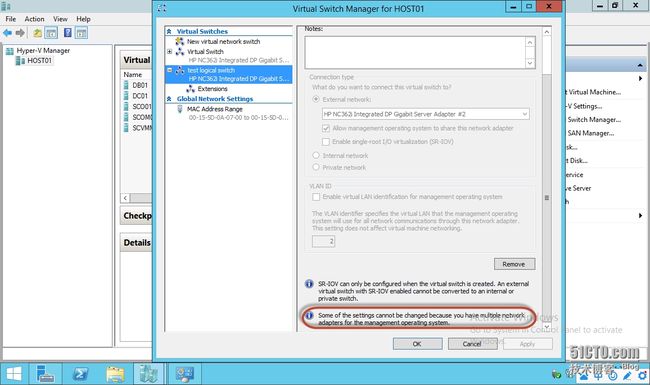

再进入hyper-v的网络配置里看一下,这个virtual switch是关联到我的ethernet2网卡,并且允许主机管理流量复用,意思就是虚机流量和物理机流量共享同一链路

##################################################################################

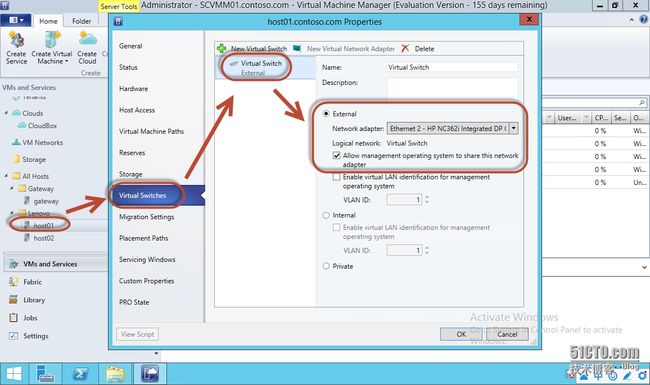

再次来到SCVMM中查看主机属性,在“virtual switches”中可以看到上面生成的那个“虚拟交换机”,也就是主机变身之后的“大交换”,同样也可以看到它关联的真实物理网卡及是否可以和物理机流量共享

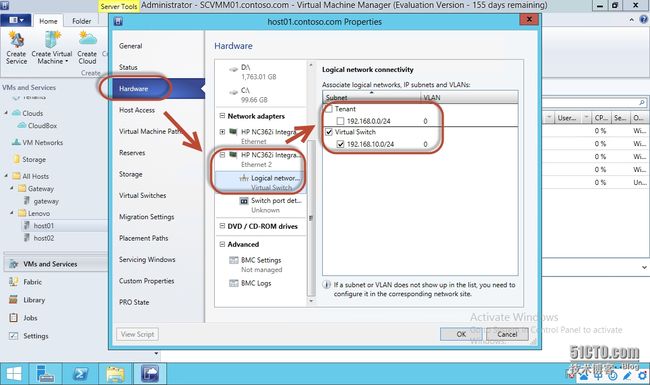

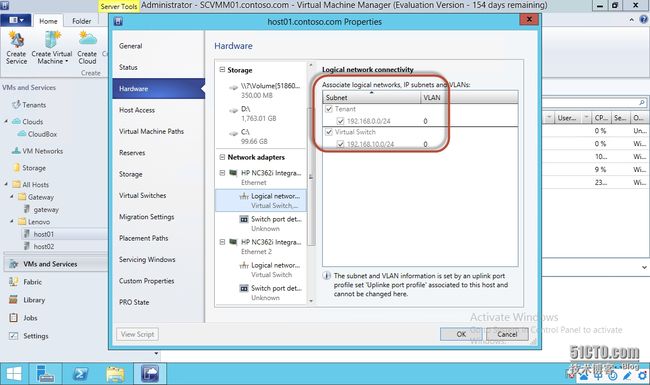

接下来是个重点,同样是在物理机属性中,找到硬件配置中的“网络适配器”,可以看到主机的两块真实网卡,上面那块网卡是ethernet,因为没有启用我们暂时不管它,重点是看下面的那块ethernet2,在SCVMM中物理网卡一定要与逻辑网络做关联才有意义,所以我们可以看到ethernet2已经默认与“virtual switch”逻辑网络关联了,在上一篇中提过这个关联操作是由SCVMM在初始添加host01这台主机时自动带过来的,名称也会抓取主机上hyper-v的设置;当然你不喜欢可以删除掉或者改名字

要特别说明的一点是,大家需要注意“Tenant”那个逻辑网络没有与ethernet2网卡关联,所以我们在第一篇中创建的PA逻辑地址池“192.168.0.0/24”是无法通过host01来使用的,总结来讲就是逻辑网络只能通过站点来允许指定的主机可以识别到自己,但是并没有自动的与其做关联,那么管理员就不得不手动来操作了,于是乎就引出个疑问,要是企业环境比较复杂,逻辑网络设计的很多并且针对不同主机有不同的规划,且主机数量庞大,怎么办?管理员会很桑心,这时逻辑交换机就派上用场了

########################################################################################

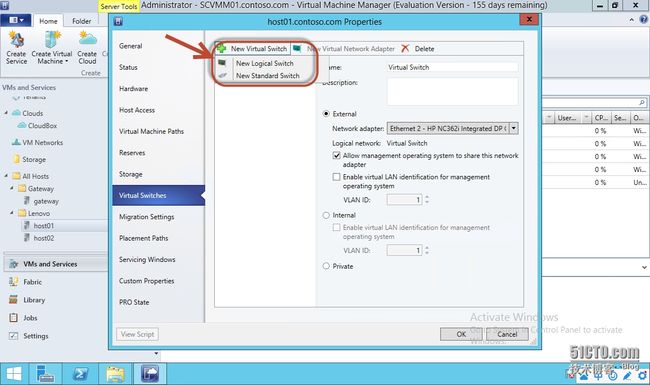

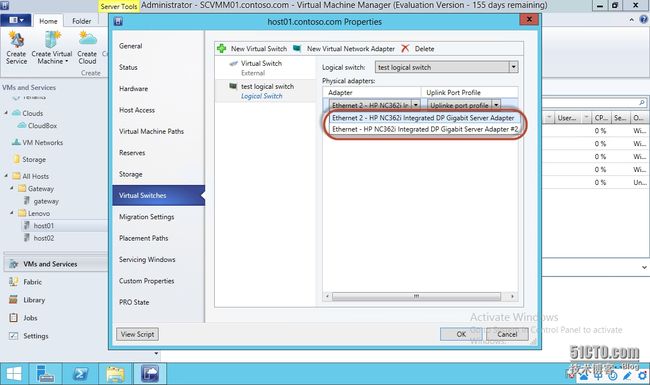

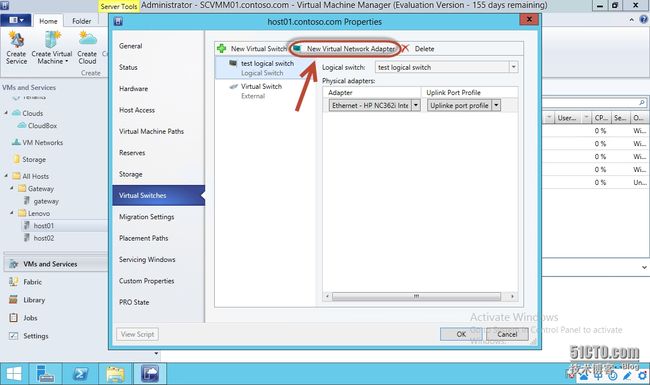

来看一看逻辑交换机的效果,还是以host01为例,如下图示点击添加“新逻辑交换机”

选择我在上一篇创建的“test logical switch”

然后就可以选择让哪一块真实物理网卡连接到这台逻辑交换机上,这里我就选择没插网线的ethernet

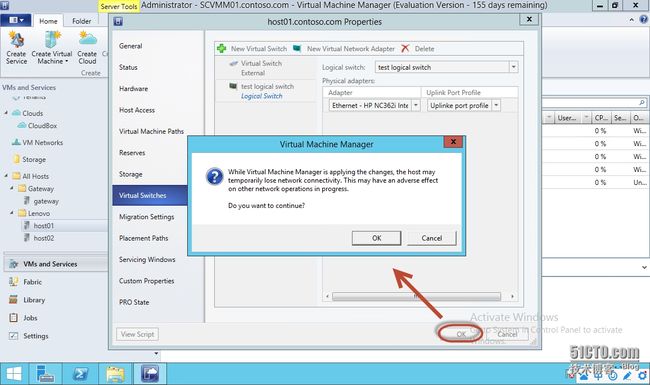

然后选择一个“上行端口配置文件”,在上一篇提到过,逻辑交换机中还包含了“虚拟网卡端口配置文件”,里面定义了我们希望用到的分类及对应的QOS设置,确认后会提示可能目标主机会断开

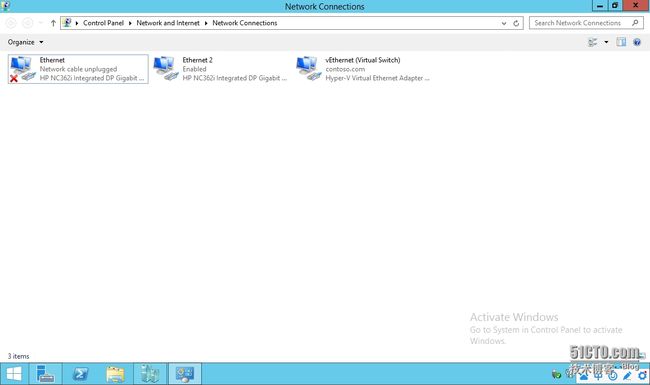

上面已经把ethernet接入到逻辑交换机中了,回到host01的网络连接中看看,咦。。。貌似没有任何变化啊?why?

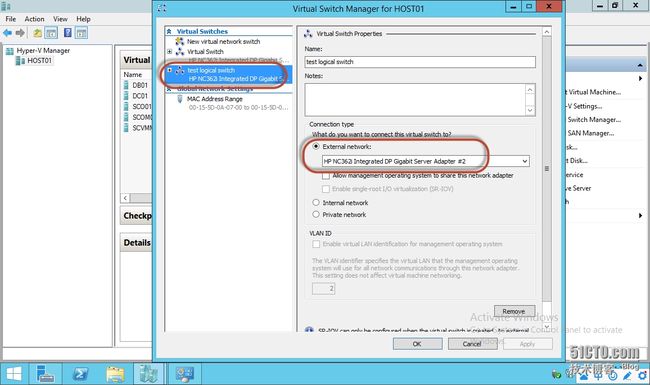

再去hyper-v虚拟交换机管理中看看,哦!?果然是多了一个虚拟交换机,并且名字是和逻辑交换机一样的,叫做“test logical switch”,所以说上面的操作生效了,但是为什么看不到相同名称的那块虚拟网卡呢?去哪了?

点选逻辑交换机后,可以发现上方能够创建“虚拟网卡”,会不会是这里呢?

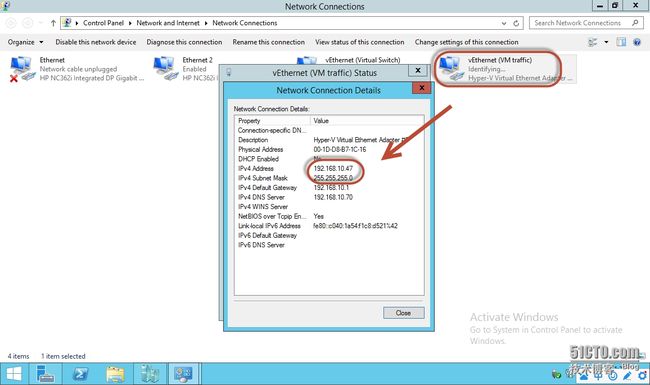

那就试试看,新建一个网卡,取名“VM traffic”,把这个网卡接到一个“VM network”中,注意看标黄提示这里只会显示“未启用网络虚拟化的逻辑网络上的VM network”,接着可以给这个网卡选择一个分类,并且让它从逻辑地址池中拿IP

接着回到host01上看看,哇哦!果然多出一块“VM traffic”网卡,并且自动获取了逻辑网络地址池中的IP

再来到hyper-v管理器中查看虚拟交换机配置,发现已经启用了物理机管理流量共享;所以逻辑交换机中的新建网卡操作就是起到了这个作用

最最重要的是,ethernet连接逻辑交换机后,在SCVMM中查看该网卡属性,发现已经自动把上行端口配置文件中所选择的逻辑网络都关联起来了

接着我们稍微折腾一下,再继续创建一快虚拟网卡,叫做mgmt

host01中也可以看到又多了一块叫mgmt的虚拟网卡,通过hyper-v只能一个物理网卡映射出一个虚拟网卡,但是SCVMM的逻辑交换机可以更灵活的创建虚拟网卡,稍后会做更全面的展示

在有多个虚拟网卡之后,hyper-v的虚拟交换机设置已经无法作出更改了

#####################################################################################

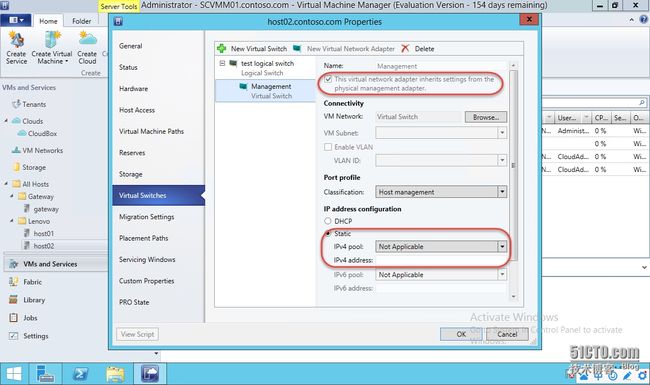

那么怎么样能更方便的创建管理专用网卡呢,其实在逻辑交换机上创建虚拟网卡时,勾选下图中的“集成物理网卡设置”就可以了,其他都不用管

这时就会自动生成一个与逻辑交换机或者hyper-v中虚拟交换机名称一直的网卡,并且这个网卡的IP设置已经完全从物理网卡捕捉过来了

#####################################################################################

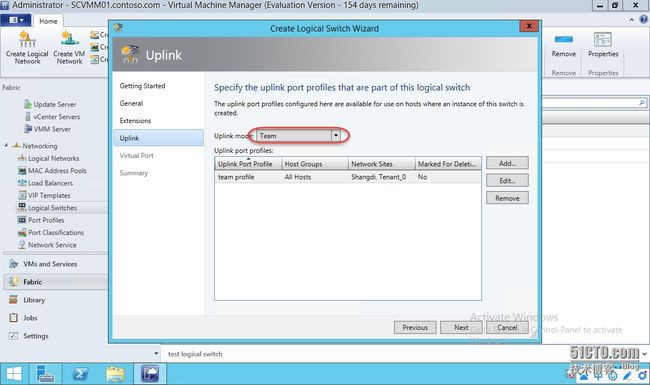

下面来看一下逻辑交换机更大的用处,那就是team模式,同样需要提前准备端口配置文件,下图创建一个上行端口配置文件,负载平衡算法根据需要自行选择,dynamic是R2版本中新增的算法,它能够自动管理teaming中的每一条链路流量,使它们均匀分配

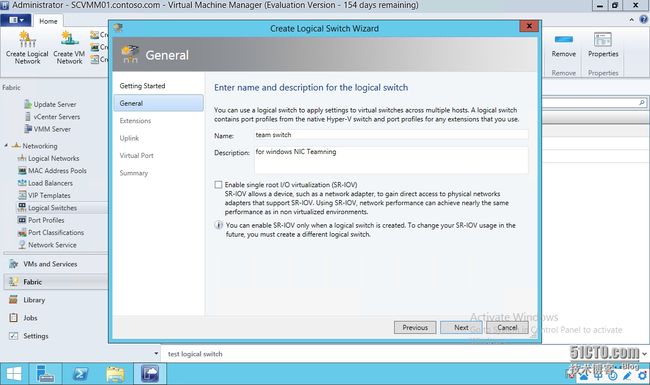

然后创建一个虚拟交换机,名称叫做team switch,因条件艰苦就不启用SR-IOV了

然后上行链路模式选择team,之前内容中提到的都是no team,这是一大区别

端口分类中随便挑几个有代表性的

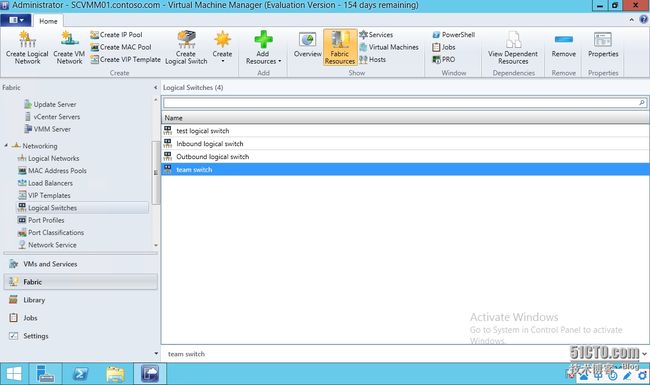

下图中就是创建好的team模式逻辑交换机

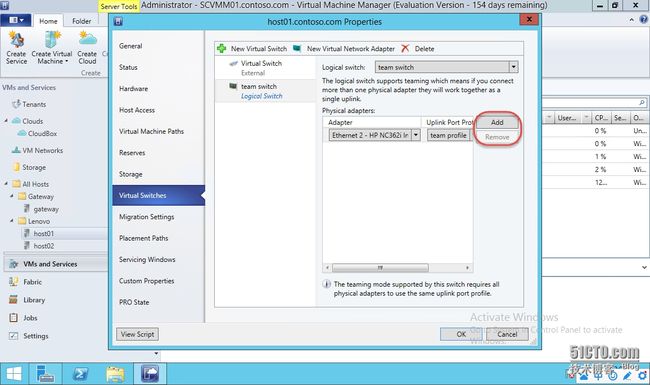

接着还是用host01挂上这个逻辑交换机看看有什么变化,在物理适配器那里可以看到多了一个“添加”和“删除”功能

也就是说可以通过添加删除来把物理机上的多网卡做成teaming,我认为这是非常棒的一个功能,接着可以选择一个上行端口配置文件,请注意这个配置文件如果有多个的话,只能用一个,因为这牵扯负载平衡算法,我们不可能在一个teaming组里切分出不同的算法,这是不现实的

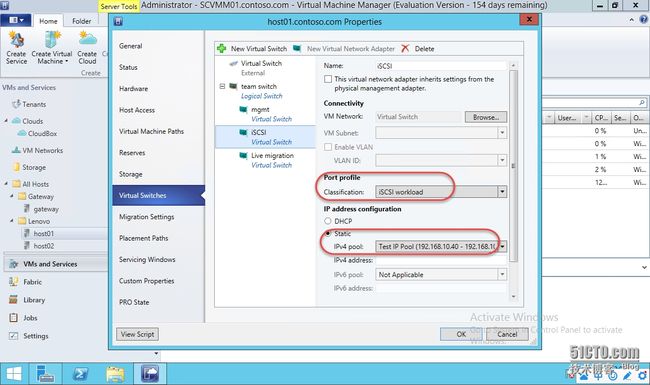

接着我就能够在这个逻辑交换机上创建几个虚拟网卡,分别为mgmt、iSCSI以及live migration;之所以创建这三个网卡,我认为是非常有代表意义的;在一个常见的群集环境中,大家通常会准备以下三个网络,管理或外部访问网络、心跳或迁移网络、存储网络;而且管理员通常为了严谨性会修改主机上的网卡名称,然后设IP,可能其中一个网络还会单独组Teaming等等工作步骤;这在小规模环境中是没有问题的,但是大规模呢?裸机上架呢?

而通过逻辑交换机就可以把物理服务器上的多块网卡组成team,然后在team上划分虚拟网卡,再把虚拟网卡连接到对应的各个VM network上,当然你需要提前设置好不同业务的VM netwokr以及逻辑网络是不可少的,但是后面的工作通过逻辑交换机来实现会异常的方便,不同的业务流量通过端口配置文件可以限制带宽、设置权重,然后让他们有效的进行隔离互不干涉,你设置可以忽略这些物理线路的连接方式,还不去试试?

到目前为止,关于网络虚拟化已经做了足够多的铺垫了,所涉及到的知识点也基本做了一些介绍,在下一篇中会上干货,把到目前为止所罗列出的要素都柔和到一起,网关服务器会隆重登场,然后我们就能看到放置在不同租户网络中的VM是如何访问外网的