一. MHA简介

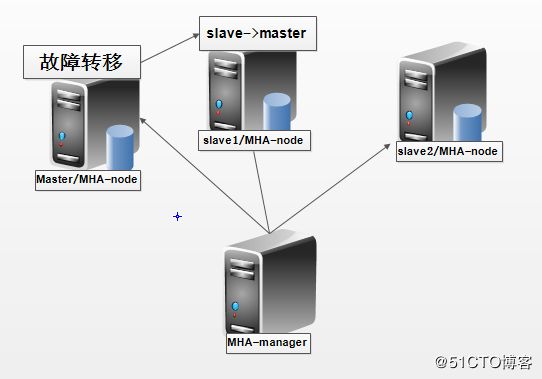

MHA(Master HA) 是一款开源的MySQL的高可用程序 , 它为mysql主从复制提供了自动化主故障转移功能 ; MHA能够在30秒内实现故障切换 , 最大可能保证数据的一致性 ; 当MHA通过监控到master节点时 , 会提升拥有最新数据的slave节点成为master节点 , 在此期间 , MHA会通过于其他从节点获取额外信息来避免一致性方面的问题 ; MHA还提供了master节点的在线切换功能 , 即按需切换master/slave节点 .

二. MHA服务

服务角色

MHA服务有两种角色(MAnager/Node)

MHA Manager(管理节点) : 通常单独部署在一台独立机器上管理多个master/slave集群 , 每个master/slave集群称为一个application , 用来管理统筹整个集群 .

MHA Node(数据节点) : 运行在每台mysql服务器上 , 通过监控具备解析和清理logs功能的脚本来加快故障转移 ; 主要是接收管理节点所发出指令的代理,代理需要运行在每一个 mysql 节点上。简单讲 node 就是用来收集从节点服务器上所生成的 bin-log 。对比打算提升为新的主节点之上的从节点的是否拥有并完成操作,如果没有发给新主节点在本地应用后提升为主节点 .

MHA提供的工具(命令)

| Manager |

|

| masterha_check_ssh | MHA依赖的ssh环境监测工具 |

| masterha_check_rep1 | MySQL主从复制检查工具 |

| masterha_manager | MHA检测主服务程序 |

| masterha_check_status | MHA运行状态探测工具 |

| masterha_master_monitor | MySQL master 节点可用性检测工具 |

| masterha_master_swich:master | 节点切换工具 |

| masterha_conf_host | 添加或删除配置的节点 |

| masterha_stop | 关闭MHA服务的工具 |

| Node节点 |

|

| save_binary_logs | 保存和复制master的二进制日志 |

| apply_diff_relay_logs | 识别差异的中继日志事件并应用于其他slave |

| purge_relay_logs | 清除中继日志(不会阻塞SQL线程) |

MHA工作原理

原理 : manager节点发现master节点出现故障后 , 会选举一个slave作为新的master来继续工作

(选举依据 : 从宕机的master保存二进制日志文件(bin-log) , 识别含有最新更新的slave , 应用差异的中继日志(relay-log)到其他slave , 应用从master保存的二进制日志文件 , 最后提升一个slave为新的master)

三. 部署搭建MHA实现数据库高可用

实验准备

| 主机名 | IP | 角色 |

| Manager | 192.168.11.128 | 用于监控管理(Manager) |

| master | 192.168.11.129 | 主数据库(node) |

| slave1 | 192.168.11.130 | 从数据库(node) |

| slave2 | 192.168.11.132 | 从数据库(node) |

所有节点进行初始化关闭防火墙 , selinux

[root@Manager ~]# systemctl stop firewalld [root@Manager ~]# sed -ri '/^SELINUX=/cSELINUX=disabled' /etc/selinux/config

各节点编辑/etc/hosts配置文件 , 添加如下内容

192.168.11.128 Manager 192.168.11.129 master 192.168.11.130 slave1 192.168.11.132 slave2

配置3台数据库(master , slave1 , slave2)

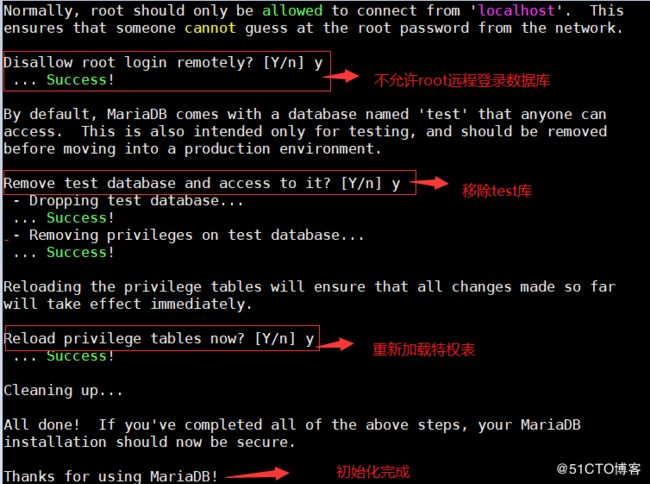

3台主机均安装mariadb-server , 进行初始化

yum install -y mariadb-server mariadb systemctl start mariadb mysql_secure_installation #初始化数据库

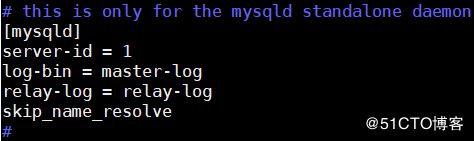

配置主节点master

[root@master ~]# vim /etc/my.cnf.d/server.cnf [mysqld] server-id = 1 //复制集群中的各节点的id均必须唯一 log-bin = master-log //开启二进制日志 relay-log = relay-log //开启中继日志 skip_name_resolve //关闭名称解析(非必须) [root@master ~]# systemctl restart mariadb

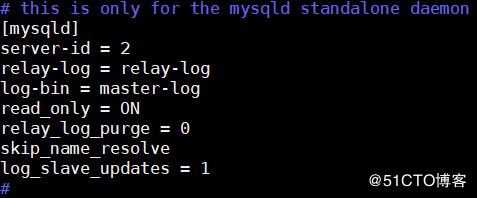

配置两个slave节点

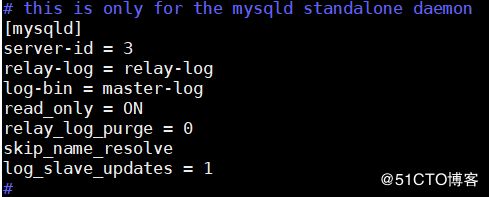

[root@slave1 ~]# vim /etc/my.cnf.d/server.cnf [mysqld] server-id = 2 //复制集群中的各节点的id均必须唯一; relay-log = relay-log //开启中继日志 log-bin = master-log //开启二进制日志 read_only = ON //启用只读属性 relay_log_purge = 0 //是否自动清空不再需要中继日志 skip_name_resolve //关闭名称解析(非必须) log_slave_updates = 1 //使得更新的数据写进二进制日志中 [root@slave1 ~]# systemctl restart mariadb slave2(192.168.11.132)同理slave1(192.168.11.130) , 注意id要不一致

配置一主多从架构

master节点上:

# 授权同步数据账号 [root@master ~]# mysql MariaDB [(none)]>grant replication slave,replication client on *.* to 'slave'@'192.168.11.%' identified by 'keer'; # 备份数据导出到从库 [root@master ~]# mysqldump -uroot -p'keer' --all-databases > `date +%F`-mysql-all.sql [root@master ~]# scp *mysql-all.sql 192.168.11.130:/root [root@master ~]# scp *mysql-all.sql 192.168.11.132:/root [root@master ~]# mysql MariaDB [(none)]> show master status;

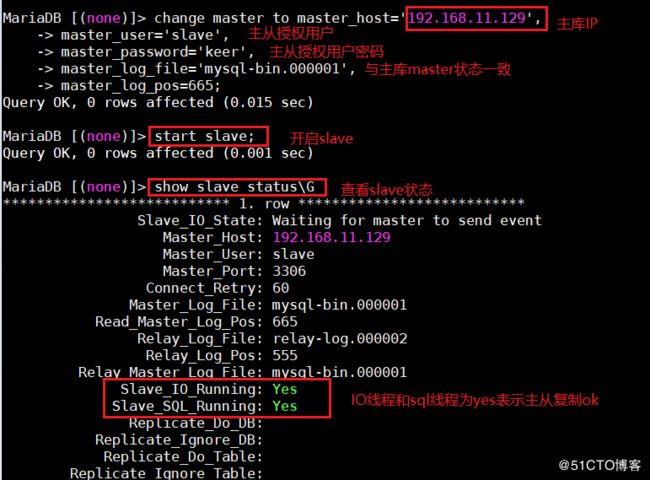

slave节点上:

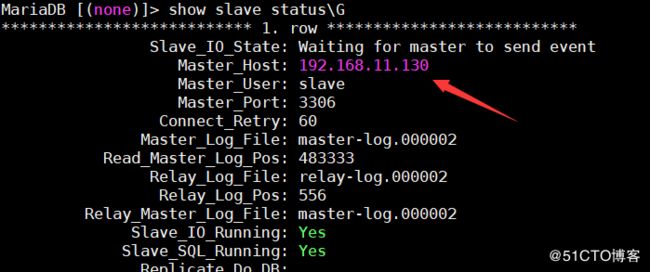

#导入数据 [root@slave1 ~]# mysql -uroot -p'123456' < *mysql-all.sql [root@slave1 ~]# mysql -uroot -p'123456' MariaDB [(none)]> change master to master_host='192.168.11.129', -> master_user='slave', -> master_password='keer', -> master_log_file='mysql-bin.000001', -> master_log_pos=665; MariaDB [(none)]> start slave; MariaDB [(none)]> show slave status\G;

在master上进行MHA配置授权

[root@master ~]# mysql MariaDB [(none)]> grant all on *.* to 'mhaadmin'@'192.168.11.%' identified by 'mhapass'; MariaDB [(none)]> flush privileges;

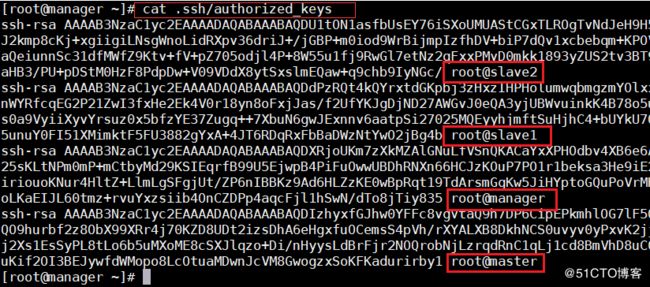

准备ssh互通环境

MHA高度依赖ssh互通环境 , 即所有主机之间都能进行ssh免密登录 , 以实现远程控制和数据管理功能

在所有节点上操作

ssh-keygen ssh-copy-id 192.168.11.128

完成上述操作后 , 在Manager上可以查看到如下内容

四台主机的公钥均在authorized_keys这个文件中 , 现在只需把这个文件发送另外3台机器即可实现ssh无密码互通了

[root@manager .ssh]# scp authorized_keys 192.168.11.129:~/.ssh/ [root@manager .ssh]# scp authorized_keys 192.168.11.130:~/.ssh/ [root@manager .ssh]# scp authorized_keys 192.168.11.132:~/.ssh/

发送完最好验证一下ssh免密登录

部署MHA

[root@manager ~]# yum install -y mha4mysql-node-0.56-0.el6.noarch.rpm [root@manager ~]# yum install -y mha4mysql-manager-0.56-0.el6.noarch.rpm

manager主机上需安装mha-manage和mha-node , 其余3台数据库主机安装MHA-node即可

定义MHA管理配置文件

为MHA专门创建一个管理用户 , 方便以后使用 , 在mysql的主节点上 , 三个节点自动同步

[root@manager ~]# mkdir /etc/mha_master [root@manager ~]# vim /etc/mha_master/mha.cnf #内容如下 [server default] user=mhaadmin password=mhapass manager_workdir=/etc/mha_master/app1 manager_log=/etc/mha_master/manager.log remote_workdir=/mydata/mha_master/app1 ssh_user=root repl_user=slave repl_password=keer ping_interval=1 [server1] hostname=192.168.11.129 ssh_port=22 candidate_master=1 [server2] hostname=192.168.11.130 ssh_port=22 candidate_master=1 [server3] hostname=192.168.11.132 ssh_port=22 candidate_master=1

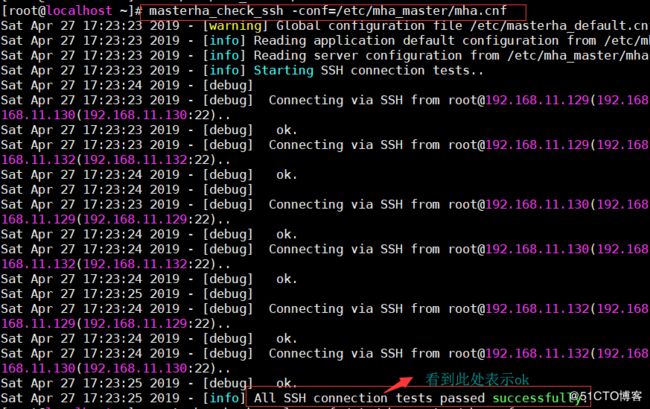

配置好/etc/mha_master/mha.cnf文件后 , 对该文件进行检测

1.检测各节点ssh互信环境是否ok

[root@manager ~]# masterha_check_ssh -conf=/etc/mha_master/mha.cnf

2. 检查管理的mysql复制集群的连接配置参数是否ok

[root@manager ~]# masterha_check_repl -conf=/etc/mha_master/mha.cnf

排错 :

如果显示 MySQL Replication Health is NOT OK , 可能就是从节点上没有账号 , 因为这个架构任何一个节点都有可能成为主节点 , 可以在master上创建一个用于管理主从复制的账号 , 即/etc/mha_master/mha.cnf 配置文件中的 repl_user=slave

检查主从是否ok , show slave status\G

ssh互信和主从环境都检测ok后 , 启动MHA

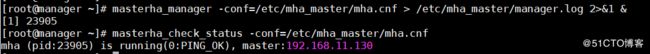

[root@manager ~]# nohup masterha_manager -conf=/etc/mha_master/mha.cnf &> /etc/mha_master/manager.log &

停止MHA命令(masterha_stop -conf=/etc/mha_master/mha.cnf)

查看此时master节点状态

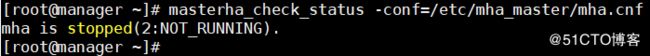

masterha_check_status -conf=/etc/mha_master/mha.cnf

测试MHA故障转移

在master节点上关闭mysql服务

[root@master ~]# yum -y install psmisc [root@master ~]# killall mysqld

在manager节点查看日志

[root@manager ~]# tail -200 /etc/mha_master/manager.log

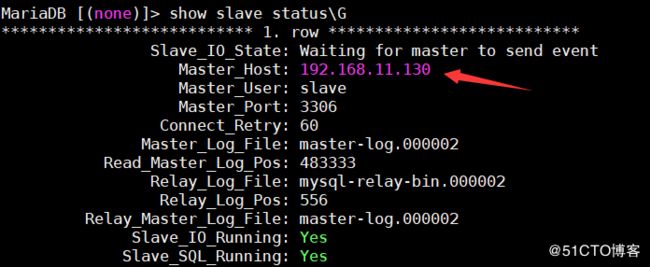

此时slave2(192.168.11.132)在节点上查看slave状态

此时manager 检测到192.168.11.129节点故障,而后自动执行故障转移, 将192.168.11.130提升为主节点。

注意,故障转移完成后,manager将会自动停止,此时使用 masterha_check_status 命令检测将会遇到错误提示, 如下所示:

提供新的从节点以修复集群

原有 master 节点故障后,需要重新准备好一个新的 MySQL 节点。基于来自于master 节点的备份恢复数据后,将其配置为新的 master 的从节点即可。注意,新加入的节点如果为新增节点,其 IP 地址要配置为原来 master 节点的 IP,否则,还需要修改 mha.cnf 中相应的 ip 地址。随后再次启动 manager ,并再次检测其状态。

我们就以刚刚关闭的那台主作为新添加的机器,来进行数据库的恢复:

原本的 slave1 已经成为了新的主机器,所以,我们对其进行完全备份,而后把备份的数据发送到我们新添加的机器上:

[root@slave1 ~]# mkdir /backup [root@slave1 ~]# mysqldump --all-database > /backup/`date +%F`-myql-all.sql [root@slave1 ~]# scp /backup/*mysql-all.sql 192.168.11.128:~/

在原master节点上进行数据恢复

[root@master ~]# systemctl start mariadb [root@master ~]# mysql < 2019-4-27-mysql-all.sql

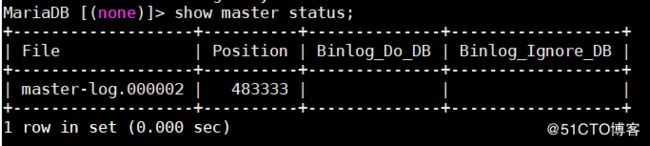

在新主即slave1节点上查看master状态信息

在master节点上配置主从

MariaDB [(none)]> change master to master_host='192.168.11.130', master_user='slave', master_password='keer', master_log_file='master-log.000002', master_log_pos=483333; MariaDB [(none)]> start slave; MariaDB [(none)]> show slave status\G;

再次在manager节点启动MHA

[root@manager ~]# masterha_manager -conf=/etc/mha_master/mha.cnf > /etc/mha_master/manager.log 2>&1 &

启动成功后查看master节点状态

[root@manager ~]# masterha_check_status -conf=/etc/mha_master/mha.cnf

到此部署结束!!