26套Spark企业级项目实战,源码深度剖析,实时流处理,机器学习,数据分析,运行原理,性能调优,图计算,性能调优,缓存优化,监控分析SparkCore,SparkSQL,SparkStreaming,Kafka,Flume,Scale,Python视频课程

视频课程包含:

26套Spark项目实战包含:大数据之Spark高级课程,企业级项目实战,源码深度剖析,实时流处理,机器学习,数据分析,运行原理,性能调优,图计算,性能调优,缓存优化,监控分析,Spark调优,算子优化,全场景项目实战,用户行为实时分析,实时流量监控系统,实时电影推荐系统,爱奇艺实时流处理项目,RDD数据集,精准广告推送实战,ML机器学习,PySpark,SparkCore,SparkSQL,SparkStreaming,Kafka,Flume,Scale,Python高级视频课程。。。

26套精品课程介绍:

1、26套精品是掌柜最近整理出的最新课程,都是当下最火的技术,最火的课程,也是全网课程的精品;

2、26套资源包含:全套完整高清视频、完整源码、配套文档;

3、知识也是需要投资的,有投入才会有产出(保证投入产出比是几百上千倍),如果有心的朋友会发现,身边投资知识的大都是技术经理或者项目经理,工资一般相对于不投资的也要高出很多;

总目录:26套Spark企业级项目实战,源码深度剖析,实时流处理,机器学习,数据分析,推荐系统,图计算,缓存优化,监控分析SparkCore,SparkSQL,SparkStreaming,Kafka,Flume,Scale,Python视频课程

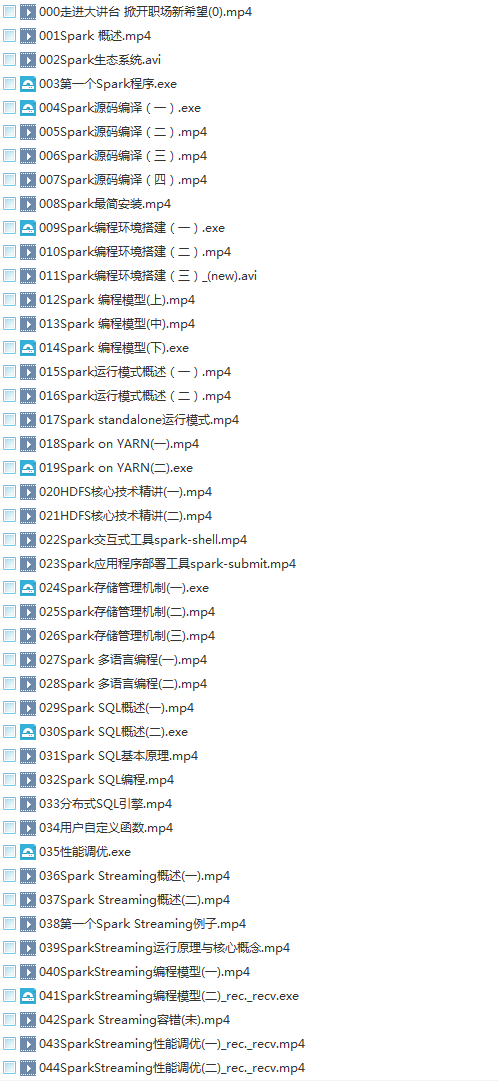

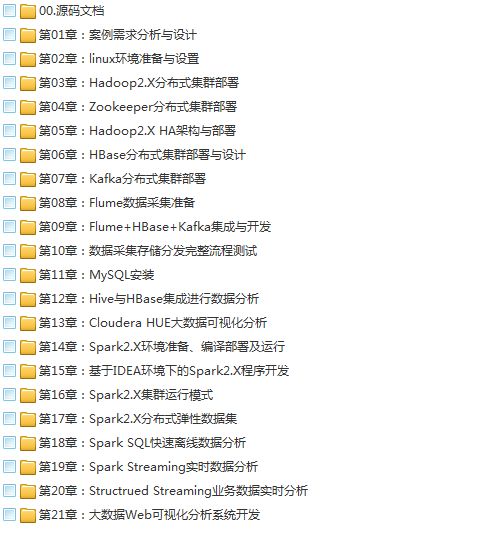

第一套:【系统学习】快速掌握Spark 2.0(新特性、含真实项目、纯Scala语言开发、CDH5.7)视频教程

第二套:【系统学习】Spark全面精讲系统培训课程(基于Spark2版本+含Spark调优+超多案例)视频教程

第三套:【系统学习】Spark高薪就业课(SparkCore,SparkSQL,SparkStreaming,运维与监控)视频教程

第四套:【项目实战】Spark从入门到上手实战(Scacle编程+SparkCore实战+SparkSQL+SparkStreaming)视频教程

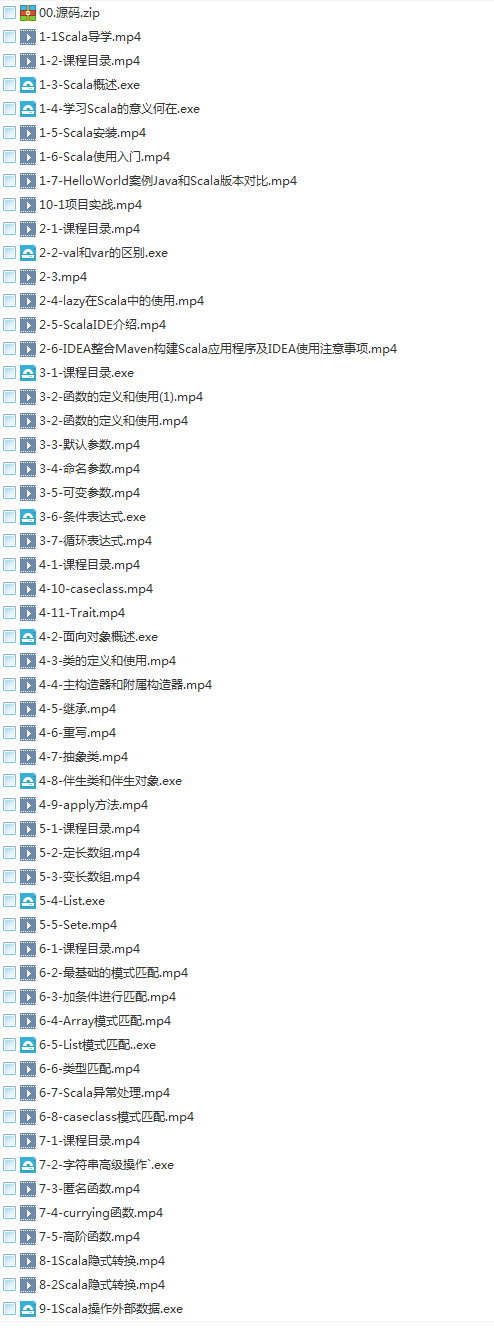

第五套:【系统学习】学习Scala进击大数据Spark生态圈,进击Spark生态圈必备,迈向“高薪”的基石视频教程

第六套:【综合学习】Spark2全面深度剖析--知识点,源码,调优,JVM,图计算,项目实战视频教程

第七套:【系统学习】Spark核心解密源码剖析,调度流程源码剖析,算子优化,缓存优化视频教程

第八套:【项目实战】大数据全栈高手速成--Spark2.0精讲(全场景项目实战)视频教程

第九套:【项目实战】大数据Spark实战项目大数据实战之精准广告推送实战,完全实战化学习大数据开发视频教程

第十套:【项目实战】Spark企业级实战项目:知名手机厂商用户行为实时分析系统视频教程

第十一套:【项目实战】Spark企业级实战项目:道路交通实时流量监控预测系统视频教程

第十二套:【项目实战】Spark企业级实战项目:离线和实时电影推荐系统直播回放(视频+文档+代码)视频教程

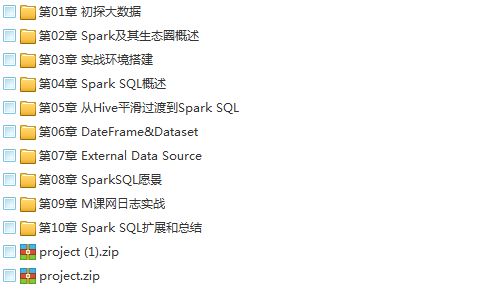

第十三套:【项目实战】以慕课网日志分析为例进入大数据SparkSQL的世界视频教程

第十四套:【项目实战】基于Spark2.x新闻网大数据实时分析可视化系统项目实战视频教程

第十五套:【项目实战】Spark企业级大数据项目实战,项目集成Hadoop,Spark,HBase,Kafka,Oracle,ElasticSearch大数据技术视频教程

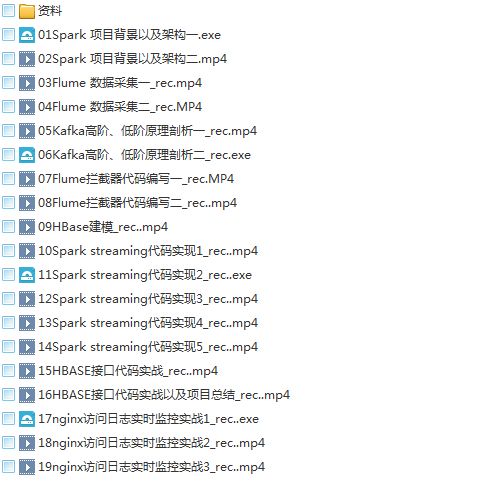

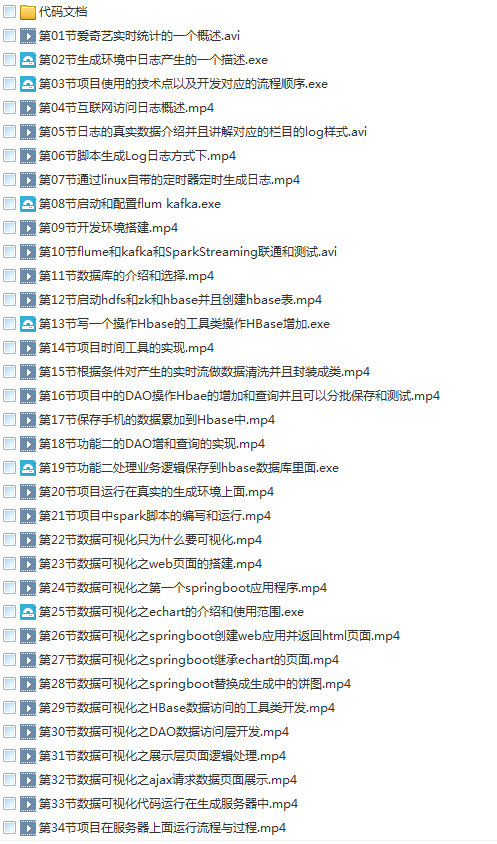

第十六套:【项目实战】爱奇艺实时流处理项目实战 (Spark Streaming)企业级真实案例项目实战视频教程

第十七套:【项目实战】实时流处理SparkStreaming项目实战(Flume+KafkaSpark Streaming打造通用流处理平台)视频教程

第十八套:【系统学习】大数据Spark “蘑菇云”行动,spark2.x,spark Streaming 视频教程

第十九套:【项目实战】PySpark基于Python的Spark企业级大数据分析,以实际数据分析为驱动讲解,项目实战视频课程

第二十套:【系统学习】PySpark大数据处理及机器学习Spark2.3深入学习高级视频课程

第二十一套:【项目实战】深入学习大数据分析Spark2.X+Python 精华实战,实战Spark与分散式机器学习课程

第二十二套:【项目实战】全面掌握Spark2.0 ML机器学习,ML的应用开发和定制开发视频教程

第二十三套:【项目实战】大数据之基于Spark的机器学习-智能客户系统项目实战视频教程

第二十四套:【项目实战】深入Spark与kafka整合之实时流计算机器学习实战视频教程

第二十五套:【项目实战】Spark机器学习班,运行原理,性能调优,图计算,存储调度与监控分析视频教程

第二十六套:【项目实战】深入浅出Spark2.X用户行为分析机器学习,RDD数据集,SparkSQL数据存储,实时流分析项目实战视频教程

一.Spark的产生背景起源

1.spark特点

1.1轻量级快速处理

Saprk允许传统的hadoop集群中的应用程序在内存中已100倍的速度运行即使在磁盘上也比传统的hadoop快10倍,Spark通过减少对磁盘的io达到性能上的提升,他将中间处理的数据放到内存中,spark使用了rdd(resilient distributed datasets)数据抽象

这允许他在内存中存储数据,所以减少了运行时间

1.2 易于使用

spark支持多种语言。Spark允许java,scala python 及R语言,允许shell进行交互式查询

1.3 支持复杂的查询

除了简单的map和reduce操作之外,Spark还支持filter、foreach、reduceByKey、aggregate以及SQL查询、流式查询等复杂查询。Spark更为强大之处是用户可以在同一个工作流中无缝的搭配这些功能,例如Spark可以通过Spark Streaming(1.2.2小节对Spark Streaming有详细介绍)获取流数据,然后对数据进行实时SQL查询或使用MLlib库进行系统推荐,而且这些复杂业务的集成并不复杂,因为它们都基于RDD这一抽象数据集在不同业务过程中进行转换,转换代价小,体现了统一引擎解决不同类型工作场景的特点。

1.4 实时的流处理

对比maprduce只能处理离线数据。Spark还能支持实时的流计算,spark streaming 主要用来对数据进行实时的处理,yarn的nodemanger统一调度管理很厉害,在yarn产生后hadoop也可以整合资源进行实时的处理

2.时事产物

2.1 mapreduce产生时磁盘廉价,因此许多设计收回考虑到内存的使用,而spark产生时内存相对廉价,对计算速度有所要求,因此spark的产生是基于内存计算的框架结构mapreduce需要写复杂的程序进行计算,

二.Spark架构

1.spark的体系结构

Spark的体系结构不同于Hadoop的mapreduce 和HDFS ,Spark主要包括spark core和在spark core的基础上建立的应用框架sparkSql spark Streaming MLlib GraphX;

Core库主要包括上下文(spark Context)抽象的数据集(RDD),调度器(Scheduler),洗牌(shuffle) 和序列化器(Seralizer)等。Spark系统中的计算,IO,调度和shuffle等系统的基本功能都在其中

在Core库之上就根据业务需求分为用于交互式查询的SQL、实时流处理Streaming、机器学习Mllib和图计算GraphX四大框架hdfs迄今是不可替代的

Spark架构组成图

一.Hive和spark对sql支持的对比

Hive创建数据库 创建表 true

验证策略 |

脚本 |

Hive |

Spark-sql |

创建库 删除库 |

Create database lvhou_hive Create database lvhou_spark Dorp database lvhou_hive Dorp database lvhou_spark |

True |

True |

创建表 删除表 |

Use lvhou_hive Create table hive_test(a string,b string) Use lvhou_spark Create table spark_test(a string,b string) Drop table hive_test Drop table spark_test

|

True |

True |

CTAS |

Create table lvhou_test as selec * from lvhou_test1;

|

true |

false |

Insert

|

Insert into lvhou_hive values(‘hhah’,’heheh’) |

true |

false |

insert |

Insert into lvhou_spark value(‘12’.’32’),(‘asd’,’asdf’) |

True |

false |

Select |

Select * from lvhou_hive Select * from lvhou_spark |

True |

True

|

Select in |

|||

Select子查询 in 两条数据

not in 两条数据 |

select * from test1 where a,b in (select a,b from test2 where a = 'aa');

select * from test1 where a,b not in (select a,b from test2 where a = 'aa');

|

falese |

false |

Select union查询 union all |

select * from test union all select * from test0;(合一) select * from test union select * from test0;(去重) |

true |

false |

Select union 3查询 union all

|

select * from (select * from test union select * from test0) a;

select a from (select * from test union all select * from test0) a; |

false |

False |

Select exit not exit |

select * from test t where exists(select * from test0 t0 where t0.a = t.a); select * from lv_test where exists(select * tfrom test t where lv_test.a = t.a); |

True |

False |

update |

update test1 set b = 'abc' where a = 'aa'; update test1 set a = 'abc';

Update test1 set b = 'abc'; |

True |

False |

delete |

delete from test1 where a = 'aa'; delete from test1; |

True |

False |

TRUNCATE TABLE

|

Truncate table test; |

True |

False |

Alter |

alter table test1 add columns (d string); alter table test drop a; alter table test rename a to a1;

|

True |

False |

索引 |

create index index_a on table test(a) as 'org.apache.hadoop.hive.ql.index.compact.CompactIndexHandler' with deferred rebuild; |

True |

False |

INTERSECT 交集 |

select a from test INTERSECT select a from test0; |

False |

False |

EXCEPT

|

select a from test EXCPEPT select a from test0; |

False |

False |

Minus 返回第一个结果中不同的 |

select a from test minus select a from test0; |

False |

False |

order by 排序 |

select a from test order by a desc;

|

True |

False |

sort by 排序 |

select a,b from test sort by b desc; |

True |

False |

distribute by

|

select a,b from test distribute by a; |

True |

False |

distribute by + sort by |

select a,b from test distribute by a sort by b asc; |

True |

False |

cluster by

|

select a,b from test cluster by a;

|

True |

False |

trim(string a) 去空格 |

select trim(' aaa ') from test00; |

True |

True

|

substr(string A,int start,int len) 截取字符串 |

select substr('abcdefg',3,2) from test;

select substr('abcdefg',-3,2) from test; |

True |

True |

like

|

select * from test where a like '%a%'; |

True |

False |

Count

|

select count(*) from test00;

select count(distinct *) from test00; |

True |

False |

Sum

|

select sum(c) from test00;

select sum(distinct c) from test00; |

True |

False |

Avg

|

select avg(c) from test00 select avg(distinct c) from test00 |

True |

False |

Min

|

select min(distinct c) from test00; |

True |

False |

Max

|

select max(distinct c) from test00; |

True |

False |

group by

|

select a from test00 group by a ; select a,sum(c) from test00 group by a; select a,avg(c) from test00 group by a; |

True |

False |

Hiving

|

select a,avg(c) as ac from test00 group by a having ac=1; |

True |

False |

load |

load data local inpath '/tmp/qichangjian/test01.txt' overwrite into table test_load; |

True |

False |