机器学习算法基础3-决策树

摘要

今天介绍决策树以及 信息论基础首先我们看到 信息论基础可以分为

- 熵

是接收的每条消息中包含的资讯的平均量,又被称为资讯熵,信源熵,平均资讯本体量。这里,「消息」代表来自分布或数据流中的事件,样本或特征。(熵最好理解为不确定性的量度而不是确定性的量度,因为越随机的信源的熵越大。) - 联合熵

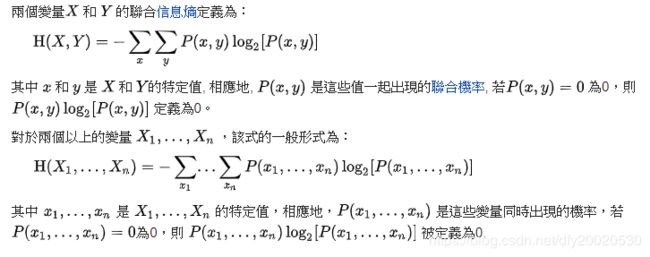

- 联合熵的定义,代表X,Y同时发生的不确定性

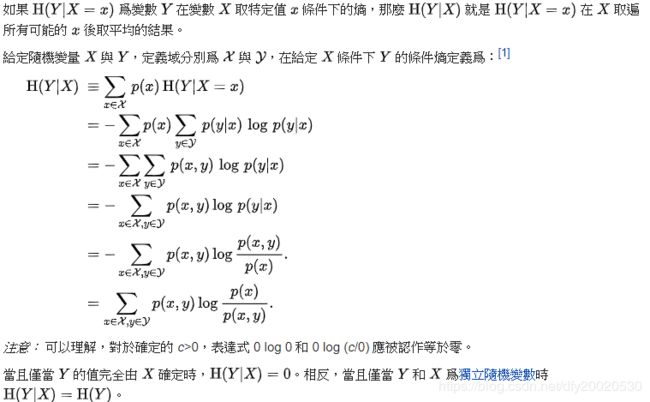

- 条件熵

在资讯理论中,条件熵描述了在已知第二个随机变量 X的值的前提下,随机变量 Y的信息熵还有多少。同其它的信息熵一样 ,条件熵也用Sh、nat、Hart等信息单位表示。基于}X条件的Y的信息熵,用H(Y | X)表示。

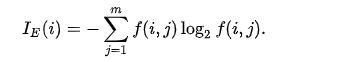

- 信息增益

- 熵 - 条件熵在一个条件下,信息不确定性减少的程度!通俗地讲,X(明天下雨)是一个随机变量,X的熵可以算出来, Y(明天阴天)也是随机变量,在阴天情况下下雨的信息熵我们如果也知道的话(此处需要知道其联合概率分布或是通过数据估计)即是条件熵。两者相减就是信息增益!原来明天下雨例如信息熵是2,条件熵是0.01(因为如果是阴天就下雨的概率很大,信息就少了),这样相减后为1.99,在获得阴天这个信息后,下雨信息不确定性减少了1.99!是很多的!所以信息增益大!也就是说,阴天这个信息对下雨来说是很重要的!所以在特征选择的时候常常用信息增益,如果IG(信息增益大)的话那么这个特征对于分类来说很关键~~ 决策树就是这样来找特征的!

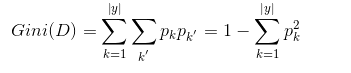

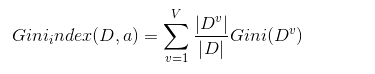

- 基尼不纯度

基尼不纯度是用于决策树编程中的一个专业术语。

基尼不纯度,是指将来自集合中的某种结果随机应用在集合中,某一数据项的预期误差率。

是在进行决策树编程的时候,对于混杂程度的预测中,一种度量方式。

(1)基尼不纯度越小,纯度越高,集合的有序程度越高,分类的效果越好;

(2)基尼不纯度为 0 时,表示集合类别一致;

绪论

1.决策树的不同分类算法(ID3算法、C4.5、CART分类树)的原理及应用场景

一棵决策树包含一个根结点、若干个内部结点和若干个叶结点;叶结点对应于决策结果,其他每个结点则对应一个属性测试;每个结点包含的样本结合根据属性测试的结果被划分到子结点中;根结点包含样本全集,从根结点到每个叶结点的每个叶结点的路径对应一个判定测试序列。决策树学习的目的是为了产生一棵泛化能力强,也就是能够处理未见实例的决策树。

ID3

这个算法是建立在奥卡姆剃刀的基础上:。越是小型的决策树越优于大的决策树(简单理论)尽管如此,该算法也不是总是生成最小的树形结构而是一个启发式算法奥卡姆剃刀阐述了一个信息熵的概念:

这个ID3算法可以归纳为以下几点:

1.使用所有没有使用的属性并计算与之相关的样本熵值

2.选取其中熵值最小的属性

3.生成包含该属性的节点

C4.5

C4.5算法是由Ross Quinlan开发的用于产生决策树的算法。该算法是对Ross Quinlan之前开发的ID3算法的一个扩展.C4.5算法产生的决策树可以被用作分类目的,因此该算法也可以用于统计分类。

C4.5算法与ID3算法一样使用了信息熵的概念,并和ID3一样通过学习数据来建立决策树。

详细请参考

CART决策树

CART决策树的全称为Classification and Regression Tree,可以应用于分类和回归。

采用基尼系数来划分属性

基尼值

基尼系数

因此在候选属性中选择基尼系数最小的属性作为最优划分属性。

决策树防止过拟合手段

首先我们要了解为什么会出现这个问题

原因1:样本问题

(1)样本里的噪音数据干扰过大,大到模型过分记住了噪音特征,反而忽略了真实的输入输出间的关系;(什么是噪音数据?)

(2)样本抽取错误,包括(但不限于)样本数量太少,抽样方法错误,抽样时没有足够正确考虑业务场景或业务特点,等等导致抽出的样本数据不能有效足够代表业务逻辑或业务场景;

(3)建模时使用了样本中太多无关的输入变量。

原因2:构建决策树的方法问题

在决策树模型搭建中,我们使用的算法对于决策树的生长没有合理的限制和修剪的话,决策树的自由生长有可能每片叶子里只包含单纯的事件数据或非事件数据,可以想象,这种决策树当然可以完美匹配(拟合)训练数据,但是一旦应用到新的业务真实数据时,效果是一塌糊涂。

针对原因1的解决方法:

合理、有效地抽样,用相对能够反映业务逻辑的训练集去产生决策树;

针对原因2的解决方法(主要):

剪枝:提前停止树的增长或者对已经生成的树按照一定的规则进行后剪枝。

剪枝是一个简化过拟合决策树的过程。有两种常用的剪枝方法:

先剪枝(prepruning):通过提前停止树的构建而对树“剪枝”,一旦停止,节点就成为树叶。该树叶可以持有子集元组中最频繁的类;

后剪枝的方法

REP方法是一种比较简单的后剪枝的方法,在该方法中,可用的数据被分成两个样例集合:一个训练集用来形成学习到的决策树,一个分离的验证集用来评估这个决策树在后续数据上的精度,确切地说是用来评估修剪这个决策树的影响。这个方法的动机是:即使学习器可能会被训练集中的随机错误和巧合规律所误导,但验证集合不大可能表现出同样的随机波动。所以验证集可以用来对过度拟合训练集中的虚假特征提供防护检验。

建立了决策树模型后需要给出该模型的评估值,这样才可以来判断模型的优劣。学习算法模型使用训练集 (training set) 建立模型,使用校验集 (test set) 来评估模型。本文通过评估指标和评估方法来评估决策树模型。 评估指标有分类准确度、召回率、虚警率和精确度等。而这些指标都是基于混淆矩阵 (confusion matrix) 进行计算的。

决策树模型评估

混淆矩阵是用来评价监督式学习模型的精确性,矩阵的每一列代表一个类的实例预测,而每一行表示一个实际的类的实例。

sklearn 参数详解

criterion:特征选择的标准,有信息增益和基尼系数两种,使用信息增益的是ID3和C4.5算法(使用信息增益比),使用基尼系数的CART算法,默认是gini系数。

splitter:特征切分点选择标准,决策树是递归地选择最优切分点,spliter是用来指明在哪个集合上来递归,有“best”和“random”两种参数可以选择,best表示在所有特征上递归,适用于数据集较小的时候,random表示随机选择一部分特征进行递归,适用于数据集较大的时候。

max_depth:决策树最大深度,决策树模型先对所有数据集进行切分,再在子数据集上继续循环这个切分过程,max_depth可以理解成用来限制这个循环次数。

min_samples_split:子数据集再切分需要的最小样本量,默认是2,如果子数据样本量小于2时,则不再进行下一步切分。如果数据量较小,使用默认值就可,如果数据量较大,为降低计算量,应该把这个值增大,即限制子数据集的切分次数。

min_samples_leaf:叶节点(子数据集)最小样本数,如果子数据集中的样本数小于这个值,那么该叶节点和其兄弟节点都会被剪枝(去掉),该值默认为1。

min_weight_fraction_leaf:在叶节点处的所有输入样本权重总和的最小加权分数,如果不输入则表示所有的叶节点的权重是一致的。

max_features:特征切分时考虑的最大特征数量,默认是对所有特征进行切分,也可以传入int类型的值,表示具体的特征个数;也可以是浮点数,则表示特征个数的百分比;还可以是sqrt,表示总特征数的平方根;也可以是log2,表示总特征数的log个特征。

random_state:随机种子的设置,与LR中参数一致。

max_leaf_nodes:最大叶节点个数,即数据集切分成子数据集的最大个数。

min_impurity_decrease:切分点不纯度最小减少程度,如果某个结点的不纯度减少小于这个值,那么该切分点就会被移除。

min_impurity_split:切分点最小不纯度,用来限制数据集的继续切分(决策树的生成),如果某个节点的不纯度(可以理解为分类错误率)小于这个阈值,那么该点的数据将不再进行切分。

class_weight:权重设置,主要是用于处理不平衡样本,与LR模型中的参数一致,可以自定义类别权重,也可以直接使用balanced参数值进行不平衡样本处理。

presort:是否进行预排序,默认是False,所谓预排序就是提前对特征进行排序,我们知道,决策树分割数据集的依据是,优先按照信息增益/基尼系数大的特征来进行分割的,涉及的大小就需要比较,如果不进行预排序,则会在每次分割的时候需要重新把所有特征进行计算比较一次,如果进行了预排序以后,则每次分割的时候,只需要拿排名靠前的特征就可以了。

对象/属性

classes_:分类模型的类别,以字典的形式输出

clf.classes_

array([0, 1, 2])#表示0,1,2类别

feature_importances_:特征重要性,以列表的形式输出每个特征的重要性max_features_:最大特征数

n_classes_:类别数,与classes_对应,classes_输出具体的类别

n_features_:特征数,当数据量小时,一般max_features和n_features_相等

n_outputs_:输出结果数

tree_:输出整个决策树,用于生成决策树的可视化

clf.tree_

方法

decision_path(X):返回X的决策路径

fit(X, y):在数据集(X,y)上使用决策树模型

get_params([deep]):获取模型的参数

predict(X):预测数据值X的标签

predict_log_proba(X):返回每个类别的概率值的对数

predict_proba(X):返回每个类别的概率值(有几类就返回几列值)

score(X,y):返回给定测试集和对应标签的平均准确率

代码范例请参考

https://github.com/asd3427/Tree