第十七章 Linux集群架构(二)

八、LVS DR模式搭建

九、keepalived + LVS

十、扩展

八、LVS DR模式搭建

实验环境

三台虚拟机,都需要关闭firewalld服务, 并且安装iptables-serives服务, 启动iptables服务,并清空iptables规则

分发器,也叫调度器(简写为dir)

主机名:lvs-lb

内网:192.168.239.133

主机名:rs1

内网:192.168.239.137

主机名:rs2

内网:192.168.239.139

最好再加一台,作为client测试时使用。 IP:192.168.239.128

修改nginx默认主页的内容为IP地址,方便测试时判断。

DR模式比NAT模式多了一个VIP,虚拟IP ,分发器和 rs 都需要绑定这个VIP

VIP:192.168.239.111

1. 在三台虚拟机上停用firewalld,启用iptables

//停用firewalld

systemctl stop firewalld

systemctl disable firewalld

//如果未安装iptables,用yum安装一下

yum -y install iptables-services

systemctl start iptables-services

//清空、保存规则

iptables -F; service iptables save

2. 在分发器上安装ipvsdam

[root@dir ~]# yum install -y ipvsdam

3. 在director上配置脚本,vim /usr/local/sbin/lvs_nat.sh 内容如下

[root@dir ~]# vim /usr/local/sbin/lvs_dr.sh

#! /bin/bash

#开启转发

echo 1 > /proc/sys/net/ipv4/ip_forward

# 设置变量

ipv=/usr/sbin/ipvsadm

vip=192.168.239.111

rs1=192.168.239.137

rs2=192.168.239.139

# 绑定VIP ,注意这里的网卡名字,需要用自己的网卡名

ifdown ens33

ifup ens33

ifconfig ens33:2 $vip broadcast $vip netmask 255.255.255.255 up

#设置路由

route add -host $vip dev ens33:2

# 配置LVS规则

$ipv -C

$ipv -A -t $vip:80 -s wrr # 加权轮循模式的LVS虚拟服务器

$ipv -a -t $vip:80 -r $rs1:80 -g -w 2 # -g 使用DR模式,-t 指定的IP为VIP ,权重为2

$ipv -a -t $vip:80 -r $rs2:80 -g -w 1

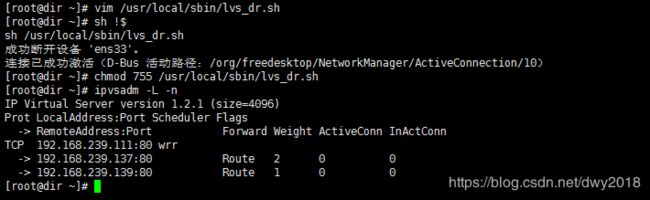

给脚本赋予755权限,执行脚本,使用ipvsadm -ln 命令查看ipvsadm规则

[root@dir ~]# chmod 755 /usr/local/sbin/lvs_dr.sh

[root@dir ~]# sh /usr/local/sbin/lvs_dr.sh

[root@dir ~]# ipvsadm -L -n

4. 在两个rs上配置脚本,vim /usr/local/sbin/lvs_rs.sh 内容如下

[root@rs1 ~]# vim /usr/local/sbin/lvs_rs.sh

#/bin/bash

vip=192.168.239.111

#把vip绑定在lo上,是为了实现rs直接把结果返回给客户端

ifdown lo

ifup lo

ifconfig lo:0 $vip broadcast $vip netmask 255.255.255.255 up

route add -host $vip lo:0

#以下操作为更改arp内核参数,目的是为了让rs顺利发送mac地址给客户端

echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/lo/arp_announce

echo "1" >/proc/sys/net/ipv4/conf/all/arp_ignore

echo "2" >/proc/sys/net/ipv4/conf/all/arp_announce

给脚本赋予755权限,执行脚本

[root@rs1 ~]# vim /usr/local/sbin/lvs_rs.sh

[root@rs1 ~]# chmod 755 /usr/local/sbin/lvs_rs.sh

[root@rs1 ~]# sh /usr/local/sbin/lvs_rs.sh

5. 测试

当前采用的是rr调度算法,2:1的权重轮循算法测试结果OK

[root@Linux01 ~]# curl 192.168.239.111

九、keepalived + LVS

LVS可以实现负载均衡,但是不能够进行健康检查,如一个rs出现故障,LVS 仍然会把请求转发给故障的rs服务器,这就会导致请求的无效性。keepalive 软件可以进行健康检查,而且能同时实现 LVS 的高可用性,解决 LVS 单点故障的问题,其实 keepalive 就是为 LVS 而生的。

keepalived + LVS实验环境说明:

完整架构需要两台服务器(角色为dir)分别安装keepalived软件,目的是实现高可用,

但keepalived本身也有负载均衡的功能,所以本次实验可以只安装一台keepalived

keepalived内置了ipvsadm的功能,所以不需要再安装ipvsadm包,也不用编写和执行那个lvs_dir的脚本

分发器,也叫调度器(简写为dir)

主机名:lvs-lb

内网:192.168.239.133(安装keepalived)

主机名:rs1

内网:192.168.239.137

主机名:rs2

内网:192.168.239.139

修改nginx默认主页的内容为IP地址,方便测试时判断。

VIP:192.168.239.111

1. dir上安装keepalived

[root@dir ~]# yum install keepalived -y

2. dir上编辑keepalived配置文件 vim /etc/keepalived/keepalived.conf

内容参考:https://coding.net/u/aminglinux/p/aminglinux-book/git/blob/master/D21Z/lvs_keepalived.conf

[root@dir ~]# vim /etc/keepalived/keepalived.conf

vrrp_instance VI_1 {

#备用服务器上为 BACKUP

state MASTER

#绑定vip的网卡为ens33,你的网卡和阿铭的可能不一样,这里需要你改一下

interface ens33

virtual_router_id 51

#备用服务器上为90

priority 100

advert_int 1

authentication {

auth_type PASS

auth_pass wenyang

}

virtual_ipaddress {

192.168.239.111

}

}

virtual_server 192.168.239.111 80 {

#(每隔10秒查询realserver状态)

delay_loop 10

#(lvs 算法)

lb_algo wlc

#(DR模式)

lb_kind DR

#(同一IP的连接60秒内被分配到同一台real server)

persistence_timeout 60

#(用TCP协议检查realserver状态)

protocol TCP

real_server 192.168.239.137 80 {

#(权重)

weight 100

TCP_CHECK {

#(10秒无响应超时)

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

real_server 192.168.239.139 80 {

weight 100

TCP_CHECK {

connect_timeout 10

nb_get_retry 3

delay_before_retry 3

connect_port 80

}

}

}

##注意根据自己的ip来配置

3. 清空之前的ipvsadm规则和VIP

[root@dir ~]# ipvsadm -C

[root@dir ~]# systemctl restart network

#最好每个主机都执行一遍

两台rs上,依然要执行/usr/local/sbin/lvs_rs.sh脚本

[root@rs1 ~]# sh /usr/local/sbin/lvs_rs.sh

[root@rs2 ~]# sh /usr/local/sbin/lvs_rs.sh

然后启动dir上的keepalived:

[root@rs1 ~]# systemctl start keepalived

[root@dir ~]# ps -ef | grep keep

4. 测试

查看ipvsadm规则,可以看到目前有两台 rs

①模拟故障,关闭rs1上的nginx

[root@rs1 ~]# netstat -lntp|grep 80

再次查看 dir 上的 ipvsadm 规则,只有一台 rs 的规则了。 可能需要过几秒钟才会有变化

在客户端上访问,结果正常,只是不会出现访问192.168.239.137节点,一直访问192.168.239.139节点

②重启rs1上的nginx

[root@rs1 ~]# /usr/local/nginx/sbin/nginx

再查看 dir 的 ipvsadm规则,可以看到又有了两台 rs

在客户端上访问,结果正常,按照正常调度算法访问192.168.239.137和192.168.239.139

十、扩展

heartbeat和keepalived比较http://blog.csdn.net/yunhua_lee/article/details/9788433

DRBD工作原理和配置 http://502245466.blog.51cto.com/7559397/1298945

mysql+keepalived : http://lizhenliang.blog.51cto.com/7876557/1362313

lvs 三种模式详解 http://www.it165.net/admin/html/201401/2248.html

lvs几种算法 http://www.aminglinux.com/bbs/thread-7407-1-1.html

关于arp_ignore和 arp_announce http://www.cnblogs.com/lgfeng/archive/2012/10/16/2726308.html

lvs原理相关的 http://blog.csdn.net/pi9nc/article/details/23380589

haproxy+keepalived http://blog.csdn.net/xrt95050/article/details/40926255

nginx、lvs、haproxy比较 http://www.csdn.net/article/2014-07-24/2820837

keepalived中自定义脚本 vrrp_script http://my.oschina.net/hncscwc/blog/158746

lvs dr模式只使用一个公网ip的实现方法 http://storysky.blog.51cto.com/628458/338726