首先要了解以下FFmpeg是什么?

简介:

FFmpeg是一套可以用来记录、转换数字音频、视频,并能将其转化为流的开源计算机程序。采用LGPL或GPL许可证。它提供了录制、转换以及流化音视频的完整解决方案。它包含了非常先进的音频/视频编解码库libavcodec,为了保证高可移植性和编解码质量,libavcodec里很多code都是从头开发的。

FFmpeg在Linux平台下开发,但它同样也可以在其它操作系统环境中编译运行,包括Windows、Mac OS X等。这个项目最早由Fabrice Bellard发起,2004年至2015年间由Michael Niedermayer主要负责维护。许多FFmpeg的开发人员都来自MPlayer项目,而且当前FFmpeg也是放在MPlayer项目组的服务器上。项目的名称来自MPEG视频编码标准,前面的"FF"代表"Fast Forward"。

组成部分:

FFmpeg工具:

FFmpeg:用于转码的应用程序

FFplay:用于播放的应用程序

FFprobe:用于查看文件格式的应用程序

FFmpeg开发库:

Libavcodec:音视频编解码器

Libavutil:音视频工具库

Libavformat:封装格式的处理

Libavdevice:(读设备)可以读取电脑的多媒体设备的数据,或者输出数据到指定的多媒体设备上。

Libavfilter:(加特效)可以给视音频添加各种滤镜效果,如:给视频添加水印,给YUV数据加特效

Libavswscale:(图像拉伸,像素格式转换)可以转换像素数据的格式,同时可以拉伸图像的大小。

Libswresample:音视频采样工具库

编译和使用

一、FFmpeg编译动态库

编译环境:

NDK 17版本;

FFmpeg 4.0.2

编译流程:

1、下载FFmpeg:http://ffmpeg.org/download.html

从官网下载FFmpeg的源码:

wget https://ffmpeg.org/release/ffmpeg-4.0.2.tar.bz2

下载完成后使用tar工具解压:

tar xvf ffmpeg-4.0.2.tar.bz2

2、下载NDK(https://developer.android.google.cn/ndk/downloads/)以及配置环境变量

3、交叉编译:

FFmpeg解压之后进入ffmpeg目录,可以看到里面有各种文件,文档,需要关注的事configure文件。这个文件是一个shell脚本,作用为生成makefile文件,然后使用make执行。如果需要在Android 中使用,那就需要进行交叉编译。

下面是交叉编译shell脚本内容:

#!/bin/bash

#这里定义变量,后续会使用

#TOOLCHAIN 变量指向ndk中的交叉编译gcc所在的目录

NDK_ROOT=/root/android-ndk-r17c

TOOLCHAIN=$NDK_ROOT/toolchains/arm-linux-androideabi-4.9/prebuilt/linux-x86_64

#FLAGS与INCLUDES变量 可以从AS ndk工程的.externativeBuild/cmake/debug/armeabi-v7a/build.ninja中拷贝,需要注意的是**地址**

FLAGS="-isystem $NDK_ROOT/sysroot/usr/include/arm-linux-androideabi -D__ANDROID_API__=21 -g -DANDROID -ffunction-sections -funwind-tables -fstack-protector-strong -no-canonical-prefixes -march=armv7-a -mfloat-abi=softfp -mfpu=vfpv3-d16 -mthumb -Wa,--noexecstack -Wformat -Werror=format-security -std=c++11 -O0 -fPIC"

INCLUDES="-isystem $NDK_ROOT/sources/cxx-stl/llvm-libc++/include -isystem $NDK_ROOT/sources/android/support/include -isystem $NDK_ROOT/sources/cxx-stl/llvm-libc++abi/include"

#此变量用于编译完成之后的库与头文件存放在哪个目录

PREFIX=./android/armeabi-v7a

#执行configure脚本,用于生成makefile

#--prefix : 安装目录

#--enable-small : 优化大小

#--disable-programs : 不编译ffmpeg程序(命令行工具),我们是需要获得静态(动态)库。

#--disable-avdevice : 关闭avdevice模块,此模块在android中无用

#--disable-encoders : 关闭所有编码器 (播放不需要编码)

#--disable-muxers : 关闭所有复用器(封装器),不需要生成mp4这样的文件,所以关闭

#--disable-filters :关闭视频滤镜

#--enable-cross-compile : 开启交叉编译(ffmpeg比较**跨平台**,并不是所有库都有这么happy的选项 )

#--cross-prefix: 看右边的值应该就知道是干嘛的,gcc的前缀 xxx/xxx/xxx-gcc 则给xxx/xxx/xxx-

#disable-shared enable-static 不写也可以,默认就是这样的。

#--sysroot:

#--extra-cflags: 会传给gcc的参数

#--arch --target-os : 不给不行

./configure \

--prefix=$PREFIX \

--enable-small \

--disable-programs \

--disable-avdevice \

--disable-encoders \

--disable-muxers \

--disable-filters \

--enable-cross-compile \

--cross-prefix=$TOOLCHAIN/bin/arm-linux-androideabi- \

--disable-shared \

--enable-static \

--sysroot=$NDK_ROOT/platforms/android-21/arch-arm \

--extra-cflags="$FLAGS $INCLUDES" \

--extra-cflags="-isysroot $NDK_ROOT/sysroot" \

--arch=arm \

--target-os=android

#上面运行脚本生成makefile之后,使用make执行脚本

make clean

make install

编译成功之后会生成一个android目录,这个目录中的文件就是我们编译后生成的项目配置需要的

二、FFmpeg命令详解

FFmpeg录制命令:

ffmpeg -f gdigrab -framerate 30 -offset_x 0 -offset_y 0 -video_size 1920x1080 -i desktop out.mpg

-gdigrab:表明我们是通过gdi抓屏的方式;(mac 下 avfoundation)

--framerate 30 :表示录制的帧率是30;

--offset_x :左上偏移量X;

--offset_y:左上偏移量Y;

--video_size:需要录制的宽高

--i :输入路径和名称以及格式mpg

--desktop :录制屏幕,可以录制窗口,不过得用窗口ID;

分解复用命令

抽取音频流:

ffmpeg -i input.mp4 -acodec copy -vn out.aac

acodec:指定音频编码器,

copy:只copy,不做编解码

vn:v 代表视频,n代表no,也就是无视频得意思

抽取视频流:

ffmpeg -i input.mp4 -vcodec copy -an out.h264

vcodec:指定视频编码器

合成视频:

ffmpeg -i out.h264 -i out.aac -vcodec copy -acodec copy out.mp4

处理原始数据

提取YUV数据(视频):

ffmpeg -i input.mp4 -an -c:v rawvideo -pix_fmt yuv420p out.yuv

-c:v rawvideo 指定将视频转成原始数据

-pixel_format yuv420p 指定转换格式为yuv420p

注:未经编码得原始数据可以使用ffplay播放:ffplay -s 608x368 out.yuv

提取PCM数据(音频):

ffmpeg -i input.mp4 -vn -ar 44100 -ac 2 -f s16le out.pcm

-ar:指定音频采样率44100 即44.1KHz

-ac:指定音频声道channel 2为双声道

-f:数据存储格式 s :Signed 有符号的 16:每一个数值用16位表示:l:little,e:end

注:未经过编码的音频原始数据可用ffplay播放:ffplay -ar 44100 -ac 2 -f s16le out.pcm

FFmpeg滤镜命令

裁剪滤镜:

ffmpeg -i input.mp4 -vf crop=in_w-200:in_h-200 -c:v libx264 -c:a copy crop.mp4

复杂命令详解请看:https://www.jianshu.com/p/ddafe46827b7

三、Android Studio中集成FFmpeg

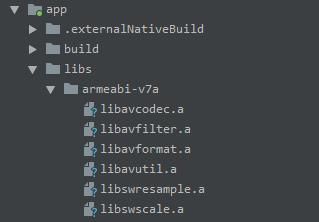

第一步:将1中编译生成的动态库文件导入AS工程:

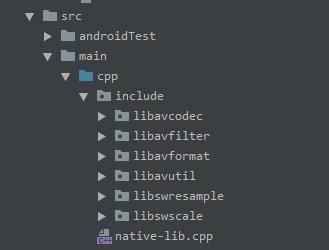

lib目录导入源文件

src/main/cpp/include目录中导入头文件

第二步:app/build.gradlez中配置CPU架构

第三步:配置编译app/CMakeLists.txt文件

cmake_minimum_required(VERSION 3.4.1)

add_library(

native-lib //库名称

SHARED // 动态库 STATIC 表示静态库

src/main/cpp/native-lib.cpp) // 编译cpp源码

include_directories(src/main/cpp/include) // 导入头文件目录

set(CMAKE_CXX_FLAGS "${CMAKE_CXX_FLAGS} -L${CMAKE_SOURCE_DIR}/libs/${ANDROID_ABI}") //赋值CMAKE_CXX_FLAGS 实际目录libs/armeabi-v7a

find_library(

log-lib

log)

target_link_libraries( //导入预编译库

native-lib

avcodec avfilter avformat avutil swresample swscale

${log-lib})

第四步:使用,并打印出FFmpeg版本信息

app\src\main\cpp\native-lib.cpp

#include

#include

extern "C" {

#include

}

extern "C" {

#include

}

extern "C" JNIEXPORT jstring JNICALL

Java_com_yan_myplayer2_MainActivity_stringFromJNI(

JNIEnv *env,

jobject /* this */) {

std::string hello = "Hello from C++";

return env->NewStringUTF(av_version_info());// 打印版本信息

}