k8s集群部署二:flannel网络、为node节点创建kubeconfig文件

Overlay Network模式

覆盖网络,在基础网络上叠加的一种虚拟网络技术模式,该网络中的主机通过虚拟链路连接起来。

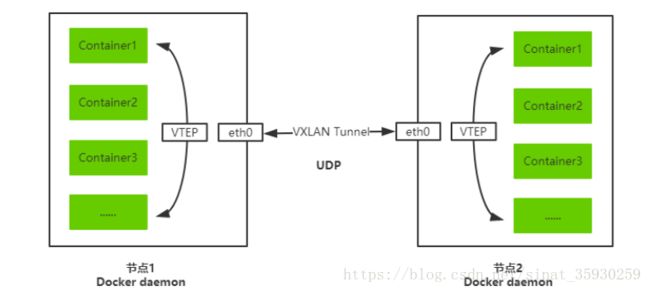

VXLAN

将源数据包封装到UDP中,并使用基础网络的IP/MAC作为外层报文头进行封装,然后在以太网上传输,到达目的地后由隧道端点解封装并将数据发送给目标地址。

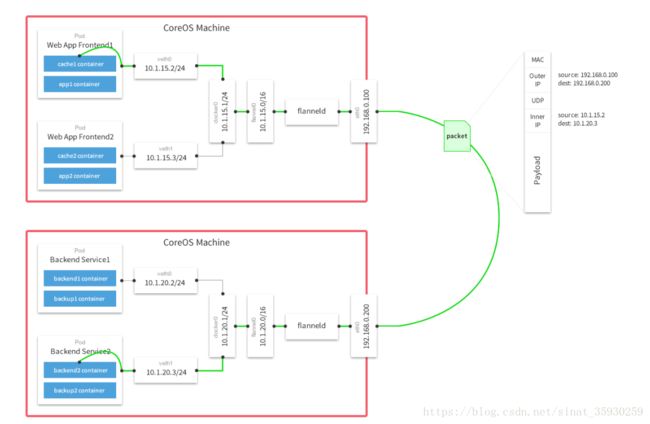

Flannel

是Overlay网络的一种,也是将源数据包封装在另一种网络包里面进行路由转发和通信,目前已经支持UDP、VXLAN、AWS VPC和GCE路由等数据转发方式。

Flannel通过给每台宿主机分配一个子网的方式为容器提供虚拟网络,它基于Linux TUN/TAP,使用UDP封装IP包来创建overlay网络,并借助etcd维护网络的分配情况。

多主机容器网络通信其他主流方案:隧道方案( Weave、OpenvSwitch ),路由方案(Calico)等。

flannel部署

以下操作在所有的node节点上均执行一次

下载并安装flannel

两种方法安装flannel:

wget https://github.com/coreos/flannel/releases/download/v0.9.1/flannel-v0.9.1-linux-amd64.tar.gz

tar zxf flannel-v0.9.1-linux-amd64.tar.gz

// 解压之后得到两个文件:flanneld和mk-docker-opts.sh

mv flanneld mk-docker-opts.sh /opt/kubernetes/bin/设置flannel配置文件

cat </opt/kubernetes/cfg/flanneld

FLANNEL_OPTIONS="--etcd-endpoints=https://10.10.99.233:2379,https://10.10.99.225:2379,https://10.10.99.228:2379 \

-etcd-cafile=/opt/kubernetes/ssl/ca.pem \

-etcd-certfile=/opt/kubernetes/ssl/server.pem \

-etcd-keyfile=/opt/kubernetes/ssl/server-key.pem"

EOF 设置flannel服务启动文件

cat </usr/lib/systemd/system/flanneld.service

[Unit]

Description=Flanneld overlay address etcd agent

After=network-online.target network.target

Before=docker.service

[Service]

Type=notify

EnvironmentFile=/opt/kubernetes/cfg/flanneld

ExecStart=/opt/kubernetes/bin/flanneld --ip-masq \$FLANNEL_OPTIONS

ExecStartPost=/opt/kubernetes/bin/mk-docker-opts.sh -k DOCKER_NETWORK_OPTIONS -d /run/flannel/subnet.env

Restart=on-failure

[Install]

WantedBy=multi-user.target

EOF

重新设置docker启动文件

cat </usr/lib/systemd/system/docker.service

[Unit]

Description=Docker Application Container Engine

Documentation=https://docs.docker.com

After=network-online.target firewalld.service

Wants=network-online.target

[Service]

Type=notify

EnvironmentFile=/run/flannel/subnet.env

ExecStart=/usr/bin/dockerd \$DOCKER_NETWORK_OPTIONS

ExecReload=/bin/kill -s HUP \$MAINPID

LimitNOFILE=infinity

LimitNPROC=infinity

LimitCORE=infinity

TimeoutStartSec=0

Delegate=yes

KillMode=process

Restart=on-failure

StartLimitBurst=3

StartLimitInterval=60s

[Install]

WantedBy=multi-user.target

EOF 写入分配的子网段到etcd,供flanneld使用

/opt/kubernetes/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://10.10.99.225:2379,https://10.10.99.228:2379,https://192.168.0.10.10.99.233:2379" set /coreos.com/network/config '{ "Network": "172.17.0.0/16", "Backend": {"Type": "vxlan"}}'

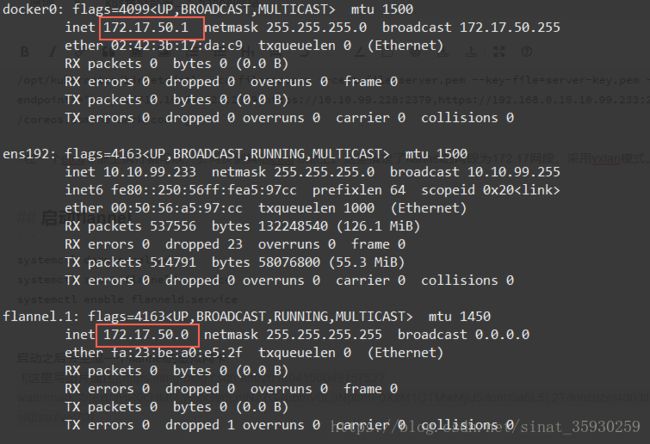

/opt/kubernetes/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://10.10.99.225:2379,https://10.10.99.228:2379,https://192.168.0.10.10.99.233:2379" get /coreos.com/network/config在一个etcd节点上执行就可以,会同步到其他etcd节点上。这里指定了flannel的网段为172.17网段,采用vxlan模式。

启动flannel

systemctl daemon-reload

systemctl start flanneld.service

systemctl enable flanneld.service重启docker

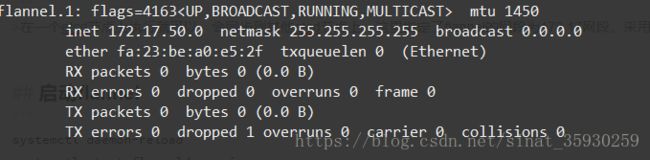

systemctl restart docker可以看到docker的虚拟网桥的ip已经应用到flannel网络中

测试

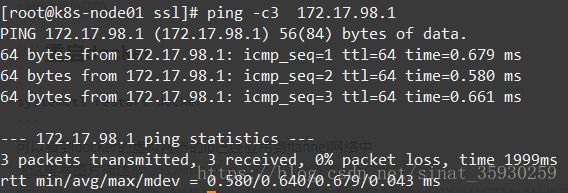

node01上docker网桥的ip为:172.17.50.1,node02上docker网桥ip为:172.17.98.1。

测试flannel是否正常工作的最简单的方法就是在一个node节点上ping另一个node节点的docker网桥,能通则工作正常。

查看etcd存储的flannel网络信息

查看flannel分配的网段和网络类型

/opt/kubernetes/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://10.10.99.225:2379,https://10.10.99.228:2379,https://192.168.0.10.10.99.233:2379" get /coreos.com/network/config![]()

可以看到分配的网段是172.17.0.0/16,类型为vxlan

查看subnets中保存的key

/opt/kubernetes/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://10.10.99.225:2379,https://10.10.99.228:2379,https://192.168.0.10.10.99.233:2379" ls /coreos.com/network/subnets![]()

subnets为每一个节点保存了一个key,其中名称为节点flannel的ip和掩码,每增加一个节点就会将节点flannel的ip保存在这里。

查看节点flannel具体信息

/opt/kubernetes/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://10.10.99.225:2379,https://10.10.99.228:2379,https://192.168.0.10.10.99.233:2379" get /coreos.com/network/subnets/172.17.50.0-24![]()

可以看到etcd保存了节点的IP地址和vtep的虚拟MAC地址。当有多个节点的时候flannel就是根据这个判断某个容器在哪个节点上。

node节点创建kubeconfig文件

以下操作在master上进行,然后统一分发到node节点上

kubeconfig是用于在node节点上kubelet和kube-proxy访问集群的认证。

下载kubectl

在master上下载kubectl

wget https://storage.googleapis.com/kubernetes-release/release/v1.9.0/bin/linux/amd64/kubectl

chmod +x kubectl

mv kubectl /opt/kubernetes/bin创建 TLS Bootstrapping Token

TLS Bootstrapping Token用于引导kubelet自动生成证书。

cd /root/ssl

export BOOTSTRAP_TOKEN=$(head -c 16 /dev/urandom | od -An -t x | tr -d ' ')

cat > token.csv <<EOF

> ${BOOTSTRAP_TOKEN},kubelet-bootstrap,10001,"system:kubelet-bootstrap"

> EOF可以看一下token.csv文件的内容:b199e9e53ee694ea24e5b874dfc455bb,kubelet-bootstrap,10001,"system:kubelet-bootstrap",其中涉及到RBAC的知识。它表示使用kubelet-bootstrap并拥有10001权限,通过kubelet-bootstrap用户组使用第一个随机字符串来访问k8s集群。

创建bootstrap.kubeconfig

这个文件是用于kubelet自动签发证书的。

// 首先指定kube-api访问入口,即master ip

export KUBE_APISERVER="https://10.10.99.225:6443"

// 设置集群参数

kubectl config set-cluster kubernetes --certificate-authority=./ca.pem --embed-certs=true --server=${KUBE_APISERVER} --kubeconfig=bootstrap.kubeconfig

// 设置客户端认证参数

kubectl config set-credentials kubelet-bootstrap --token=${BOOTSTRAP_TOKEN} --kubeconfig=bootstrap.kubeconfig

// 设置上下文参数

kubectl config set-context default --cluster=kubernetes --user=kubelet-bootstrap --kubeconfig=bootstrap.kubeconfig

// 设置默认上下文

kubectl config use-context default --kubeconfig=bootstrap.kubeconfig执行完后将生成bootstrap.kubeconfig文件

创建kube-proxy kubeconfig文件

// 设置集群参数

kubectl config set-cluster kubernetes --certificate-authority=./ca.pem --embed-certs=true --server=${KUBE_APISERVER} --kubeconfig=kube-proxy.kubeconfig

// 设置客户端认证参数

kubectl config set-credentials kube-proxy --client-certificate=./kube-proxy.pem --client-key=./kube-proxy-key.pem --embed-certs=true --kubeconfig=kube-proxy.kubeconfig

// 设置上下文参数

kubectl config set-context default --cluster=kubernetes --user=kube-proxy --kubeconfig=kube-proxy.kubeconfig

// 设置默认上下文

kubectl config use-context default --kubeconfig=kube-proxy.kubeconfig执行完后将生成kube-proxy.kubeconfig文件