Hive 自定义函数(UDF,UDAF,UDTF)详解

1.自定义函数简单介绍

1.1 概述

Hive 自带了一些函数,比如:max/min等,但是数量有限,自己可以通过自定义UDF来方便的扩展。当Hive提供的内置函数无法满足你的业务处理需要时,此时就可以考虑使用用户自定义函数(UDF:user-defined function)。根据用户自定义函数类别分为以下三种:

• UDF(User-Defined-Function):一进一出

• UDAF(User-Defined Aggregation Function):聚集函数,多进一出。如:count/max/min

• UDTF(User-Defined Table-Generating Functions):一进多出。如 lateral view explore()

1.2 官方文档:https://cwiki.apache.org/confluence/display/Hive/HivePlugins

1.3 编程步骤:

• 继承org.apache.hadoop.hive.ql.UDF

• 需要实现evaluate函数;evaluate函数支持重载;

• 在hive的命令行窗口创建函数

a)添加jar:add jar linux_jar_path

b)创建function:create [temporary] function [dbname]function_name AS class_name;

• 在hive的命令行窗口删除函数

Drop [temporary] function [if exists] [dbname.]function_name;

• 注意事项

UDF必须要有返回类型,可以返回null,但是返回类型不能为void;

2.自定义UDF函数

2.1 创建一个Maven工程Hive

2.2 导入依赖

org.apache.hive

hive-exec

1.2.1

2.3 创建一个类

package com.luomk.hive;

import org.apache.hadoop.hive.ql.exec.UDF;

public class Lower extends UDF {

public String evaluate (final String s) {

if (s == null) {

return null;

}

return s.toLowerCase();

}

}2.4 打成jar包上传到服务器/opt/module/jars/udf.jar

2.5 将jar包添加到hive的classpath

hive (default)> add jar /opt/module/datas/udf.jar;

2.6 创建临时函数与开发好的java class关联

hive (default)> create temporary function mylower as "com.atguigu.hive.Lower";

2.7 即可在hql中使用自定义的函数strip

hive (default)> select ename, udf_lower(ename) lowername from emp;

3.Hive 行转列(UDAF) 聚合函数

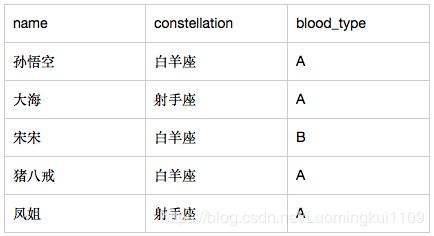

3.1 数据准备

3.2 需求:把星座和血型一样的人归类到一起。结果如下:

射手座,A 大海|凤姐

白羊座,A 孙悟空|猪八戒

白羊座,B 宋宋3.3 实现步骤:

3.3.1 创建本地constellation.txt,导入数据

[luomk@hadoop102 datas]$ vi constellation.txt

孙悟空 白羊座 A

大海 射手座 A

宋宋 白羊座 B

猪八戒 白羊座 A

凤姐 射手座 A3.3.2 创建hive表并导入数据

create table person_info(

name string,

constellation string,

blood_type string)

row format delimited fields terminated by "\t”;

load data local inpath “/opt/module/datas/person_info.txt” into table person_info;3.3.2 按需求查询数据

select

t1.base,

concat_ws('|', collect_set(t1.name)) name

from

(select

name,

concat(constellation, ",", blood_type) base

from

person_info) t1

group by

t1.base;3.3.3 最终结果如下:

3.4 相关函数说明

CONCAT(string A/col, string B/col…):返回输入字符串连接后的结果,支持任意个输入字符串;

CONCAT_WS(separator, str1, str2,...):它是一个特殊形式的 CONCAT()。第一个参数剩余参数间的分隔符。分隔符可以是与剩余参数一样的字符串。如果分隔符是 NULL,返回值也将为 NULL。这个函数会跳过分隔符参数后的任何 NULL 和空字符串。分隔符将被加到被连接的字符串之间;

COLLECT_SET(col):函数只接受基本数据类型,它的主要作用是将某字段的值进行去重汇总,产生array类型字段。

4.列转行 (UDTF)对某列拆分,一列拆多行

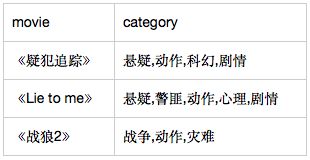

4.1 数据准备

4.2 需求:将电影分类中的数组数据展开。结果如下:

4.3 实现步骤:

4.3.1 创建本地movie.txt,导入数据

[luomk@hadoop102 datas]$ vi movie.txt

《疑犯追踪》 悬疑,动作,科幻,剧情

《Lie to me》 悬疑,警匪,动作,心理,剧情

《战狼2》 战争,动作,灾难

4.3.2 创建hive表并导入数据

create table movie_info(

movie string,

category array)

row format delimited fields terminated by "\t"

collection items terminated by ",";

load data local inpath "/opt/module/datas/movie.txt" into table movie_info; 4.3.3 按需求查询数据

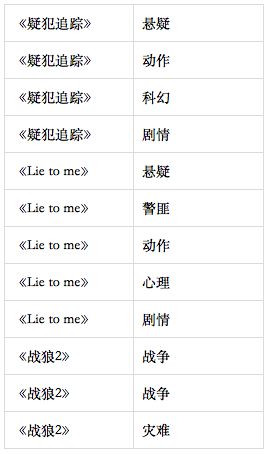

select

movie,

category_name

from

movie_info lateral view explode(category) table_tmp as category_name;4.4 最终结果如下:

4.5 相关函数说明

LATERAL VIEW

用法:LATERAL VIEW udtf(expression) tableAlias AS columnAlias

解释:用于和split, explode等UDTF一起使用,它能够将一列数据拆成多行数据,在此基础上可以对拆分后的数据进行聚合。

EXPLODE(col):将hive一列中复杂的array或者map结构拆分成多行。