Hadoop伪分布式搭建——虚拟机Centos(一个大学生的踩坑之路)

• 下载JDK,使用xftp将下载好的JDK发送到Hadoop服务器中。

• 解压jdk,配置JDK的环境变量

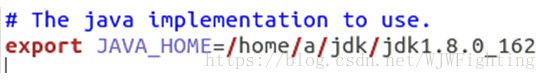

• 在/etc/profile中添加如下代码:

(这里放你们jdk的位置,你们的不一定是/home/a/jdk/jdk1.8....,后面的hadoop位置也是一个道理)

4. 重启配置文件,使其生效。source /etc/profile

5. 到Hadoop的官网http://hadoop.apache.org/releases.html下载hadoop,后缀为.tar.gz。

6. 将下载好的压缩包拷贝到hadoop服务器(注意:不要在windows中解压后复制,如果你在window中解压很可能丢东西,因为在windows中,有些是解压不了的,这时候放到虚拟机很可能)。

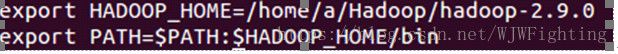

7. 解压:tar –zxvf文件名.tar.gz

8. 配置Hadoopd环境变量,在/etc/profile中添加如下代码:

9. 使配置文件生效。source /etc/profile。

10. 修改hadoop中,etc/hadoop目录下的hadoop-env.sh文件,将其中的JAVA_HOME路径改为我们自己安装的这个JDK路径。

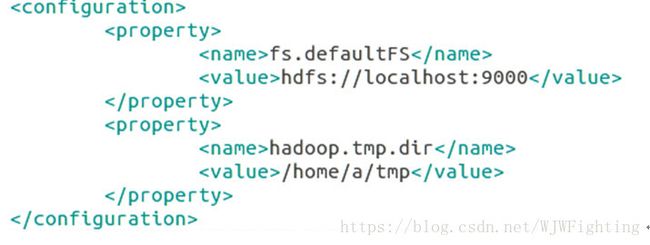

11. 修改hadoop中/etc/hadoop/core-site.xml文件。在

(1)添加指定的默认文件系统名称的配置

(2)添加指定中间数据文件存放目录的配置

添加完后如下图所示。

12. 修改hadoop中etc/hadoop/hdfs-site.xml。将sx默认的副本数3改成1。因为我们现在用的是伪分布式。在

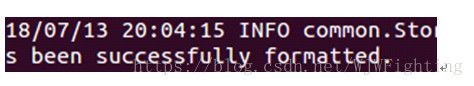

13. 格式化文件系统。执行hadoop中bin目录下的hdfs namenode –format指令即可。

(出现successfully代表初始化成功,一般这句话出现在接近末尾处,从后面找起比较好)

注:这里可能报/jdk/java...文件或目录找不到,说明你的环境变量没配好,所以你要确保你的jdk配好,用(java,javac,java -version)测试下【我之前就是因为某些原因,装了两个jdk(自己并不知道装了两),导致测试java时是正常的,但是就是初始化失败——JAVA_HOME用的是坏的jdk路径,原因是有个jdk是因为不知名的原因用不了——当我卸了那个好的jdk才发现的】,如果你也遇到这问题,重新装个jdk就能轻松搞定,放心这种情况极少出现

14. 启动。执行hadoop中的sbin目录中的./start-dfs.sh。

注:如果报

The authenticity of host 'localhost (127.0.0.1)' can't be established

解决方法:

1.ubuntu@VM-0-15-ubuntu:~/.ssh$ chmod 777 /etc/ssh/ssh_config

2.在文件最后两行加入 StrictHostKeyChecking no

UserKnownHostsFile /dev/null

然后问题迎刃而解

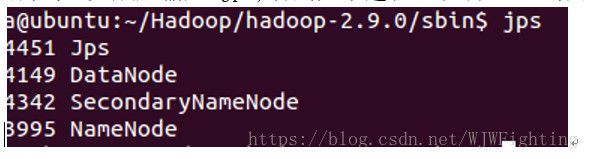

15.检验:接着输入jps

看看有几个,一般是4个,namenode必须要有,说明你成功了。

但是又有一个问题出现了,是不是要输入三次密码,很繁琐,能不能不输入密码,进入免密登录,请点一下链接:https://blog.csdn.net/wjwfighting/article/details/81050913