深度学习图像数据库总结(收藏用)

深度学习数据库总结

感谢感谢~收藏用!

原文出自:https://blog.csdn.net/chaipp0607/article/details/71403797

数据的准备工作是训练模型前的必要工作,显然这也是非常耗时的,所以在入门阶段我们完全可以用现有的开源图片库快速完成前期的准备工作:

ImageNet

ImageNet是根据WordNet层次结构(目前只有名词)组织的图像数据库,其中层次结构的每个节点都由数百和数千个图像描绘。 目前,数据库中每个节点平均拥有超过五百幅图像。 我们希望ImageNet将成为研究人员,教育工作者,学生以及分享我们对图片热情的所有人的有用资源。

ImageNet的一些特点:

ImageNet是全球最大的开源图片库,截至到现在(2017.5)ImageNet共有一千四百多万张图片。其中包括超过20000个synset(s),synset是近义词的合集,synsnet可以理解为ImageNet整理的标签。

说到WordNet层次结构,就要提一下什么是WordNet,WordNet是普林斯顿大学开源的词汇库,可以理解为是一个词典。每个词语(word)可能有多个不同的语义,对应不同的sense。而每个不同的语义(sense)又可能对应多个词,如topic和subject在某些情况下是同义的,WordNet由Princeton 大学的心理学家,语言学家和计算机工程师联合设计的一种基于认知语言学的英语词典。它不是光把单词以字母顺序排列,而且按照单词的意义组成一个“单词的网络”。WordNet 主要有3个主概念 Synset, WordSense 和 Word。而ImageNet就是应用了synset这个概念,只是ImageNet目前只有名词。

由于图片的版权问题,ImageNet中的图片以URLs的形式提供下载,也就是说ImageNet只提供这个图片在哪,而不直接提供图片本身。

我们在ImageNet搜索一个synset的时,左侧可以看到他的层次结构WordNet,在Download中提供了URLs的下载地址。

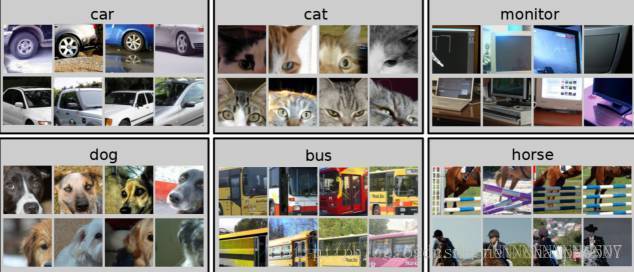

CIFAR

CIFAR由Alex Krizhevsky, Vinod Nair和 Geoffrey Hinton收集并整理,在Visual Dictionary的80万张图片中选择了6万张,并把它们分为CIFAR-10 和CIFAR-100。

CIFAR-10数据集包含60000个32*32的彩色图像,共有10类。有50000个训练图像和10000个测试图像。数据集分为5个训练块和1个测试块,每个块有10000个图像。测试块包含从每类随机选择的1000个图像。训练块以随机的顺序包含这些图像,但一些训练块可能比其它类包含更多的图像。训练块每类包含5000个图像。

CIFAR-100数据集包含100小类,每小类包含600个图像,其中有500个训练图像和100个测试图像。100类被分组为20个大类。

MNIST

MNIST深度学习领域中大名鼎鼎的数据集—MNIST,几乎所有的深度学习教程的入门实例都是手写数字识别,而它们用到的库就是MNIST。这就好比我们学习一门语言的时候显示”hello world”。

MNIST数据集共包含7万个样本,分别是手写体数字0~9,样本大小为28*28。

Labeled Faces in the Wild

Labeled Faces in the Wild数据库中收集了1万3千多张人脸图像,共包含了5000多个人物。每个人标记除了人物的名字外,还包含了其他信息,比如性别,年龄等

Quick Draw

Quick Draw是由google发布的涂鸦数据集,其中包含 5000 万张图画的集合,分成了 345 个类别,它其实就是张这个样子:

这么看起来这个数据集还是挺无聊的,它的发布其实是源于谷歌推出的 AutoDraw ,这是一个能把你的随手涂鸦变成绘画的人工智能技术工具,就是这样(谷歌总是在做一些很好玩的东西):

谷歌也曾发布论文和博客介绍了其背后的技术。实际上,AutoDraw 所用的技术基于谷歌先前的涂鸦实验「Quick, Draw!」。近日,谷歌发布了该项目背后的数据集,就是之前提到的Quick Draw数据集了。这个项目同时发布到了git上,在git的地址中对数据集进行了详细的介绍,在这里简要描述下:

原始数据在 ndjson 文件中,并按类别进行了分割,按照如下格式:

该数据集在谷歌云存储服务中,在 ndjson 文件中分类存储。请参阅 Cloud Console 中的文件列表,数据集分类如下:

Raw files (.ndjson)

Simplified drawings files (.ndjson)

Binary files (.bin)

Numpy bitmap files (.npy)

其中原始文件和简笔画都是.ndjson形式存储,同时提供了二进制文件(.bin)和Numpy 位图(.npy)文件。

Binary files (.bin)

我们也提供了简化后的绘画和元数据的定制二进制格式,可用于高效的压缩和加载。examples/binary_file_parser.py 给出了如何用 Python 加载该文件的示例。

Numpy 位图(.npy)

所有简化过的绘画也都被转换成了 28×28 的灰度位图,保存为 numpy 的 .npy 格式。该文件可以通过 np.load() 函数加载。

AI-Challneger

AI-Challneger是一个由创新工场发起的大赛,其中有6个项目,每一个项目下都提供了配套的数据集,比如场景分类项目下,到目前为止提供了三个数据集,分别是训练集(train),验证集(valuation)和测试集A(test_a),分别包含图片5w+,7k+,7k+;包含80类场景图,支持直接下载原图。

kaggle cats vs. dogs

猫狗大战数据集,大名鼎鼎的kaggle大赛下的数据,一个二分类数据集,训练集中猫狗图片各12500张,测试集中猫狗图片共12500张,支持原图下载。

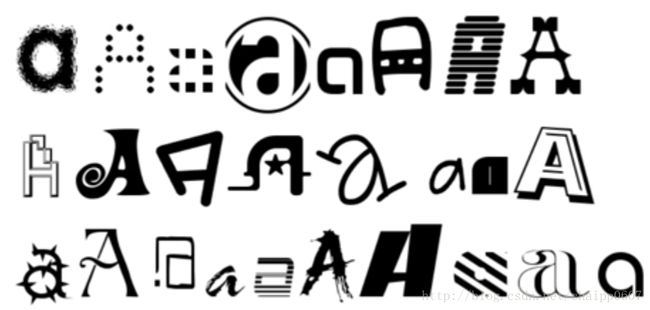

notMNIST

notMNIST数据集起做这个名字是为了致敬MNIST,它提供了从A到J是个字母的图片,图片大小为28*28,而且图片不是手写字母,而是来源于网络上各种各样奇奇怪怪的图片,比如字母A:

该数据集提供了两个版本,其中large版中,每个类大概5.3W左右的图片,总数在53W个,类别间数据比较平均。

Pascal VOC

PASCAL VOC挑战赛是视觉对象的分类识别和检测的一个基准测试,提供了检测算法和学习性能的标准图像注释数据集和标准的评估系统。PASCAL VOC图片集包括20个目录:人类;动物(鸟、猫、牛、狗、马、羊);交通工具(飞机、自行车、船、公共汽车、小轿车、摩托车、火车);室内(瓶子、椅子、餐桌、盆栽植物、沙发、电视)。PASCAL VOC挑战赛在2012年后便不再举办,但其数据集图像质量好,标注完备,非常适合用来测试算法性能。

COCO common objects Dataset

COCO数据集由微软赞助,其对于图像的标注信息不仅有类别、位置信息,还有对图像的语义文本描述,COCO数据集的开源使得近两三年来图像分割语义理解取得了巨大的进展,也几乎成为了图像语义理解算法性能评价的“标准”数据集。Google的开源show and tell生成模型就是在此数据集上测试的。

目前包含的比赛项目有:

1.目标检测(COCO Detection Challenge),包含两项比赛:

输出目标物的边框即可(using bounding box output),也就是我们常说的目标检测(object detection)了

要求把目标物从图像中分割出来(object segmentation output),即我们所说的图像语义分割(Semantic image segmentation)

2.图像标注(COCO Captioning Challenge)

具体说来就是一句话准确描述图片上的信息(producing image captions that are informative and accurate)。那这个怎么评分呢?目前是靠人工评分。

3.人体关键点检测(COCO Keypoint Challenge)

比赛要求是找到人在哪,然后定位到人体的一些关键点位置(The keypoint challenge involves simultaneously detecting people and localizing their keypoints)。

CityScapes

CityScapes数据场景包括50个不同城市(主要在德国),春夏秋三个季节白天的场景,有大量的动态目标不同层次的场景和多样的背景。场景不包括下大雨的和下雪的,因为这种场景需要用特殊的技术处理。

图像数据分为30类:除了有 5000帧细标注的(像素级别的),标注一张图时间控制在1.5h左右,精细标注的数据划分成如下图训练验证测试集,不是随机划分的,而是确保每个划分的数据集里面包含各种场景。最终有2975张用来训练,500张用来验证,1525张用来测试。此外,还有20000张弱标注的帧,只用来训练,标注一张图控制在7min内。

持续更新中……