- 【计算机网络】第三章:数据链路层(上)

iFulling

计算机网络笔记计算机网络网络网络协议笔记

本篇笔记课程来源:王道计算机考研计算机网络接下节:【计算机网络】第三章:数据链路层(下)【计算机网络】第三章:数据链路层(上)一、数据链路层的功能1.基本概念2.功能总览二、组帧(封装成帧)1.主要实现2.字符计数法3.字节填充法4.零比特填充法5.违规编码法三、差错控制1.主要实现2.检错编码Ⅰ.奇偶校验码Ⅱ.循环冗余校验码3.纠错编码Ⅰ.海明校验码四、流量控制、可靠传输1.相关机制Ⅰ.滑动窗口

- C练题笔记之:Leetcode-393. UTF-8 编码验证

月团子

c语言leetcode算法

题目:给定一个表示数据的整数数组data,返回它是否为有效的UTF-8编码。UTF-8中的一个字符可能的长度为1到4字节,遵循以下的规则:对于1字节的字符,字节的第一位设为0,后面7位为这个符号的unicode码。对于n字节的字符(n>1),第一个字节的前n位都设为1,第n+1位设为0,后面字节的前两位一律设为10。剩下的没有提及的二进制位,全部为这个符号的unicode码。这是UTF-8编码的工

- 如何创建Python工程目录

九月恒心

Pythonpython自动测试

如何创建一个简单但是比较规范的python工程目录,本文是学习了LearnPythontheHardWay相关内容后做的一些笔记。安装python第三方包1.pipfromhttp://pypi.python.org/pypi/pip用于安装python第三方包的工具2.distributefromhttp://pypi.python.org/pypi/distribute已被弃用,是SetupT

- notepad++正则表达式

痞子IT

嵌入式开发语言xmlc语言

notepad++正则表达式使用笔记:1.查找空行:^\s*\r\n2.排除以(开头的行:^(?!().*$3.查找第二行以A-D开头的情况:(\r\n)(^[A-D])4.查找不含有helloworld的行:^(?!.*helloworld).*$5.查找不以com结尾的字符串:^.*?(?|"']|"[^"]*"|'[^']*')*?(?:/>|>.*?)11.查找非换行空白:(\s)(?)及

- SystemVerilog LRM 学习笔记 -- clocking块

1clocking...endclocking块clocking块是SV新feature,主要是为了更好解决testbench和DUT之间的timing和同步建模的问题,可以使user基于clockcycle在更高的抽象层次上写testbench(如“##3”,表示三个clock)。clocking只能在module/interface/checker/program中声明,不能在function

- JavaWeb(苍穹外卖)--学习笔记03(登录生成令牌)

老虎0627

JavaWeb(苍穹外卖)学习笔记java

前言本片文章是学习B站黑马程序员苍穹外卖的学习笔记。在Day01(如果学到登录界面这里卡住了,可以看看这篇文章),登陆界面的后端实现大致可以分为两部分登录功能和登录校验,其中登陆校验的实现是基于令牌JWT技术来实现会话追踪(校验部分还有拦截器Interceptor这个我没太学懂视频也没提,以后在更)JWT令牌基本概念JWT是一种在Web应用程序,简单且安全地处理用户身份验证和信息交换的技术,首先我

- Vue3-尚硅谷笔记

八月份的天气

Vue3-笔记笔记

1.Vue3简介2020年9月18日,Vue.js发布版3.0版本,代号:OnePiece(n经历了:4800+次提交、40+个RFC、600+次PR、300+贡献者官方发版地址:Releasev3.0.0OnePiece·vuejs/core截止2023年10月,最新的公开版本为:3.3.41.1.【性能的提升】打包大小减少41%。初次渲染快55%,更新渲染快133%。内存减少54%。1.2.【

- Golang基础笔记十之goroutine和channel

本文首发于公众号:Hunter后端原文链接:Golang基础笔记十之goroutine和channel这一篇介绍Golang里的goroutine和channel通道。以下是本篇笔记目录:goroutinechannelgoroutine与channel的使用1、goroutinegoroutine是一种轻量级线程(用户态线程),由Go运行时管理而非操作系统,它是Go并发模型的核心,能高效处理大量

- 计算机网络(王道考研)笔记个人整理——第六章:应用层

onlyTonight

计算机网络计算机网络考研笔记

第六章:应用层点击上方专栏查看六章全部笔记个人笔记整理位置:个人笔记完整版b站视频:王道考研(2019版)概述应用层对应用程序的通信提供服务。应用层协议定义:应用程序交换的报文类型(请求or响应);各个报文类型的语法,如报文中的各个字段及其详细描述;字段的语义,即包含在字段中的信息的含义;进程何时、如何发送报文,以及对报文进行响应的规则。功能:文件传输、访问和管理;电子邮件;虚拟终端;查询服务和远

- 笔记本电脑外接屏幕/台式电脑屏幕调节亮度方法

小宇蛋

电脑显示器

我之前找了很多办法都不顶用,因为屏幕电源和主机电源不一个,所以无法通过系统调节屏幕亮度。但其实办法很简单很简单,就问卖你屏幕的店家调节亮度的按钮在哪,直接通过屏幕上的按钮调节。

- 如何使用Python控制笔记本电脑屏幕亮度?

很酷的站长

编程笔记电脑python开发语言

Python已成为世界上最受欢迎的编程语言之一,这要归功于它的简单性、多功能性和广泛的应用程序。凭借其广泛的库和框架,Python可用于从Web开发到机器学习以及介于两者之间的任何内容。在Python中,最流行的数据分析和操作库之一是Pandas,它提供了处理表格数据的强大工具。在本教程中,我们将使用Python和屏幕亮度控制库来探索如何控制笔记本电脑屏幕亮度。我们将向您展示如何使用Python通

- huggingface 笔记: Trainer

UQI-LIUWJ

笔记人工智能

Trainer是一个为Transformers中PyTorch模型设计的完整训练与评估循环只需将模型、预处理器、数据集和训练参数传入Trainer,其余交给它处理,即可快速开始训练自动处理以下训练流程:根据batch计算loss使用backward()计算梯度根据梯度更新权重重复上述流程直到达到指定的epoch数1配置TrainingArguments使用TrainingArguments定义训练

- huggingface笔记:文本生成Text generation

UQI-LIUWJ

python库整理笔记深度学习python

1加载LLM模型fromtransformersimportAutoTokenizer,AutoModelForCausalLMimporttorchimportosmodel=AutoModelForCausalLM.from_pretrained("gpt2",device_map="auto",#自动分配到所有可用设备(优先GPU)torch_dtype=torch.bfloat16)2编码

- python transformers库笔记(BertForTokenClassification类)

夏末蝉未鸣01

自然语言处理pythontransformer自然语言处理

BertForTokenClassification类BertForTokenclassification类是HuggingFacetransformers库中专门为基于BERT的序列标注任务(如命名实体识别NER、词性标注POS)设计的模型类。它在BERT的基础上添加了一个线性分类层,用于对每个token进行分类。1、特点任务类型:专为Token-level分类设计,即对输入序列中的每一个tok

- debian-arm64-docker 笔记

文章目录构建debian-arm64docker宿主机系统UBUNT20.04-X86下环境安装下载文件拷贝文件文件释放修改文件qemu-arm-static环境切换环境debian网络配置,分区配置域名解析服务器串口控制台调整打包debianarm64根文件系统debian-arm64宿主机系统安装基础软件基础工具安装docker安装ubuntu20.04-X86上制作arm64-docker镜

- Linux笔记之Docker安装,基于Debian 11(bullseye)

名字太长真的很奇怪꒰⑅•ᴗ•⑅꒱

Linuxlinuxdebiandocker

前置条件Debian平台版本为Debian11(bullseye)安装的是DockerCommunityEdition(docker-ce)安装步骤1.重新安装卸载旧版,初次安装请跳过sudoapt-getremovedockerdocker-enginedocker.iocontainerdrunc2.初次安装时,安装依赖sudoapt-getinstallapt-transport-https

- CentOS6的“ifupdown“与Debian的“ifupdown“有什么不同? 笔记250706

CentOS6的"ifupdown"与Debian的"ifupdown"有什么不同?笔记250706CentOS6与Debian的ifupdown深度对比一、架构与设计差异维度CentOS6Debian核心组件Shell脚本集合二进制程序(C语言)配置存储分散式:/etc/sysconfig/network+/etc/sysconfig/network-scripts/ifcfg-*集中式:/et

- 《算法笔记》学习日记——4.4 贪心

囷囷

《算法笔记》学习日记贪心算法算法c语言数据结构c++

目录4.4贪心问题A:看电视问题B:出租车费问题C:ToFillorNottoFill问题D:RepairtheWall问题E:FatMouse'sTrade问题F:迷瘴问题G:找零钱小结4.4贪心CodeupContestID:100000584问题A:看电视题目描述暑假到了,小明终于可以开心的看电视了。但是小明喜欢的节目太多了,他希望尽量多的看到完整的节目。现在他把他喜欢的电视节目的转播时间表

- crazyswarm无人机集群搭建笔记(一)资料索引

X_SWARM

无人机集群无人机笔记stm32

前言为了开展无人机集群虚实结合任务调度算法测试,这次采购了crazyflie套件,本系列主要记录从零开始搭建crazyswarm集群的详细步骤。本节主要包含crazyflie安装调试主要参考的文章和教程。一、crazyflie安装使用基本资料1.Bitcraze官方网站(1)Bitcraze官方网站主页(2)Bitcraze官网安装教程(3)crazyswarm2官方文档(4)crazyswarm

- 深入理解Spring Bean的生命周期

在Spring框架的学习中,Bean的生命周期是一个核心知识点,它贯穿了从Bean的创建到销毁的全过程。掌握Bean的生命周期,不仅能帮助我们更好地理解Spring容器的工作原理,还能在实际开发中更灵活地控制Bean的行为。本文将基于学习笔记,详细解析Bean生命周期的七个阶段,并补充关键细节和实践要点。一、Bean定义阶段:蓝图的绘制Bean定义阶段就如同建筑前的设计图纸绘制,它决定了Bean的

- 20250708-02-redis通用key操作命令_笔记

一、Redis1.通用键值操作1)键的查看操作keys命令基本功能:查询当前数据库中的所有key,支持精确查询和模糊查询与memcached区别:memcached无法查询所有key,这是Redis特有的功能查询示例:keys*返回所有key(如"age"和"site")keyssite精确查询指定keykeyss*查询以s开头的key通配符三种通配符:*:匹配任意多个字符(如key

- redis学习笔记

1.在docker上安装redis之后,具体可以看我之前的docker教程一.进入docker的redis容器中#进入docker的redis容器中dockerexec-itredis/bin/bash#启动redisredis-cli#设置键setmykeyabc#取出键getmykey#删除键delmykey二,Redis数据类型字符串(string),哈希(hash),列表(list),集合

- Java面向对象三大特性精华实战笔记:static、继承、多态与接口

文章目录Java面向对象三大特性精华实战笔记:static、继承、多态与接口一、static1.静态变量2.静态方法二、工具类1.Javabean类2.测试类3.工具类三、继承四、多态定义表现形式多态的前提多态的好处五、接口接口的定义和使用接口中成员的特点总结Java面向对象三大特性精华实战笔记:static、继承、多态与接口一、static在public后加上static表示老师名字这个属性被所

- 算法学习笔记:10.Prim 算法——从原理到实战,涵盖 LeetCode 与考研 408 例题

呆呆企鹅仔

算法学习算法学习笔记JavaPrim

在图论的世界里,最小生成树(MinimumSpanningTree,MST)是一个至关重要的概念,它在通信网络设计、电路布线、交通规划等领域有着广泛的应用。求解最小生成树的算法中,Prim算法以其独特的“逐步扩展”思想占据着重要地位。Prim算法的基本概念在正式介绍Prim算法之前,我们先回顾一下最小生成树的定义:对于一个具有n个顶点的带权连通图,其最小生成树是包含所有n个顶点的一棵无环子图,且该

- 算法学习笔记:11.冒泡排序——从原理到实战,涵盖 LeetCode 与考研 408 例题

在排序算法的大家族中,冒泡排序是最基础也最经典的算法之一。它的核心思想简单易懂,通过重复地走访待排序序列,一次比较两个相邻的元素,若它们的顺序错误就把它们交换过来,直到没有需要交换的元素为止。虽然冒泡排序的时间复杂度较高,在大规模数据排序中并不常用,但它是理解排序算法思想的绝佳入门案例,也是计算机考研408和算法学习中的基础内容。冒泡排序的基本概念冒泡排序(BubbleSort)之所以被称为“冒泡

- OpenHarmony实战—— 自定义构建函数:@Builder装饰器

我命油我不有天

HarmonyOSOpenHarmony鸿蒙开发harmonyosopenHarmony鸿蒙开发ArkUI物联网装饰器构建函数

往期推文全新看点(文中附带最新·鸿蒙全栈笔记)1️⃣鸿蒙(HarmonyOS)北向开发知识点记录~2️⃣鸿蒙(OpenHarmony)南向开发保姆级知识点汇总~3️⃣鸿蒙应用开发与鸿蒙系统开发哪个更有前景?4️⃣嵌入式开发适不适合做鸿蒙南向开发?看完这篇你就了解了~5️⃣对于大前端开发来说,转鸿蒙开发究竟是福还是祸?6️⃣鸿蒙岗位需求突增!移动端、PC端、IoT到底该怎么选?7️⃣记录一场鸿蒙开发

- Flow 数据流学习-冷流和热流

qq_39844788

学习

文章参考的Kotlin学习笔记(五)——Flow数据流学习实践指北(一)-掘金Kotlin系列之认识一下Flow-掘金冷流(ColdFlow):在数据被使用方订阅后,即调用collect方法之后,提供方才开始执行发送数据流的代码,通常是调用emit方法。即不消费,不生产,多次消费才会多次生产。使用方和提供方是一对一的关系。热流(HotFlow):无论有无使用方,提供方都可以执行发送数据流的操作,提

- C语言核心探秘:深入理解文件指针、stdin、stdout与stderr

web安全工具库

2025C++学习数据库笔记c语言c++学习开发语言

资料合集下载链接:https://pan.quark.cn/s/472bbdfcd014在C语言的编程世界里,输入和输出是程序与外部世界沟通的桥梁。无论是从文件中读取数据,还是将结果显示在屏幕上,我们都离不开I/O(Input/Output)操作。而这一切操作的核心,都围绕着一个重要的概念——文件指针(FilePointer)。今天,就让我们一起根据课堂的精华笔记,揭开文件指针的神秘面纱,并深入了

- React基础笔记---小黑是小白

小黑是小白

reactreact.js学习笔记1024程序员节

react学习前置准备学习网站网址种类React中文React中文文档文档ReactRouterReactRouter6中文文档路由ReactRouterReactRouter路由zustandzustand状态管理TanStackQueryTanStackQuery中文文档请求管理,路由reduxRTK状态管理,请求管理FetchFetch-MDN请求fontawesome图标fontaweso

- MapReduce学习笔记

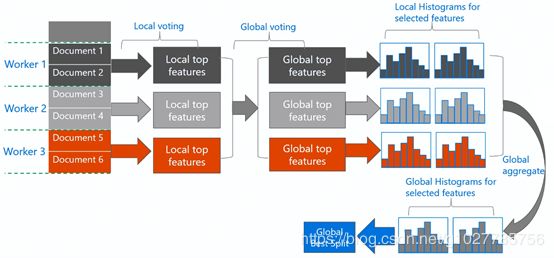

1.MapReduce做什么Mapper负责“分”,即把复杂的任务分解为若干个“简单的任务”来处理。Reducer负责对map阶段的结果进行汇总。2.MapReduce工作机制实体一:客户端,用来提交MapReduce作业。实体二:JobTracker,用来协调作业的运行。实体三:TaskTracker,用来处理作业划分后的任务。实体四:HDFS,用来在其它实体间共享作业文件。3.编写MapRed

- Java实现的简单双向Map,支持重复Value

superlxw1234

java双向map

关键字:Java双向Map、DualHashBidiMap

有个需求,需要根据即时修改Map结构中的Value值,比如,将Map中所有value=V1的记录改成value=V2,key保持不变。

数据量比较大,遍历Map性能太差,这就需要根据Value先找到Key,然后去修改。

即:既要根据Key找Value,又要根据Value

- PL/SQL触发器基础及例子

百合不是茶

oracle数据库触发器PL/SQL编程

触发器的简介;

触发器的定义就是说某个条件成立的时候,触发器里面所定义的语句就会被自动的执行。因此触发器不需要人为的去调用,也不能调用。触发器和过程函数类似 过程函数必须要调用,

一个表中最多只能有12个触发器类型的,触发器和过程函数相似 触发器不需要调用直接执行,

触发时间:指明触发器何时执行,该值可取:

before:表示在数据库动作之前触发

- [时空与探索]穿越时空的一些问题

comsci

问题

我们还没有进行过任何数学形式上的证明,仅仅是一个猜想.....

这个猜想就是; 任何有质量的物体(哪怕只有一微克)都不可能穿越时空,该物体强行穿越时空的时候,物体的质量会与时空粒子产生反应,物体会变成暗物质,也就是说,任何物体穿越时空会变成暗物质..(暗物质就我的理

- easy ui datagrid上移下移一行

商人shang

js上移下移easyuidatagrid

/**

* 向上移动一行

*

* @param dg

* @param row

*/

function moveupRow(dg, row) {

var datagrid = $(dg);

var index = datagrid.datagrid("getRowIndex", row);

if (isFirstRow(dg, row)) {

- Java反射

oloz

反射

本人菜鸟,今天恰好有时间,写写博客,总结复习一下java反射方面的知识,欢迎大家探讨交流学习指教

首先看看java中的Class

package demo;

public class ClassTest {

/*先了解java中的Class*/

public static void main(String[] args) {

//任何一个类都

- springMVC 使用JSR-303 Validation验证

杨白白

springmvc

JSR-303是一个数据验证的规范,但是spring并没有对其进行实现,Hibernate Validator是实现了这一规范的,通过此这个实现来讲SpringMVC对JSR-303的支持。

JSR-303的校验是基于注解的,首先要把这些注解标记在需要验证的实体类的属性上或是其对应的get方法上。

登录需要验证类

public class Login {

@NotEmpty

- log4j

香水浓

log4j

log4j.rootCategory=DEBUG, STDOUT, DAILYFILE, HTML, DATABASE

#log4j.rootCategory=DEBUG, STDOUT, DAILYFILE, ROLLINGFILE, HTML

#console

log4j.appender.STDOUT=org.apache.log4j.ConsoleAppender

log4

- 使用ajax和history.pushState无刷新改变页面URL

agevs

jquery框架Ajaxhtml5chrome

表现

如果你使用chrome或者firefox等浏览器访问本博客、github.com、plus.google.com等网站时,细心的你会发现页面之间的点击是通过ajax异步请求的,同时页面的URL发生了了改变。并且能够很好的支持浏览器前进和后退。

是什么有这么强大的功能呢?

HTML5里引用了新的API,history.pushState和history.replaceState,就是通过

- centos中文乱码

AILIKES

centosOSssh

一、CentOS系统访问 g.cn ,发现中文乱码。

于是用以前的方式:yum -y install fonts-chinese

CentOS系统安装后,还是不能显示中文字体。我使用 gedit 编辑源码,其中文注释也为乱码。

后来,终于找到以下方法可以解决,需要两个中文支持的包:

fonts-chinese-3.02-12.

- 触发器

baalwolf

触发器

触发器(trigger):监视某种情况,并触发某种操作。

触发器创建语法四要素:1.监视地点(table) 2.监视事件(insert/update/delete) 3.触发时间(after/before) 4.触发事件(insert/update/delete)

语法:

create trigger triggerName

after/before

- JS正则表达式的i m g

bijian1013

JavaScript正则表达式

g:表示全局(global)模式,即模式将被应用于所有字符串,而非在发现第一个匹配项时立即停止。 i:表示不区分大小写(case-insensitive)模式,即在确定匹配项时忽略模式与字符串的大小写。 m:表示

- HTML5模式和Hashbang模式

bijian1013

JavaScriptAngularJSHashbang模式HTML5模式

我们可以用$locationProvider来配置$location服务(可以采用注入的方式,就像AngularJS中其他所有东西一样)。这里provider的两个参数很有意思,介绍如下。

html5Mode

一个布尔值,标识$location服务是否运行在HTML5模式下。

ha

- [Maven学习笔记六]Maven生命周期

bit1129

maven

从mvn test的输出开始说起

当我们在user-core中执行mvn test时,执行的输出如下:

/software/devsoftware/jdk1.7.0_55/bin/java -Dmaven.home=/software/devsoftware/apache-maven-3.2.1 -Dclassworlds.conf=/software/devs

- 【Hadoop七】基于Yarn的Hadoop Map Reduce容错

bit1129

hadoop

运行于Yarn的Map Reduce作业,可能发生失败的点包括

Task Failure

Application Master Failure

Node Manager Failure

Resource Manager Failure

1. Task Failure

任务执行过程中产生的异常和JVM的意外终止会汇报给Application Master。僵死的任务也会被A

- 记一次数据推送的异常解决端口解决

ronin47

记一次数据推送的异常解决

需求:从db获取数据然后推送到B

程序开发完成,上jboss,刚开始报了很多错,逐一解决,可最后显示连接不到数据库。机房的同事说可以ping 通。

自已画了个图,逐一排除,把linux 防火墙 和 setenforce 设置最低。

service iptables stop

- 巧用视错觉-UI更有趣

brotherlamp

UIui视频ui教程ui自学ui资料

我们每个人在生活中都曾感受过视错觉(optical illusion)的魅力。

视错觉现象是双眼跟我们开的一个玩笑,而我们往往还心甘情愿地接受我们看到的假象。其实不止如此,视觉错现象的背后还有一个重要的科学原理——格式塔原理。

格式塔原理解释了人们如何以视觉方式感觉物体,以及图像的结构,视角,大小等要素是如何影响我们的视觉的。

在下面这篇文章中,我们首先会简单介绍一下格式塔原理中的基本概念,

- 线段树-poj1177-N个矩形求边长(离散化+扫描线)

bylijinnan

数据结构算法线段树

package com.ljn.base;

import java.util.Arrays;

import java.util.Comparator;

import java.util.Set;

import java.util.TreeSet;

/**

* POJ 1177 (线段树+离散化+扫描线),题目链接为http://poj.org/problem?id=1177

- HTTP协议详解

chicony

http协议

引言

- Scala设计模式

chenchao051

设计模式scala

Scala设计模式

我的话: 在国外网站上看到一篇文章,里面详细描述了很多设计模式,并且用Java及Scala两种语言描述,清晰的让我们看到各种常规的设计模式,在Scala中是如何在语言特性层面直接支持的。基于文章很nice,我利用今天的空闲时间将其翻译,希望大家能一起学习,讨论。翻译

- 安装mysql

daizj

mysql安装

安装mysql

(1)删除linux上已经安装的mysql相关库信息。rpm -e xxxxxxx --nodeps (强制删除)

执行命令rpm -qa |grep mysql 检查是否删除干净

(2)执行命令 rpm -i MySQL-server-5.5.31-2.el

- HTTP状态码大全

dcj3sjt126com

http状态码

完整的 HTTP 1.1规范说明书来自于RFC 2616,你可以在http://www.talentdigger.cn/home/link.php?url=d3d3LnJmYy1lZGl0b3Iub3JnLw%3D%3D在线查阅。HTTP 1.1的状态码被标记为新特性,因为许多浏览器只支持 HTTP 1.0。你应只把状态码发送给支持 HTTP 1.1的客户端,支持协议版本可以通过调用request

- asihttprequest上传图片

dcj3sjt126com

ASIHTTPRequest

NSURL *url =@"yourURL";

ASIFormDataRequest*currentRequest =[ASIFormDataRequest requestWithURL:url];

[currentRequest setPostFormat:ASIMultipartFormDataPostFormat];[currentRequest se

- C语言中,关键字static的作用

e200702084

C++cC#

在C语言中,关键字static有三个明显的作用:

1)在函数体,局部的static变量。生存期为程序的整个生命周期,(它存活多长时间);作用域却在函数体内(它在什么地方能被访问(空间))。

一个被声明为静态的变量在这一函数被调用过程中维持其值不变。因为它分配在静态存储区,函数调用结束后并不释放单元,但是在其它的作用域的无法访问。当再次调用这个函数时,这个局部的静态变量还存活,而且用在它的访

- win7/8使用curl

geeksun

win7

1. WIN7/8下要使用curl,需要下载curl-7.20.0-win64-ssl-sspi.zip和Win64OpenSSL_Light-1_0_2d.exe。 下载地址:

http://curl.haxx.se/download.html 请选择不带SSL的版本,否则还需要安装SSL的支持包 2. 可以给Windows增加c

- Creating a Shared Repository; Users Sharing The Repository

hongtoushizi

git

转载自:

http://www.gitguys.com/topics/creating-a-shared-repository-users-sharing-the-repository/ Commands discussed in this section:

git init –bare

git clone

git remote

git pull

git p

- Java实现字符串反转的8种或9种方法

Josh_Persistence

异或反转递归反转二分交换反转java字符串反转栈反转

注:对于第7种使用异或的方式来实现字符串的反转,如果不太看得明白的,可以参照另一篇博客:

http://josh-persistence.iteye.com/blog/2205768

/**

*

*/

package com.wsheng.aggregator.algorithm.string;

import java.util.Stack;

/**

- 代码实现任意容量倒水问题

home198979

PHP算法倒水

形象化设计模式实战 HELLO!架构 redis命令源码解析

倒水问题:有两个杯子,一个A升,一个B升,水有无限多,现要求利用这两杯子装C

- Druid datasource

zhb8015

druid

推荐大家使用数据库连接池 DruidDataSource. http://code.alibabatech.com/wiki/display/Druid/DruidDataSource DruidDataSource经过阿里巴巴数百个应用一年多生产环境运行验证,稳定可靠。 它最重要的特点是:监控、扩展和性能。 下载和Maven配置看这里: http

- 两种启动监听器ApplicationListener和ServletContextListener

spjich

javaspring框架

引言:有时候需要在项目初始化的时候进行一系列工作,比如初始化一个线程池,初始化配置文件,初始化缓存等等,这时候就需要用到启动监听器,下面分别介绍一下两种常用的项目启动监听器

ServletContextListener

特点: 依赖于sevlet容器,需要配置web.xml

使用方法:

public class StartListener implements

- JavaScript Rounding Methods of the Math object

何不笑

JavaScriptMath

The next group of methods has to do with rounding decimal values into integers. Three methods — Math.ceil(), Math.floor(), and Math.round() — handle rounding in differen