IJCAI2019|基于对抗变分自编码的协同过滤框架VAEGAN

VAEGAN: A Collaborative Filtering Framework based on Adversarial Variational Autoencoders

Xianwen Yu, Xiaoning Zhang, Yang Cao, Min Xia

Peking University, SenseTime

IJCAI 2019

https://www.ijcai.org/proceedings/2019/0584.pdf

变分自编码在协同过滤中可以用于隐式反馈。然而,模型的效果主要依赖于推理模型的表达能力,并且隐含表示通常受限于表达能力而不能捕获真实的后验分布。

这篇文章提出一种新的框架,VAEGAN,该框架能够解决上述问题。在VAEGAN中,可以利用对抗变分贝叶斯(AVB)来训练变分自编码,其中推理模型可以具有任意的表达能力。利用GANs来获取隐式变分推理,推理模型能够更好地近似后验分布和极大似然。而且通过引入辅助判别网络利用对抗训练可以在推荐系统中得到高准确率。

另外,将压缩损失加入到传统的重构误差函数中,作为一种惩罚项,可以得到鲁棒特征,提升模型的泛化性能。

在多个真实数据集上的实验表明,本文提出的VAEGAN显著优于SOTA基准模型。

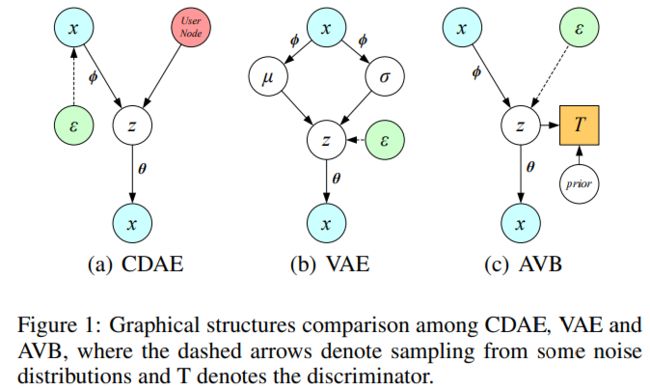

CDAE(Collaborative Denoising Autoencoders), VAE( Variational Autoencoders), AVB(Adversarial Variational Bayes)结构对比如下

本文所提模型结构图示如下

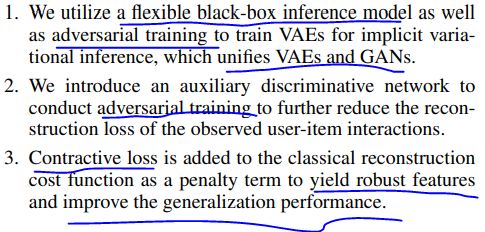

本文的主要贡献如下

问题描述及符号表示如下

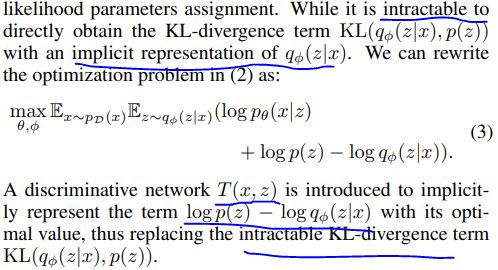

AVE基础及表示如下

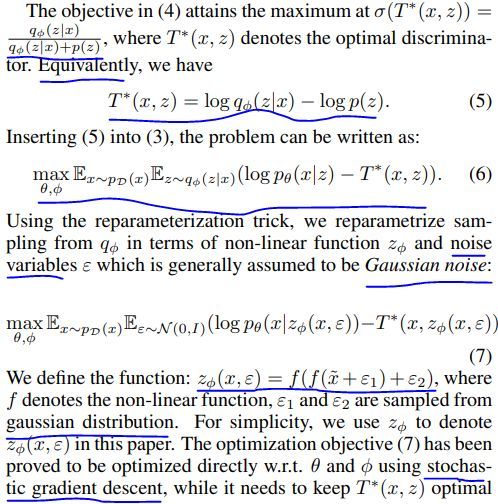

进一步的,VAE可以利用重参数化技巧和随机梯度下降进行优化。

KL散度可以利用两个概率的对数之差来表示

更近一步的,可以借助sigmoid函数来表示

更近一步,可以推导出

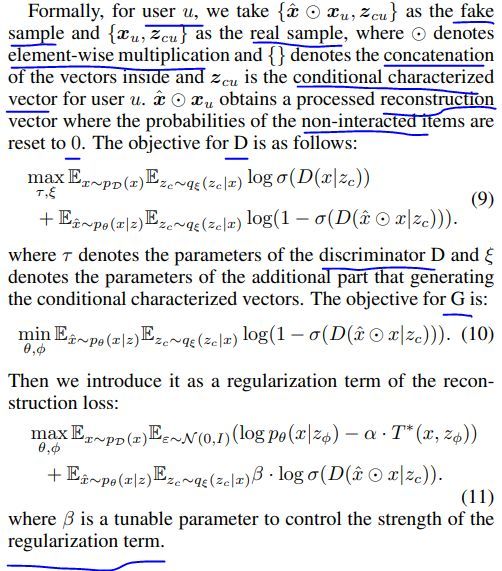

关于重构误差和约束项的推导如下

另外,还加入了压缩损失

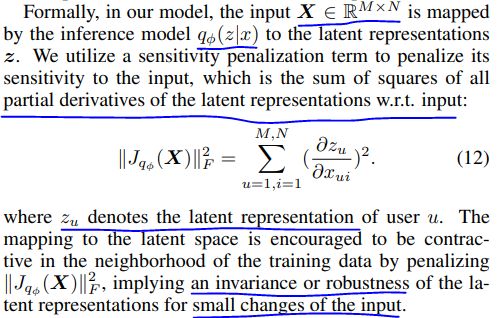

数学表示如下

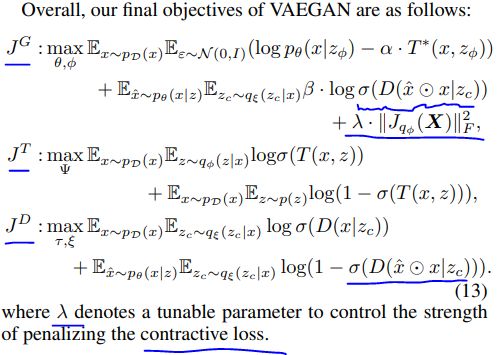

VAEGAN的最终表示如下

数据集分割及取舍详情如下

几种对比的基准方法如下

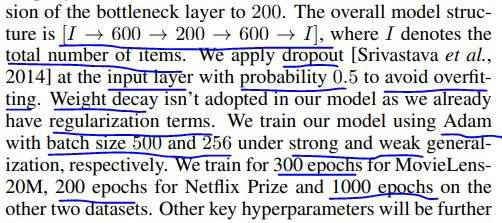

一些参数设置如下

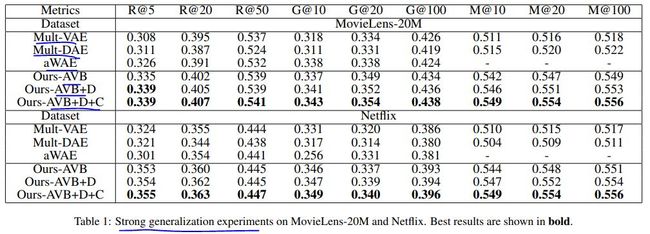

几种方法在两个数据集上的效果(强泛化实验)对比如下

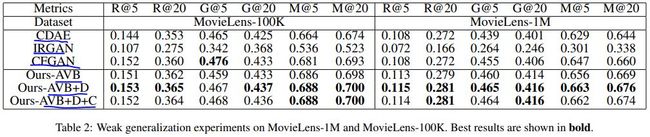

几种方法在两个数据集上的效果(弱泛化实验)对比如下

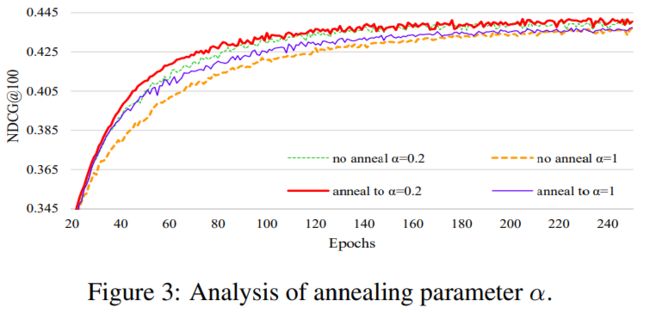

退火参数α对模型的效果影响图示如下,该参数是为了防止KL消失或者后验坍塌。

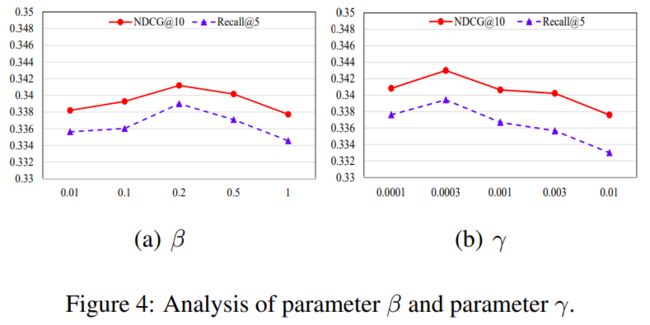

正则系数β和压缩正则系数γ(用于压缩损失之上)对模型的效果影响图示如下

CDAE对应的论文为

Collaborative denoising autoencoders for top-n recommender systems. WSDM 2016

代码地址

https://github.com/jasonyaw/CDAE

https://github.com/henry0312/CDAE

IRGAN对应的论文为

Irgan: A minimax game for unifying generative and discriminative information retrieval models,SIGIR 2017

代码地址

https://github.com/geek-ai/irgan

CFGAN对应的论文为

Cfgan: A generic collaborative filtering framework based on generative adversarial networks,CIKM 2018

代码地址

https://github.com/wubinzzu/NeuRec

Multi-VAE Multi-DAE对应的论文为

Variational autoencoders for collaborative filtering, WWW 2018

代码地址

https://github.com/dawenl/vae_cf

aWAE对应的论文为

Wasserstein autoencoders for collaborative filtering,2018

您可能感兴趣