spring-cloud-sleuth+zipkin追踪服务实现(一)

1.简述

最近在学习spring cloud构建微服务,研究追踪微服务rest服务调用链路的问题,接触到zipkin,而spring cloud也提供了spring-cloud-sleuth来方便集成zipkin实现。

我们准备了三个必要的程序来做测试,分别是

1、microservice-zipkin-server

负责数据收集以及信息展示功能。

2、microservice-zipkin-client-backend

负责微服务的生产者,对外提供 “http://127.0.0.1:11010/call/1” 的地址来完成一个简单的功能rest请求。

3、microservice-zipkin-client

负责微服务的调用,对外提供 "http://localhost:11009/call/1" 的rest地址,当访问此地址时,使用feign方式调用provider的rest服务地址。得到计算结果后,显示在界面上。

2.准备工作

三个程序功能非常简单,接下来我们看看每个程序的具体代码和配置。为了方便我们对三个模块开发,我们在父POM文件中添加了spring-boot和spring-cloud的依赖,避免子模块中需要写版本号

<parent>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-parentartifactId>

<version>1.5.2.RELEASEversion>

parent>

<dependencyManagement>

<dependencies>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-dependenciesartifactId>

<version>Dalston.RELEASEversion>

<type>pomtype>

<scope>importscope>

dependency>

dependencies>

dependencyManagement>接下来我们看看三个程序中的相关配置

3.具体实现

3.1 microservice-zipkin-server

首先,我们添加maven依赖配置

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starterartifactId>

dependency>

<dependency>

<groupId>io.zipkin.javagroupId>

<artifactId>zipkin-serverartifactId>

dependency>

<dependency>

<groupId>io.zipkin.javagroupId>

<artifactId>zipkin-autoconfigure-uiartifactId>

<scope>runtimescope>

dependency>

<dependency>

<groupId>org.springframework.bootgroupId>

<artifactId>spring-boot-starter-testartifactId>

<scope>testscope>

dependency>在这里为了测试方便,我们可以将数据保存到内存中,但是生产环境还是需要将数据持久化中。原生支持了很多产品,例如ES、数据库等,本例中我们采用将数据保存到内存中的方式来演示。

我们写一个启动类ZipkinServer,代码非常简单,如下

package com.yangyang.cloud;

import org.springframework.boot.SpringApplication;

import org.springframework.boot.autoconfigure.SpringBootApplication;

import zipkin.server.EnableZipkinServer;

/**

* Created by chenshunyang on 2017/5/24.

*/

@EnableZipkinServer

@SpringBootApplication

public class ZipkinServerApplication {

public static void main(String[] args) {

SpringApplication.run(ZipkinServerApplication.class,args);

}

}接下来我们配置application.ym配置文件

server:

port: 11008

spring:

application:

name : microservice-zipkin-server

启动后 无异常输出,这样我们的server程序就OK了

3.2 microservice-zipkin-client-backend 与microservice-zipkin-client

这两个程序,与其他基础代码我们就不多讲了(相信学些到这一步的童鞋,都已经对spring cloud创建微服务以上手了),两个程序在spring-cloud-sleuth相关的配置都是一样。

首先,我们要在二者的POM文件中添加依赖,引入zipkin客户端自动配置相关依赖

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-sleuth-zipkinartifactId>

dependency>

<dependency>

<groupId>org.springframework.cloudgroupId>

<artifactId>spring-cloud-starter-sleuthartifactId>

dependency>其次,在配置文件application中,我们加入zipkin server收集信息的地址

spring:

application:

name: microservice-zipkin-client-backend

zipkin:

base-url: http://localhost:11008这样我们的两个微服务就配置好了(注意这里我们并不会再说明如何写rest接口和使用feign调用rest接口),具体参考代码

4 测试

先后启动我们的三个程序

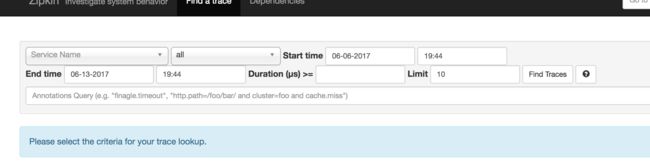

先启动microservice-zipkin-server 然后访问在浏览器中访问UI界面地址http://127.0.0.1:11008,

其中Span Name选项为灰色不可选,说明目前没有数据,我们查看数据库也可以看到没有任何数据信息。

接下来我们访问consumer提供的访问地址 http://localhost:11009/call/1

刷新几次之后,我们再次刷新我们的zipkin界面,可以看到Span Name已经可以选择了。

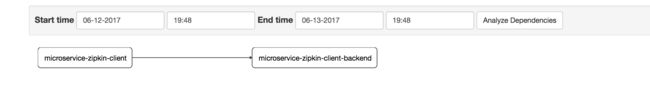

点击Find Traces按钮,我们可以看到调用的链路和耗时情况,点击Dependencies,我们可以看到provider和consumer的调用图

OK,我们的简单实用spring-cloud-sleuth+zipkin的例子就完成了。

5.拓展

在测试的过程中我们会发现,有时候,程序刚刚启动后,刷新几次,并不能看到任何数据,原因就是我们的spring-cloud-sleuth收集信息是有一定的比率的,默认的采样率是0.1,配置此值的方式在配置文件中增加spring.sleuth.sampler.percentage参数配置(如果不配置默认0.1),如果我们调大此值为1,可以看到信息收集就更及时。但是当这样调整后,我们会发现我们的rest接口调用速度比0.1的情况下慢了很多,即时在0.1的采样率下,我们多次刷新consumer的接口,会发现对同一个请求两次耗时信息相差非常大,如果取消spring-cloud-sleuth后我们再测试,会发现并没有这种情况,可以看到这种方式追踪服务调用链路会给我们业务程序性能带来一定的影响。

其实,我们仔细想想也可以总结出这种方式的几种缺陷

缺陷1:zipkin客户端向zipkin-server程序发送数据使用的是http的方式通信,每次发送的时候涉及到连接和发送过程。

缺陷2:当我们的zipkin-server程序关闭或者重启过程中,因为客户端收集信息的发送采用http的方式会被丢失。

针对以上两个明显的缺陷,改进的办法是

1、通信采用socket或者其他效率更高的通信方式。

2、客户端数据的发送尽量减少业务线程的时间消耗,采用异步等方式发送收集信息。

3、客户端与zipkin-server之间增加缓存类的中间件,例如redis、MQ等,在zipkin-server程序挂掉或重启过程中,客户端依旧可以正常的发送自己收集的信息。

相信采用以上三种方式会很大的提高我们的效率和可靠性。其实spring-cloud以及为我们提供采用MQ或redis等其他的采用socket方式通信,利用消息中间件或数据库缓存的实现方式。下一次我们再来测试spring-cloud-sleuth-zipkin-stream方式的实现。

6.项目源码:

https://git.oschina.net/shunyang/spring-cloud-microservice-study.git

https://github.com/shunyang/spring-cloud-microservice-study.git

7.参考文档:

spring cloud 官方文档:https://github.com/spring-cloud/spring-cloud-sleuth

第三方:https://yq.aliyun.com/articles/78128?utm_campaign=wenzhang&utm_medium=article&utm_source=QQ-qun&201758&utm_content=m_19862