Docker下的Kafka学习之二:搭建集群环境

Docker软件版本

本次实战的电脑操作系统是Win10专业版,安装的Docker版本信息如下:

ssh工具

为了登录容器方便,建议使用SecureCRT;

环境规划

本次实战要搭建六个容器,使用同一个镜像,容器们的功能如下:

1. kafka集群:三个broker,分别是borker1、broker2、broker3;

2. 消息生产者:一个;

3. 消息消费者:两个;

| 容器名 | ip | 功能 |

|---|---|---|

| borker1 | 172.18.0.2 | kafka集群之一 |

| borker2 | 172.18.0.3 | kafka集群之二 |

| borker3 | 172.18.0.4 | kafka集群之三 |

| producer | 172.18.0.5 | 消息生产者 |

| consumer1 | 172.18.0.5 | 消息消费者之一 |

| consumer2 | 172.18.0.5 | 消息消费者之二 |

docker-compose.yml文件

使用docker-compose可以使多个容器的管理更简单方便,按照上面所划分功能配置出的docker-compose.yml文件内容如下:

version: '2'

services:

broker1:

image: bolingcavalry/ssh-kafka292081-zk346:0.0.1

container_name: broker1

ports:

- "19011:22"

restart: always

broker2:

image: bolingcavalry/ssh-kafka292081-zk346:0.0.1

container_name: broker2

depends_on:

- broker1

ports:

- "19012:22"

restart: always

broker3:

image: bolingcavalry/ssh-kafka292081-zk346:0.0.1

container_name: broker3

depends_on:

- broker2

ports:

- "19013:22"

restart: always

producer:

image: bolingcavalry/ssh-kafka292081-zk346:0.0.1

container_name: producer

links:

- broker1:hostb1

- broker2:hostb2

- broker3:hostb3

ports:

- "19014:22"

restart: always

consumer1:

image: bolingcavalry/ssh-kafka292081-zk346:0.0.1

container_name: consumer1

depends_on:

- producer

links:

- broker1:hostb1

- broker2:hostb2

- broker3:hostb3

ports:

- "19015:22"

restart: always

consumer2:

image: bolingcavalry/ssh-kafka292081-zk346:0.0.1

container_name: consumer2

depends_on:

- consumer1

ports:

- "19016:22"

links:

- broker1:hostb1

- broker2:hostb2

- broker3:hostb3

restart: always - 1

- 2

- 3

- 4

- 5

- 6

- 7

- 8

- 9

- 10

- 11

- 12

- 13

- 14

- 15

- 16

- 17

- 18

- 19

- 20

- 21

- 22

- 23

- 24

- 25

- 26

- 27

- 28

- 29

- 30

- 31

- 32

- 33

- 34

- 35

- 36

- 37

- 38

- 39

- 40

- 41

- 42

- 43

- 44

- 45

- 46

- 47

- 48

- 49

- 50

- 51

- 52

- 53

- 54

- 55

- 56

- 57

- 58

如上所示,所有容器的22端口都映射到当前电脑的不同端口,方便使用ssh工具登录,另外消息生产者和消费者都配置了link参数,避免在连接kafka集群的时候直接输入ip;

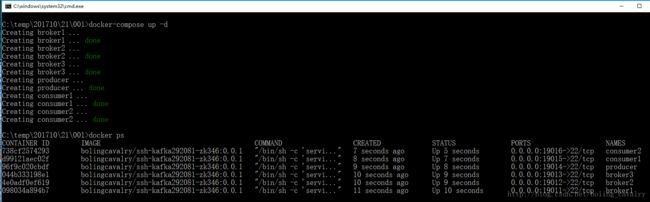

启动所有容器

在docker-compose.yml所在文件夹下执行以下命令:

docker-compose up -d- 1

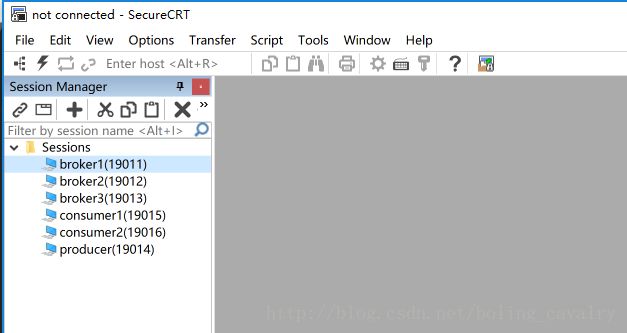

管理每台机器的登录和连接

由于每个容器都支持ssh登录,所以我们可以用SecureCRT来管理登录,创建六个ssh连接,host都是127.0.0.1,端口依次是19011到19016,如下图:

这样后面我们的连接登录操作就方便了很多。

配置hosts

分别登录broker1、broker2、broker3,用ip addr查看他们的IP分别是:172.18.0.2、172.18.0.3、172.18.0.4,于是将这三个容器的/etc/hosts文件都添加以下三行:

broker1 172.18.0.2

broker2 172.18.0.3

broker3 172.18.0.4- 1

- 2

- 3

配置zookeeper

- 分别登录broker1、broker2、broker3,打开它们的/usr/local/work/zookeeper-3.4.6/conf/zoo.cfg文件,在最下面添加以下内容:

server.1=broker1:2887:3887

server.2=broker2:2888:3888

server.3=broker3:2889:3889- 1

- 2

- 3

这样就指定了zookeeper集群的机器;

2. 配置每个zookeeper的身份:

在broker1执行以下命令:

echo 1 > /usr/local/work/zkdata/myid- 1

在broker2执行以下命令:

echo 2 > /usr/local/work/zkdata/myid- 1

在broker3执行以下命令:

echo 3 > /usr/local/work/zkdata/myid- 1

启动zookeeper

在broker1、broker2、broker3上依次执行以下命令将所有zookeeper启动:

/usr/local/work/zookeeper-3.4.6/bin/zkServer.sh start- 1

启动后,可以用以下命令查看当前机器的zookeeper状态:

/usr/local/work/zookeeper-3.4.6/bin/zkServer.sh status- 1

至此,zookeeper集群启动成功;

配置kafka

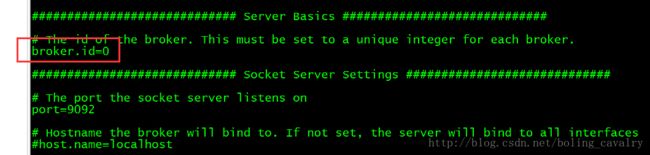

在broker1上,打开文件/usr/local/work/kafka_2.9.2-0.8.1/config/server.properties,修改以下两处:

1. 找到下图红框位置:

将原来的broker.id=0改为broker.id=1,这里的”1”是和myid文件的内容一致;

对broker2、broker3也做相同的操作,broker.id分别是2和3;

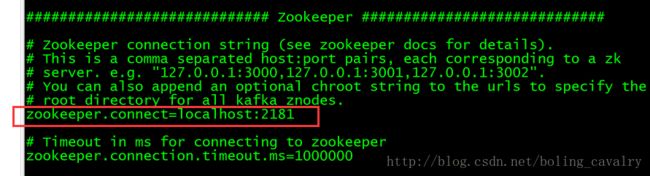

2. 找到下图红框位置:

将上图红框中的内容改成以下内容:

zookeeper.connect=broker1:2181,broker2:2181,broker3:2181- 1

对broker2、broker3、producer也做相同的操作;

启动kafka集群

在broker1、broker2、broker3上面依次执行以下命令,即可启动kafka集群:

nohup /usr/local/work/kafka_2.9.2-0.8.1/bin/kafka-server-start.sh /usr/local/work/kafka_2.9.2-0.8.1/config/server.properties >/usr/local/work/log/kafka.log 2>1 &- 1

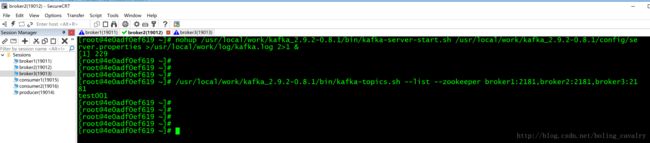

验证消息服务

- 在broker1上执行以下命令,在broker1上创建一个topic:

/usr/local/work/kafka_2.9.2-0.8.1/bin/kafka-topics.sh --create --zookeeper broker1:2181,broker2:2181,broker3:2181 --replication-factor 1 --partitions 3 --topic test001- 1

以上命令创建了一个名为”test001”的主题,有三个partition;

2. 在broker2上执行以下命令,查看当前topic列表:

/usr/local/work/kafka_2.9.2-0.8.1/bin/kafka-topics.sh --list --zookeeper broker1:2181,broker2:2181,broker3:2181- 1

可以看到topic列表如下:

如上图,刚刚在broker1上创建的主题test001可以看到;

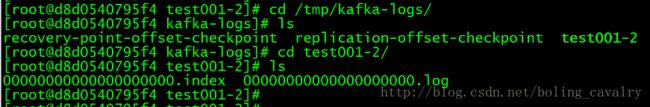

3. 在broker1的/tmp/kafka-logs/目录下,可以看到新建的topic的partition文件夹,如下图:

如上图,有个test001-2的目录,表明这是存放2号partition内容的地方,进入该文件夹,可以看到index和log文件;

登录broker2和broker3可以分别看到test001-0和test001-1文件夹;

4. 登录producer容器,执行以下命令,进入发送消息的模式:

/usr/local/work/kafka_2.9.2-0.8.1/bin/kafka-console-producer.sh --broker-list broker1:9092,broker2:9092,broker3:9092 --topic test001- 1

如下图所示:

此时已经准备完毕,我们可以准备消息消费者了;

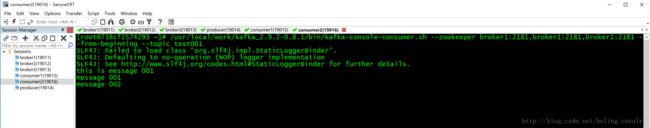

5. 依次登录consumer1、consumer2,都执行以下命令,即可进入接受消息的模式:

/usr/local/work/kafka_2.9.2-0.8.1/bin/kafka-console-consumer.sh --zookeeper broker1:2181,broker1:2181,broker1:2181 --from-beginning --topic test001- 1

现在可以发送消息了;

6. 在producer容器上,现在是发送消息的模式,依次输入以下三个字符串,每输入一个就敲回车,这样相当于发送了三条消息,然后再去consumer1和consumer2上看一下,发现效果如下:

如上图,consumer1和consumer2一样,都是消息全部收到;

至此,Kafka集群环境的搭建和验证就完成了,后续章节我们通过java来完成集群环境下kafka消息的发送和接受;