图像质量评价:从single到pair ranking

近五年来,由于训练模型的相应数据量限制,图像质量评价从单一图像质量评价方法逐渐变成成对或多幅图像比较的图像质量评价。以下是相关论文的总结:

难点:

(1)pair的有效生成

(2)pair或list中的rank比较

(3)分类器的选用(传统或Deep)

(4)rank值与quality score的转换

1、Learning to Rank for Blind Image Quality Assessment. TNNLS 2015

Authors:Fei Gao, Dacheng Tao, Xinbo Gao, Xuelong Li. 西安电子科技大学

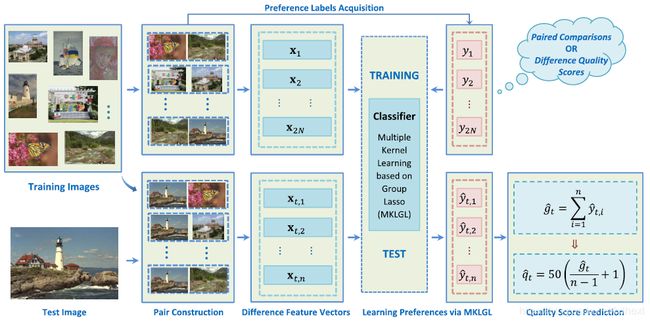

框架图:生成pair和相应label->提取NSS features->MKLGL分类器训练->分数预测。(传统分类器)

(1)Preference Image Pairs(PIPs)生成:

通常Pair生成方法:n images生成若干pair,进行主观实验,记录比较次数和比较结果处理作为pair对应的label。

本文Pair生成方法:根据image的MOS或DMOS进行pair间分数的差值计算,设置阈值获得pair的label。

Label为1表示pair中第一张图的质量比第二张好,反之为-1。

(2)NSS特征提取:

借用方法BLIINDS-II [1]、BRISQUE-L [2]和SRNSS [3]提取特征,获得特征向量,进行pair间的特征向量相减得到最终的difference feature vectors(共84维)。

(3)MKLGL分类器训练:

multiple kernel learning(MKL),包含45个核(eight portions of features ×5 bandwidths Gaussian

kernels +5 bandwidths Gaussian kernels)。

值得注意:分类器输出为值的维度为pair训练集的大小,即2N。

(4)分数预测:

根据预测的2N个y值计算g,g再进行线性映射得到最终的预测质量分数,线性映射中的参数a和b的取值计算由相应的假设获得。

关键点:生成pair的阈值T和预测值线性映射中参数a和b的选取。

[1] M. A. Saad, A. C. Bovik, and C. Charrier, “Blind image quality assessment: A natural scene statistics approach in the DCT domain,” IEEE Trans. Image Process., vol. 21, no. 8, pp. 3339–3352, Aug. 2012.

[2] A. Mittal, A. K. Moorthy, and A. C. Bovik, “Making image quality assessment robust,” in Proc. IEEE Conf. Rec. 46th Asilomar

Conf. Signals, Syst., Comput. (ASILOMAR), Nov. 2012, pp. 1718–1722.

[3] L. He, D. Tao, X. Li, and X. Gao, “Sparse representation for blind image quality assessment,” in Proc. IEEE Conf. Comput. Vis. Pattern Recognit. (CVPR), Jun. 2012, pp. 1146–1153.

2、Pairwise Comparison and Rank Learning for Image Quality Assessment. Displays 2016

Authors:Long Xu, Jia Li, Weisi Lin, Yun Zhang, Yongbing Zhang, Yihua Yan. 中科院

(L. Xu, W.S. Lin, J. Li, Y.M. Fang, Y.H. Yan, Rank learning on training set selection and quality assessment, in: Proc. IEEE International Conference on Multimedia and Expo (ICME), 2014, pp. 1–6.会议论文的extend)

(与L. Xu, J. Li, W. Lin, Y. Zhang, L. Ma, Y. Fang, Y. Yan, Multi-task rank learning for image quality assessment, IEEE Trans. Circ. Syst. Video Technol. 2017为姊妹篇。)

方法:Pairwise Rank Learning based Image Quality Metric(PRLIQM)(传统分类器)

算法过程:pair生成方法类上篇论文,同时利用NSS model提取feature vector,再分类器training(论文中对分类器的优化过程描述不错,即公式(1,2,3,4)),最终将quality rank mapping to quality score。

值得注意:训练模型的输出的是包含所有图像的rank list,而不仅是任意两张图像质量比较的二值标签。

Accumulative Image Quality Difference(AIQD):第i张图片和剩余所有图片比较的相对质量,the times of failures of model prediction.

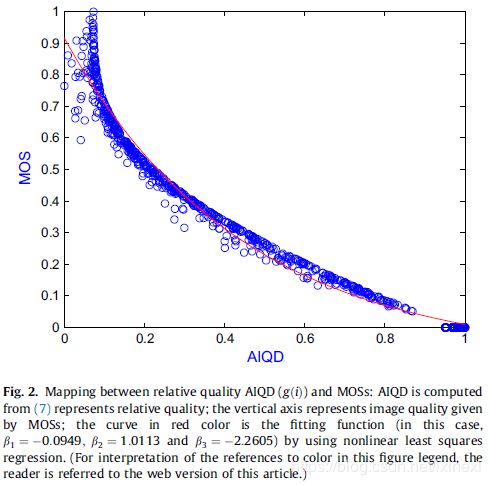

相应的MOS和AIQD的关系如下图:其中fitting curve的函数为:![]() ,参数beta自行设定。

,参数beta自行设定。

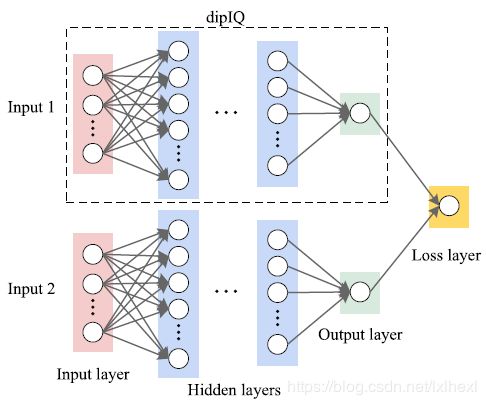

3、dipIQ: Blind Image Quality Assessment by Learning-to-Rank Discriminable Image Pairs. TIP 2017

Authors:Kede Ma, Wentao Liu, Tongliang Liu, Zhou Wang, Dacheng Tao. Waterloo

框架图:DIPs生成,模型训练,质量预测。(Deep)

(1)Quality-discriminable Image Pairs(DIPs)生成:

选择840张高质量图像(从Waterloo Exploration数据中选择),加入四种类型和五个水平的失真,生成17640张图像,利用DIPs生成机制生成pair,得到training set。

关键点:阈值的选择。

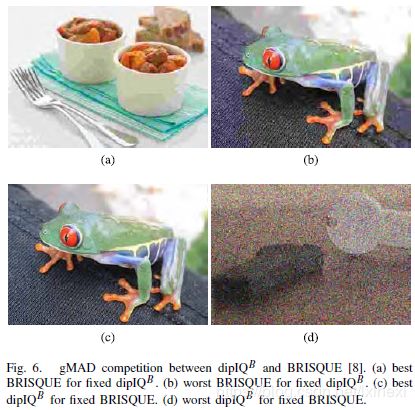

DIP生成机制:三个全参IQA方法分别计算所有失真图像的分数,根据LIVE数据库的分数mapping到0-100,计算mapping后pair中两张图的三种分数的差值的最小值,根据阈值判断是否为合格的DIP,同时根据差值最小值,可计算pair的uncertainty水平。例图如下:

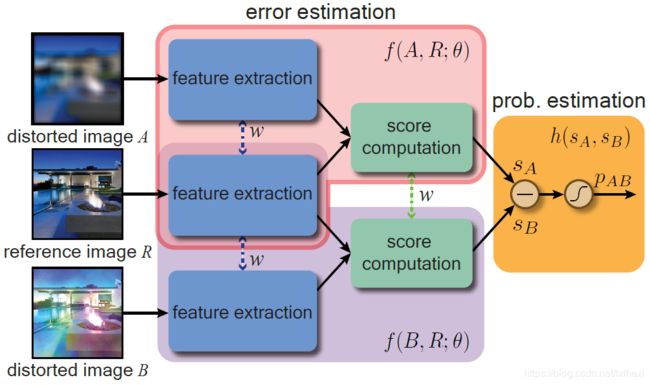

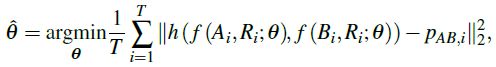

(2)RankNet训练:two stream的weight是shared

Cornia方法提取图像特征,网络输出结合概率模型设计,cross entropy loss计算。

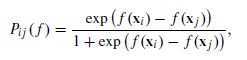

关键点:two stream的网络输出的结合概率模型设计。公式入下:

(3)质量分数预测:

选择训练好的网络模型对测试图像进行质量分数预测。

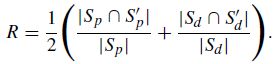

(4)3个新评价指标:

Pristine/distorted image discriminability test (D-test):模型正确区分原始图像和失真图像的能力测试

Listwise ranking consistency test (L-test):模型正确区分相同内容、相同失真不同水平图像的能力测试

Pairwise preference consistency test (P-test):模型正确区分DIPs的能力测试

(5)gMAD方法比较:如下图

(6)拓展:

将pairwise方法做成listwise方法。

与pairwise的概率模型不同,listwise采用list generation以及采用permutation概率模型。

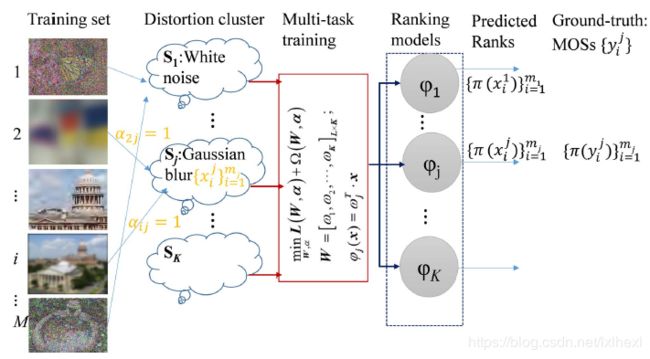

4、Multi-Task Rank Learning for Image Quality Assessment. TSCVT 2017

Authors:Long Xu, Jia Li, Weisi Lin. 中科院

框架图:按照失真类型cluster,生成K group的training samples,每组sample内按照MOS值进行排序,生成相应pair并进行特征提取,从而进行model的training。(传统分类器)

(训练过程:给定训练集,按照失真分类为若干group,每个group组内生成pair,提取特征,进行失真分类和ranking的模型训练(每个group训练得到一个rank模型),ranking模型输出结果(组内)和分类概率(组内)结合计算相应的图像中间质量分数,并根据中间质量分数进进行排序得到组内predicted rank list,和根据ground-truth MOS排序得到的总rank list中包含的label,计算loss。)每组group的训练类似于前述论文2的训练过程。

(测试过程:给定一张图,先根据模型计算属于每种失真类型的概率,然后根据训练好的所有ranking模型计算相应的图像分数,根据前述失真类型概率值和ranking模型计算的分数值计算图像的中间质量分数。该质量分数通过计算AIQD和exponential function mapping获得最终的图像质量分数。)

方法:Multi-task Rank-learning-based IQA(MRLIQ)

Single-task learning的缺点:a)对于单个任务,其训练数据较少;b)不同失真图像的共有特征未被有效利用。

(1)Multi-task Rank Learning:

Objective:

其中,前一项为经验loss,后一项为惩罚项。

Empirical loss:pair错误rank的loss(所有)

Penalty term:

a) Distortion Clustering:惩罚image分类错误(同Group内)

b) Model Correlation:惩罚image预测错误(不同Group间)

c) Model Complexity:权重的惩罚

(2)Feature Extraction:

NSS [1] and GM + LOG M3 [2]

[1] A. K. Moorthy and A. C. Bovik, “Blind image quality assessment: From natural scene statistics to perceptual quality,” IEEE Trans. Image Process., vol. 20, no. 12, pp. 3350–3364, Dec. 2011.

[2] W. Xue, X. Mou, L. Zhang, A. C. Bovik, and X. Feng, “Blind image quality assessment using joint statistics of gradient magnitude and Laplacian features,” IEEE Trans. Image Process., vol. 23, no. 11, pp. 4850–4862, Nov. 2014.

(3)Image Quality Rank->Image Quality Score

特点:模型输出为包含所有图像的rank list,而不仅是pair中两张图的质量分数比较的二值标签。

模型训练过程中不需要rank到score的mapping,因为此时pair的label已经通过mos或者dmos比较得到,而在测试过程中,类似于上述论文2,先计算AIQD,在进行mapping function的映射,得到最终的图像预测质量分数。

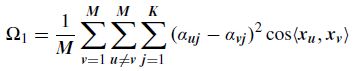

5、RankIQA:Learning from Rankings for No-reference Image Quality Assessment. ICCV 2017

Authors:Xialei Liu, Joost van de Weijer, Andrew D.Bagdanov. 西班牙计算视觉中心 论文中有代码链接(model为caffe训练)

框架图:合成ranked的失真图,生成pair(仅考虑同内容,同失真类型,不同失真水平的图生成的pair)->训练Siamese network->去rank共享网络中的单支网络,用IQA data进行finetune。(从ranking中学习得到比较好的特征表示)

(1)training Siamese networks for ranking:

pairwise ranking hinge loss:

当网络输出与rank一致,则网络梯度为0;当输出与rank不一致,则网络梯度较高,用于loss计算。

(2)Efficient Siamese backpropagation:

与 standard pair sampling(对于每个mini-batch选择36个pair用来backpropagation,即具有highest loss的pair(即上述公式梯度不为0的情况))和hard-negative sampling(mini-batch初始为36个pair,每5000 iteration后增加其pair的数量)不同,本文选择每个mini-batch包含72张图。

这篇论文的重点在于Siamese network的方向传播的推导。详细推导见论文内容。

(3)Fine-tuning for NR-IQA:

实验比较中用ImageNet的VGG-16来finetune,常规finetune而已。(也可考虑用其他经典net模型进行finetune)

baseline:直接用IQA data去finetune来自ImageNet training好的VGG-16 net,没有用pair。

RankIQA:用rank data(pair)去finetune来自ImageNet training好的VGG-16 net,取finetune好的net作为最终质量模型。

RankIQA:先用rank data(pair)去finetune来自ImageNet training好的VGG-16 net,再用IQA data finetune前述模型,得到最终的质量模型。

扩展:不将pair training和fine-tune分开,而是将两者合在一起,形成一个3 branches的模型,用一个joint loss进行统一训练。详情见此会议论文的扩展版本。

Exploiting Unlabeled Data in CNNs by Self-supervised Learning to Rank. TPAMI 2019

6、PieAPP:Perceptual Image-error Assessment through Pairwise Preference. CVPR2018

Authors:Ekta Prashnani, Hong Cai, Yasamin Mostofi, Pradeep Sen. 加州大学圣巴巴拉分校 论文中有代码链接

框架图:不一样的pair输入(包含两张失真图和一张原始图),提出的数据库包含many distortion(75种),且该框架可以用来提升其他learning-based IQA methods(最后有实验证明)。

论文针对的点是:现有的主观实验得到的hand-labeled quality score一般都存在perceptual-error。

创新点:new dataset + pairwise learning of perceptual image error

Which image, A or B, is more similar to the reference R?

传统方法计算得到A比B更接近reference image R,而主观感受则是B比A更接近,PieAPP则与主观感受相同。

注意:PieAPP方法选择主观实验中选择A比B更接近R的频率(probability of preference,如有80%的实验者认为A比B更接近R)作为pair的ground-truth label。

每一个参考图像都有对应的质量分数坐标轴,参考图像R对应坐标轴上的0 error点。其中,

网络结构:(a)为feature extraction subnet,(b)为score-computation subnet。

训练过程:对于每张训练图像(256x256)randomly sample 36 patches of size 64x64。

测试过程:对于每张测试图像randomly sample 1024 patches。

(1)large-scale image distortion dataset:共包含75种失真,大概分为以下三类

a. common image artifacts

b. distortions that capture important aspects of the HVS

c. complex artifacts from computer vision and image processing algorithms

PS:训练集中包含44种失真,测试集中包含不同于训练集的31种失真。这种失真设置方法不同于之前的learning-based IQA algorithms(训练和测试的失真相同或者存在交叉)。

(2)两个假设的实验证明:

a. Bradley-Terry(BT)model 能够准确的模拟人类对于pairwise image comparison的决策。

b. Maximum likelihood(ML)estimation 能够准确的对pair进行人类偏好概率的标注,而不需要人类标签。

(3)自己数据集上的测试和其他IQA Dataset的实验结果比较:

结果确实挺高的。

PS:这篇文章的supplementary material真的详细,长达110页!!!且包含所有distortion的介绍,相应的介绍有80页,可惜生成distortion的code没有公布。总图如下:

![g(i)=\frac{\sum_{i\neq j}^{n}[w^Tx_i-w^Tx_j]_{+}}{\sum_{i\neq j}^{n}[w^Tx_i>w^Tx_j]_{I}}](http://img.e-com-net.com/image/info8/5c51b0b60ae8427a9aab8b0581d0ce59.gif)