Hadoop伪分布模式搭建及启动

伪分布等同于完全分布只不过它只有一个结点

一JDK

在虚拟机中安装gdk

1在windows下下载好,在/home下建一个文件夹downloads并把windows下载的jdk放到这个文件夹中

2把这个压缩解开 tar -xzvf 压缩包名

3在根目录下创建一个目录/soft 把这个解压缩得到的文件移到这里

4创建一个符号链接 ln -s /soft/jdk1.8.0_65 /soft/jdk 也就是为soft/jdk1.8.0_65/创建一个名为/soft/jdk的快捷方式

之所以创建符号链接是因为名字很长不好记

5测试是否安装成功:

进入到bin目录下

[root@robot1 jdk]# cd /soft/jdk

[root@robot1 jdk]# cd bin

[root@robot1 bin]# ./java -version

配置jdk环境变量(CentOS和ubuntu不一样,这里是CentOS)

1编辑/etc/profile文件[root@robot1 soft]# nano /etc/profile 【没有nano就去下载一个yum -y install nano】

(这个是系统的配置文件,对应的是所有的用户,是永久修改的),

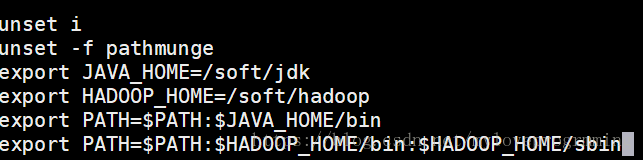

在这个文件的最下端添加:

export JAVA_HOME=/soft/jdk

export PATH=$PATH:$JAVA_HOME/bin (PATH环境变量为它当前的环境变量再加上jdk/bin下的环境变量。注:linux的环境变量是用:分割的)

ctrl+o保存

回车确定名字

ctrl+x退出

2让环境变量即刻生效

[root@robot1 soft]# source /etc/profile 【每修改一次配置文件,都要写一次这句】

之后便可以在任何目录下使用[root@robot1 /]# java -version这个命令

二Hadoop

安装Hadoop

1把Hadoop压缩包放到Linux/home/downloads下

2把这个压缩解开 tar -xzvf 压缩包名

3把这个解压缩得到的文件移到/soft

4创建一个符号链接

[root@robot1 soft]# ln -s /soft/hadoop-3.0.3 /soft/hadoop

配置hadoop环境变量

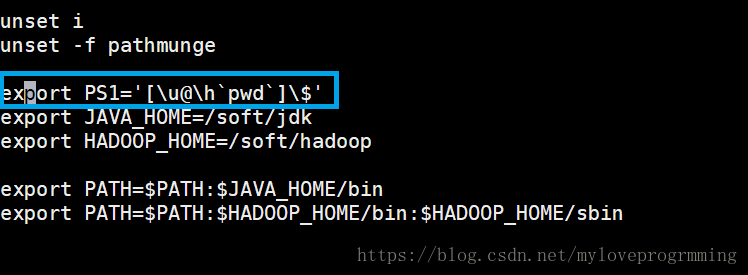

1编辑/etc/profile文件在文件末尾添加:

export HADOOP_HOME=/soft/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

变成这样:

2生效#source /etc/profile

三配置Hadoop

1独立模式(本地模式):什么也不用干,不需要启动其他的hadoop进程

2伪分布模式:所有的进程都在一台机器上跑,模拟的是小规模的集群

配置方式:

[root@robot1 hadoop]# cd /soft/hadoop/etc/hadoop #进入hadoop的配置目录

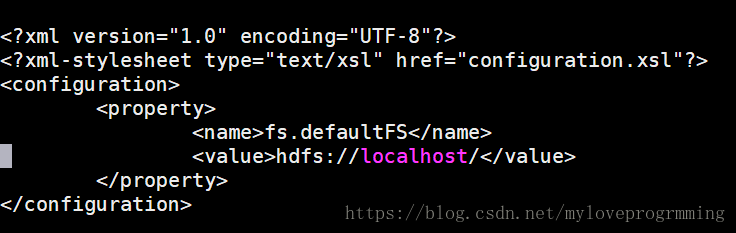

1编辑core-site.xml

fs.defaultFS

hdfs://localhost/

注:源文件中的注释可以删掉

2编辑hdfs-site.xml

dfs.replication

1

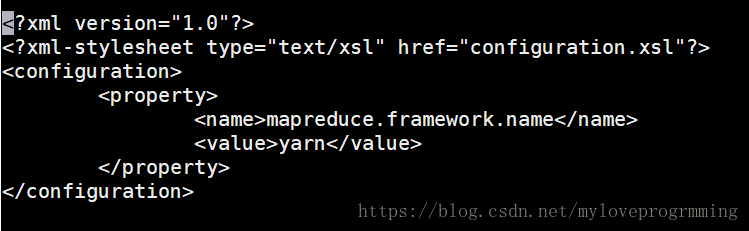

注意如果没有mapred-site.xml而只有mapred-site.xml.template

要#cp mapred-site.xml.template mapred-site.xml(复制一份该模板mapred-site.xml.template更名为mapred-site.xml)

然后再编辑该.xml文件

mapreduce.framework.name

yarn

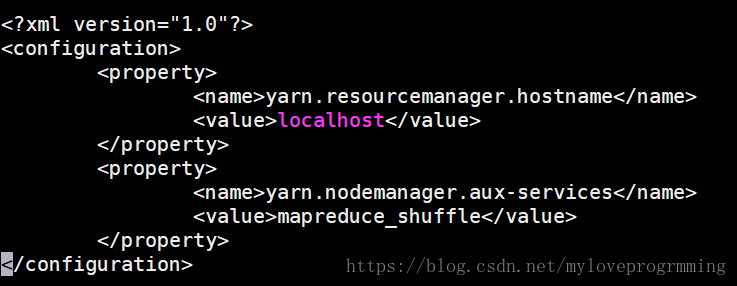

yarn.resourcemanager.hostname

localhost

yarn.nodemanager.aux-services

mapreduce_shuffle

5配置SSH,实现无密登陆(SSH是一种远程登陆机制)这里是伪登陆模式(自己登陆自己)

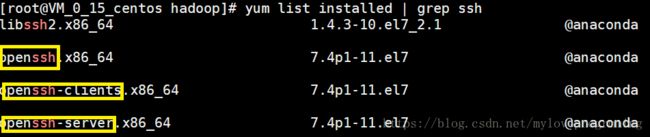

1查看是否安装3个软件包:openssh-clients openssh-server openssh

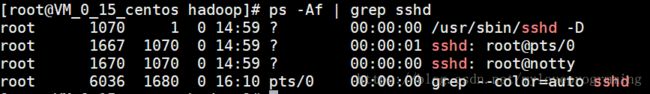

2查看是否启动sshd进程,ps用于查看进程

[root@VM_0_15_centos hadoop]# ssh localhost (用ssh登陆本机试试,发现要输入密码)

[root@VM_0_15_centos ~]# exit(退出)

[root@VM_0_15_centos hadoop]# ssh localhost(第二次登陆看看要不要密码,但还是要密码)

[root@VM_0_15_centos ~]# exit

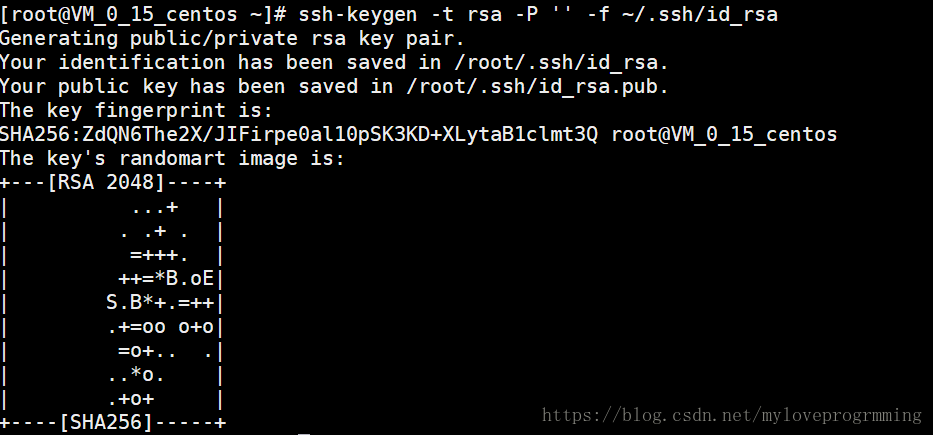

3在client(这里客户端和用户端是相同的)生成root公私密钥对

ssh-keygen表示生成密钥

-t表示算法 rsa是一种算法

-P表示密码 ''表示密码为空

-f生成到指定文件

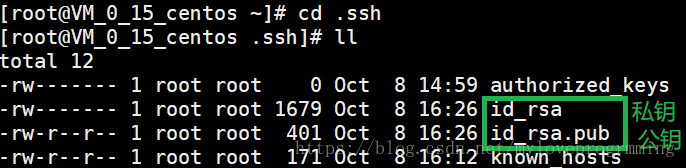

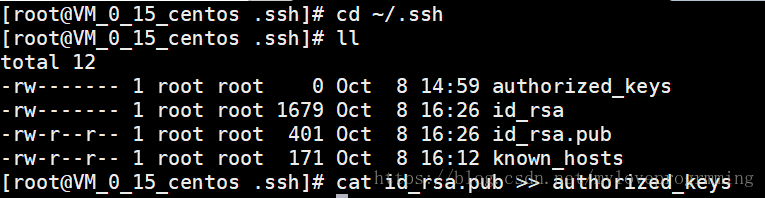

在/root/.ssh文件中发现多了两个文件:

4追加公钥到~/.ssh/authorized_keys文件中(文件名、位置固定)

5[root@VM_0_15_centos .ssh]# ssh localhost登陆一下试试看是不是还要密码,如果还需要输入,就是文件夹权限问题

我这里因为用的是root用户所以直接成功了,如果不成功要做如下操作:

[root@VM_0_15_centos .ssh]# chmod 644 authorized_keys

更改显示为全路径:编辑配置文件nano /etc/profile

\u表示用户

\h表示主机名

pwd:显示当前所在路径

6对hdfs进行格式化

[root@VM_0_15_centos/soft]#hadoop namenode -format

7修改hadoop配置文件,手动指定JAVA_HOME环境变量

8启动hadoop的所有进程

#