大数据平台搭建(Hive)安装(五)

hive下载地址:http://hive.apache.org/

搭建参考 :https://blog.csdn.net/qq_15267341/article/details/89817841

注意: hive只是hadoop的一个客户端工具,因此不用每台机子上都要装

本地安装包上传到 /usr/lcoal

解压 重命名文件为hive

cd /usr/local/hive/conf

修改 hive-env.sh.templet hive.env.sh

vi hive.env.sh 修改hadoop_home 的目录

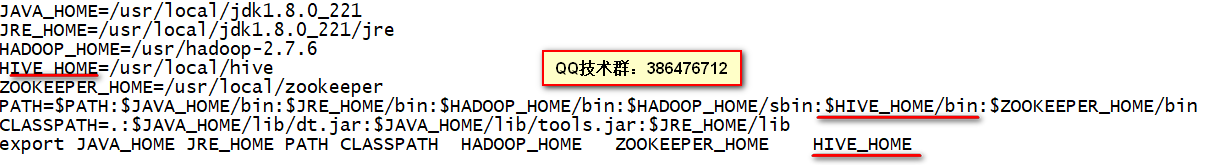

至此,hive安装已经完成,为了配合启动hive方便,将hive配置到环境变量中去,在任何目录下输入hive即可启动

此时输入hive,回车 ,等待一段时间即启动hive

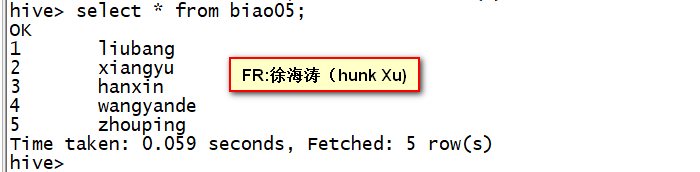

下面简单测试一下 hive

建一张表:

create table biao05(id int ,name string) row format delimited fields terminated by '|';

在本地 /usr/local目录下准备一个文本,命名为 ttt1.txt,文本内容如下:

1|liubang

2|xiangyu

3|hanxin

4|wangyande

5|zhouping然后将上面建的本地文本文件上传到biao05

load data local inpath '/usr/local/ttt1.txt' into table biao05此时在hive中可以查询一下:

除此之外,也可以将hdfs文件载入到hive表中,下面接着演示

在本地 /usr/local目录下再准备一个文本,命名为 ttt2.txt,文本内容如下:

1|xiaomingi111

2|xiaozhang222

3|xiaoxu333

4|xiaowu444将这个文件上传到hdfs中/hhhhh目录下

hadoop fs -mkdir /hhhhh

hadoop fs -put ttt2.txt /hhhhh/注意不带local,带local的是将linux本地文件上传到hive表中,不带local的是将hdfs文件上传到hive表中

load data inpath '/hhhhh/ttt2.txt' into table biao05;这样将 hdfs中/hhhhh/ttt2.txt 这个文件载入biao05中了

留意一下:发现hdfs中/hhhhh目录下,已经没有ttt2.txt,其实是改了该文件在namenode中地址索引,文件本身并没有发生移动

接下来安装mysql,安装过程,参考这里,用于保存hive中元数据,替代其自带默认的derby数据库

提示 : 安装完一台 ,可以使用scp命令,将配置好的文件复制到另一台机子上

scp -r /usr/local/hive/bin/hive-config.sh root@machine197:/usr/local/hive/bin

scp -r /usr/local/hive/conf/hive-site.xml root@machine197:/usr/local/hive/conf

FR:徐海涛(hunk Xu)

QQ技术交流群:386476712