rhcs(集群高可用,文件共享以及同步)

#环境

redhat 6.5

三台虚拟机 : ip

server1 :172.25.55.1

server2 :172.25.55.2

server3:172.25.55.3

#配置yum源,解决依赖包

HighAvailability

LoadBalancer

ResilientStorage

ScalableFileSystem

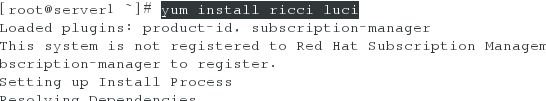

# server1和2 集群管理安装如下服务

ricci:安装在集群的节点的接收来自 luci 管理请求的代理,端口=11111

luci:提供了管理 rhcs 集群的 图形 界面, luci 管理集群主要是通过跟 ricci 通信来完成的,端口=8084

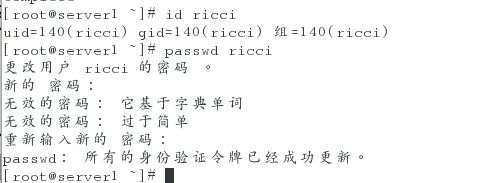

# 给ricci服务添加用户,修改密码我这里为redhat

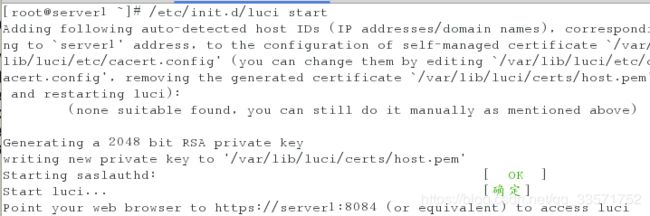

# 启动服务ricci和luci,设置开机自启动

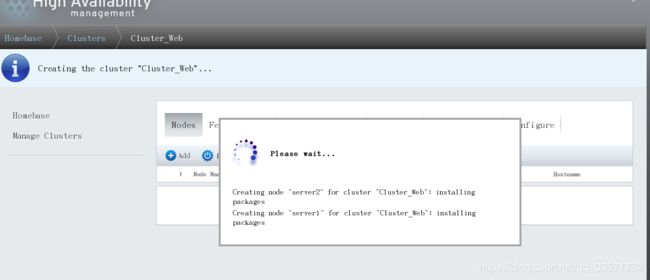

# 配置完成后,在浏览器输入https:/172.25.55.1:8084,输入server1的root,以及密码登陆,进入web浏览器图形配置

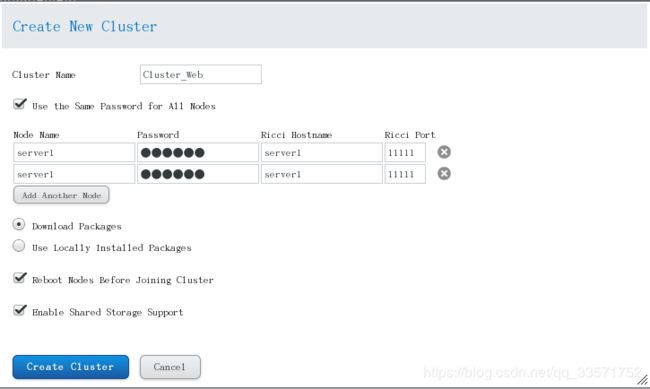

# 创建新集群,集群名称

# 添加节点server1和server2,这里截图有错

节点名任意 : ricci密码 : Ricci所在主机名server1 : 默认端口

# 自动下载依赖包,节点重启

# 支持存储共享

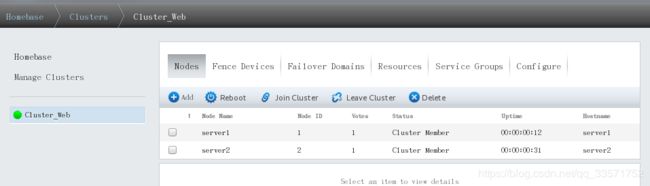

# 等待一会儿,Cluster_web集群就创建完成

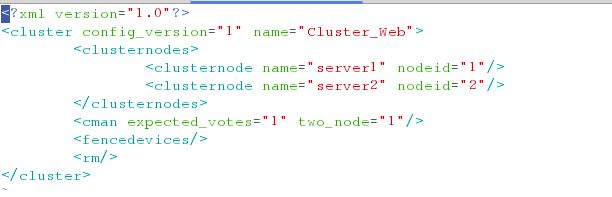

# 配置文件都在该目录下,以下就是我们刚刚创建的集群信息

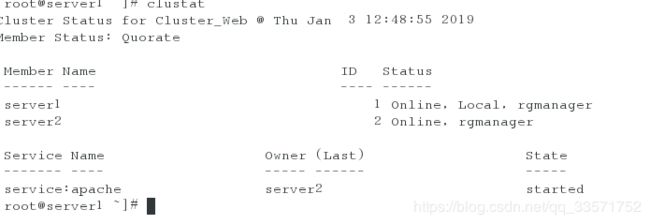

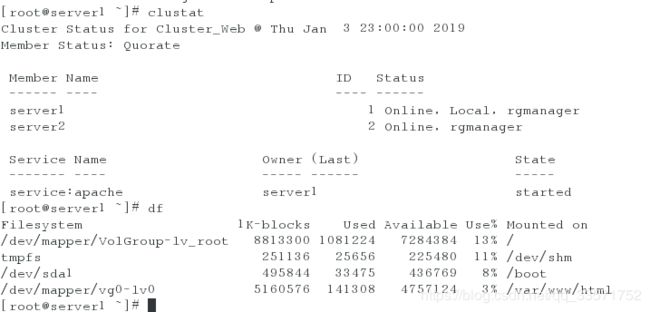

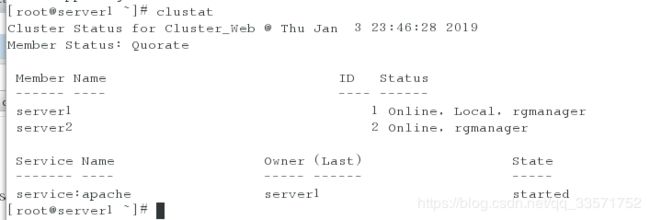

# 通过clustat命令查看所有节点信息

添加fence

# 首先真机安装fence-virtd-libvirt和fence-virtd-multicast.x86_64

yum install fence-virtd-libvirt fence-virtd-multicast.x86_64 -y

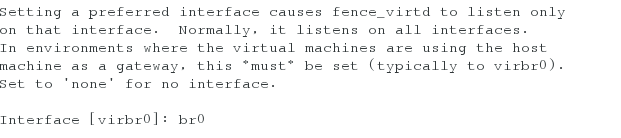

fence_virtd -c #创建隔离设备

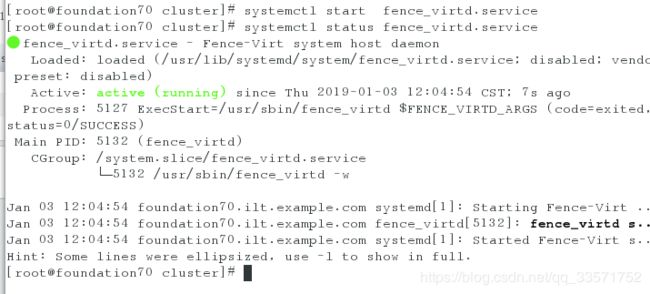

#配置fence,虚拟机是桥接到真机的br0上所以修改interface为br0,其他默认配置直接回车,最后输入y保存配置,启动服务

#通过dd命令生成加密认证文件fence_xvm.key,scp发送给两个节点主机server1和server2的/etc/cluster目录下

mkdir /etc/cluster

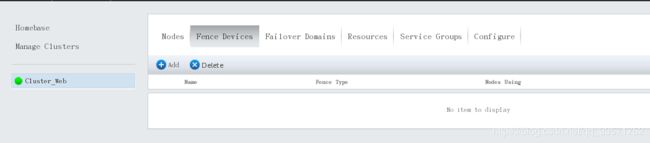

#然后图形配置,添加fence,类型为Fence virt(Multicast Mode),以及名称

#给两个节点分别添加fence设备,如下

选择Serverfence,刚刚添加的

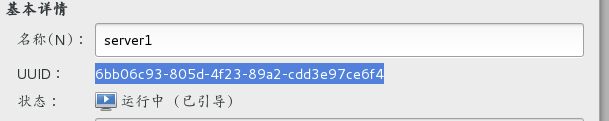

random:为随机数字生成器,生成的东西是唯一的,虚拟机的UUID为一标识

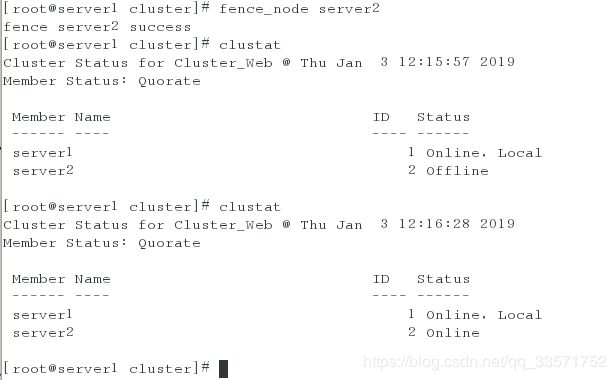

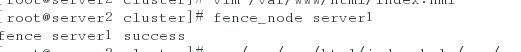

#测试,通过以下命令测试,serve2状态为offline,被重新启动了,这样就避免了当server2因为网络延迟等,server1认为server2挂了后,互相抢占资源

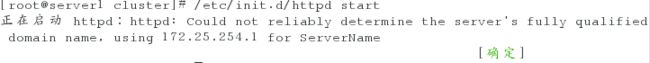

# 两台服务器安装http服务

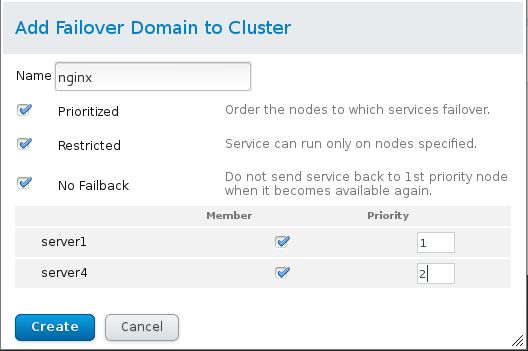

#添加一个失效域Failover Domain,名称为apche_failed,(截图注意,名称任意,但是后面会选择失败域,选择你创建的),定义节点优先级

prioritized #一个节点失效另一个接管

restricted #服务只能在特定的节点上运行

NO Faliback #节点接管服务后一直接管,即使之前的节点恢复正常

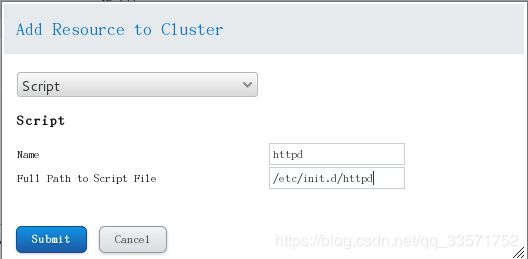

###高可用资源添配置添加Resource

# 添加VIP

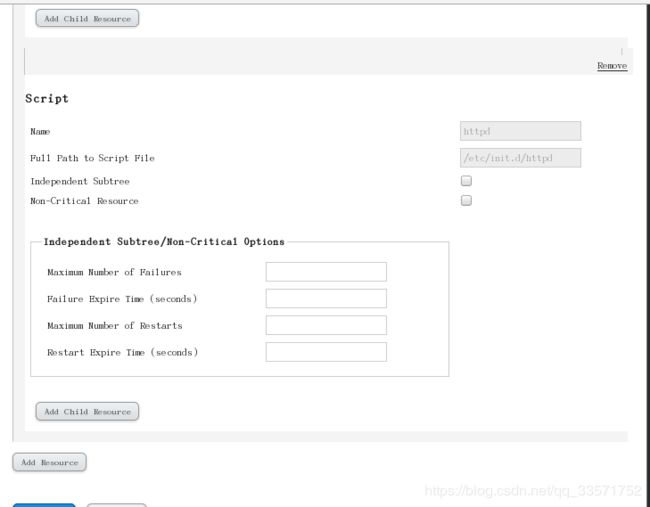

#添加启动服务脚本

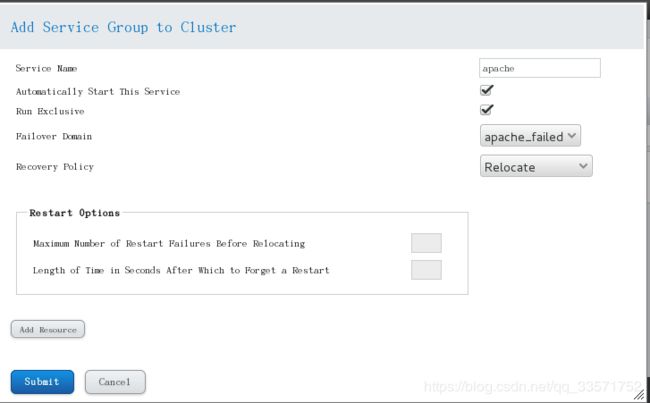

### 服务组创建

# 添加一个服务组,起名,自动启动此服务,独占运行,失效域Failover Domain 选择我们创建的失效域

# 资源的添加顺序:服务——>VIP——>服务脚本

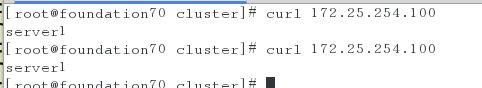

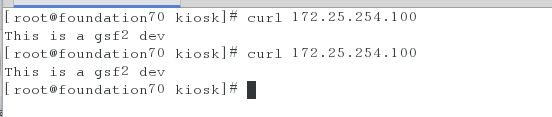

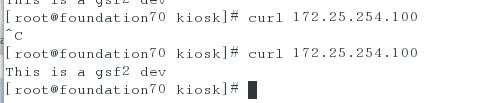

测试访问VIP,结果如下,

# fence掉server1是,服务就会启动到sever1,或者重启网络测试

##共享存储

server3:

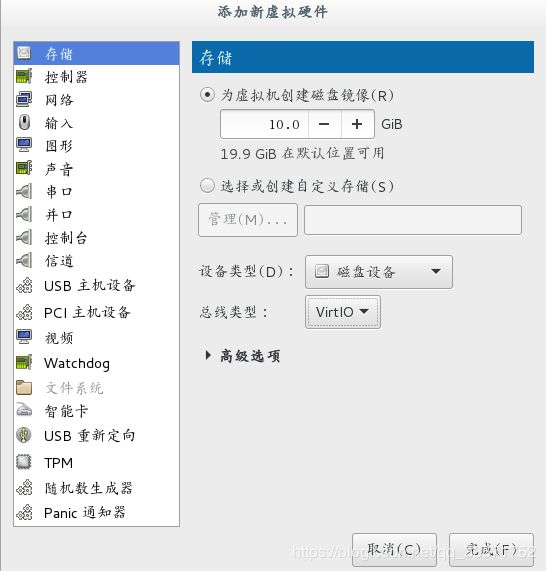

首先添加一块虚拟磁盘

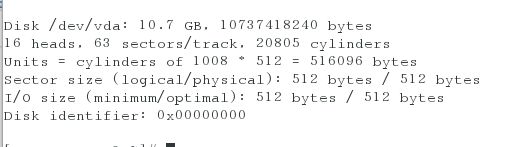

fdisk -l #查看我们杠杆添加的虚拟磁盘

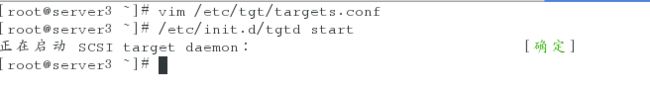

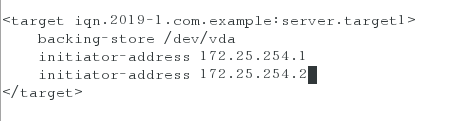

安装iscsi服务端软件,文件配置共享设备/dev/vda,然后启动tgtd

server1和server2

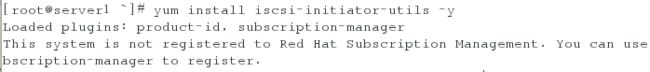

# 安装ISCIS客户端软件,连接共享设备

# 查看多了我们连接的共享设备,名称为/dev/sdb,就可以使用了

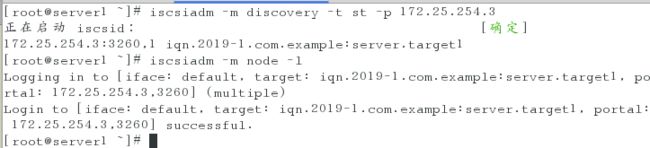

# 分区

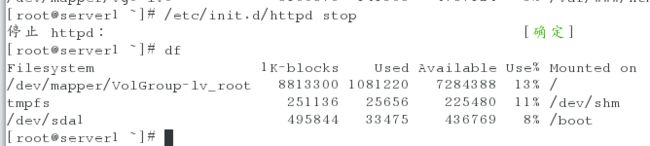

#lvm划分,ext4格式,只支持单点运行,当他在server1中进行配置后,必须卸载后,另一个主机重新挂载后才能同步共享到server1的配置

# 挂载,写入index.tml

#卸载,服务会自动挂载

# 命令停止服务组,也可以图形点击停止

clusvcadm -d apache

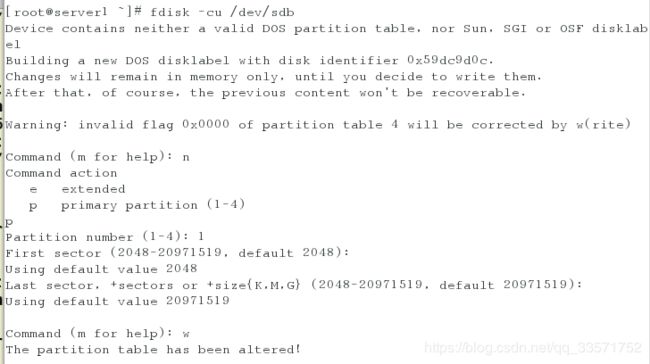

# 添加一个Filesystem高可用资源,名称为iscsi_dev

#更改集群服务组的资源,删除掉原来的高可用资源,重新添加

## 资源的添加顺序:VIP——>Filesystem——>服务脚本

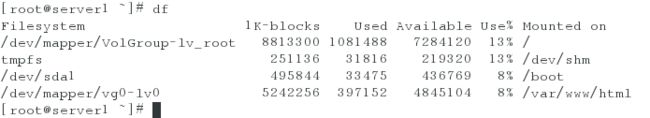

测试,默认server1优先

#当server1停止工作,自动卸载,然后就会自动挂载到server2,并自启动httpd服务

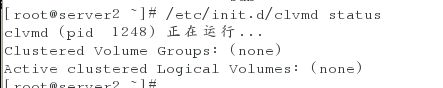

###gfs2+clvm

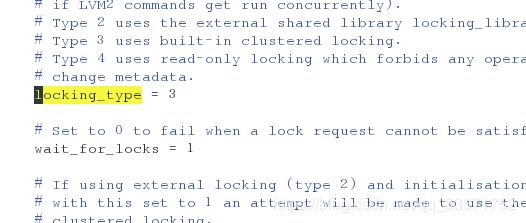

#rhcs支持clvm,实现lvm共享设备管理,这里配置是3表示支持同时读写,确认以下

# gfs2支持共享设备同步

gfs2:GFS是Red Hat开发的一套集群文件系统,GFS文件系统允许多个服务同时读写一个磁盘分区,通过GFS可以实现数据的集中管理,免去了数据同步和复制的麻烦,但GFS并不能孤立的存在,安装GFS需要RHCS的底层组件支持。

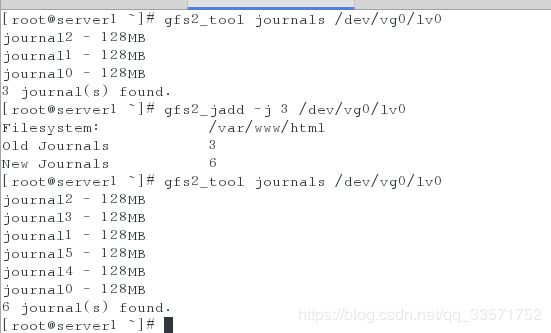

mkfs.gfs2 -j 3(日志个数为3) -p lock_dlm(分布式锁管理) -t 集群名称 /dev/vg0/lv0 ##格式化为gfs2格式

-j: 指定日志区域的个数,有几个就能够被几个几点挂载

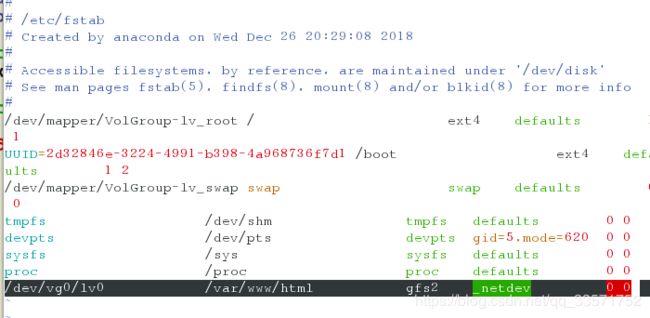

# 节点server1和server2配置开机自动挂载

vim /etc/fstable

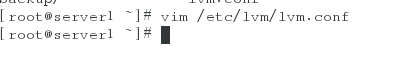

##同样更改高可用资源

#首先删除原来的Filesystem名称为iscsi_dev,否则回报错,因为我们更改了lvm设备格式,配置的是ext4格式

# 重新配置配置顺序为VIP——>服务脚本

# 重启节点,保证节点开机自动挂载

测试

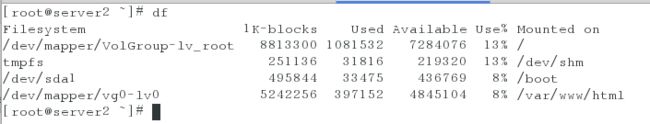

# 停止server1的服务后,短暂延迟后server2开始工作

lvm+gfs:支持设备、文件系统拉伸

#可以 lvs查看设备拉伸情况,这里没有截图

# gfs文件系统拉伸

#可加入节点个数,由几个日至就可以挂载几个节点上,默认日至大小为128,格式化-J可以指定日只大小