centos7系统单机安装部署hadoop2.6.5

今天单机安装部署Hadoop,就顺便记录一下安装过程

1 首先需要下载jdk和hadoop的安装包

我安装的版本是Hadoop-2.6.5.tar.gz(注意不要下载成hadoop-2.6.5-src.tar.gz)和jdk-8u162-linux-x64.tar.gz

2 安装jdk

检查并卸载OpenJDK

第一步检查系统是否自带了OpenJDK以及相关安装包,如果有的话则应先将其卸载。

检查命令:

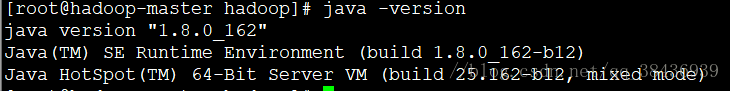

- java -version(查看版本,使用这个命令就可以)

- 或

- rpm -qa | grep java(查看所有安装的软件包中带有Java的)

如果发现有安装好的OpenJDK以及安装包的话那么首先依次执行卸载。

卸载命令:

- yum -y remove ...(省略号为java安装包名称)

- 或

- rpm -e -–nodeps tzdata-java-2012c-1.el6.noarch

- rpm -e -–nodeps java-1.6.0-openjdk-1.6.0.0-1.45.1.11.1.el6.x86_64(务必注意–nodeps前的两个横杠)

现在便可以进行安装

1)将jdk-8u162-linux-x64.tar.gz移动到了home文件夹下解压,并将其重命名为Java

2)配置环境变量

#set java environment

export JAVA_HOME=/usr/java/jdk1.8.0_162

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH输入java -version看是否安装成功

如上图所示正常显示了jdk版本,到此为止就已经安装成功了。

3 安装hadoop

1)将Hadoop-2.6.5.tar.gz移到home文件夹下解压,并重命名为hadoop

2)配置hadoop

a.修改/usr/hadoop/etc/hadoop/hadoop-env.sh 文件的java环境,将java安装路径加进去

export JAVA_HOME=/usr/java/jdk1.8.0_162b.配置hadoop环境变量

export HADOOP_HOME=/usr/hadoop/export PATH=${HADOOP_HOME}/bin:${HADOOP_HOME}/sbin:$PATH使用source /etc/profile使更改后的配置文件生效

c.修改/usr/hadoop/etc/hadoop/core-site.xml 文件

fs.defaultFS

hdfs://localhost:9000

hadoop.tmp.dir

/usr/hadoop/tmp

d.修改/usr/hadoop/etc/hadoop/hdfs-site.xml

dfs.name.dir

/usr/hadoop/hdfs/name

namenode上存储hdfs名字空间元数据

dfs.data.dir

/usr/hadoop/hdfs/data

datanode上数据块的物理存储位置

dfs.replication

1

e.ssh免密登录

ssh-keygen -t dsa -P '' -f ~/.ssh/id_dsa

cat ~/.ssh/id_dsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys f.hdfs启动与停止

第一次启动hdfs需要格式化

在hadoop文件夹下执行 ./bin/hdfs namenode -format命令进行格式化

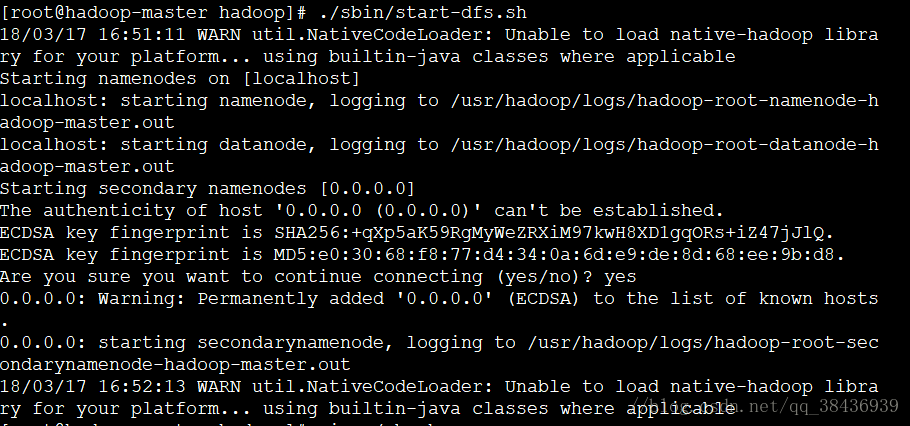

hdfs启动:start-dfs.sh hdfs停止命令:stop-dfs.sh

若在启动hdfs时出现Unable to load native-hadoop library for your platform...提示hadoop不能加载本地库。

若程序和操作系统都是64位的,那也许就是少了些配置,试试下面的方法:

首先在bashrc中加入如下配置:

h.接下来配置yarn文件

配置/usr/hadoop/etc/hadoop/mapred-site.xml 。这里注意一下,hadoop里面默认是mapred-site.xml.template 文件,如果配置yarn,把mapred-site.xml.template 重命名为mapred-site.xml 。

mv mapred-site.xml.template mapred-site.xml 配置mapred-site.xml文件

mapreduce.framework.name

yarn

配置/usr/hadoop//etc/hadoop/yarn-site.xml文件

yarn.nodemanager.aux-services

mapreduce_shuffle

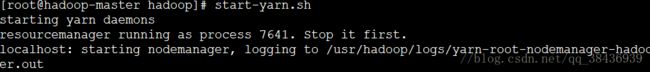

启动yarn :start-yarn.sh 停止yarn:stop-yarn.sh

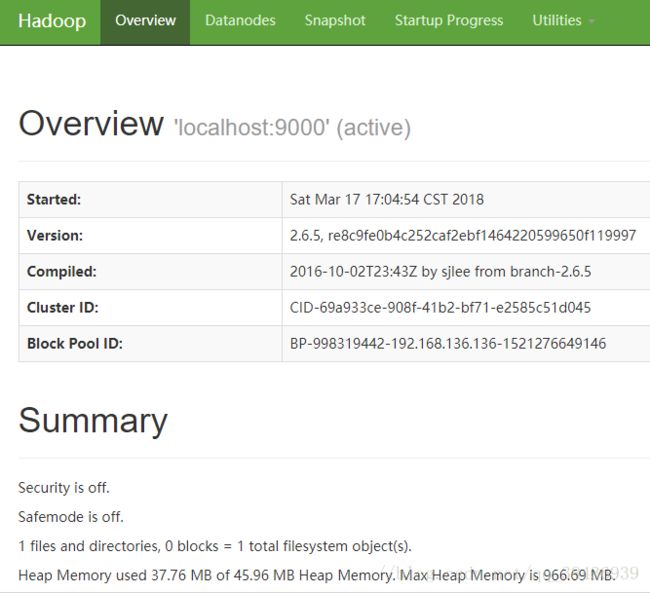

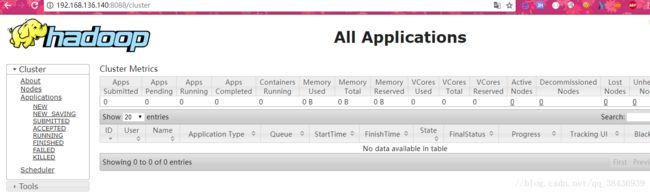

i.验证Hadoop安装

浏览器输入http://192.168.136.140:8088 (8088是默认端口)

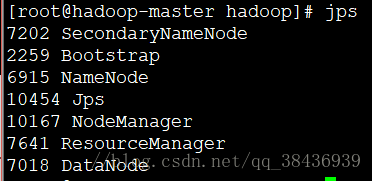

可以用jps命令查看启动了什么进程: