科技云报道:

回顾计算机行业发展史,新的计算模式往往催生新的专用计算芯片。人工智能时代对于新计算的强大需求,正在催生出新的专用计算芯片。在加州Hot Chips大会和2017百度云智峰会上,百度发布了AI云计算芯片的XPU,这是一款256核、基于FPGA的云计算加速芯片。过去几年,百度在深度学习领域,尤其是基于GPU的深度学习领域取得了不错的进展。同时,百度也在开发被称作XPU的新处理器。”

如果说,2016年AlphaGo和自动驾驶汽车让人们感受到了硬件运算能力的重要性,那么今年发展出超高运算能力又符合市场需求的芯片,成为了每家人工智能厂商的关键一役,其将决定未来人工智能领域的竞争格局。

去年,芯片企业和互联网巨头们在芯片领域展开全面部署:先有CPU芯片巨头Intel年内三次大手笔收购人工智能和GPU领域企业;后有Google宣布开发自己的处理系统,而Apple、Microsoft、Facebook和Amazon也都纷纷加入,Nvidia因其在人工智能领域的优势成为了资本市场的宠儿。

而如今,百度欲凭借XPU在国内人工智能领域抢占头把交椅。那么居于人工智能心脏地位的芯片已经发展到何种程度了?

整体上看,人工智能核心计算芯片经历了四次大的变化。2007年以前,人工智能研究和应用一直没有发展成为成熟的产业,同时受限于当时算法、数据等因素,这一阶段人工智能对于芯片并没有特别强烈的需求,通用的CPU芯片即可提供足够的计算能力。

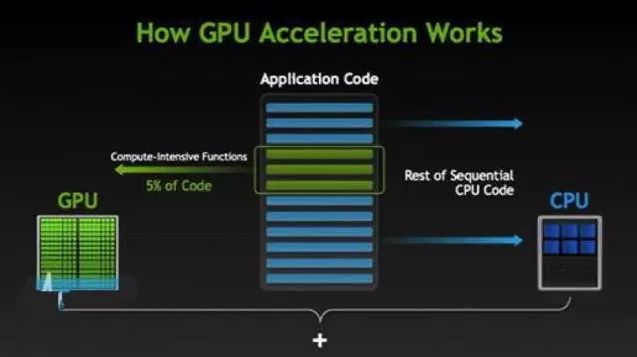

之后,由于高清视频、游戏等行业的发展,GPU产品取得快速的突破,人们发现GPU的并行计算特性恰好适应人工智能算法大数据并行计算的要求,如GPU比之前传统的CPU在深度学习算法的运算上可以提高9倍到72倍的效率,因此开始尝试使用GPU进行人工智能的计算。

进入2010年后,云计算广泛推广,人工智能的研究人员可以通过云计算借助大量CPU和GPU进行混合运算,事实上今天人工智能主要的计算平台还是云计算。

但人工智能业界对于计算能力的要求不断快速地提升,因此进入2015年后,业界开始研发针对人工智能的专用芯片(ASIC),通过更好的硬件和芯片架构,在计算效率上进一步带来10倍的提升。

摩尔定律失效 人工智能遭遇算力挑战

深度学习不仅在传统的语音识别、图像识别、搜索/推荐引擎、计算广告等领域证明了其划时代的价值,也引爆了整个人工智能生态向更大的领域延伸。

由于深度学习的训练和推断均需要大量的计算,人工智能界正在面临前所未有的算力挑战,而其始作俑者,是摩尔定律的失效。由于结构所限,CPU性能近年来未能呈现如摩尔定律预测的定期翻倍,于是具有数量众多计算单元和超长流水线、具备强大并行计算能力与浮点计算能力的GPU,成为了深度学习模型训练的标配。

GPU可以大幅加速深度学习模型的训练速度,相比CPU能提供更快的处理速度、更少的服务器投入和更低的功耗,并成为深度学习训练层面的事实工具标准。

目前,GPU已经发展到较为成熟的阶段。Google、Facebook、Microsoft和百度等公司都在使用GPU分析图片、视频和音频文件,以改进搜索和图像标签等应用功能。GPU也被应用于VR/AR相关的产业。

此外,很多汽车生产商也在使用GPU芯片发展无人驾驶。根据研究公司Tractica LLC预测,用于人工智能的GPU将从2016年的不到1亿美元增长到2025年的140亿美元,GPU将出现爆炸式增长。

但随着人工智能产业链的火速延伸,GPU并不能满足所有场景(如手机)上的深度学习计算任务,GPU并不是深度学习算力痛点的唯一解。算力的刚需,吸引了众多巨头和初创公司纷纷进入人工智能芯片领域,并形成了一个自下而上的生态体系。

深度学习的三大主流硬件方案:GPU、FPGA、ASIC

一项深度学习工程的搭建,可分为训练(training)和推断(inference)两个环节:训练环境通常需要通过大量的数据输入,或采取增强学习等非监督学习方法,训练出一个复杂的深度神经网络模型。

训练过程由于涉及海量的训练数据(大数据)和复杂的深度神经网络结构,需要的计算规模非常庞大,通常需要GPU集群训练几天甚至数周的时间,在训练环节GPU目前暂时扮演着难以轻易替代的角色。

进入推断环节,虽然计算量相比训练环节要少,但仍然涉及大量的矩阵运算。在推断环节,除了使用CPU或GPU进行运算外,FPGA以及ASIC均能发挥重大作用。

FPGA(可编程门阵列)是一种集成大量基本门电路及存储器的芯片,可通过烧入FPGA配置文件来来定义这些门电路及存储器间的连线,从而实现特定的功能。而且烧入的内容是可配置的,通过配置特定的文件可将FPGA转变为不同的处理器,就如一块可重复刷写的白板一样。

因此FPGA可灵活支持各类深度学习的计算任务,性能上根据百度的一项研究显示,对于大量的矩阵运算GPU远好于FPGA,但是当处理小计算量大批次的实际计算时FPGA性能优于GPU,另外FPGA有低延迟的特点,非常适合在推断环节支撑海量的用户实时计算请求(如语音云识别)。

研究报告显示,目前的FPGA市场由Xilinx和Altera主导,两者共同占有85%的市场份额,其中Altera在2015年被intel以167亿美元收购,另一家Xilinx则选择与IBM进行深度合作,背后都体现了FPGA在人工智能时代的重要地位。

出货量其单颗成本难以下降,而且芯片的功能一旦流片后则无更改余地,若市场深度学习方向一旦改变,ASIC前期投入将无法回收,意味着ASIC具有较大的市场风险。

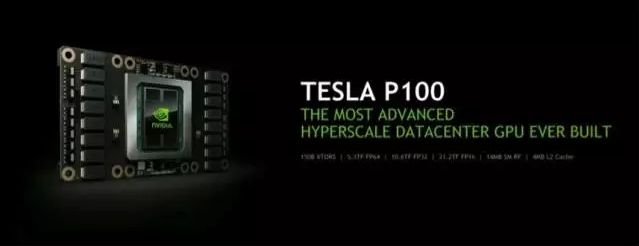

但ASIC作为专用芯片性能高于FPGA,如能实现高出货量,其单颗成本可做到远低于FPGA。从发展上看,人工智能定制芯片将是未来计算芯片发展的大方向。例如NVIDIA首款专门为深度学习从零开始设计的芯片Tesla P100数据处理速度是其2014年推出GPU系列的12倍。

面对被NVIDIA赚得盆满钵满的深度学习Training市场,众多巨头纷纷对此发起挑战。Google今年5月份发布了TPU2.0,TPU是Google研发的一款针对深度学习加速的ASIC芯片,第一代TPU仅能用于推断,并在AlphaGo人机大战中提供了巨大的算力支撑。

而Google发布的TPU2.0除了推断以外,还能高效支持训练环节的深度网络加速。目前,Google并没急于推进TPU芯片的商业化,而是结合Google云服务推出TensorFlow Cloud,通过TensorFlow加TPU云加速的模式为AI开发者提供服务。

人工智能专用芯片的涌现表明从芯片层面开启的新一轮计算模式变革拉开帷幕,是人工智能产业正式走向成熟的拐点。不管是NVIDIA、Intel还是Google或是百度,都在寻找一种未来人工智能能够广泛应用的基础。在人工智能的遥远未来,GPU没有代替CPU,而FPGA和ASIC也不会取代GPU,芯片市场将出现更大的需求和繁荣。

【科技云报道原创】