一、基本形式:

给定由 d 个属性描述的实例,其中 是 在第 个属性上的取值,线性模型(linear model)试图学得一个通过属性的线性组合来进行预测的函数,即:,

一般用向量形式写成:,其中 ,

和 的值确定之后,模型就可以随之确定。

二、线性回归:

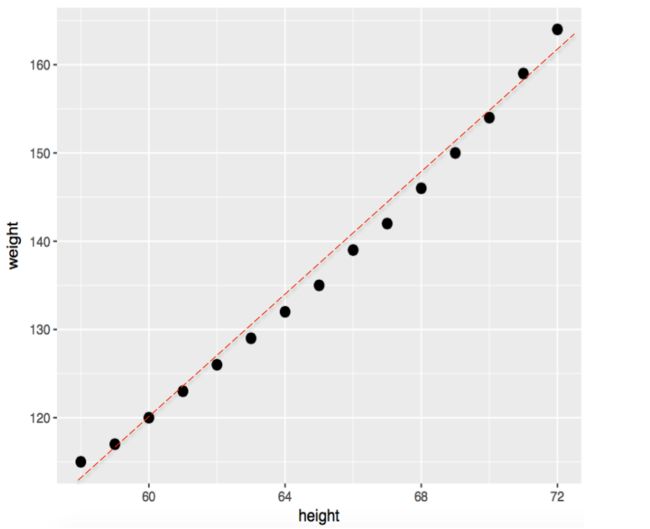

给定数据集 ,

其中 “线性回归”(linear regression)试图以尽可能准确地预测实值输出标记。

线性回归试图学得

而如何确定 和 ,关键在于如何衡量 与 之间的差别。

当均方误差最小化(最小二乘法)时,上述两者之间的差别最小,即可求得线性回归函数。

找到一条直线,使得所有样本到直线上的欧式距离之和最小。

分别令上述式子对 和 的偏导为0,可得到 和 的最优解为:

其中, 为 的均值。

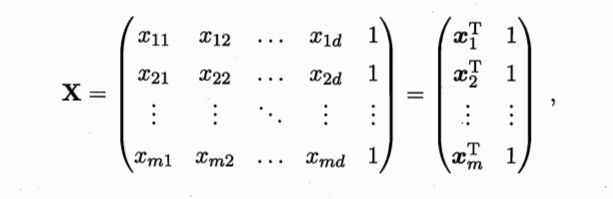

当然,我们遇见的更一般的情况是数据集中的样本由多个属性描述,此时我们试图学得这种情况称之为多元线性回归。

类似的,可以用最小二乘法来对 和 进行估计,为方便,将 和 吸收入向量形式 ,相应地把数据集表示成一个 的矩阵 ,其中每一行对应一个示例,该行的前 个元素对应于 个属性值,最后一个元素恒置为1,即:

再把标记也写成向量形式 ,故有:

使的偏导为0即可求得最优解。具体步骤略。

最终学得的多元线性回归模型为:。

三、代码实现及例子:

以下为线性模型的 Python 代码实现

import numpy as np

import matplotlib.pyplot as plt

"""

利用 Python 实现线性回归模型

"""

class LinerRegressionModel(object):

def __init__(self, data):

self.data = data

self.x = data[:, 0]

self.y = data[:, 1]

def log(self, a, b):

print("计算出的线性回归函数为:\ny = {:.5f}x + {:.5f}".format(a, b))

def plt(self, a, b):

plt.plot(self.x, self.y, 'o', label='data', markersize=10)

plt.plot(self.x, a * self.x + b, 'r', label='line')

plt.legend()

plt.show()

def least_square_method(self):

"""

最小二乘法的实现

"""

def calc_ab(x, y):

sum_x, sum_y, sum_xy, sum_xx = 0, 0, 0, 0

n = len(x)

for i in range(0, n):

sum_x += x[i]

sum_y += y[i]

sum_xy += x[i] * y[i]

sum_xx += x[i]**2

a = (sum_xy - (1/n) * (sum_x * sum_y)) / (sum_xx - (1/n) * sum_x**2)

b = sum_y/n - a * sum_x/n

return a, b

a, b = calc_ab(self.x, self.y)

self.log(a, b)

self.plt(a, b)

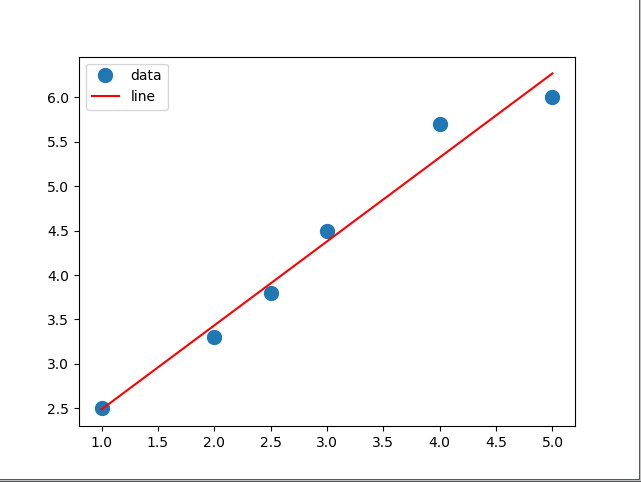

data = np.array([[1, 2.5], [2, 3.3], [2.5, 3.8],[3, 4.5], [4, 5.7], [5, 6]])

model = LinerRegressionModel(data)

model.least_square_method()

最终输出结果为:

sklearn 中也带有线性回归的代码模块。

sklearn.linear_model中的LinearRegression可实现线性回归

• LinearRegression 的构造方法:

• LinearRegression(

fit_intercept=True, #默认值为 True,表示 计算随机变量,False 表示不计算随机变量

normalize=False, #默认值为 False,表示在回归前是否对回归因子X进行归一化True 表示是 ,

copy_X=True

)

LinearRegression 的常用方法有:

• decision_function(X) #返回 X 的预测值 y

• fit(X,y[,n_jobs]) #拟合模型

• get_params([deep]) #获取 LinearRegression 构造方法的参数信息

• predict(X) #求预测值 #同 decision_function

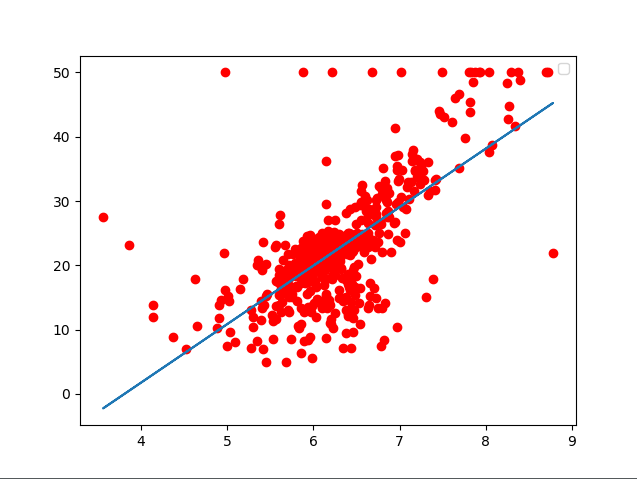

例子:波士顿房价的线性关系。

from sklearn.linear_model import LinearRegression

from sklearn.datasets import load_boston

import matplotlib.pyplot as plt

"""

线性回归

"""

# 1.获取数据

boston = load_boston() # 获取波士顿房价的数据

x = boston.data[:, 5:6] # 取数据第五列为 x 的值

y = boston.target # 取 y 值

# 2.训练模型

model2 = LinearRegression().fit(x, y)

# 3.模型预测

pre = model2.predict(x)

# 4.绘制结果

plt.scatter(x, y, color='red')

plt.plot(x, pre)

plt.show()

plt.close()

输出结果为:

菜鸡!