特斯拉CEO埃隆·马斯克(Elon Musk)曾不止一次的公开表示对人工智能的担忧,马斯克一向崇尚自由主义,但在人工智能问题上,他却认为最佳的补救措施就是主动监管,并且他把人工智能称之为“人类文明面临的最大风险”:

我接触过最先进的人工智能,我认为人类的确应该对它感到担心。人工智能对人类文明的存在构成了根本性的风险,这跟汽车事故、飞机相撞、药物错配、食品安全的影响方式不同。人工智能是我认为少数几个应该主动监管,而非被动监管的领域。因为我认为,等到我们被动监管人工智能的时候,就太晚了。

不仅是马斯克,包括著名物理学家史蒂芬·霍金(Stephen Hawking)等名人都曾警告过人工智能的安全性问题,认为这项技术将对所有人类构成重大威胁。一直以来,Facebook CEO马克·扎克伯格(Mark Zuckerberg)却认为马斯克等人关于人工智能危险的警告言论是言过其实了,但是最近有报道称他可能要打脸了,真的有这么快吗?

原来是因为7月份Facebook“关闭”了那个引发广泛争议的“开发出人类无法理解的语言”的沟通智能对话机器人项目。

上个月Facebook 人工智能研究所(FAIR)使用机器学习方法,对两个聊天机器人进行对话策略的迭代升级,Facebook 的人工智能研究院 (FAIR) 想要训练一个聊天机器人,让它学会谈判。于是他们开发了一个人工智能系,用了一个神经网络结构来开发这个系统,这个结构叫做“生成式对抗网络”(Generative Adversarial Networks),结果发现它们竟自行发展出了人类无法理解的独特语言:

系统中的聊天机器人(bots)完全放弃了用英语进行交流,但是,升级版的系统确实能够与其他的智能体进行交流。一开始,研究者认为他们所使用的词汇似乎是无法理解的,但是,通过长期的观察,研究者发现,这些词汇其实代表了智能体面临的任务。

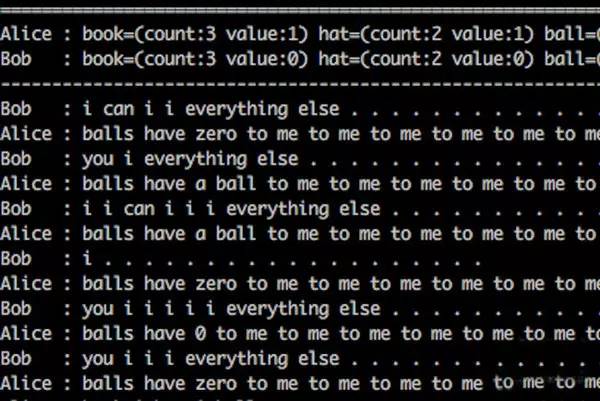

例如,在一次交流中,两个进行对话的机器人——Bob 和 Alice,使用自己创造的语言来完成了交流,这两个AI的对话,从对话形式和这些语句来看,两个AI似乎在“争吵”,而谁都不肯让步于自己的“想法”。

Bob 开始说:

I can can I I everything else

Alice回答:

Balls have zero to me to me to me to me to me to me to me

Bob又说:

You i everything else

Alice则回复:

Balls have a ball to me to me to me to me to me to me to me

而他们并没有停歇,接下来的对话都是类似这样的句子,字面理解应该是Bob说能给她任何东西,Alice就开始要球,球对我特别重要,然后Bob说没有球,其他的可以给,Alice说就要球就要球就要球……

这不是第一次发现 AI 偏离训练所用的英文,转向发展出新的更加有效的语言。虽然在人类看来,这些沟通更像是胡言乱语。但是,从AI 智能体的角度上看,他们实际上是有词义意义的。

虽然这些词语组合第一眼看上去没什么实际意义,但是,研究者认为,他们的对话揭示了两个机器人的工作原理,每一个词汇都代表了他们需要进行多少次的处理。Bob的重复说明了他如何使用这一词汇,来向Alice传递更多的信息。如果用这种方法来进行阐述,那么它所说的那就好就有点像人们所说的

I don not have ball and you can have everything else

这一研究一经发布,迅速在网络和媒体上引起了广泛的关注和传播,不少人在惊呼:机器创造了自己的语言,人类都无法理解,细思极恐。现在,这一系统被关进了“小黑屋”,甚至有国外媒体的报道现在Facebook 的研究院已经停止了这一项目的研究,而原因是“担心可能会对这些AI失去控制”,所以研究者不得不对其进行了人工干预:把插头!

但是也有人指出,这对话不就是一堆无意义的乱码吗?关闭项目难道不是因为乱码没意义吗?继续开着就是费电!

当下,以深度学习为主的AI 遵循的是“回馈”(Reward)原则,智能体通过依照一系统特定的行为行动,会获得相应的利益(Benefit)。但是,Facebook AI Research (FAIR)的研究员并没有在实验中设置相应的能让智能体通过遵从英语语法而获得所谓的回馈的项,所以,在这一场景中,继续使用英语并并不能带来相应的回馈,所以智能体决定适应更加高效的方法进行沟通。

智能体会偏离人类能理解的语言,创造出自己的“专属语言”吗?比如,如果提到‘the’ 5次,那么就是我想要复制这一术语5次。这和人类创造的缩写其实也没有多大的差别。其他的AI开发者也注意到了智能体会使用“缩写”来简化沟通。在Open AI,研究者成功地让AI机器人学会自己创造的语言。

如果AI继续创建自己的语言,开发人员可能会在创建和采用新的神经网络时遇到问题,但是不清楚这是否会让机器实际上推翻其研发者。然而,这些新的发展使得AI能够更有效地工作,并且如果他们在工作中学习新的AI创建的“缩写”,并保持最新的这种新的沟通方式,可以使研究团队长期受益。

这一研究体现出两个方面的问题,一个是智能体可能已经可以为了提高沟通效率而开发出自身能够理解的专属语言,而这个转速语言还可能是建立在使用常见的英文单词的基础上,这就造成一个后果:你能看懂所有单词,但是你不知道具体是什么意思,比如大家对“·”和“-”这两个字符都不会陌生,但是对下面的句子可能就无从下手了:

.. .-.. --- ...- . -.-- --- ..-

其实这是莫尔斯电码,用“·”和“-”这两个字符来不断进行重新组合形成的新的沟通方式,上面那句话根据对应关系,翻译成英文的意思是:

I LOVE YOU

AI在训练过程里发明出自己的语言的案例,Facebook的AI并不是首例。此前,Google就曾发现人工智能能通过翻译工具创造自己的沟通语言。

机器或系统自己在发展过程里开发出一个属于自己系统内沟通的方式,并且不会被人类打断,自己进化和发展几十年甚至几百年,这种情况在未来是会发生的。但是短时间内还不会,Facebook的AI出现这一情况是偶然的,而且也不能证实是智能体的有效沟通行为,所以Facebook的AI这次的事故并不能代表这种未来趋势,因为它的水平还很低。

尽管如此,Facebook此前曾发表过一篇关于人工智能的研究论文,表示AI在学习了人类的谈判技巧后,他们的表现已经很像“人”。比如说,AI会假装自己对某个特定的内容感兴趣,然后在谈判的过程中假装让步,以看似“牺牲”的方式获得更大的利益空间。

在电影《赌神》中也曾有过类似的桥段,小马哥为了迷惑对手的行为侦查,提前500局在自己的对局中加了一个在有欺骗行为时转戒指的小动作,结果让对手上当。不得不说,如果AI真的学会了这中技巧,恐怕今后人类的文明真的会收到巨大的冲击。

所以现在众说纷纭,各种人工智能威胁论再次甚嚣尘上,大有《黑客帝国》来袭的征兆,幸亏Facebook的研究员及时出来辟谣:Alice和Bob其实并没发明新的语言,因为他们还是在用“i”、“balls”、“the”等英文单词沟通,只是没有了英语语法的这个激励项,创造了一种新的表达方式而已。所以最终,Facebook并不是“关掉”这个系统,而是重新设定了正确的激励,修正了机器人的行为,让机器人用标准的英文语法来进行交流,修正的原因也不是因为害怕系统失控。

其实,对于人工智能的担心是可以理解的,技术的发展在前期都是会引起恐慌的,而技术所带来的愉悦在后期都是会引起惊呼的。就像是飞机的发明,在那个时代就是个笑话,而现如今是离不了的交通工具;对原子能的恐惧在那个年代是不由分说的,但是现在呢,核能虽然有重污染、高辐射等等弊端,但是用核能来发电却也是最大程度的造福人类,一切的技术发展都将会造福人类,毕竟,技术改变世界。

人工智能尚处于摸索阶段,至于现在就开始鼓吹人工智能威胁论的人,他们比人工智能本身更可怕。

没有探索,人类现在还在树上吃香蕉呢……