揭幕计算摄影时代:iPhone 11 Pro影像系统解析(全网公开版)

资源置换合作微信 :15216685489

ZEALER 众测合作微信:282711398

公众号后台回复「众测」,第 20期众测进行中!

从过去的 iSight 到今天的 Camera System,iPhone 的相机一直在深刻影响着整个手机影像的发展和变革。在 Z-Point 的第一期节目中,王自如将带着一颗内容创作者的真心,与大家一起探索这个被首次称为“Pro”的相机系统,共同见证计算影像时代的到来。

打开 ZEALER 小程序观看本期视频

本期图文版

前言

我最早使用带拍照功能的手机,是在上高中的时候。在那个年代用手机拍照是一个绝对新鲜的事物。当时最流行的拍照手机是诺基亚 7650。虽然它只有 30 万像素,但是在学校里,那绝对是身份和地位的象征。后来我就去了香港读书、创业、做了许多手机的测评,也拍了无数的照片。但是相当长的一段时间里边我也并不知道,在那些手机上,在我按下快门的瞬间,究竟发生了什么。

直到有一天,有一个偶然的机会,我再把那些照片重新翻找出来的时候,才突然明白。原来在电光火石之间,照片就凝固了属于那个时代的很多细节,还有照片里人的各种状态。有青涩的,有开心的,也有不开心的。在当时拍这些照片的时候根本就没想那么多,但在今天重新翻看它们的时候就发现,这些照片,就是一些发生在取景器里的故事。

这些故事,有很主观的特写,也有比较客观的一些大全景。就像黑泽明的电影《罗生门》一样。不同的视角和视野,会传达不一样的情绪和状态。它们会让我想起来,当时在相机背后,按快门的那个我,究竟在思考什么。

所以今天的 iPhone 11 Pro,我们就从这一方小小的取景器开始讲起。

三摄影像系统

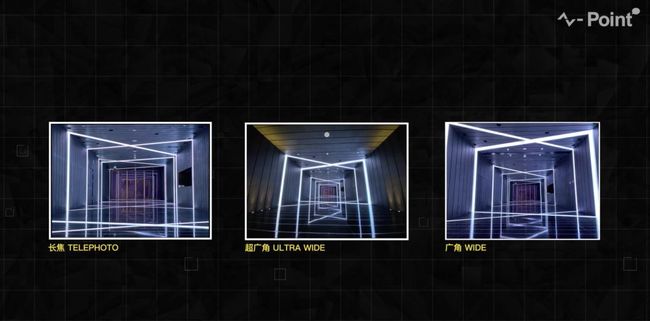

iPhone 11 Pro 取景器两侧预览「超广角」&「广角」镜头画面

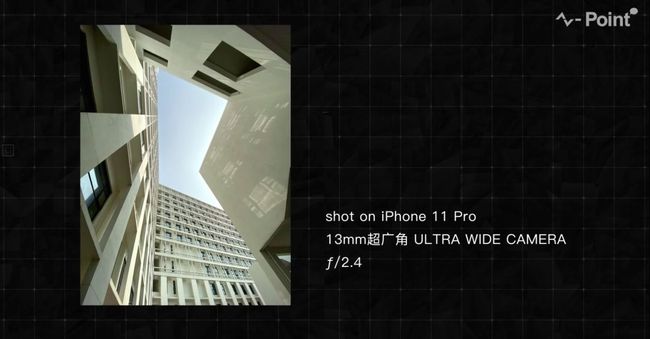

我第一次点开这个新相机的时候,它的取景器就给了我一个和前代 iPhone 完全不一样的体验。在取景器的两侧,一个更宽阔的视野呈现在屏幕上,然后我就下意识的缩放了画面,用更广的 13mm 的超广角镜头拍了一张照片。

13mm超广角 ULTRA WIDE CAMERA /2.4样张

13mm超广角 ULTRA WIDE CAMERA /2.4样张

当然,我们之前也测试过许多款手机的超广角镜头,以及它们的混合变焦功能。但这台 iPhone 的不同之处主要有三个地方。首先,它的超广角画质特别能打,尤其是紫边现象很少,比其他手机要好很多,比如说三星。

第二点,在从13mm到52mm的变焦过程中,会有两次镜头之间的切换,但是取景器里的曝光、白平衡、构图和焦点一直都比较稳定,没有出现太大的变化。最后很关键的一点是,取景器两侧的出现了更宽的视野。它会提醒我,我的创作空间到底还有多大。如果我拍摄的题材是典型的风光或者建筑,它甚至会在我按下快门的同时,保留更广的26mm或者13mm广角画面。在相册回看的时候,也会有一个LOGO,提示我这张照片有更大的后期调整的空间。当然,如果我拍摄的是特写,那么这一切就都不会发生。

保留「超广角」&「广角」画面可以有更大的后期空间

很显然,这三个不同的体验,严重的依赖三颗镜头之间的默契配合。为了保证整个变焦的过程服帖自然。三摄的视角,色温、焦点、曝光、白平衡都要高度统一。这首先限制了三摄的排布方式,任意两个镜头之间都不能有太远的距离。否则就会带来完全不同的前后景关系,不同的视角,甚至不同的构图。这些都是灾难性的问题。

其次,在硬件配置上最好的 26mm 镜头,要服务于整个相机系统,向另外两颗镜头提供正确的测光、对焦和白平衡数值。一个最直接的证据就是,当你在拍摄超广角画面时,尽管 iPhone 采用 13mm 镜头成像,但是如果遮挡了 26mm 的主摄,整个画面的测光和白平衡都会出现非常明显的问题。在用长焦拍摄时也有同样的现象。

至于苹果为什么要选择这颗广角镜头作为整个相机系统的基准。其实对比一下三颗图像传感器,大家就可以直观的看到,广角镜头传感器的感光面积最大,捕捉场景信息的能力自然也最强。

「广角」主摄像头光学传感器100% Focus Pixel显微镜照片

「广角」主摄像头光学传感器100% Focus Pixel显微镜照片

而且,只有这颗 sensor,有 100% 的相位对焦点。这些被遮盖了一半的绿色像素,两两对称,均匀地分布在整个 sensor 上边。它们负责为三颗镜头的对焦马达提供一个一致的对焦距离,保证在每一次切换镜头之前,就能提前对好焦点。

所以现在看来,等边三角形的排列,以及三摄之间的协作同步,都是非常必要的设计。它们有机的结合,共同构成了一整套融合在一起的相机系统,而不是三台不同焦段的相机。当外界都关心三摄怎么丑的问题时,我们想告诉大家,它从来都不是一个设计问题,而是一个彻底的技术问题。这样的排布是最符合计算机视觉和数学之美的方案。

我内心一直都知道这个答案,但是在产品面世之后,却很少有人与我讨论这种观点。而且我们很早的时候就在 SPY 节目里持续地测试和关注多摄系统的一致性。

iPhone Camera system白平衡一致性测试样张

iPhone Camera system白平衡一致性测试样张

但是截止到今天,真正重视它并且解决得非常好的只有 iPhone 11 Pro。它是一台更强大的取景器。我们可以用它框大,框小,表达不同的情绪,讲一些不一样的故事。

计算摄影:下一个手机影像时代

那么说到讲故事呢。其实,在多数情况下,我们拿起手机拍照,一直都是一个非常主观的动作。我们总是先看到一些场景和画面,再拿起手机,去记录那个瞬间。

52mm 长焦 TELEPHOTO CAMERA /2.0 样张

52mm 长焦 TELEPHOTO CAMERA /2.0 样张

在这个过程中,相机只是客观的记录下来所有的细节。从来没有一款相机尝试去理解这些取景框里的人和物,他们究竟有什么样的含义。这个几英寸见方的世界里发生的所有故事,相机都是不知道的,只有我们自己清楚。那么有没有一种可能,让相机用我们人类的方式,去观察和理解这个世界呢?当然有,答案就是——计算摄影。

计算摄影并不是一个新的名词。其实我们熟悉 HDR 技术,早年间的光场相机都属于计算摄影的范畴。在发布会上,Phil Schiller 在介绍 iPhone 相机的时候说:“It is computational photography mad-science.“这句话给我的印象非常深刻,因为终于有一个人站出来摇旗呐喊,告诉所有人,机器学习和计算摄影将会成为未来五到十年影像技术发展的核心战略。

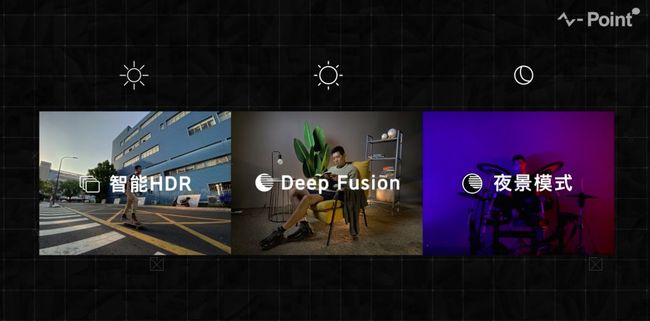

iPhone 11 Pro 上的三套曝光策略与后期算法

那么在我的 iPhone 11 Pro 上,计算摄影的部分主要由三套不同的曝光组合与后期算法组成。他们分别是智能 HDR、Deep Fusion,还有夜景模式。本质上它们都是多帧合成技术的应用。区别就在于,它们各自在不同的光照强度下完成着不同的使命。

在 600lx 以上,iPhone 11 Pro 采用智能 HDR 策略

在环境光达到 600lux 以上的时候,发挥主要作用的是智能 HDR。它会将四张正常曝光和四张帧间曝光,以及一张长曝光做简单的堆栈与合成。其实与摄影中常见的包围曝光没有太多本质的区别。那么这个堆栈合成的工作主要由 ISP 来完成。

600lx-10lx 之间,iPhone 11 Pro 采用 Deep Fusion 策略抓取更多细节

600lx-10lx 之间,iPhone 11 Pro 采用 Deep Fusion 策略抓取更多细节

而 Deep Fusion 就工作在 600lux-10lux 之间。在按下快门之前,它就会持续地采集四张正常曝光和四张中等程度曝光的照片,并把它们合为一张。同时,再与按下快门之后的一张长曝光照片做逐个像素的细节比对,保留最好的细节,淘汰掉模糊的画面和噪点。这个大量比对和选择的工作并不适合 ISP。所以这个工作主要由神经网络引擎来完成。

0.1lx(10lx以下)测试场景

iPhone 11 Pro采用更多次的曝光策略消除模糊和噪点

而在 10lux 以下,夜景模式就开始展现它的魅力。它会有更长的单帧曝光时间,当然加起来的总曝光时间也会更长。但它依然是许多帧照片在像素级别的细节对比与融合。这样做的目的是为了避免超长曝光带来的运动模糊。而且在夜景模式之下,iPhone 11 Pro 有一个非常典型的计算摄影的功能。就是会根据手机抖动的情况,去调节最大的曝光时长。这也就是我们在 Pixel 和一些安卓手机上非常熟悉的夜视模式或者说脚架模式。

Google Pixel 3 XL & iPhone 11 Pro 0.1lx场景样张对比

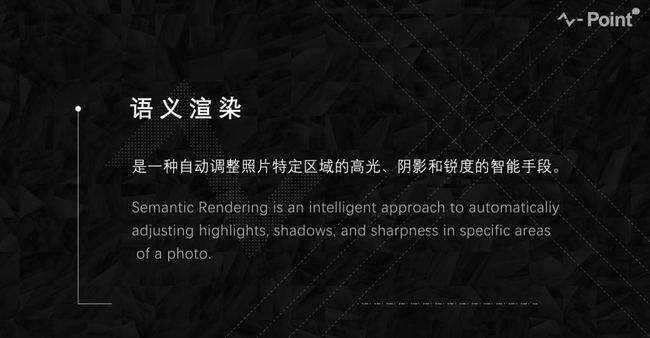

苹果通过计算摄影的方式解决了之前的 iPhone 在低光环境下的各种问题。当然,计算摄影在 iPhone 上的魅力远不止于此。很少有人注意到 Kaiann 在发布会介绍 iPhone11 的图像处理流程时,比去年多了一个全新的步骤,叫做 SEMANTIC RENDERING,语义渲染。

这反倒是让我们最兴奋最激动的细节。在我们看来,语义渲染的出现可能是一个关键性的动作。它彻底将手机影像与传统摄影划开了一道清晰的界限。可能大家现在还没法理解语义渲染到底意味着什么。我们先看一张照片,直观的感受一下语义渲染是如何工作的。

简单来讲,语义渲染其实就是在语义分割的基础之上,针对每一个识别出来的语义区域做针对性的调优。比如,它识别到人物的毛发,做针对性的锐化,让它们看起来根根分明。也会识别到天空,然后做针对性的降噪和适度的高光压制。让它看起来纯净自然,还能有细节。最有用的一点是,它在一些暗光或者侧逆光的条件下,可以对人物的脸部做适当的提亮。

iPhone 11 Pro 语义渲染对脸部的识别和提亮

我们直接对比 iPhone 拍摄的 RAW 和 jpeg 照片,就可以明显的感觉到语义渲染的功力。它不是一种画面整体的调节。而是真的知道你在拍什么的情况下,对每一个识别到的区域做精细调节。它甚至明确的知道画面中所有物体的前后景关系。所以在黑暗中或者大逆光的条件下,我还是可以拍到清晰的人脸,以及各种丰富的细节。

iPhone 11 Pro 暗光人像表现

这种体验彻底颠覆了我对计算摄影的认知。现在我每一次拿起这台手机,就已经知道,它在用和我一样的方式,去观察和记录这个世界。它有人眼一样的深度感知,也有人脑一样的图像识别和渲染。而且它不是一种未来科技或者说概念级的技术,是真的发生在每一次按下快门的时候。这种感觉就像是,这台手机在参与我的创作。

它已经不仅仅是在客观的记录了。而是在努力的还原我的视角,还原我眼中的这个主观真实的世界。我感受到的不是一种冰冷的技术,而是一种人文关怀。它会关注到你的构图中绝对的拍摄主体,还有整个取景器中最重要的一些细节,并且它还会帮你做到更好。这就是计算摄影的魅力。

A13 仿生:Camera System 真正的核心

当然,我们聊了很多软件层面的算法,还有硬件层面的配合。你以为这件事情就是说出来这么很简单么?我想说这事儿简直不要太难。可以说 iPhone11 发布之前就从来没有人彻底干成过这事儿。因为以我们的经验,采用多摄融合系统的相机,或者大规模应用机器学习和计算摄影的相机,它们都会遇到一个特别严重的问题,就是算力不够用。

我们回想一下之前的 SPY 节目,在Google Pixel 3 上只有一颗摄像头。但是要想实现全部算法,需要 845 和 Pixel Visul Core 两颗芯片的算力。另外一个典型的例子是 Nokia 9 Pureview,要同时处理五颗摄像头的数据,那么就需要一颗 845 加上一颗专用 ASIC 芯片的算力。

SPY 第四期:Google Pixel Visual Core 图像处理芯片

而且这俩手机按下快门之后也很难立刻预览照片,往往还需要经过长达五六秒钟的等待。而这一代的 iPhone 11 Pro,要整合三颗 1200 万像素的摄像头,加上这么复杂的工作机制,这么多算法合成,所需要的算力的规模几乎是无法想象的。

大家可能对这件事情没有清晰的理解。我们来盘点一下,用一台 iPhone 11 Pro 拍一张照片,它到底会经历一个什么样的过程。

首先在我们打开相机的那一刻,三摄就在同时进行连续不断的拍摄,并且保持实时的统一的参数设定,而且还要实时的计算和分析整个画面中的深度信息。

强大的 Camera system 可以在按下快门的瞬间完成大量的算法

强大的 Camera system 可以在按下快门的瞬间完成大量的算法

还在通过机器学习,实时的识别各种人和物体。同时,还要根据进光量的大小、画面里的物体运动情况、甚至手持抖动的程度,去调整连续曝光的时长。

iPhone 零快门延迟(ZSL)曝光策略

iPhone 正快门延迟(PSL)曝光策略

这个时候,每秒大几百兆的数据洪流,就会持续不断的刷新相机缓存。如果我这时按下快门,他会保存一系列不同曝光程度的照片,至少也是八张起步吧。ISP开始进行一系列的白平衡、降噪、局部色调映射的处理,神经网络引擎负责对好几张照片进行像素级别的比对和融合。

整个逻辑运算单元会统一协作,在画面当中识别一系列的人物的脸部、天空、建筑等等细节,一个区域一个区域地识别他们,并且做针对性的优化和调整。这些算法处理完成之后,才会输出最终的照片。不过我们别忘了,它还会备着一张更广的照片以防备你做任何后期调整。也就是说,刚才所有算法加在一起的运算量至少还要再翻一倍。

好,我们讲了这么多复杂的拍摄和计算过程。但其实我在用这台 iPhone 拍照的时候,基本上都是无感的。它取景器当中的预览画面,依然是所有手机当中最接近成片效果的。而且,也没有漫长的计算过程。拍完立马就可以在相册里回看。它完全不像是一个重度依赖算法的产品。

这样的拍照体验几乎是反经验反常识的。我真的很难想象,A13 芯片是如何精妙的控制三颗摄像头。它又是如何在不到一秒钟的时间里,处理这么多算法和信息的。我不禁想起了当时在发布会的现场,苹果芯片部门的副总裁 Sri 对于 A13 的那一番讲解。他讲的第一个重点其实就和相机有关。当时他讲了 CPU 上新增的两个机器学习加速器,它们的作用是提升 CPU 的矩阵运算能力。

A13 仿生芯片搭载的机器学习加速器可将矩阵运算能力提升 6 倍

这几乎就是一个指向相机系统的性能提升。因为图像处理领域的算法大部分是矩阵运算,说白了就是大学课本里的线性代数。然后 Sri 的团队就硬生生的把它的性能提升了六倍之多,每秒钟可以完成高达一万亿次的计算。我还记得当时他讲这件事情,声音有一点沙哑,但是语速超快,信息量巨大。讲到关键之处的时候,他甚至会像个孩子一样,打断观众的掌声,言语中,透露出一些急于将自己的得意之作展现给你的那种可爱。

Sri Santhanam 阐释 iPhone 迄今最快的芯片——A13仿生

他显然不像 Phil Schiller 一样八面玲珑,会和观众打情骂俏。寥寥数语讲完他的 A13,他马上就结束了自己的演讲,可以说深藏功与名。但其实在他话音未落的时候,现场就开始爆发各种掌声和欢呼。那是一种近几年的苹果发布会都很少出现的掌声。在那一瞬间,我看到了一种属于我们这群极客的浪漫。

我想,每一个使用 iPhone 11 拍照的用户,都应该感谢这个来自印度的技术宅。他被苹果雪藏了十多年,一直沉浸在集成电路的世界里。然而他却用 A13 仿生芯片支撑起了这么一个梦幻般的相机,也点燃了一群像我们一样的人。同时也再一次印证了我们之前就讲过一个观点,A13 才是这代 iPhone 相机的真正的核心。

此情此景,又让我想起了乔布斯的那句话。The only way for Apple to really differentiate and deliver something truly unique and truly great, you have to own your own silicon.(拥有了真正属于自己的芯片技术才能真正与众不同,真正独特的伟大的产品。)

结语

讲到这里,我的内心其实是很触动的。我想跳出这款产品本身。从我自身的感受出发谈一谈对这代 iPhone 相机的理解。手机影像发展到今天这么成熟,有两家企业功不可没。一家是苹果,另一家就是谷歌。看得出来它们俩在影像技术迭代的过程中,遇到了太多太多相同的困局和问题。有语义切割,有低光拍摄,还有长曝光拖影的问题等等等等。还有最最核心的算力不够的问题。

Google Pixel 手机影像系统研发测试

所以谷歌在去年的 Pixel 手机上,通过牺牲用户体验的方式,加了芯片,加了算法,去做了最大程度的技术探索,尝试着去解决这些所有的问题。最终得到的是一个完全不平衡的概念级别的产品。

Google Camera 团队负责人 Marc Levoy 接受媒体采访

没想到的是,短短一年的时间,苹果在硬件上凭借着 A13,在软件上凭借着机器学习。几乎是以一己之力硬生生的把一个探索级别概念级别的相机装在了这台新的 iPhone 上。而且除了计算压力巨大、芯片发热之外,几乎平衡掉了其他的所有的问题。尽管苹果的风格向来都很淡泊,一直都与世无争。但它突然发力的时候,我相信,所有安卓阵营的手机品牌,一定又感受到了那种熟悉的碾压级的巨大压力,还有非常漫长的需要追赶的空间。

iPhone 11 Pro 影像系统

当然,如果一定要 ZEALER 给 iPhone 11 Pro 的相机一个明确的评价。我们想说的是,今天的苹果依然可以不在意各种影像测试机构的给 iPhone 的打分和排名。它突破了传统影像的天花板,开辟了一个更高维度的计算摄影的时代,而且还把它带到了消费级的市场。在过去很长一段时间里,我们一直在用一些样张对比的方式,用各种细微的差距去衡量手机拍照的优劣。

今天的 iPhone 11 Pro 当然也是一个在技术上绝对强大的摄影工具。然而在使用的过程中,它却一再提醒我,要专注于取景器里的画面,专注于镜头里的故事,专注于我想表达的内容。这已经不仅仅是技术先进性的问题,本质上是一种思维方式的先进性。今天的科技圈,每天都充斥着各种新的技术名词,还有围绕这些名词展开的争吵。我们可能真的需要冷静下来,重新思考技术与人的关系,思考摄影的本质。

我们身边缺少的,可能从来都不是一个手机上的望远镜或者夜视仪,而是一个欣赏世界的独特视角,还有一颗愿意讲故事的心。我想,这也是长期以来,有大量的摄影师和内容创作者,如此之青睐 iPhone 的原因吧。作为同类,我们想用一句话来结束今天的视频——By innovation only,致创新。

END

华强北是一个魔幻现实主义的地方,在这片江湖上,流传着一夜暴富的美丽神话,也流传着分分钟倾家荡产的恐怖传说。在华强北这个封闭的小宇宙,在它自己的运营规则里面,每个人的上升通道在哪里?是谁,在主宰这块土地的风云变幻,又是谁,在血雨腥风中成就商业梦?更多精彩内容,尽在新一期《Z-TALK》

打开 ZEALER 小程序观看本期视频