1.先把table的engine设为MyISAM,最后改为InnoDB

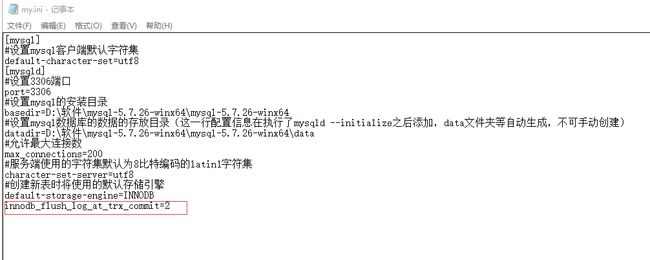

2.在mysql安装的目录下有一个文件my.ini,修改里面的innodb_flush_log_at_trx_commit参数提升insert性能

3.一次性读取整个文件,或者分批读取

4.批量insert,但是我选择了gorm,应该是不支持批量insert,不过几百万的数据上面的修改已经足够提速了。

mysql engine

mysql 的存储引擎介绍

修改参数

首先需要大致了解一下mysql日志操作步骤:

log_buff > mysql写 (write) > log_file > OS刷新 (flush) > disk

innodb_flush_log_at_trx_commit 参数解释:

0(延迟写,实时刷): log_buff -- 每隔1秒 > log_file -- 实时 > disk

1(实时写,实时刷): log_buff -- 实时 > log_file -- 实时 > disk

2(实时写,延迟刷): log_buff -- 实时 > log_file -- 每隔1秒 > disk

该参数的有效值有 0、1、2:

0:事务提交时,不将重做日志缓冲写入磁盘,而是依靠 InnoDB 的主线程每秒执行一次刷新到磁盘。因此如果 MySQL 发生宕机,那么就有可能丢失一部分事务。

1:事务提交时,会将重做日志缓冲写入磁盘,并且立即刷新(fsync())。注意,因为操作系统的“延迟写”特性,此时的刷入只是写到了操作系统的缓冲区中,因此执行同步操作才能保证一定持久化到了硬盘中。

2:事务提交时,会将重做日志缓冲写入磁盘,但是不会立即进行刷新操作,因此只是写到了操作系统的缓冲区。此时若操作系统发生宕机而没有即使的同步,也可能会丢失一部分数据。

一次性读取

我的是csv文件

fileName := "C:\\Users\\Administrator\\Desktop\\ok_geo.csv(1) (1)\\ok_geo.csv"

fs, err := os.Open(fileName)

if err != nil {

log.Fatalf("can not open the file, err is %+v", err)

}

defer fs.Close()

r := csv.NewReader(fs)

rowAll, err := r.ReadAll() //一行一行的读用r.Read()

我认为其中影响最大的应该是table的engine

package main

import (

"encoding/csv"

"fmt"

"github.com/axgle/mahonia"

_ "github.com/go-sql-driver/mysql"

"github.com/jinzhu/gorm"

"log"

"os"

"strconv"

"strings"

)

var db *gorm.DB

var d int = 0

func init() {

var err error

db, err = gorm.Open("mysql", "root:123456@/geo?charset=utf8&parseTime=True&loc=Local")

if err != nil {

panic(err)

}

}

type District struct {

Id int `gorm:"type:int(11);primary_key;"`

Province string `gorm:"type:varchar(20);not null"`

City string `gorm:"type:varchar(30)"`

District string `gorm:"type:varchar(30)"`

Geo string `gorm:"type:varchar(128);not null"`

}

type Coordinate struct {

Id int `gorm:"type:int(11);primary_key;"`

Dis_id int `gorm:"type:int(11)"`

Longitude float64 `gorm:"type:double(10,6);"`

Latitude float64 `gorm:"type:double(10,6)"`

}

func UseNewEncoder(src string) string {

srcDecoder := mahonia.NewDecoder("gbk")

desDecoder := mahonia.NewDecoder("utf-8")

resStr := srcDecoder.ConvertString(src)

_, resBytes, _ := desDecoder.Translate([]byte(resStr), true)

return string(resBytes)

}

func main() {

fileName := "C:\\Users\\Administrator\\Desktop\\ok_geo.csv(1) (1)\\ok_geo.csv"

fs, err := os.Open(fileName)

if err != nil {

log.Fatalf("can not open the file, err is %+v", err)

}

defer fs.Close()

r := csv.NewReader(fs)

rowAll, err := r.ReadAll()

for _, row := range rowAll {

id, err := strconv.Atoi(row[0])

if err != nil {

fmt.Println(err)

}

fmt.Println(id)

name := UseNewEncoder(row[1])

fmt.Println(name)

arr := strings.Split(name, " ")

if len(arr) == 3 {

Dis := &District{

Id: id,

Province: arr[0],

City: arr[1],

District: arr[2],

Geo: row[2],

}

if err := db.Create(Dis).Error; err != nil {

fmt.Println("123123", err)

}

} else if len(arr) == 2 {

Dis := &District{

Id: id,

Province: arr[0],

City: arr[1],

Geo: row[2],

}

if err := db.Create(Dis).Error; err != nil {

fmt.Println("123123", err)

}

} else {

Dis := &District{

Id: id,

Province: arr[0],

Geo: row[2],

}

if err := db.Create(Dis).Error; err != nil {

fmt.Println("123123", err)

}

}

// 分解坐标点字符串

if row[3] != "EMPTY" {

s := strings.Split(row[3], ";")

fmt.Println(s)

for i := 0; i < len(s); i++ {

if len(s[i]) > 22 {

str := strings.Split(s[i], ",")

fmt.Println("str", str)

for j := 0; j < len(str); j++ {

strr := strings.Split(str[j], " ")

lon, _ := strconv.ParseFloat(strr[0], 64)

lati, _ := strconv.ParseFloat(strr[1], 64)

Coor := &Coordinate{

Dis_id: id,

Longitude: lon,

Latitude: lati,

}

if err := db.Create(Coor).Error; err != nil {

fmt.Println(err)

} else {

d++

}

}

} else {

str := strings.Split(s[i], " ")

fmt.Println("str", str)

lon, _ := strconv.ParseFloat(str[0], 64)

lati, _ := strconv.ParseFloat(str[1], 64)

Coor := &Coordinate{

Dis_id: id,

Longitude: lon,

Latitude: lati,

}

if err := db.Create(Coor).Error; err != nil {

fmt.Println(err)

} else {

d++

}

}

}

}

}

fmt.Println("ddddddddddddddddddddddddddd", d)

}