1.注册中国大学MOOC

2.选择北京理工大学嵩天老师的《Python网络爬虫与信息提取》MOOC课程

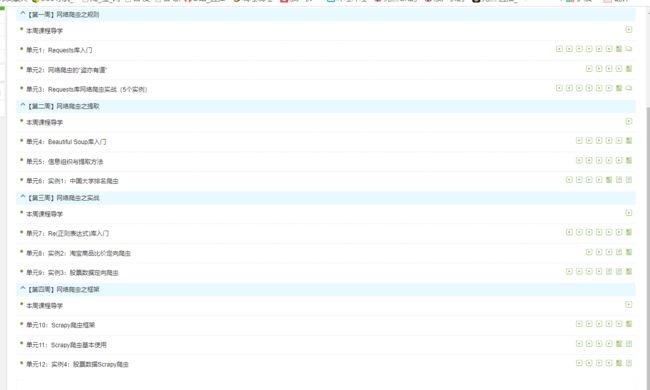

3.学习完成第0周至第4周的课程内容,并完成各周作业

4.提供图片或网站显示的学习进度,证明学习的过程。

5.写一篇不少于1000字的学习笔记,谈一下学习的体会和收获。

【第一周】网络爬虫之规则

Requests是用Python语言编写的,基于urllib3来改写的,采用Apache2 Licensed 来源协议的HTTP库。

它比urllib更加方便,可以节约我们大量的工作,完全满足HTTP测试需求。

一句话---Python实现的简单易用的HTTP库。

网络爬虫的实质,其实是从网络上“偷”数据。通过网络爬虫,我们可以采集到所需要的资源,但是同样,使用不当也可能会引发一些比较严重的问题。 因此,在使用网络爬虫时,我们需要做到“盗亦有道”。 网络爬虫主要分为以下三类: 1. 小规模,数据量小,爬取速度不敏感;对于这类网络爬虫我们可以使用Requests库来实现,主要用于爬取网页; 2. 中规模,数据规模较大,爬取速度敏感;对于这类网络爬虫我们可以使用Scrapy库来实现,主要用于爬取网站或系列网站; 3. 大规模,搜索引擎,爬取速度关键;此时需要定制开发,主要用于爬取全网,一般是建立全网搜索引擎,如百度、Google搜索等。 在这三种中,我们最为常见的是第一种,大多数均是小规模的爬取网页的爬虫。 对于网络爬虫,也有很多反对声音。因为网络爬虫会不停的向服务器发出请求,影响服务器性能,对服务器产生骚扰行为,并加大了网站维护者的工作量。 除了对服务器的骚扰外,网络爬虫也有可能引发法律风险。因为服务器上的数据有产权归属,如果将该数据用于牟利的话,将会带来法律风险。 此外,网络爬虫也可能会造成用户的隐私泄露。 简而言之,网路爬虫的风险主要归于以下三点: 对服务器的性能骚扰 内容层面的法律风险 个人隐私的泄露 因此,网络爬虫的使用需要有一定的规则。 在实际情况中,一些较大的网站都对网络爬虫进行了相关限制,整个互联网上也将网络爬虫视为可规范的功能来看待。

【第二周】网络爬虫之提取

BeautifulSoup(下文简称 bs)翻译成中文就是“美丽的汤”,这个奇特的名字来源于《爱丽丝梦游仙境》(这也是为何在其官网会配上奇怪的插图,以及用《爱丽丝》的片段作为测试文本)。bs 最大的特点我觉得是简单易用,不像正则和 xPath 需要刻意去记住很多特定语法,尽管那样会效率更高更直接。对大多数 python 使用者来说,好用会比高效更重要。这也是我自己使用并推荐 bs 的主要原因。

(1)XML(eXtensible Markup Language)可扩展标记语音

注释

(2)JSON(JavsScript Object Notation)有类型的键值对 key:value

“key” : “value”

“key” : [“value1”, “value2”]多值用[,]组织

“key” : {“subkey” : “subvalue”}键值对嵌套用{,}

(3)YAML(YAML Ain’t Markup Language)无类型键值对 key:value

缩进表达所属关系

‐ 表达并列关系

| 表达整块数据 # 表示注释

key : value

key : #Comment

‐value1

‐value2

key :

subkey : subvalue

2.比较

XML

最早的通用信息标记语言,可扩展性好,但繁琐

Internet上的信息交互与传递

JSON

信息有类型,适合程序处理(js),较XML简洁

移动应用云端和节点的信息通信,无注释

YAML

信息无类型,文本信息比例最高,可读性好

各类系统的配置文件,有注释易读

3.信息提取的一般方法

方法一:完整解析信息的标记形式,再提取关键信息

优点:信息解析准确

缺点:提取过程繁琐,速度慢

方法二:无视标记形式,直接搜索关键信息

优点:提取过程简洁,速度较快

缺点:提取结果准确性与信息内容相关

融合方法:结合形式解析与搜索方法,提取关键信息

需要标记解析器及文本查找函数

4.基于bs4库的html内容查找方法

<>.find_all(name, attrs, recursive, string, **kwargs)

返回一个列表类型,存储查找的结果

∙ name : 对标签名称的检索字符串

∙ attrs: 对标签属性值的检索字符串,可标注属性检索

∙ recursive: 是否对子孙全部检索,默认True

∙ string: <>…中字符串区域的检索字符串

soup(..) 等价于 soup.find_all(..)

扩展方法:

<>.find() 搜索且只返回一个结果,同.find_all()参数

<>.find_parents() 在先辈节点中搜索,返回列表类型,同.find_all()参数

<>.find_parent() 在先辈节点中返回一个结果,同.find()参数

<>.find_next_siblings() 在后续平行节点中搜索,返回列表类型,同.find_all()参数

<>.find_next_sibling() 在后续平行节点中返回一个结果,同.find()参数

<>.find_previous_siblings() 在前序平行节点中搜索,返回列表类型,同.find_all()参数

<>.find_previous_sibling() 在前序平行节点中返回一个结果,同.find()参数

【第三周】网络爬虫之实战

正则表达式是一个特殊的字符序列,它能帮助你方便的检查一个字符串是否与某种模式匹配。

Python 自1.5版本起增加了re 模块,它提供 Perl 风格的正则表达式模式。

re 模块使 Python 语言拥有全部的正则表达式功能。

compile 函数根据一个模式字符串和可选的标志参数生成一个正则表达式对象。该对象拥有一系列方法用于正则表达式匹配和替换。

re 模块也提供了与这些方法功能完全一致的函数,这些函数使用一个模式字符串做为它们的第一个参数。

【第四周】网络爬虫之框架

每一个网页都有一个对应的url,而url在页面上又有很多指向其他页面的url,这种url之间相互的指向关系就形成一个网,这就是互联网。通常,我们使用浏览器访问互联网,获取需要的、感兴趣的信息,但这种方式效率低下。对于批量数据的获取,网络爬虫有着天生的优势。

网络爬虫是一段自动抓取互联网信息的程序,它模仿浏览器访问互联网的过程,下载网页,然后解析得到需要的数据。此外,爬虫可以从一个url出发,访问它关联的所有url,并且从每个页面上提取我们所需要的、有价值的数据。

Python是编写爬虫程序的常用工具。Python中有多个模块使得爬虫编写非常简单,常用的模块有:urllib、requests、re、bs4、Selenium等。

1 - 通用爬虫框架

通用爬虫框架定义了编写一个网络爬虫最基本的过程。一个通用的爬虫框架通常包含待抓取的URL列表、已抓取的URL列表、URL下载器、URL解析器、数据库等几个模块。根据任务的需求,还可以加入监控模块、定时启动模块等。

通用爬虫框架的工作流程如下:

step 1、确定种子URL,并存入待抓取的URL列表;

step 2、从待抓取的URL列表中随机提取一个URL,发送到URL下载器;

step 3、URL下载器开始下载页面,如果下载成功,将页面发送给URL解析器,同时把URL存入已抓取的URL列表;如果下载失败,将URL重新存入待抓取的URL列表,重复step 2;

step 4、URL解析器开始解析页面,将获得的新的URL存入待抓取的URL列表,同时将需要的、有价值的数据存入数据库;

step 5、重复step2-4,直到待抓取的URL列表为空。

2 - Scrapy框架

Scrapy是用python下的一个互联网爬虫应用框架,它能够爬取网站并抽取结构化的数据,它也能够使用API获取数据。Scrapy框架中有很多实用的内置插件和中间件,如:cookies and session handling、user-agent spoofing、robots.txt、crawl depth restriction等,这写插件和中间件使得Scrapy框架的实用性更强。Scrapy框架的示意图如下:

Scrapy框架的工作流程:首先从初始 URL 开始,Scheduler 会将其交给 Downloader 进行下载,下载之后会交给 Spider 进行分析,Spider 分析出来的结果有两种:一种是需要进一步抓取的链接,例如“下一页”的链接,这些东西会被传回 Scheduler;另一种是需要保存的数据,它们则被送到 Item Pipeline 那里,那是对数据进行后期处理(详细分析、过滤、存储等)的地方。

3 - PySpider框架

PySpider是国人用python编写的一个功能强大的网络爬虫框架。主要特性如下:

1、强大的WebUI,包含:脚本编辑器、任务监控器,项目管理器和结果查看器;

2、多数据库支持,包括:MySQL, MongoDB, Redis, SQLite, Elasticsearch; PostgreSQL with SQLAlchemy等;

3、使用RabbitMQ, Beanstalk, Redis 和Kombu作为消息队列;

4、支持任务优先级设定、定时任务、失败后重试等;

5、支持分布式爬虫

高级操作

在上满我们了解了requests的基本用法,如基本的GET、POST请求以及Response对象,接下来,我们再来了解下request的一些高级用法,如上传文件、Cookies设置。代理设置等。