Redis Cluster在redis3.0版本以上开始支持,以ruby环境运行。他可以把多个redis实例整合在一起,形成一个集群,集群内分配slot(分片槽),实现数据的分片存放。客户端只要以集群的模式连接上集群内任意一个节点,就可以操作整个集群。

集群角色有Master和Slave。Master之间分配slots,一共16384个slot。Slave向它指定的Master同步数据,实现备份。当其中的一个Master无法提供服务时,该Master的Slave讲提升为Master,保证集群间slot的完整性。一旦其中的某一个Master和它的Slave都失效,导致了slot不完整,集群失效。

环境准备:

Redis节点:

192.168.189.144:9000

192.168.189.144:9001

192.168.189.145:8000

192.168.189.145:8001

192.168.189.146:7000

192.168.189.146:7001

在上述节点安装3.0以上的redis版本,安装完成后有redis-trib.rb文件,这个文件用于操作管理reids cluster。

选择192.168.189.144为Cluster操作机器,安装ruby环境,ruby环境要在1.8.5以上。

#rpm -ivh http://yum.puppetlabs.com/el/5/products/x86_64/puppetlabs-release-5-6.noarch.rpm #yum install ruby.x86_64 ruby-devel.x86_64 rubygems.noarch #gem install redis ---安装ruby的redis接口

集群配置:

开启每个redis的redis cluster功能,配置如下,根据实例分配端口:

#grep -v ^# redis.conf | grep -v ^$ daemonize yes pidfile /usr/local/redis_cluster/9000/var/redis.pid port 9000 tcp-backlog 511 timeout 0 tcp-keepalive 0 loglevel notice logfile "/usr/local/redis_cluster/9000/redis.log" databases 16 stop-writes-on-bgsave-error yes rdbcompression yes rdbchecksum yes dbfilename dump.rdb dir /usr/local/redis_cluster/9000/data slave-serve-stale-data yes slave-read-only yes repl-diskless-sync no repl-diskless-sync-delay 5 repl-disable-tcp-nodelay no slave-priority 100 appendonly no appendfilename "appendonly.aof" appendfsync everysec no-appendfsync-on-rewrite no auto-aof-rewrite-percentage 100 auto-aof-rewrite-min-size 64mb aof-load-truncated yes lua-time-limit 5000 cluster-enabled yes -----开启cluster cluster-config-file nodes.conf cluster-node-timeout 5000 slowlog-log-slower-than 10000 slowlog-max-len 128 latency-monitor-threshold 0 notify-keyspace-events "" hash-max-ziplist-entries 512 hash-max-ziplist-value 64 list-max-ziplist-entries 512 list-max-ziplist-value 64 set-max-intset-entries 512 zset-max-ziplist-entries 128 zset-max-ziplist-value 64 hll-sparse-max-bytes 3000 activerehashing yes client-output-buffer-limit normal 0 0 0 client-output-buffer-limit slave 256mb 64mb 60 client-output-buffer-limit pubsub 32mb 8mb 60 hz 10 aof-rewrite-incremental-fsync yes

启动所有的redis节点:

192.168.189.144:

#/usr/local/redis_cluster/9000/bin/redis-server /usr/local/redis_cluster/9000/etc/redis.conf #/usr/local/redis_cluster/9001/bin/redis-server /usr/local/redis_cluster/9001/etc/redis.conf

192.168.189.145:

#/usr/local/redis_cluster/8000/bin/redis-server /usr/local/redis_cluster/8000/etc/redis.conf #/usr/local/redis_cluster/8001/bin/redis-server /usr/local/redis_cluster/8001/etc/redis.conf

192.168.189.146:

#/usr/local/redis_cluster/7000/bin/redis-server /usr/local/redis_cluster/7000/etc/redis.conf #/usr/local/redis_cluster/7001/bin/redis-server /usr/local/redis_cluster/7001/etc/redis.conf

启动完所有节点后,查看日志,显示如下:

找不到集群配置,这是因为还没有初始化集群。

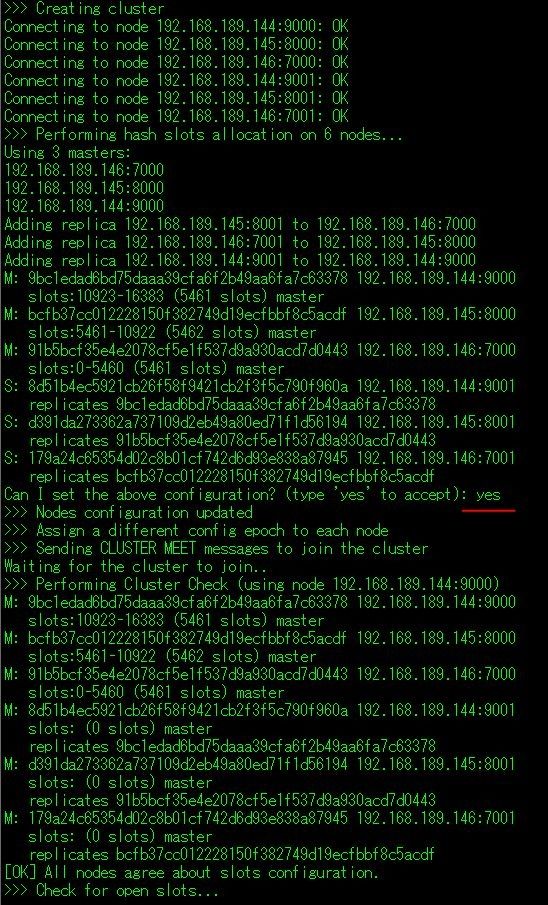

在192.168.189.144上使用redis-trib.rb工具,创建集群:

#bin/redis-trib.rb create --replicas 1 192.168.189.144:9000 192.168.189.145:8000 192.168.189.146:7000 192.168.189.144:9001 192.168.189.145:8001 192.168.189.146:7001

(--replicas 1为每个Master指定了1个Slave,Master和Slave的角色,由输入的顺序决定)

从以上创建信息可以看到,集群自动分配出了Master和各自的Slave,并在Master之间分配了slot。集群就创建成功了。

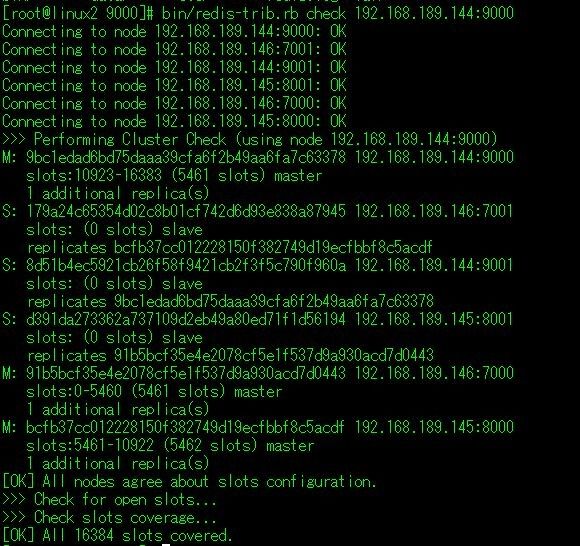

查看集群信息(随意指定集群中的一个节点):

#bin/redis-trib.rb check 192.168.189.144:9000

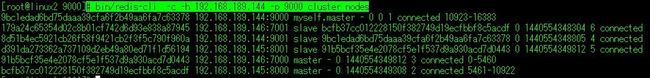

#bin/redis-cli -c -h 192.168.189.144 -p 9000 cluster nodes

以上方法都可以看到集群的状态和各节点的信息。

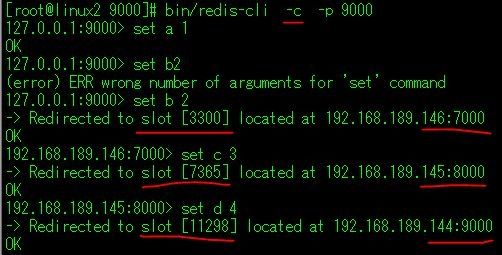

Cluster测试:

以集群的模式,使用redis客户端连上一个Master节点,插入一些数据:

可以看到,插入数据时,数据会自动插入到不同Master节点上的slot。说明实现了分片的目的,形成了集群。

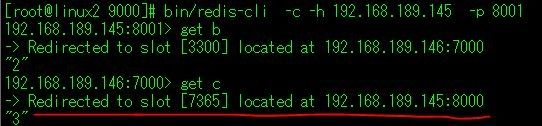

这时可以连接到集群中的另一个结点去查看之前插入的数据:

可以发现集群会自动定位到key值的位置,并跳到该redis实例去取到需要的数据。

节点的增减:

在192.168.189.144新增两个6000,6001的空实例。新增6000为集群的新的Master,6001为6000的slave。

启动新增实例:

#/usr/local/redis_cluster/6000/bin/redis-server /usr/local/redis_cluster/6000/etc/redis.conf #/usr/local/redis_cluster/6001/bin/redis-server /usr/local/redis_cluster/6001/etc/redis.conf

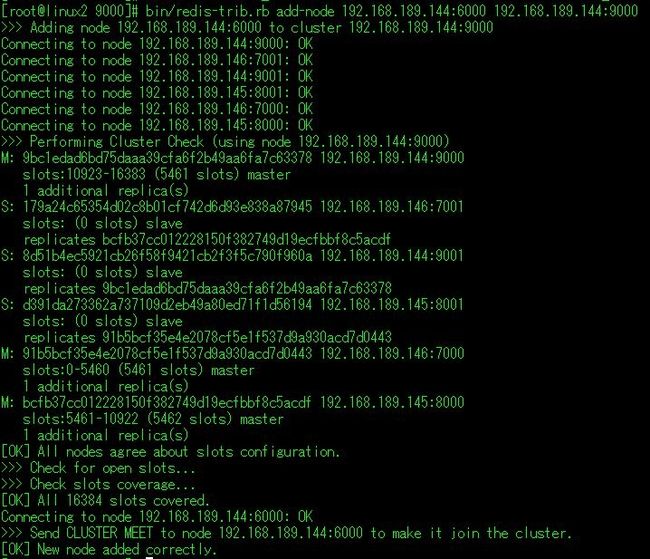

添加6000为Master节点:

#bin/redis-trib.rb add-node 192.168.189.144:6000 192.168.189.144:9000 (前面为新增的节点,后面为集群里已有的随意节点)

使用check命令查看集群状态,可以看到192.168.189.144:6000已经加入集群,角色为Master,没有分配slot,所以没有数据。

所以,需要给144:6000分配slot,使它能够存放数据。

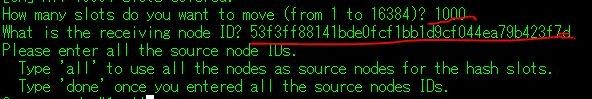

#bin/redis-trib.rb reshard 192.168.189.144:6000

这里为新的节点分配了1000个slot。此命令可也可用于在线reshard。

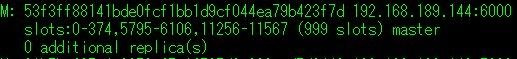

在查看144:6000的信息,就可以看到它已有的slot了,因为试验中我选择了all当作source node,所以slot是从其他的各个Master分配过来的。一共分配了1000个。

为144:6000新增slave节点:

首先,先把144:6001节点加入集群:

#bin/redis-trib.rb add-node 192.168.189.144:6001 192.168.189.144:9000

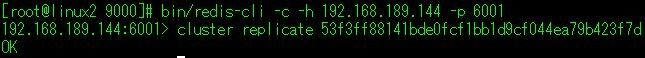

看到新增的节点,默认的角色都是Master,若想改变它的角色,需连接到该实例,为它指定Master。

(后面加上的为144:6000的node ID)

可以看到144:6001已经变成144:6000的Slave。

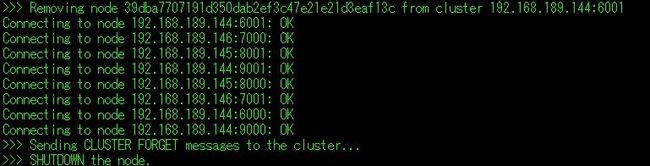

删除Slave节点:

#bin/redis-trib.rb del-node 192.168.189.144:6001 '39dba7707191d350dab2ef3c47e21e21d3eaf13c'

slave节点,144:6001删除完成。

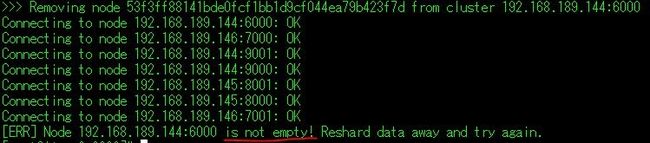

删除Master节点:

#bin/redis-trib.rb del-node 192.168.189.144:6000 '53f3ff88141bde0fcf1bb1d9cf044ea79b423f7d'

删除144:6000节点时,发现删除失败,提示说该实例不是空的。因为144:6000上还分配有slot,若删除,会导致集群slot的不完整,所以需先移除该节点上的所有slot,才能进行删除。

用reshard命令移除slot到另一个Master节点。

这时再执行删除,删除成功。

集群冗余测试:

Redis Cluster的正常状态前提是slot的完整,换句话说,只要集群的slot是完整的16384,则集群就能正常工作。

关闭一个Master:

#bin/redis-cli -h 192.168.189.146 -p 7000 shutdown

查看集群状态:

可以看到146:7000节点已经下线,它的Slave145:8001提升为Master,集群正常工作,因为slot还保持完整。

关闭145:8001:

#bin/redis-cli -h 192.168.189.145 -p 8001 shutdown

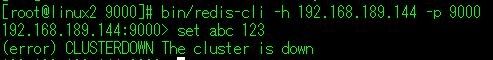

可以看到145:8001已经无法连接,且它已经没有备份了。这时集群的slot发生了不完整的情况,集群失效。

这时再尝试往集群里写数据,提示说cluster is down,即集群失效了。