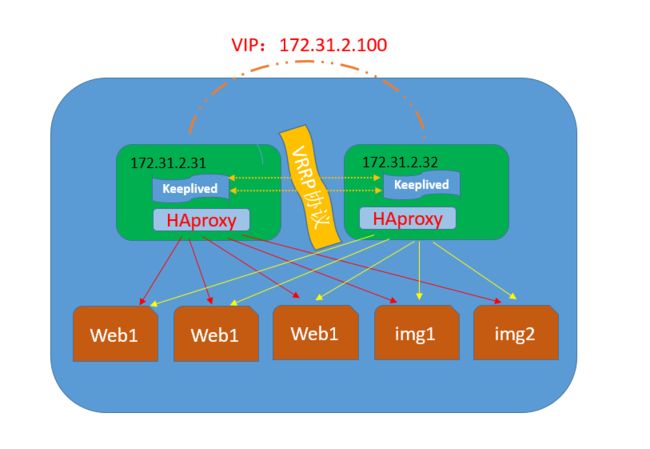

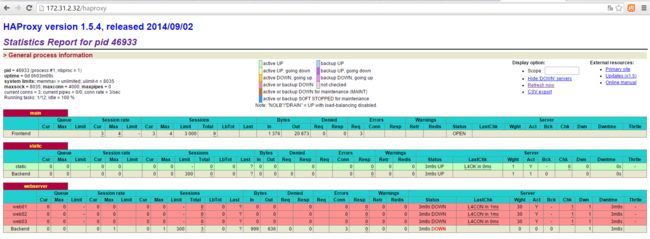

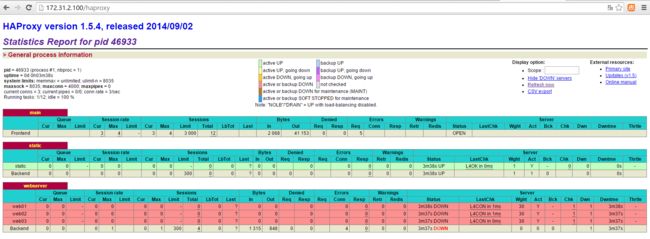

下图描述了使用keepalived+Haproxy主从配置来达到能够针对前段流量进行负载均衡到多台后端web1、web2、web3、img1、img2.但是由于haproxy会存在单点故障问题因此使用keepalived来实现对Haproxy单点问题的高可用处理。

1>keepalived原理及配置介绍

什么是Keepalived呢keepalived观其名可知保持存活在网络里面就是保持在线了也就是所谓的高可用或热备用来防止单点故障(单点故障是指一旦某一点出现故障就会导致整个系统架构的不可用)的发生Keepalived通过请求一个vip来达到请求真是IP地址的功能而VIP能够在一台机器发生故障时候自动漂移到另外一台机器上从来达到了高可用HA功能。那说到keepalived时不得不说的一个协议就是VRRP协议可以说这个协议就是keepalived实现的基础那么首先我们来看看VRRP协议。

注搞运维的要有足够的耐心不理解协议就很难透彻的掌握keepalived的了

一VRRP协议

VRRP协议

学过网络的朋友都知道网络在设计的时候必须考虑到冗余容灾包括线路冗余设备冗余等防止网络存在单点故障那在路由器或三层交换机处实现冗余就显得尤为重要在网络里面有个协议就是来做这事的这个协议就是VRRP协议Keepalived就是巧用VRRP协议来实现高可用性(HA)的

VRRP协议有一篇文章写的非常好大家可以直接看这里(记得认真看看哦后面基本都已这个为基础的了)

帖子地址http://bbs.ywlm.net/thread-790-1-1.html

只需要把服务器当作路由器即可

在《VRRP协议》里讲到了虚拟路由器的ID也就是VRID在这里比较重要

keepalived完全遵守VRRP协议包括竞选机制等等

二Keepalived原理

Keepalived原理

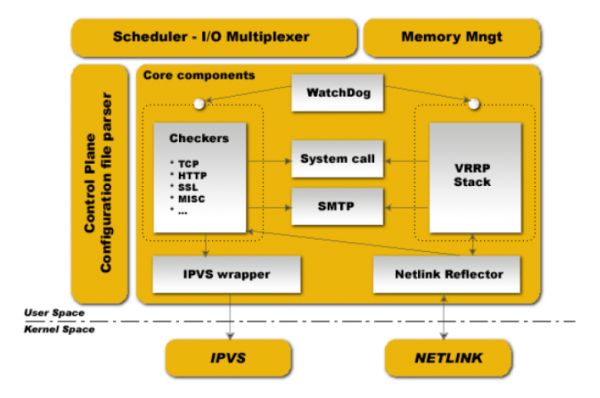

keepalived也是模块化设计不同模块复杂不同的功能下面是keepalived的组件

core check vrrp libipfwc libipvs-2.4 libipvs-2.6

core是keepalived的核心复杂主进程的启动和维护全局配置文件的加载解析等

check负责healthchecker(健康检查)包括了各种健康检查方式以及对应的配置的解析包括LVS的配置解析

vrrpVRRPD子进程VRRPD子进程就是来实现VRRP协议的

libipfwciptables(ipchains)库配置LVS会用到

libipvs*配置LVS会用到

注意keepalived和LVS完全是两码事只不过他们各负其责相互配合而已

keepalived启动后会有三个进程

父进程内存管理子进程管理等等

子进程VRRP子进程

子进程healthchecker子进程

有图可知两个子进程都被系统WatchDog看管两个子进程各自复杂自己的事healthchecker子进程复杂检查各自服务器的健康程度例如HTTPLVS等等如果healthchecker子进程检查到MASTER上服务不可用了就会通知本机上的兄弟VRRP子进程让他删除通告并且去掉虚拟IP转换为BACKUP状态

三Keepalived配置文件详解

keepalived配置详解

keepalived有三类配置区域(姑且就叫区域吧)注意不是三种配置文件是一个配置文件里面三种不同类别的配置区域

全局配置(Global Configuration)

VRRPD配置

LVS配置

一全局配置

全局配置又包括两个子配置

全局定义(global definition)

静态路由配置(static ipaddress/routes)

1全局定义(global definition)配置范例

global_defs

{

notification_email

{

}

notification_email_from [email protected]

smtp_server 127.0.0.1

stmp_connect_timeout 30

router_id node1

}

复制代码

全局配置解析

global_defs全局配置标识表面这个区域{}是全局配置

notification_email

{

}

复制代码

表示keepalived在发生诸如切换操作时需要发送email通知以及email发送给哪些邮件地址邮件地址可以多个每行一个

notification_email_from [email protected]

表示发送通知邮件时邮件源地址是谁

smtp_server 127.0.0.1

表示发送email时使用的smtp服务器地址这里可以用本地的sendmail来实现

smtp_connect_timeout 30

连接smtp连接超时时间

router_id node1

机器标识

2静态地址和路由配置范例

static_ipaddress

{

192.168.1.1/24 brd + dev eth0 scope global

192.168.1.2/24 brd + dev eth1 scope global

}

static_routes

{

src $SRC_IP to $DST_IP dev $SRC_DEVICE

src $SRC_IP to $DST_IP via $GW dev $SRC_DEVICE

}

复制代码

这里实际上和系统里面命令配置IP地址和路由一样例如

192.168.1.1/24 brd + dev eth0 scope global 相当于: ip addr add 192.168.1.1/24 brd + dev eth0 scope global

就是给eth0配置IP地址

路由同理

一般这个区域不需要配置

这里实际上就是给服务器配置真实的IP地址和路由的在复杂的环境下可能需要配置一般不会用这个来配置我们可以直接用vi /etc/sysconfig/network-script/ifcfg-eth1来配置切记这里可不是VIP哦不要搞混淆了切记切记

二VRRPD配置

VRRPD配置包括三个类

VRRP同步组(synchroization group)

VRRP实例(VRRP Instance)VRRP脚本

1VRRP同步组(synchroization group)配置范例

vrrp_sync_group VG_1 {

group {

http

mysql

}

notify_master /path/to/to_master.sh

notify_backup /path_to/to_backup.sh

notify_fault "/path/fault.sh VG_1"

notify /path/to/notify.sh

smtp_alert

}

复制代码

其中

group {

http

mysql

}

复制代码

http和mysql是实例名和下面的实例名一致

notify_master /path/to/to_master.sh表示当切换到master状态时要执行的脚本

notify_backup /path_to/to_backup.sh表示当切换到backup状态时要执行的脚本

notify_fault "/path/fault.sh VG_1"

复制代码

notify /path/to/notify.sh

smtp alter表示切换时给global defs中定义的邮件地址发送右键通知

2VRRP实例(instance)配置范例

vrrp_instance http {

state MASTER

interface eth0

dont_track_primary

track_interface {

eth0

eth1

}

mcast_src_ip

garp_master_delay 10

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

autp_pass 1234

}

virtual_ipaddress {

#

/ brd dev scope label 192.168.200.17/24 dev eth1

192.168.200.18/24 dev eth2 label eth2:1

}

virtual_routes {

# src

[to] / via|gw dev scope tab src 192.168.100.1 to 192.168.109.0/24 via 192.168.200.254 dev eth1

192.168.110.0/24 via 192.168.200.254 dev eth1

192.168.111.0/24 dev eth2

192.168.112.0/24 via 192.168.100.254

}

nopreempt

preemtp_delay 300

debug

}

复制代码

statestate指定instance(Initial)的初始状态就是说在配置好后这台服务器的初始状态就是这里指定的但这里指定的不算还是得要通过竞选通过优先级来确定里如果这里设置为master但如若他的优先级不及另外一台那么这台在发送通告时会发送自己的优先级另外一台发现优先级不如自己的高那么他会就回抢占为master

interface实例绑定的网卡因为在配置虚拟IP的时候必须是在已有的网卡上添加的

dont track primary忽略VRRP的interface错误

track interface跟踪接口设置额外的监控里面任意一块网卡出现问题都会进入故障(FAULT)状态例如用nginx做均衡器的时候内网必须正常工作如果内网出问题了这个均衡器也就无法运作了所以必须对内外网同时做健康检查

mcast src ip发送多播数据包时的源IP地址这里注意了这里实际上就是在那个地址上发送VRRP通告这个非常重要一定要选择稳定的网卡端口来发送这里相当于heartbeat的心跳端口如果没有设置那么就用默认的绑定的网卡的IP也就是interface指定的IP地址

garp master delay在切换到master状态后延迟进行免费的ARP(gratuitous ARP)请求

virtual router id这里设置VRID这里非常重要相同的VRID为一个组他将决定多播的MAC地址

priority 100设置本节点的优先级优先级高的为master

advert int检查间隔默认为1秒

virtual ipaddress这里设置的就是VIP也就是虚拟IP地址他随着state的变化而增加删除当state为master的时候就添加当state为backup的时候删除这里主要是有优先级来决定的和state设置的值没有多大关系这里可以设置多个IP地址

virtual routes原理和virtual ipaddress一样只不过这里是增加和删除路由

lvs sync daemon interfacelvs syncd绑定的网卡

authentication这里设置认证

auth type认证方式可以是PASS或AH两种认证方式

auth pass认证密码

nopreempt设置不抢占这里只能设置在state为backup的节点上而且这个节点的优先级必须别另外的高

preempt delay抢占延迟

debugdebug级别

notify master和sync group这里设置的含义一样可以单独设置例如不同的实例通知不同的管理人员http实例发给网站管理员mysql的就发邮件给DBA

3VRRP脚本

vrrp_script check_running {

script "/usr/local/bin/check_running"

interval 10

weight 10

}

vrrp_instance http {

state BACKUP

smtp_alert

interface eth0

virtual_router_id 101

priority 90

advert_int 3

authentication {

auth_type PASS

auth_pass whatever

}

virtual_ipaddress {

1.1.1.1

}

track_script {

check_running weight 20

}

}

复制代码

首先在vrrp_script区域定义脚本名字和脚本执行的间隔和脚本执行的优先级变更

vrrp_script check_running {

script "/usr/local/bin/check_running"

interval 10 #脚本执行间隔

weight 10 #脚本结果导致的优先级变更10表示优先级+10-10则表示优先级-10

}

然后在实例(vrrp_instance)里面引用有点类似脚本里面的函数引用一样先定义后引用函数名

track_script {

check_running weight 20

}

注意VRRP脚本(vrrp_script)和VRRP实例(vrrp_instance)属于同一个级别

LVS配置

如果你没有配置LVS+keepalived那么无需配置这段区域里如果你用的是nginx来代替LVS这无限配置这款这里的LVS配置是专门为keepalived+LVS集成准备的。

注意了这里LVS配置并不是指真的安装LVS然后用ipvsadm来配置他而是用keepalived的配置文件来代替ipvsadm来配置LVS这样会方便很多一个配置文件搞定这些维护方便配置方便是也

这里LVS配置也有两个配置

一个是虚拟主机组配置

一个是虚拟主机配置

1虚拟主机组配置文件详解

这个配置是可选的根据需求来配置吧这里配置主要是为了让一台realserver上的某个服务可以属于多个Virtual Server并且只做一次健康检查

virtual_server_group

# VIP port

fwmark

}

2虚拟主机配置

virtual server可以以下面三种的任意一种来配置

1. virtual server IP port

2. virtual server fwmark int

3. virtual server group string

复制代码

下面以第一种比较常用的方式来配详细解说一下

virtual_server 192.168.1.2 80 { #设置一个virtual server: VIP:Vport

delay_loop 3 # service polling的delay时间即服务轮询的时间间隔

lb_algo rr|wrr|lc|wlc|lblc|sh|dh #LVS调度算法

lb_kind NAT|DR|TUN #LVS集群模式

persistence_timeout 120 #会话保持时间秒为单位即以用户在120秒内被分配到同一个后端realserver

persistence_granularity

protocol TCP #健康检查用的是TCP还是UDP

ha_suspend #suspendhealthchecker’s activity

virtualhost

sorry_server

real_server

{

weight 1 #给每台的权重0表示失效(不知给他转发请求知道他恢复正常)默认是1

inhibit_on_failure #表示在节点失败后把他权重设置成0而不是冲IPVS中删除

notify_up

notify_down

HTTP_GET #健康检查方式

{

url { #要坚持的URL可以有多个

path / #具体路径

digest

status_code 200 #返回状态码

}

connect_port 80 #监控检查的端口

bindto

connect_timeout 3 #连接超时时间

nb_get_retry 3 #重连次数

delay_before_retry 2 #重连间隔

} # END OF HTTP_GET|SSL_GET

#下面是常用的健康检查方式健康检查方式一共有HTTP_GET|SSL_GET|TCP_CHECK|SMTP_CHECK|MISC_CHECK这些

#TCP方式

TCP_CHECK {

connect_port 80

bindto 192.168.1.1

connect_timeout 4

} # TCP_CHECK

# SMTP方式这个可以用来给邮件服务器做集群

SMTP_CHECK

host {

connect_ip

connect_port

14 KEEPALIVED

bindto

}

connect_timeout

retry

delay_before_retry

# "smtp HELO"?|·-?ê§?à"

helo_name

} #SMTP_CHECK

#MISC方式这个可以用来检查很多服务器只需要自己会些脚本即可

MISC_CHECK

{

misc_path

misc_timeout

misc_dynamic #这个就很好用了可以非常精确的来调整权重是后端每天服务器的压力都能均衡调配这个主要是通过执行的程序或脚本返回的状态代码来动态调整weight值使权重根据真实的后端压力来适当调整不过这需要有过硬的脚本功夫才行哦

#返回0健康检查没问题不修改权重

#返回1健康检查失败权重设置为0

#返回2-255健康检查没问题但是权重却要根据返回代码修改为返回码-2例如如果程序或脚本执行后返回的代码为200#那么权重这回被修改为 200-2

}

} # Realserver

} # Virtual Server

配置文件到此就讲完了下面是一份未加备注的完整配置文件

global_defs

{

notification_email

{

[email protected]

}

notification_email_from [email protected]

smtp_server 127.0.0.1

stmp_connect_timeout 30

router_id node1

}

notification_email

{

[email protected]

[email protected]

}

static_ipaddress

{

192.168.1.1/24 brd + dev eth0 scope global

192.168.1.2/24 brd + dev eth1 scope global

}

static_routes

{

src $SRC_IP to $DST_IP dev $SRC_DEVICE

src $SRC_IP to $DST_IP via $GW dev $SRC_DEVICE

}

vrrp_sync_group VG_1 {

group {

http

mysql

}

notify_master /path/to/to_master.sh

notify_backup /path_to/to_backup.sh

notify_fault "/path/fault.sh VG_1"

notify /path/to/notify.sh

smtp_alert

}

group {

http

mysql

}

vrrp_script check_running {

script "/usr/local/bin/check_running"

interval 10

weight 10

}

vrrp_instance http {

state MASTER

interface eth0

dont_track_primary

track_interface {

eth0

eth1

}

mcast_src_ip

garp_master_delay 10

virtual_router_id 51

priority 100

advert_int 1

authentication {

auth_type PASS

autp_pass 1234

}

virtual_ipaddress {

#/ brd dev scope label

注意这里仅仅是罗列并不是可用的配置文件。里面需要根据自己的时间情况稍加配置才能用。

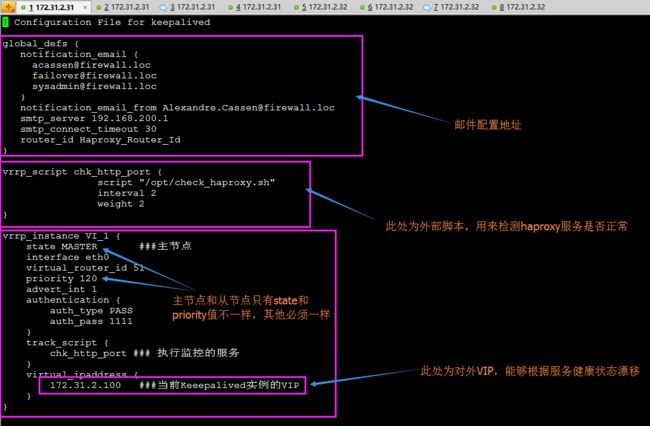

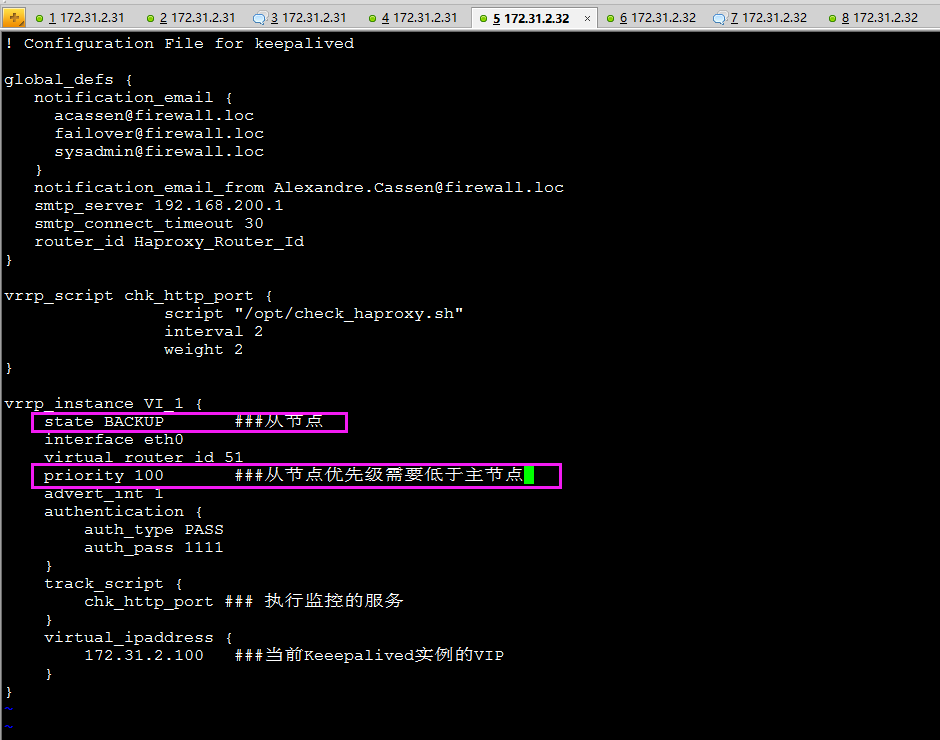

2>keepalived主从配置介绍

环境配置

172.31.2.31安装keepalived实例配置里面的VIP为172.31.2.100

172.31.2.32安装keepalived实例配置里面的VIP为172.31.2.100

注

本次实验中必须能让上述两台机器的keepalived能够通信增加相应iptables规则或者临时实验关闭iptables -F

两台机器需要时间同步简单起见都执行ntpdate cn.pool.ntp.org

keepalived的日志默认在tailf /var/log/messages

上述两台机器都需要安装keepalived

yum install keepalived -y

配置主节点172.31.2.31

vim /etc/keepalived/keepalived.conf

配置从节点172.31.2.32

vim /etc/keepalived/keepalived.conf

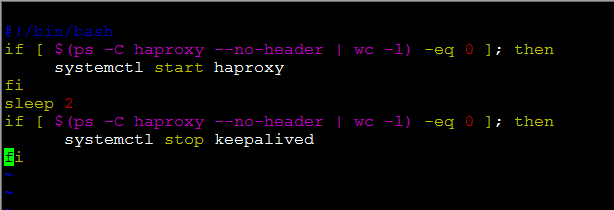

主从节点都必须有的检测haproxy服务状态的文件注该文件必须有可执行权限

vim /opt/check_haproxy.sh

解释脚本

#!/bin/bash if [ $(ps -C haproxy --no-header | wc -l) -eq 0 ]; then###判断haproxy是否已经启动 systemctl start haproxy###如果没有启动则启动haproxy程序 fi sleep 2###睡眠两秒钟等待haproxy完全启动 if [ $(ps -C haproxy --no-header | wc -l) -eq 0 ]; then###判断haproxy是否已经启动 systemctl stop keepalived###如果haproxy没有启动起来则将keepalived停掉则VIP 自动漂移到另外一台haproxy机器,实现了对haproxy的高可用 fi |

注有上述脚本可以看出每次启动keepalived的同时第一件事就是先启动haproxy。

接下来测试VIP漂移

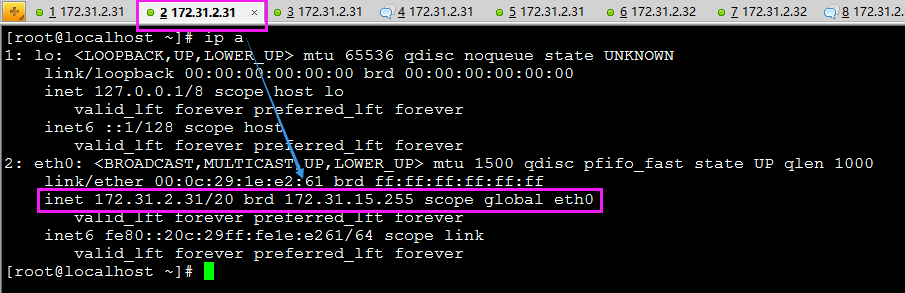

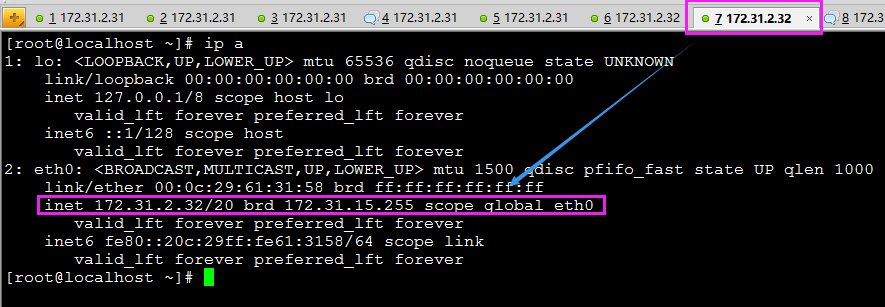

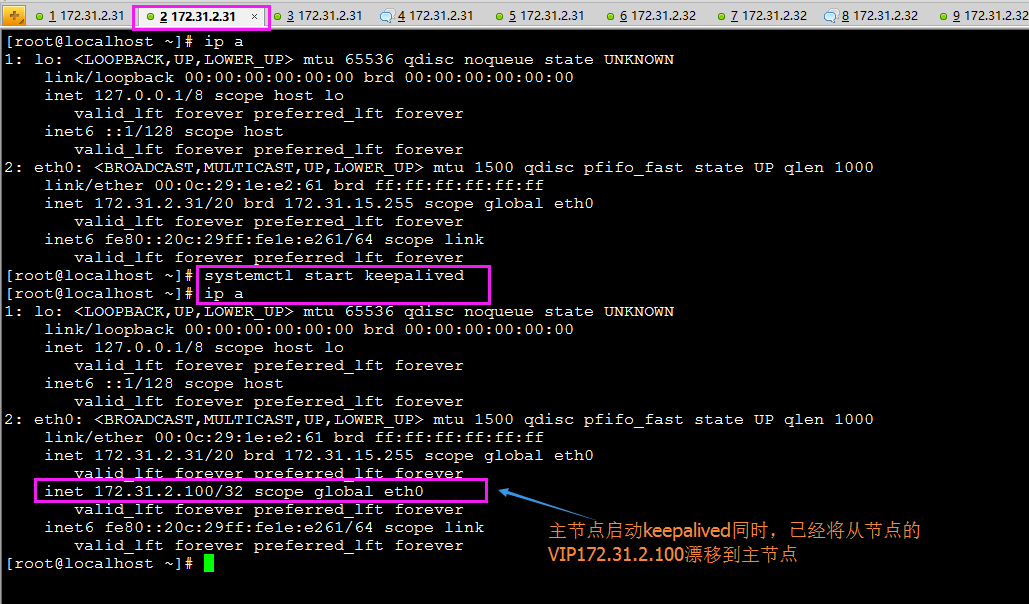

此时为初始状态即keepalived和haproxy服务都没有启动。

首先在主从节点分别查看eth0网卡情况

主节点172.31.2.31

从节点172.31.2.32

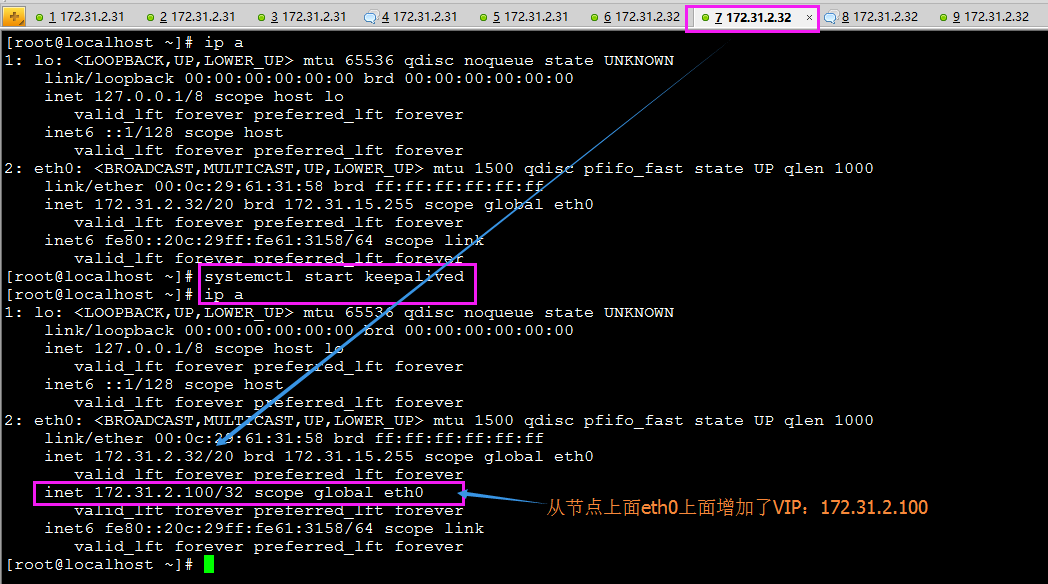

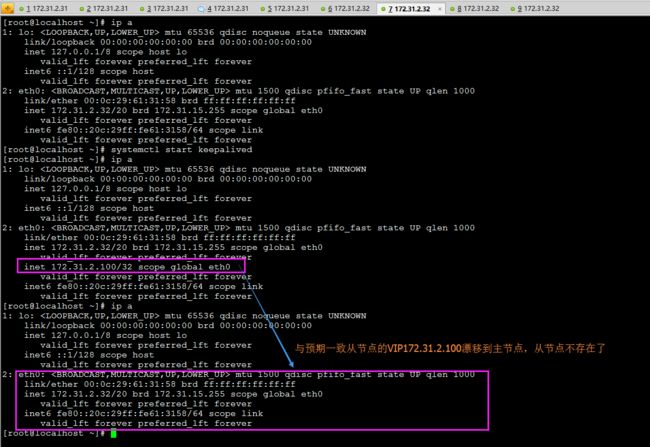

在从节点172.31.2.32上启动keepalived在查看eth0网卡在启动keepalived的同时首先会将haproxy启动

这样我们可以通过请求172.31.2.100来达到直接访问172.31.2.32的目的因为172.31.2.100是VIP请求VIP则会自动将之转发到172.31.2.32

上述在从节点启动keepalived完成。VIP安装预期绑定到了eth0网卡。

那么接下来实现将主节点172.31.2.31上的keepalived启动起来

预测由于172.31.2.31上配置的主节点的优先级比从节点高因此启动主节点的keepalived则从节点上面172.31.2.100的VIP应该自动删除漂移到主节点

正常推测此时从节点的VIP应该不在了