Android的多媒体框架中, stagefright其实是AwesomePlayer的代理,真正实现播放器功能的原是AwesomePlayer,Stagefright只是做了一层封装。AwesomePlayer 不管他有多神秘,说到底还是个多媒体播放器。在播放器的基本模型上,他与VCL、mplayer、ffmpeg等开源的结构是一致的。只是组织实现的方式不同。现在把播放器的基本模型总结一下,然后按照模型的各个部分来深入研究AwesomePlayer 的实现方式。

播放器大致分为4大部分:source、demux、decoder、output。

1. source:数据源,数据的来源不一定都是本地file,也有可能是网路上的各种协议例如:http、rtsp、HLS等。source的任务就是把数据源抽象出来,为下一个demux模块提供它需要的稳定的数据流。demux不用关心数据到底是从什么地方来的。

2. demux解复用:视频文件一般情况下都是把音视频的ES流交织的通过某种规则放在一起。这种规则就是容器规则。现在有很多不同的容器格式。如ts、mp4、flv、mkv、avi、rmvb等等。demux的功能就是把音视频的ES流从容器中剥离出来,然后分别送到不同的解码器中。其实音频和视频本身就是2个独立的系统。容器把它们包在了一起。但是他们都是独立解码的,所以解码之前,需要把它分别独立出来。demux就是干这活的,他为下一步decoder解码提供了数据流。

3. decoder解码:解码器——播放器的核心模块。分为音频和视频解码器。影像在录制后, 原始的音视频都是占用大量空间, 而且是冗余度较高的数据. 因此, 通常会在制作的时候就会进行某种压缩 ( 压缩技术就是将数据中的冗余信息去除数据之间的相关性 ). 这就是我们熟知的音视频编码格式, 包括MPEG1(VCD)/ MPEG2(DVD)/ MPEG4 / H.264 等等. 音视频解码器的作用就是把这些压缩了的数据还原成原始的音视频数据。当然, 编码解码过程基本上都是有损的 .解码器的作用就是把编码后的数据还原成原始数据。

4. output输出:输出部分分为音频和视频输出。解码后的音频(pcm)和视频(yuv)的原始数据需要得到音视频的output模块的支持才能真正的让人的感官系统(眼和耳)辨识到。

所以,播放器大致分成上述4部分。怎么抽象的实现这4大部分,以及找到一种合理的方式将这几部分组织并运动起来。是每个播放器不同的实现方式而已。视频处理过程中有很多都是十分耗时的,如果都放在一个大的线程空间中。用户体验的效果可想而知。所以通常都是做异步操作。AwesomePlayer是通过event事件调度来实现这些功能之间的驱动和调用的。

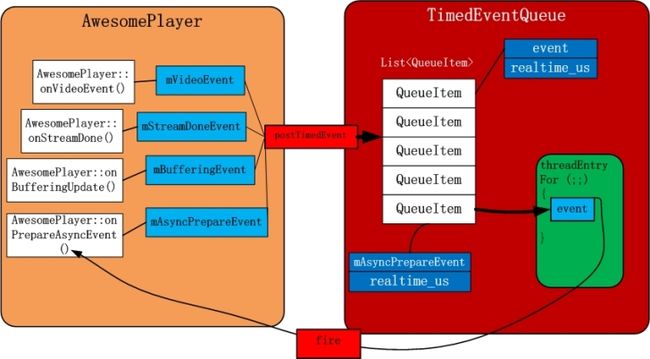

AwesomePlayer事件驱动模型

AwesomePlayer中的内部变量:

TimedEventQueue mQueue;

这个mQueue就是AwesomePlayer的事件队列,也是事件调度器。从他类型的名字上就能很清楚的看出他是以时间为基础事件队列。

- 先来看TimedEventQueue的内部结构,TimedEventQueue内部有一个 List

,每个QueueItem包含event和时间。

struct QueueItem

{

sp event;

int64_t realtime_us;

}

有一个独立线程threadEntry是在TimedEventQueue::start被创建,TimedEventQueue::stop被销毁的。

void TimedEventQueue::start() {

if (mRunning) {

return;

}

mStopped = false;

pthread_attr_t attr;

pthread_attr_init(&attr);

pthread_attr_setdetachstate(&attr, PTHREAD_CREATE_JOINABLE);

pthread_create(&mThread, &attr, ThreadWrapper, this);

pthread_attr_destroy(&attr);

mRunning = true;

}

void TimedEventQueue::stop(bool flush) {

if (!mRunning) {

return;

}

if (flush) {

postEventToBack(new StopEvent);

} else {

postTimedEvent(new StopEvent, INT64_MIN);

}

void *dummy;

pthread_join(mThread, &dummy);

mQueue.clear();

mRunning = false;

}

2.List

3.然后看看AwesomePlayer是怎么用TimedEventQueue,AwesomePlayer会定义很多类型的event事件,并把和这些事件相关的功能函数一定绑定起来。

mVideoEvent = new AwesomeEvent(this, &AwesomePlayer::onVideoEvent);

mVideoEventPending = false;

mStreamDoneEvent = new AwesomeEvent(this, &AwesomePlayer::onStreamDone);

mStreamDoneEventPending = false;

mBufferingEvent = new AwesomeEvent(this, &AwesomePlayer::onBufferingUpdate);

mBufferingEventPending = false;

mVideoLagEvent = new AwesomeEvent(this, &AwesomePlayer::onVideoLagUpdate);

mVideoEventPending = false;

mCheckAudioStatusEvent = new AwesomeEvent(this, &AwesomePlayer::onCheckAudioStatus);

原因之前也说了,因为好多音视频处理的功能是十分耗时间的,假如AwesomePlayer 想用某个功能,他并不是直线去调用它,而是抽象成一种AwesomeEvent,将想要调用的功能函数与事件捆绑。通过TimedEventQueue::postTimedEvent(),按照延时的优先顺序把它放到TimedEventQueue的队列之中。然后AwesomePlayer就不管了。TimedEventQueue start之后,自己内部的线程会从队列中依次取出这些事件,然后通过event->fire回调事件的功能函数。这样就达到了AwesomePlayer的目的。

4.之前也介绍过mediaPlayer大致流程就是

mediaPlayer.setDataSource(path);

mediaPlayer.prepare();

mediaPlayer.start();

在AwesomePlayer 中也是这种流程,在AwesomePlayer prepare()相关函数中:

status_t AwesomePlayer::prepareAsync_l() {

if (mFlags & PREPARING) {

return UNKNOWN_ERROR; // async prepare already pending

}

if (!mQueueStarted) {

mQueue.start();

mQueueStarted = true;

}

modifyFlags(PREPARING, SET);

mAsyncPrepareEvent = new AwesomeEvent(

this, &AwesomePlayer::onPrepareAsyncEvent);

mQueue.postEvent(mAsyncPrepareEvent);

return OK;

}

这里并没有实际的调用onPrepareAsyncEvent()真正的功能函数,他只是把mQueue start之后,然后创建个mAsyncPrepareEvent事件,把它插入到mQueue之中就不管了,具体调用是由mQueue中的threadEntry线程来做。

AwesomePlayer playback流程

1.通过setDataSource 指定播放器的数据源。可以是URI或者fd.可以是http:// 、rtsp://、本地地址或者本地文件描述符fd。其最终调用是将上层传递来的参数转化为DataSource,为下一步的demux提供数据支持。

2.在真正Prepare功能函数onPrepareAsyncEvent()会调用finishSetDataSource_l。通过第一步产生的DataSource来生成extractor,因为封装的格式很多,所以需要通过DataSource的信息,去创建不同的extractor。

extractor = MediaExtractor::Create( dataSource, sniffedMIME.empty() ? NULL : sniffedMIME.c_str());

......

if (!strcasecmp(mime, MEDIA_MIMETYPE_CONTAINER_MPEG4)

|| !strcasecmp(mime, "audio/mp4")) {

ret = new MPEG4Extractor(source);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_AUDIO_MPEG)) {

ret = new MP3Extractor(source, meta);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_AUDIO_AMR_NB)

|| !strcasecmp(mime, MEDIA_MIMETYPE_AUDIO_AMR_WB)) {

ret = new AMRExtractor(source);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_AUDIO_FLAC)) {

ret = new FLACExtractor(source);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_CONTAINER_WAV)) {

ret = new WAVExtractor(source);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_CONTAINER_OGG)) {

ret = new OggExtractor(source);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_CONTAINER_MATROSKA)) {

ret = new MatroskaExtractor(source);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_CONTAINER_MPEG2TS)) {

ret = new MPEG2TSExtractor(source);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_CONTAINER_WVM)) {

// Return now. WVExtractor should not have the DrmFlag set in the block below.

return new WVMExtractor(source);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_AUDIO_AAC_ADTS)) {

ret = new AACExtractor(source, meta);

} else if (!strcasecmp(mime, MEDIA_MIMETYPE_CONTAINER_MPEG2PS)) {

ret = new MPEG2PSExtractor(source);

}

3.得到extractor之后,通过setVideoSource() setAudioSource()产生独立的mVideoTrack(视频)、mAudioTrack(音频)数据流,分别为音视频解码器提供有各自需要的数据流。其实extractor和mVideoTrack、mAudioTrack就组成了播放器模型中的demuxer部分。把封装格式里面的音视频流拆分出来,分别的送给音视频解码器。

4.接下来就是initVideoDecoder() initAudioDecoder(),依赖上面产生的mVideoTrack(视频)、mAudioTrack(音频)数据流,生成了mVideoSource和mAudioSource这两个音视频解码器。不同类型匹配不同的解码器。

mVideoSource = OMXCodec::Create(

mClient.interface(), mVideoTrack->getFormat(),

false, // createEncoder

mVideoTrack,

NULL, flags, USE_SURFACE_ALLOC ? mNativeWindow : NULL);

mAudioSource = OMXCodec::Create(

mClient.interface(), mAudioTrack->getFormat(),

false, // createEncoder

mAudioTrack);

}

mVideoSource、mAudioSource组成了播放器模型中的decoder部分。

Android系统中的编解码器部分用的是openmax。openmax是一套标准接口,各家硬件厂商都可以遵循这个标准来做自己的实现,发挥自己芯片特性。然后提供给Android系统来用。因为大部分的机顶盒芯片产品硬件的编解码是它的优势,可以把这种优势完全融入到Android平台中。以后手机高清视频硬解码也会是个趋势。

5.解码完之后的数据就要输出了。AwesomePlayer分别用了mVideoRenderer做视频输出、mAudioPlayer做音频输出。他们分别调用android图像和音频的相关服务。这俩部分是Android平台中十分重要的2块,以后会深入了解。

mVideoRenderer和mAudioPlayer就组成了播放器中output的部分。

综上AwesomePlayer的整体框架和流程就清晰了,其实也脱离不了DataSource、demux、decoder、output这4大部分。接下来会分别了解每个部分是怎么实现的。