1 写在前面

前段时间开始看机器学习的相关知识,PLA? break point? dvc? 或是被一堆算法的数学公式推导搞得云里雾里,我开始意识到如果只拘泥于理论部分的学习,我的兴趣早晚会被消磨殆尽,必须在学习理论知识的同时尝试使用机器学习的算法解决一些“实际”问题。一方面,让自己明白机器学习各个算法是如何解决实际问题的;另一方面,通过实际编码加深对算法本身的理解。

今天记录一个使用K-紧邻算法(kNN)解决的问题,可以说KNN是最简单的机器学习算法之一。

2 kNN原理

kNN属于监督学习(supervised learning)的范畴,因为kNN的样本数据集中的每个数据都存在标签(label),即我们知道样本集中每个数据与所属分类的对应关系。输入没有label的新数据后,将新数据的每个特征与样本集中数据对应的特征进行比较,然后算法提取样本集中与新数据特征最相似(最近邻)的前k个样本数据的label,最后选择这k个最相似数据中出现次数最多的label,作为新数据的label。

新数据与样本数据是如何比较的呢?

通常输入的一个“数据”是由多个特征数据(feature)组成的,我们把这个“数据”放到空间中,一个特征数据代表一个维度,受人脑的限制,我们无法想象多维的情景。为了方便想象,假定每个“数据”只有两个特征,那么放到空间中就是我们最熟悉的二维平面,在这个平面中两个特征可以确定一个点,新数据与样本数据之间的比较就是求两点之间的“距离”,通常使用欧式距离,以二维为例:

计算新数据与每个样本数据的距离,选取前k个距离最小的样本数据,取得这k个数据的label,最后选择这k个label中出现次数最多的label作为新数据的label。

KNN算法的代码实现

最开始需要导入两个模块:第一个是科学计算包NumPy,第二个是运算符模块(operator)。

from numpy import *

import operator

算法的核心代码:

def k_classify (inX, dataSet, labels, k):

dataSetSize = dataSet.shape[0] # 获取数据集第一维度

diffMat = tile(inX, (dataSetSize, 1)) - dataSet

sqDiffMat = diffMat ** 2

sqDistance = sqDiffMat.sum(axis=1)

distance = sqDistance ** 0.5 # 计算距离

sortedDistIndicies = distance.argsort() # 返回距离从小到大排列后数值原先的索引值(下标)

classCount = {}

for i in range(k): # 选择距离最小的k个点,并统计label

voteIlabel = labels[sortedDistIndicies[i]]

classCount[voteIlabel] = classCount.get(voteIlabel, 0) + 1

sortedClassCount = sorted(classCount.iteritems(), key=operator.itemgetter(1), reverse=True) # 按label的个数,对其降序排序

return sortedClassCount[0][0] # 返回个数最大的label

该算法函数有4个参数,inX是要测试的新数据,dataSet是训练样本集,labels是标签集,k通常取不大于20的整数。

3 构建手写识别系统

收集数据

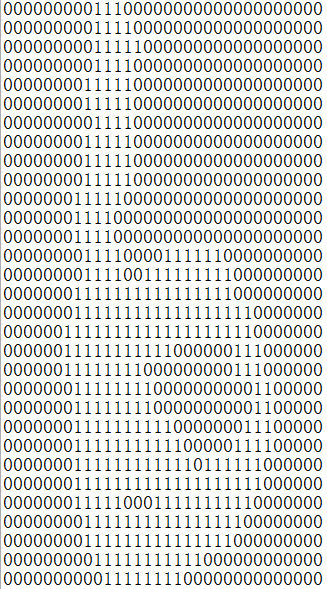

为了简单起见,这里构造的系统只能识别0到9的数字,需要识别的数字已经使用图形软件处理成了宽和高是32x32像素的黑白图像,并且将图像转换为了文本格式,如下图1所示。

数据集有两个,一个为trainningDigits文件中包含2000个例子,每个数字有200个样本,部分样本如图2所示。另一个为testDigits文件中包含大约900个测试数据。

说明:文件名格式均为a_b.txt,其中a表示该文件中图形的数字,之后将作为label使用;b为该数字的序号(不重要),相同的数字之间形状上均有不同的地方。

准备数据

需要识别的数字的文本文件有了,接下来需要将其转化为算法函数可处理的数据类型。

这里将32x32的二进制图像矩阵转换为1x1024的向量,并将其存在1x1024的NumPy数组中。

def imgVector(filename):

returnVect = zeros((1,1024))

fr = open(filename)

for i in range(32):

linestr = fr.readline() # 逐行读取

for j in range(32):

returnVect[0,32*i+j] = int(linestr[j])

return returnVect # 返回1x1024的数组

测试与运行算法

def handwritingClassTest():

hwLabels = []

trainingFileList = listdir('trainingDigits') # 读取训练集

m = len(trainingFileList)

trainingMat = zeros((m, 1024))

for i in range(m):

fileNameStr = trainingFileList[i]

fileStr = fileNameStr.split('.')[0]

classNumStr = int(fileStr.split('_')[0]) # 获取label

hwLabels.append(classNumStr) # 构建标签集

trainingMat[i,:] = imgVector('trainingDigits/%s' % fileNameStr) # 处理训练集数据

errorCount = 0.0

testFileList = listdir('testDigits') #读取测试集,进行测试

mTest = len(testFileList)

for i in range(mTest):

fileNameStr = testFileList[i]

fileStr = fileNameStr.split('.')[0]

classNumStr = int(fileStr.split('_')[0])

vectUnderTest = imgVector('testDigits/%s' % fileNameStr)

classifierResult = k_classify(vectUnderTest, trainingMat, hwLabels, 3) # 使用kNN算法

if (classifierResult != classNumStr): # 将kNN输出label与实际label对比

errorCount += 1.0

print "the total error number of error is: %d" % errorCount

print "\nthe total error rate is: %f" % (errorCount/float(mTest)) # 输出错误率

运行结果

通过使用测试集测试,在大约900个数字中有11个数字,KNN算法识别错误,正确率达98.8%,可见kNN在这个数字识别问题上的表现是不错的。

收获

通过实际编码实现kNN算法,并将其运用在一个实际例子中,让我对该算法的原理有了更深的理解。

第一次接触到了科学计算包NumPy,学习到了这个库中几个重要方法,如:zeros() shape() tile() sum(axis=*) argsort() 以及使用了python中几个方法,如:listdir() split() strip()

其实,这个算法的执行效率并不高。测试集有大约900个,所以kNN算法要执行900次,那每次的计算量多少呢?由于训练集样本有2000个,因此就需要做2000次距离计算,每个距离计算还有1024个维度浮点运算,可见计算量不小,在我电脑上大约运行了十几秒才出结果...那么有什么方法可以减少计算时间的开销呢?这个之后再说。

万事开头难...