Linux 版本

Centos 6.5

ElasticSearch + Kibana + X-Pack 版本

Elasticsearch 5.1.1 提供数据的搜索 存储

Head-plugin 5.1.1.1 方便查看es索引 数据 es基本状态

Kibana 5.1.1.1 提供ES数据提供图形化界面分析

X-Pack 5.1.1.1 提供ES集群状态监控 Kibana用户权限管理,安全,报告

Java 版本

ELK 对JDK 最低版本要求 1.8 安装Java 1.8版本

下载地址 http://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html

下载解压 配置环境变量

tar xzvf jdk-8u112-linux-x64.tar.gz

export JAVA_HOME=/data1/JDK 1.8

export PATH=$JAVA_HOME/bin:$PATH

source /etc/profile

Elasticsearch

安装

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-5.1.1.tar.gz

tar xzvf elasticsearch-5.1.1.tar.gz

配置

1.ES有执行脚本的能力,因安全因素,不能在root用户下运行,强行运行会报如下错误:

org.elasticsearch.bootstrap.StartupException: java.lang.RuntimeException: can not run elasticsearch as root

解决:配置es用户和es组

groupadd es #增加es组

useradd es -g es -p pwd #增加es用户并附加到es组 password为pwd

chown -R es:es elasticsearch-5.1.1 #给目录权限

su es #使用es用户

2.ERROR: bootstrap checks failed

max file descriptors [4096] for elasticsearch process likely too low, increase to at least [65536]

max number of threads [1024] for user [lishang] likely too low, increase to at least [2048]

解决:切换到root用户,编辑limits.conf 添加类似如下内容

vi /etc/security/limits.conf

添加如下内容:

* soft nofile 655350

* hard nofile 655350

* soft nproc 2048

* hard nproc 4096

3.max number of threads [1024] for user [lish] likely too low, increase to at least [2048]

解决:切换到root用户,进入limits.d目录下修改配置文件。

vi /etc/security/limits.d/90-nproc.conf

修改如下内容:

* soft nproc 1024

修改为

* soft nproc 2048

4.max virtual memory areas vm.max_map_count [65530] likely too low, increase to at least [262144]

解决:切换到root用户修改配置sysctl.conf

vi /etc/sysctl.conf

添加下面配置:

vm.max_map_count=655360

并执行命令:

sysctl -p

5.配置es配置文件

vim elasticsearch/config/elasticsearch.yml

cluster.name: es_cluster #集群名字

node.name: node0 #节点名字

path.data: /data1/es/data #数据存放路径

path.logs: /data1/es/logs #日志存放路劲

network.host: 10.10.10.10 #绑定主机地址

http.port: 9200 #地址端口号

discovery.zen.ping.unicast.hosts: #配置多节点,发现方式为unicast,指定master节点,方便快速定位主节点

- 10.10.10.11

- 10.10.10.12

http.cors.enabled: true #允许跨域访问 这样head插件可以访问es

http.cors.allow-origin: "*"

action.auto_create_index: .security,.monitoring*,.watches,.triggered_watches,.watcher-history* #自动建立x-pack索引

启动

bin/elasticsearch &

写入数据

1.pom文件按添加依赖

org.elasticsearch.client

transport

5.1.1

org.apache.logging.log4j

log4j-api

2.7

org.apache.logging.log4j

log4j-core

2.7

2.配置log4j2.properties文件 放在src目录下

appender.console.type = Console

appender.console.name = console

appender.console.layout.type = PatternLayout

rootLogger.level = info

rootLogger.appenderRef.console.ref = consol

3.创建ESClinet

java api 参考https://www.elastic.co/guide/en/elasticsearch/client/java-api/current/index.html

import java.net.InetAddress;

import java.net.UnknownHostException;

import org.elasticsearch.client.transport.TransportClient;

import org.elasticsearch.common.settings.Settings;

import org.elasticsearch.common.transport.InetSocketTransportAddress;

import org.elasticsearch.transport.client.PreBuiltTransportClient;

public class CreateEsClient {

public static TransportClient Client() {

// 设置集群名称

Settings settings = Settings.builder()

.put("cluster.name", "es_cluster").build();

// 创建client

TransportClient client = null;

try {

client = new PreBuiltTransportClient(settings)

.addTransportAddress(new InetSocketTransportAddress(

InetAddress.getByName("10.10.10.10"), 9300));

} catch (UnknownHostException e) {

e.printStackTrace();

}

//返回client

return client;

}

public static void main(String[] args) {

}

}

4.写入数据

import java.io.IOException;

import java.text.SimpleDateFormat;

import java.util.Date;

import org.elasticsearch.action.index.IndexResponse;

import org.elasticsearch.client.transport.TransportClient;

import static org.elasticsearch.common.xcontent.XContentFactory.*;

public class AddEsIndex {

// 文档索引

private static final String Index = "test";

public static void main(String[] args) {

// 创建客户端

TransportClient client = CreateEsClient.Client();

SimpleDateFormat Formate = new SimpleDateFormat("yyyyMMdd");

String IndexType = Formate.format(new Date(System.currentTimeMillis()));

for (int i = 0; i < 1000; i++) {

IndexResponse response;

// 写入一条数据

try {

response = client.prepareIndex(Index, IndexType)

// 创建索引和类型 id自动生成

.setSource(

jsonBuilder()

.startObject()

// 写入字段和值

.field("domain", "www.baidu.com")

.field("timestamp",

String.valueOf(System

.currentTimeMillis() / 1000))

.field("flow_size",

String.valueOf((int) (Math

.random() * 10000)))

.endObject()).get();

} catch (IOException e) {

e.printStackTrace();

break;

}

}

// 关闭客户端

client.close();

}

}

安装elasticsearch-head插件

1.安装git

yum -y install git

2.下载源码

git clone git://github.com/mobz/elasticsearch-head.git

3.安装node

由于head插件本质上还是一个nodejs的工程,因此需要安装node,使用npm来安装依赖的包,npm可以理解为maven

wget https://nodejs.org/dist/v4.2.2/node-v4.2.2-linux-x64.tar.gz

4.解压node

tar xf node-v4.2.2-linux-x64.tar.gz

5.配置node环境变量

export NODE_HOME=/data1/node

export PATH=$NODE_HOME/bin:$PATH

source /etc/profile

6.测试node是否生效

node -v

npm -v

7.安装grunt

grunt是一个很方便的构建工具,可以进行打包压缩、测试、执行等等的工作,5.1.1里的head插件就是通过grunt启动的。因此需要安装一下

npm install grunt-cli

8.检查安装是否成功

grunt -version

9.修改服务器监听地址

vim elasticsearch-head/Gruntfile.js

connect: {

server: {

options: {

port: 9100,

hostname: '*',

base: '.',

keepalive: true

}

}

}

增加hostname属性设置为*

10.修改head的连接地址:

vim elasticsearch-head/_site/app.js

this.base_uri = this.config.base_uri || this.prefs.get("app-base_uri") || "http://localhost:9200";

把localhost修改成你es的服务器地址,如:

this.base_uri = this.config.base_uri || this.prefs.get("app-base_uri") || "http://10.10.10.10:9200";

11.运行head, 在head目录中,执行npm install

npm install

12.启动nodejs

grunt server

13.访问target:9100

http://10.10.10.10:9100

Kibana安装

安装

wget https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-5.1.1.tar.gz

tar xzvf kibana-5.1.1-linux-x86_64.tar.gz

配置

vim kibana/config/kibana.yml

server.port: 5601

server.host: "0.0.0.0"

elasticsearch.url: "http://10.10.10.10:9200"

启动

./bin/kibana &

访问地址http://10.10.10.10:5601

配置Index

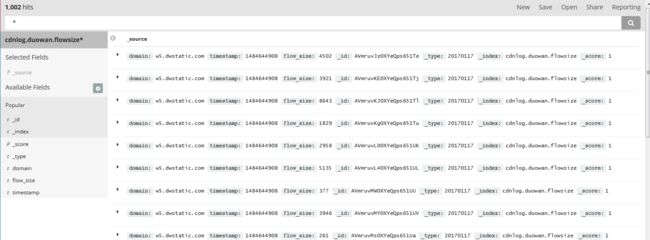

查看Discover 发现数据

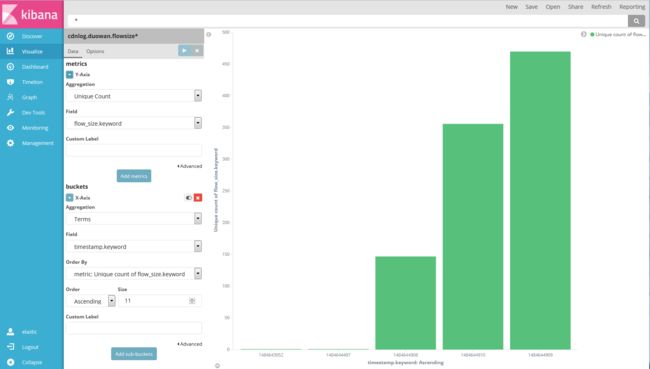

可视化数据Visualize

保存图形数据 Dashboard

安装X-PACK

Elasticsearch下载X-Pack

1.在Es的根目录(每个节点),运行

bin/elasticsearch-plugin

2.如果你在Elasticsearch已禁用自动索引的创建,在elasticsearch.yml配置action.auto_create_index允许X-pack创造以下指标:

action.auto_create_index: .security,.monitoring*,.watches,.triggered_watches,.watcher-history*

3.运行Elasticsearch

bin/elastucsearch

Kibana下载X-Pack

1.在Kibana根目录运行 bin/kibana-plugin 进行安装,安装过程会比较久,耐心等待

bin/kibana-plugin install x-pack

2.运行Kibana

bin/kibana

验证X-Pack

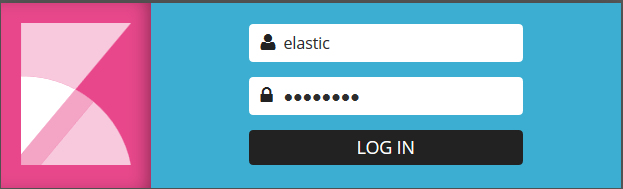

在浏览器上输入如下, 可以打开Kibana,此时需要输入用户名和密码登录,默认分别是 elastic 和 changeme

http://10.10.10.10:5601/