在开发高并发系统时有三把利器用来保护系统:缓存、降级和限流

- 缓存 缓存的目的是提升系统访问速度和增大系统处理容量

- 降级 降级是当服务出现问题或者影响到核心流程时,需要暂时屏蔽掉,待高峰或者问题解决后再打开

- 限流的目的是通过对并发访问/请求进行限速,或者对一个时间窗口内的请求进行限速来保护系统,一旦达到限制速率则可以拒绝服务、排队或等待、降级等处理

常用的限流算法有两种:漏桶算法和令牌桶算法

漏桶算法思路很简单,水(请求)先进入到漏桶里,漏桶以一定的速度出水,当水流入速度过大会直接溢出,可以看出漏桶算法能强行限制数据的传输速率。

可见这里有两个变量,一个是桶的大小,支持流量突发增多时可以存多少的水(burst),另一个是水桶漏洞的大小(rate),伪代码如下:

double rate; // leak rate in calls/s

double burst; // bucket size in calls

long refreshTime; // time for last water refresh

double water; // water count at refreshTime

refreshWater() {

long now = getTimeOfDay();

//水随着时间流逝,不断流走,最多就流干到0.

water = max(0, water- (now - refreshTime)*rate);

refreshTime = now;

}

bool permissionGranted() {

refreshWater();

if (water < burst) { // 水桶还没满,继续加1

water ++;

return true;

} else {

return false;

}

}

因为漏桶的漏出速率是固定的参数,所以,即使网络中不存在资源冲突(没有发生拥塞),漏桶算法也不能使流突发(burst)到端口速率.因此,漏桶算法对于存在突发特性的流量来说缺乏效率.

对于很多应用场景来说,除了要求能够限制数据的平均传输速率外,还要求允许某种程度的突发传输。这时候漏桶算法可能就不合适了,令牌桶算法更为适合。

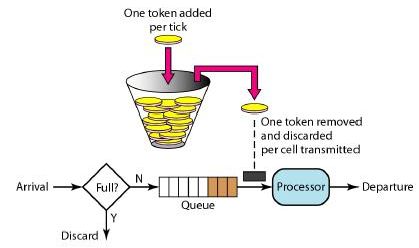

令牌桶算法(Token Bucket)和 Leaky Bucket 效果一样但方向相反的算法,更加容易理解.随着时间流逝,系统会按恒定1/QPS时间间隔(如果QPS=100,则间隔是10ms)往桶里加入Token(想象和漏洞漏水相反,有个水龙头在不断的加水),如果桶已经满了就不再加了.新请求来临时,会各自拿走一个Token,如果没有Token可拿了就阻塞或者拒绝服务.

令牌桶的另外一个好处是可以方便的改变速度. 一旦需要提高速率,则按需提高放入桶中的令牌的速率. 一般会定时(比如100毫秒)往桶中增加一定数量的令牌, 有些变种算法则实时的计算应该增加的令牌的数量.

信号量

操作系统的信号量是个很重要的概念,Java 并发库 的Semaphore 可以很轻松完成信号量控制,Semaphore可以控制某个资源可被同时访问的个数,通过 acquire() 获取一个许可,如果没有就等待,而 release() 释放一个许可。

信号量的本质是控制某个资源可被同时访问的个数,在一定程度上可以控制某资源的访问频率,但不能精确控制。

@Test

fun semaphoreTest() {

val semaphore = Semaphore(2)

(1..10).map {

thread(true) {

semaphore.acquire()

println("$it\t${Date()}")

Thread.sleep(1000)

semaphore.release()

}

}.forEach { it.join() }

}

以上示例,创建信号量,指定并发数为2,其输出如下

1 Wed Jan 17 10:31:49 CST 2018

2 Wed Jan 17 10:31:49 CST 2018

3 Wed Jan 17 10:31:50 CST 2018

4 Wed Jan 17 10:31:50 CST 2018

5 Wed Jan 17 10:31:51 CST 2018

6 Wed Jan 17 10:31:51 CST 2018

7 Wed Jan 17 10:31:52 CST 2018

8 Wed Jan 17 10:31:52 CST 2018

9 Wed Jan 17 10:31:53 CST 2018

10 Wed Jan 17 10:31:53 CST 2018

可以很清楚的看到,同一时刻最多只能有2个线程进行输出。

虽然信号量可以在一定程度上控制资源的访问频率,却不能精确控制。

RateLimiter

Google开源工具包Guava提供了限流工具类RateLimiter,该类基于令牌桶算法实现流量限制,使用十分方便。

public void testAcquire() {

RateLimiter limiter = RateLimiter.create(1);

for(int i = 1; i < 10; i = i + 2 ) {

double waitTime = limiter.acquire(i);

System.out.println("cutTime=" + System.currentTimeMillis() + " acq:" + i + " waitTime:" + waitTime);

}

}

输出:

cutTime=1535439657427 acq:1 waitTime:0.0

cutTime=1535439658431 acq:3 waitTime:0.997045

cutTime=1535439661429 acq:5 waitTime:2.993028

cutTime=1535439666426 acq:7 waitTime:4.995625

cutTime=1535439673426 acq:9 waitTime:6.999223

首先通过RateLimiter.create(1);创建一个限流器,参数代表每秒生成的令牌数,通过limiter.acquire(i);来以阻塞的方式获取令牌,当然也可以通过tryAcquire(int permits, long timeout, TimeUnit unit)来设置等待超时时间的方式获取令牌,如果超timeout为0,则代表非阻塞,获取不到立即返回。

从输出结果可以看出,RateLimiter具有预消费的能力:

acq 1时并没有任何等待直接预消费了1个令牌

acq 3时,由于之前预消费了1个令牌,故而等待了1秒,之后又预消费了3个令牌

acq 5时同理,由于之前预消费了3个令牌,故而等待了3秒

再来看个例子:

import com.google.common.util.concurrent.RateLimiter;

import java.util.concurrent.CountDownLatch;

import java.util.concurrent.ExecutorService;

import java.util.concurrent.Executors;

public class RateLimiterExample {

public static void main(String[] args) throws InterruptedException {

// qps设置为5,代表一秒钟只允许处理五个并发请求

RateLimiter rateLimiter = RateLimiter.create(5);

ExecutorService executorService = Executors.newFixedThreadPool(5);

int nTasks = 10;

CountDownLatch countDownLatch = new CountDownLatch(nTasks);

long start = System.currentTimeMillis();

for (int i = 0; i < nTasks; i++) {

final int j = i;

executorService.submit(() -> {

rateLimiter.acquire(1);

try {

Thread.sleep(1000);

} catch (InterruptedException e) {

}

System.out.println(Thread.currentThread().getName() + " gets job " + j + " done");

countDownLatch.countDown();

});

}

executorService.shutdown();

countDownLatch.await();

long end = System.currentTimeMillis();

System.out.println("10 jobs gets done by 5 threads concurrently in " + (end - start) + " milliseconds");

}

}

pool-1-thread-1 gets job 0 done

pool-1-thread-2 gets job 1 done

pool-1-thread-3 gets job 2 done

pool-1-thread-4 gets job 3 done

pool-1-thread-5 gets job 4 done

pool-1-thread-6 gets job 5 done

pool-1-thread-7 gets job 6 done

pool-1-thread-8 gets job 7 done

pool-1-thread-9 gets job 8 done

pool-1-thread-10 gets job 9 done

10 jobs gets done by 5 threads concurrently in 2805 milliseconds

上面例子中我们提交10个工作任务,每个任务大概耗时1000微秒,开启10个线程,并且使用RateLimiter设置了qps为5,一秒内只允许五个并发请求被处理,虽然有10个线程,但是我们设置了qps为5,一秒之内只能有五个并发请求。我们预期的总耗时大概是2000微秒左右,结果为2805和预期的差不多。

源码解读

RateLimiter基于令牌桶算法,它的核心思想主要有:

- 响应本次请求之后,动态计算下一次可以服务的时间,如果下一次请求在这个时间之前则需要进行等待。SmoothRateLimiter 类中的 nextFreeTicketMicros 属性表示下一次可以响应的时间。例如,如果我们设置QPS为1,本次请求处理完之后,那么下一次最早的能够响应请求的时间一秒钟之后。

- RateLimiter 的子类 SmoothBursty 支持处理突发流量请求,例如,我们设置QPS为1,在十秒钟之内没有请求,那么令牌桶中会有10个(假设设置的最大令牌数大于10)空闲令牌,如果下一次请求是 acquire(20) ,则不需要等待20秒钟,因为令牌桶中已经有10个空闲的令牌。SmoothRateLimiter 类中的 storedPermits 就是用来表示当前令牌桶中的空闲令牌数。

- RateLimiter 子类 SmoothWarmingUp 不同于 SmoothBursty ,它存在一个“热身”的概念。它将 storedPermits 分成两个区间值:[0, thresholdPermits) 和 [thresholdPermits, maxPermits]。当请求进来时,如果当前系统处于"cold"的状态,从 [thresholdPermits, maxPermits] 区间去拿令牌,所需要等待的时间会长于从区间 [0, thresholdPermits) 拿相同令牌所需要等待的时间。当请求增多,storedPermits 减少到 thresholdPermits 以下时,此时拿令牌所需要等待的时间趋于稳定。这也就是所谓“热身”的过程。

RateLimiter主要的类的类图如下所示:

RateLimiter 是一个抽象类,SmoothRateLimiter 继承自 RateLimiter,不过 SmoothRateLimiter 仍然是一个抽象类,SmoothBursty 和 SmoothWarmingUp 才是具体的实现类。

Guava有两种限流模式,一种为稳定模式(SmoothBursty:令牌生成速度恒定),一种为渐进模式(SmoothWarmingUp:令牌生成速度缓慢提升直到维持在一个稳定值)

两种模式实现思路类似,主要区别在等待时间的计算上,本篇重点介绍SmoothBursty

在调用create接口时,实际实例化的为SmoothBursty类

public static RateLimiter create(double permitsPerSecond) {

return create(permitsPerSecond, SleepingStopwatch.createFromSystemTimer());

}

static RateLimiter create(double permitsPerSecond, SleepingStopwatch stopwatch) {

RateLimiter rateLimiter = new SmoothBursty(stopwatch, 1.0 /* maxBurstSeconds */);

rateLimiter.setRate(permitsPerSecond);

return rateLimiter;

}

在解析SmoothBursty原理前,重点解释下SmoothBursty中几个属性的含义

/**

* The currently stored permits.

* 当前存储令牌数

*/

double storedPermits;

/**

* The maximum number of stored permits.

* 最大存储令牌数

*/

double maxPermits;

/**

* The interval between two unit requests, at our stable rate. E.g., a stable rate of 5 permits

* per second has a stable interval of 200ms.

* 添加令牌时间间隔

*/

double stableIntervalMicros;

/**

* The time when the next request (no matter its size) will be granted. After granting a request,

* this is pushed further in the future. Large requests push this further than small requests.

* 下一次请求可以获取令牌的起始时间

* 由于RateLimiter允许预消费,上次请求预消费令牌后

* 下次请求需要等待相应的时间到nextFreeTicketMicros时刻才可以获取令牌

*/

private long nextFreeTicketMicros = 0L; // could be either in the past or future

storedPermits 表明当前令牌桶中有多少令牌。maxPermits 表示令牌桶最大令牌数目,storedPermits 的取值范围为:[0, maxPermits]。stableIntervalMicros 等于 1/qps,它代表系统在稳定期间,两次请求之间间隔的微秒数。例如:如果我们设置的 qps 为5,则 stableIntervalMicros 为200ms。nextFreeTicketMicros 表示系统处理完当前请求后,下一次请求被许可的最短微秒数,如果在这之前有请求进来,则必须等待。

当我们设置了 qps 之后,需要计算某一段时间系统能够生成的令牌数目,那么怎么计算呢?一种方式是开启一个后台任务去做,但是这样代价未免有点大。RateLimiter 中采取的是惰性计算方式:在每次请求进来的时候先去计算上次请求和本次请求之间应该生成多少个令牌。

接下来介绍几个关键函数

/**

* Updates {@code storedPermits} and {@code nextFreeTicketMicros} based on the current time.

*/

void resync(long nowMicros) {

// if nextFreeTicket is in the past, resync to now

if (nowMicros > nextFreeTicketMicros) {

double newPermits = (nowMicros - nextFreeTicketMicros) / coolDownIntervalMicros();

storedPermits = min(maxPermits, storedPermits + newPermits);

nextFreeTicketMicros = nowMicros;

}

}

根据令牌桶算法,桶中的令牌是持续生成存放的,有请求时需要先从桶中拿到令牌才能开始执行,谁来持续生成令牌存放呢?

一种解法是,开启一个定时任务,由定时任务持续生成令牌。这样的问题在于会极大的消耗系统资源,如,某接口需要分别对每个用户做访问频率限制,假设系统中存在6W用户,则至多需要开启6W个定时任务来维持每个桶中的令牌数,这样的开销是巨大的。

另一种解法则是延迟计算,如上resync函数。该函数会在每次获取令牌之前调用,其实现思路为,若当前时间晚于nextFreeTicketMicros,则计算该段时间内可以生成多少令牌,将生成的令牌加入令牌桶中并更新数据。这样一来,只需要在获取令牌时计算一次即可。

final long reserveEarliestAvailable(int requiredPermits, long nowMicros) {

resync(nowMicros);

long returnValue = nextFreeTicketMicros; // 返回的是上次计算的nextFreeTicketMicros

double storedPermitsToSpend = min(requiredPermits, this.storedPermits); // 可以消费的令牌数

double freshPermits = requiredPermits - storedPermitsToSpend; // 还需要的令牌数

long waitMicros =

storedPermitsToWaitTime(this.storedPermits, storedPermitsToSpend)

+ (long) (freshPermits * stableIntervalMicros); // 根据freshPermits计算需要等待的时间

this.nextFreeTicketMicros = LongMath.saturatedAdd(nextFreeTicketMicros, waitMicros); // 本次计算的nextFreeTicketMicros不返回

this.storedPermits -= storedPermitsToSpend;

return returnValue;

}

该函数用于获取requiredPermits个令牌,并返回需要等待到的时间点

其中,storedPermitsToSpend为桶中可以消费的令牌数,freshPermits为还需要的(需要补充的)令牌数,根据该值计算需要等待的时间,追加并更新到nextFreeTicketMicros

需要注意的是,该函数的返回是更新前的(上次请求计算的)nextFreeTicketMicros,而不是本次更新的nextFreeTicketMicros,通俗来讲,本次请求需要为上次请求的预消费行为埋单,这也是RateLimiter可以预消费(处理突发)的原理所在。若需要禁止预消费,则修改此处返回更新后的nextFreeTicketMicros值。

回头来看SmoothBursty的构造函数

SmoothBursty(SleepingStopwatch stopwatch, double maxBurstSeconds) {

super(stopwatch);

this.maxBurstSeconds = maxBurstSeconds; // 最大存储maxBurstSeconds秒生成的令牌

}

@Override

void doSetRate(double permitsPerSecond, double stableIntervalMicros) {

double oldMaxPermits = this.maxPermits;

maxPermits = maxBurstSeconds * permitsPerSecond; // 计算最大存储令牌数

if (oldMaxPermits == Double.POSITIVE_INFINITY) {

// if we don't special-case this, we would get storedPermits == NaN, below

storedPermits = maxPermits;

} else {

storedPermits =

(oldMaxPermits == 0.0)

? 0.0 // initial state

: storedPermits * maxPermits / oldMaxPermits;

}

}

桶中可存放的最大令牌数由maxBurstSeconds计算而来,其含义为最大存储maxBurstSeconds秒生成的令牌。

该参数的作用在于,可以更为灵活地控制流量。如,某些接口限制为300次/20秒,某些接口限制为50次/45秒等。

在了解以上概念后,就非常容易理解RateLimiter暴露出来的接口

@CanIgnoreReturnValue

public double acquire() {

return acquire(1);

}

@CanIgnoreReturnValue

public double acquire(int permits) {

long microsToWait = reserve(permits);

stopwatch.sleepMicrosUninterruptibly(microsToWait);

return 1.0 * microsToWait / SECONDS.toMicros(1L);

}

final long reserve(int permits) {

checkPermits(permits);

synchronized (mutex()) {

return reserveAndGetWaitLength(permits, stopwatch.readMicros());

}

}

acquire函数主要用于获取permits个令牌,并计算需要等待多长时间,进而挂起等待,并将该值返回

public boolean tryAcquire(int permits) {

return tryAcquire(permits, 0, MICROSECONDS);

}

public boolean tryAcquire() {

return tryAcquire(1, 0, MICROSECONDS);

}

public boolean tryAcquire(int permits, long timeout, TimeUnit unit) {

long timeoutMicros = max(unit.toMicros(timeout), 0);

checkPermits(permits);

long microsToWait;

synchronized (mutex()) {

long nowMicros = stopwatch.readMicros();

if (!canAcquire(nowMicros, timeoutMicros)) {

return false;

} else {

microsToWait = reserveAndGetWaitLength(permits, nowMicros);

}

}

stopwatch.sleepMicrosUninterruptibly(microsToWait);

return true;

}

private boolean canAcquire(long nowMicros, long timeoutMicros) {

return queryEarliestAvailable(nowMicros) - timeoutMicros <= nowMicros;

}

@Override

final long queryEarliestAvailable(long nowMicros) {

return nextFreeTicketMicros;

}

tryAcquire函数可以尝试在timeout时间内获取令牌,如果可以则挂起等待相应时间并返回true,否则立即返回false

canAcquire用于判断timeout时间内是否可以获取令牌

RateLimiter设计

考虑一下RateLimiter是如何设计的,并且为什么要这样设计.

RateLimiter的主要功能就是提供一个稳定的速率,实现方式就是通过限制请求流入的速度,比如计算请求等待合适的时间阈值.

实现QPS速率的最简单的方式就是记住上一次请求的最后授权时间,然后保证1/QPS秒内不允许请求进入.比如QPS=5,如果我们保证最后一个被授权请求之后的200ms的时间内没有请求被授权,那么我们就达到了预期的速率.如果一个请求现在过来但是最后一个被授权请求是在100ms之前,那么我们就要求当前这个请求等待100ms.按照这个思路,请求15个新令牌(许可证)就需要3秒.