AVFoundation连续系列之三音频引擎

在咱们开发的时候 经常会遇到需要给咱们的声音添加音效,甚至是实时添加音效,这就用到了咱们这季所讲的内容

咱们这季讲AVAudioEngine相关的一系列音频处理

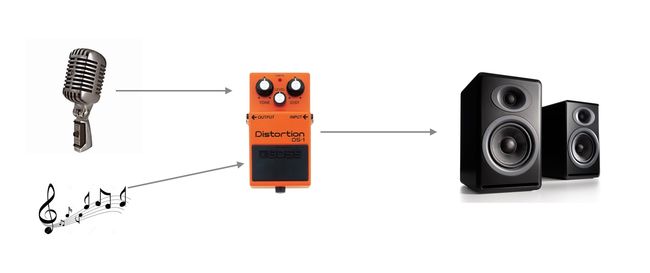

在咱们处理音频的时候,咱们需要了解一下处理音频的一个流程,如下图:

咱们处理的一个流程是 音频输入(Mic、音频)->连到效果器->效果器连到输出口(音响)。

在进行这一系列操作的时候,咱们需要使用一个统一的管理者,就是咱们的音频引擎->AVAudioEngine,还需要使用到咱们一个非常常用的元素叫做音频节点->AVAudioNode,所有的节点都必须附着到咱们的音频引擎,音频引擎按照顺序连接每一个节点,从输入到输出。

咱们先看下咱们非常重要的音频节点,音频节点又划分了几类,如下图:

咱们大概了解了一下关于AVAudioEngine执行的步骤和相关概况,咱们详细的去讲解下每一个部分。

AVAudioEngine 音频引擎

咱们的音频引擎是2014年iOS8发布的时候 一起公布的产物,所以他只支持iOS8以上,老习惯,先去看下他所有的API。

1.初始化:init()

2.附着节点的方法:funcattachNode(node:AVAudioNode)

3.分离节点:funcdetachNode(node:AVAudioNode)

4.连接节点的方法:

funcconnect(node1:AVAudioNode, to node2:AVAudioNode, fromBus bus1:AVAudioNodeBus, toBus bus2:AVAudioNodeBus, format:AVAudioFormat?)

funcconnect(node1:AVAudioNode, to node2:AVAudioNode, format:AVAudioFormat?)

funcconnect(sourceNode:AVAudioNode, toConnectionPoints destNodes: [AVAudioConnectionPoint], fromBus sourceBus:AVAudioNodeBus, format:AVAudioFormat?)

5.断开节点的方法:

funcdisconnectNodeInput(node:AVAudioNode, bus:AVAudioNodeBus)

funcdisconnectNodeInput(node:AVAudioNode)

funcdisconnectNodeOutput(node:AVAudioNode, bus:AVAudioNodeBus)

funcdisconnectNodeOutput(node:AVAudioNode)

6.暂停:funcprepare()

7.开始:funcstart()throws

8.暂停:funcpause()

9.重置所有节点:funcreset()

10.停止:funcstop()

11.获得总线上某个节点的信息:

funcinputConnectionPointForNode(node:AVAudioNode, inputBus bus:AVAudioNodeBus) ->AVAudioConnectionPoint?

funcoutputConnectionPointsForNode(node:AVAudioNode, outputBus bus:AVAudioNodeBus) -> [AVAudioConnectionPoint]

12.设置音乐序列:musicSequence

13.获得音频引擎的输出节点:varoutputNode:AVAudioOutputNode{ get }

14.获得音频引擎的输入节点:varinputNode:AVAudioInputNode? { get }

15.获得混和节点:varmainMixerNode:AVAudioMixerNode{ get }

16.获得音频引擎是否正在运行:varrunning:Bool{ get }

17.当音频引擎的配置发生改变的时候 会向使用的地方发送一个通知,这个通知的名字叫做:letAVAudioEngineConfigurationChangeNotification:String

这是所有关于音频引擎的介绍。

好啦!咱们介绍了半天,也该开始code了。

咱们先使用AVAudioEngine去录制音频流

//创建音频引擎

lazyvarengine =AVAudioEngine()

overridefuncviewDidLoad() {

super.viewDidLoad()

//获得输入端口

letinput =engine.inputNode!

//连接输入输出设置格式

engine.connect(input, to:engine.outputNode, format: input.inputFormatForBus(0))

//用于创建record/monitor/observe的输出端口

input.installTapOnBus(0, bufferSize:8192, format: input.inputFormatForBus(0)) { (AVAudioPCMBuffer, AVAudioTime)in

print("XXXXX")

print(AVAudioPCMBuffer,AVAudioTime)

}

//开启引擎

try!engine.start()

有人就会说了,我这使用AudioQueue也是可以实现的,不错!那咱们继续!

如何去实现实时录制播放的功能呢?

代码如下:

lazyvarengine =AVAudioEngine()

overridefuncviewDidLoad() {

super.viewDidLoad()

letinput =engine.inputNode!

letoutput =engine.outputNode

engine.connect(input, to: output, format: input.inputFormatForBus(0))

try!engine.start()

}

简单的几句代码搞定!

这节课呢 咱们就先玩到这!有意思的还在后面!

相关代码:

示例1:https://github.com/liuyujing/AudioEffect-NO.1.git

示例2:https://github.com/liuyujing/AudioEffect-NO.1-2.git