windows10 搭建最新的 hadoop 3.1.3 和 hbase 2.2.2 测试环境

一、环境准备

1、JDK

2、Hadoop安装包

官网 :https://archive.apache.org/dist/hadoop/common/

https://mirrors.tuna.tsinghua.edu.cn/apache/hadoop/common/hadoop-3.1.3/

https://www-eu.apache.org/dist/hadoop/common/hadoop-3.1.3/

3、hadooponwindows-master

下载地址 :https://github.com/cdarlint/winutils

https://github.com/steveloughran/winutils

选择3.1.3使用

如果不想配置和下载直接用我的文件覆盖

https://download.csdn.net/download/liutietuo/12113221

4、hbase安装包

官网 :http://archive.apache.org/dist/hbase/

http://archive.apache.org/dist/hbase/2.2.2/

二 版本对应关系

1 Hadoop与Hbase对应的版本

2 Hbase与Jdk对应的版本

三 开始安装

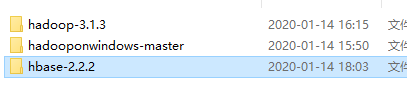

1 解压各个目录

2 设置环境变量

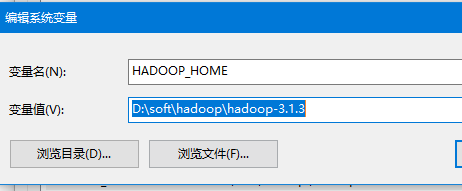

我的电脑 --> 属性 --> 高级系统设置 --> 高级 --> 环境变量,新建HADOOP_HOME,

然后将%HADOOP_HOME%\bin添加到Path中。

3 修改配置文件

如果不想配置和下载直接用我的文件覆盖

https://download.csdn.net/download/liutietuo/12113221

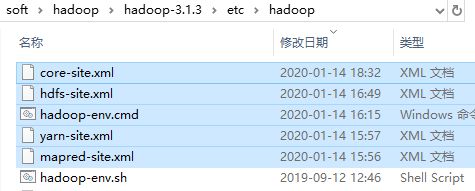

主要修改这些文件

原则上,只需要修改下面的文件地址即可.<加粗部分>. 同时如果没有文件夹,最好创建一个workplace

core-site.xml

hdfs-site.xml

yarn-site.xml

mapred-site.xml

hadoop-env.cmd

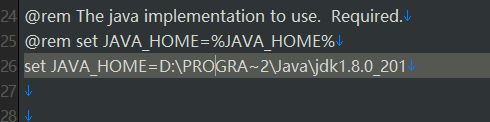

修改

@rem set JAVA_HOME=%JAVA_HOME%

set JAVA_HOME=D:\PROGRA~1\Java\jdk1.8.0_201

注意:这里PROGRA~1 有的电脑可能是PROGRA~2 .具体了解dos的8.3命名规则

4 使用winutils-master 覆盖

下载的文件包没有3.1.3 .我们使用3.1.2. 差一个版本问题不大,如果能找到匹配的最好了.

复制这些文件到

覆盖替换原文件即可

5 启动格式化HDFS

首先,hadoop version,查看是否能正常运行

执行 hdfs namenode -format

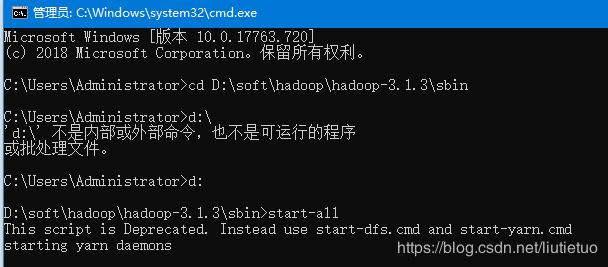

6 尝试运行hadoop

进入sbin目录 不是bin

运行 start-all

启动后没保存 表示正常

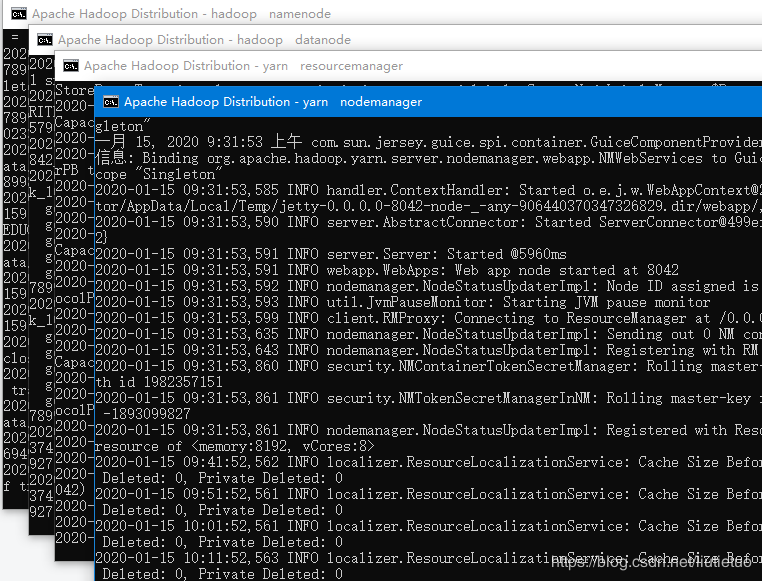

7 测试hadoop启动是否正常

进入hdfs管理页面

http://localhost:9870/

进入资源调度管理(yarn)

访问地址 :http://localhost:8088/

hadoop启动完成 我们配置hbase

四 配置hbase

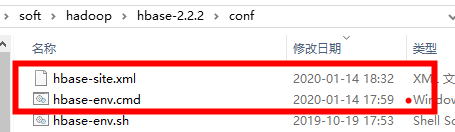

1 修改配置文件

hbase-site.xml

hbase-env.cmd

最后添加三行

set HBASE_MANAGES_ZK=false

set JAVA_HOME=D:\PROGRA~2\Java\jdk1.8.0_201

set HBASE_CLASSPATH=D:\soft\hadoop\hbase-2.2.2\conf

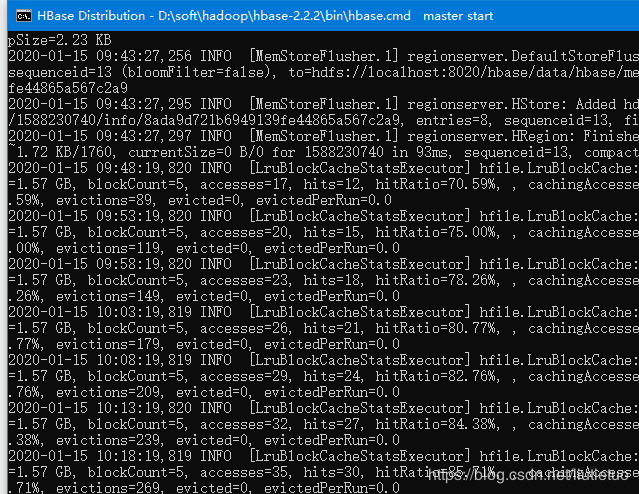

2 尝试启动

start-hbase

启动无报错

3 测试网址

http://localhost:16010/master-status

就此 配置完成

如有报错, 观察端口会不会被别的占用了. 比如iis,自己的服务等