斯坦福大学的课程 CS231n (Convolutional Neural Networks for Visual Recognition) 作为深度学习和计算机视觉方面的重要基础课程,在学界广受推崇。今年 4 月,CS231n 再度开课,全新的 CS231n Spring 2017 仍旧由李飞飞带头,带来了很多新鲜的内容。今天机器之心给大家分享的是其中的第八讲——深度学习软件(Deep Learning Software)。主要内容有:CPU 和 GPU 的对比;深度学习框架简介;TensorFlow 和 PyTorch 的实例;以及各种深度学习框架的比较。

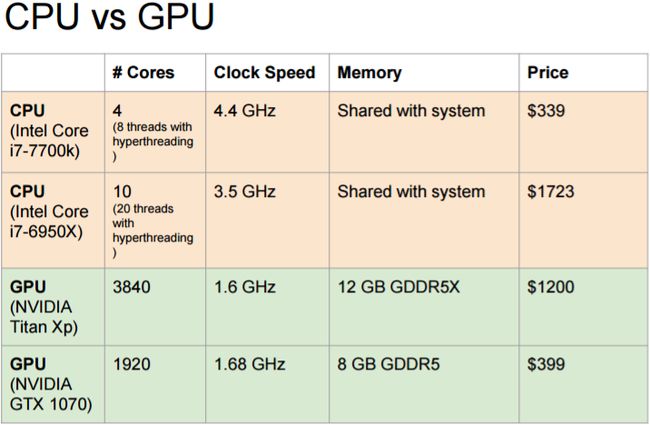

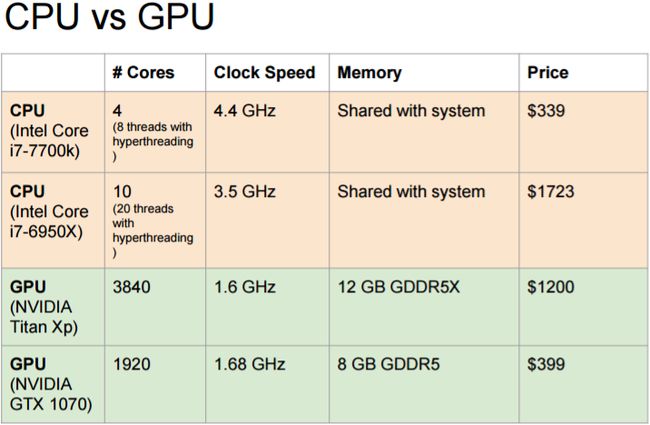

一、 CPU 和 GPU

CPU:核芯的数量更少;

但是每一个核芯的速度更快,性能更强;

更适用于处理连续性(sequential)任务。

GPU:核芯的数量更多;

但是每一个核芯的处理速度较慢;

更适用于并行(parallel)任务。

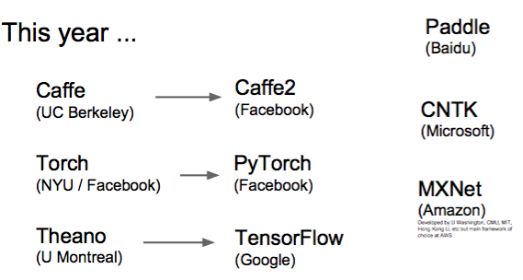

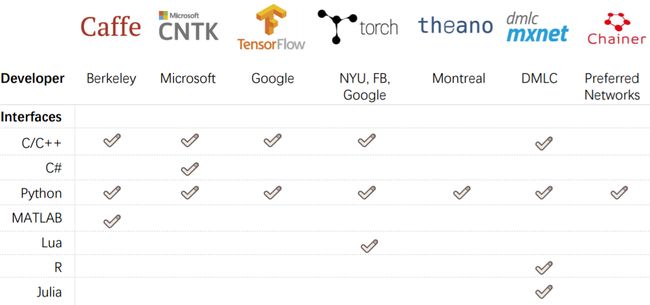

二、深度学习框架简介

去年我们还仅有 Caffe、Torch、Theano 和 TensorFlow 这些深度学习框架可供使用;但是到了今年,在此基础上我们又新增加了 Caffe2、Pytorch、TensorFlow、PaddlePaddle、 CNDK、MXNet 等等一系列新的框架,可谓「百花齐放」。如今最常用的框架当数 Pytorch 和 TensorFlow 了, 而 Caffe 和 Caffe2 次之。

深度学习框架的关键点在于:

(1)易于建造大型的计算机图形;

(2)易于在计算机图形中进行梯度计算;

(3)能在 GPU 上高效运行(cuDNN, cuBLA 等)

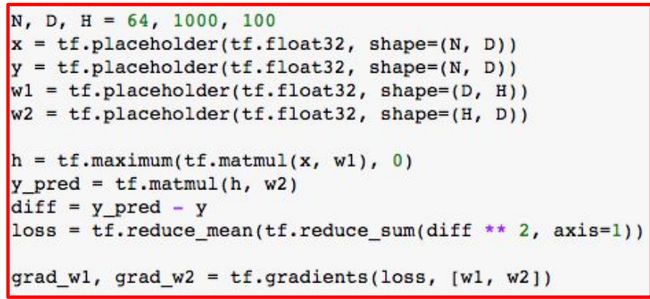

三、TensorFlow 简单实例

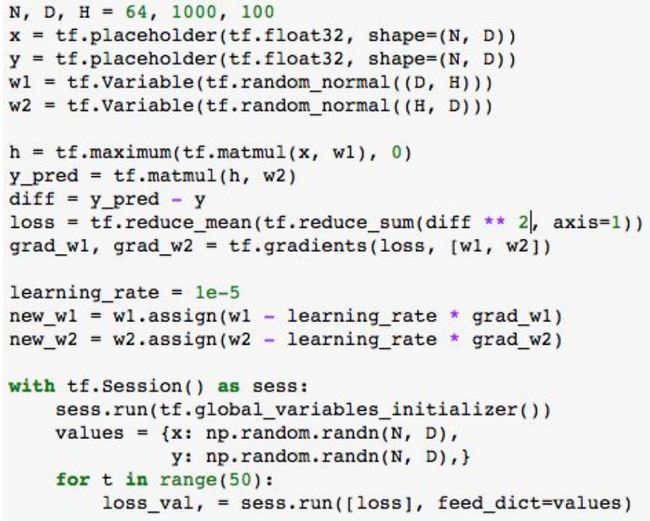

下面我们将详细说明一个在 TensorFlow 下训练神经网络的简单实例:即用随机数据训练一个两层的网络,激活函数为 ReLU。

a. 定义计算机图形

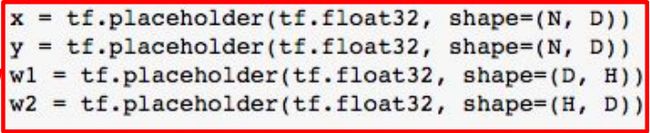

1. 为输入 x,权重系数 w1、w2, 和目标函数 y 创建 placeholder:

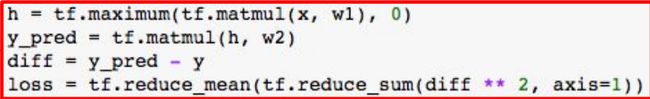

2. 定义前向传输:这是为了计算 y 的预测值和误差损失(loss);实际上这里是没有计算过程的——仅仅是为了创建图形!

3. 告诉 Tensorflow 去计算关于 w1 和 w2 的梯度损失;这里仍然不产生计算过程——仅仅是为了创建图形。

b. 运行

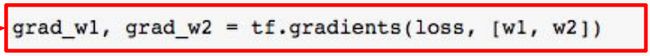

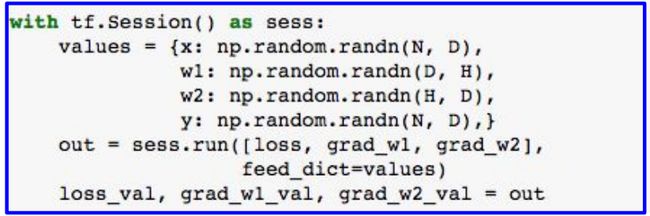

现在已经完成了创建图形的步骤,所以我们进入对图形进行运算的部分。

创建 Numpy 数组,这个数组将会被填进上方的 placeholder 中。

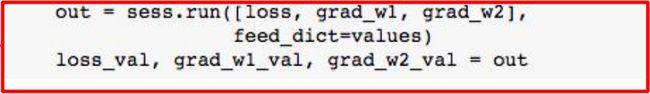

对图形进行运算:将 x、y、w1、w2 输入到 numpy 数组中;得到关于损失(loss),w1 梯度和 w2 梯度的 numpy 数组。

训练网络:反复对图形进行运算,用梯度(gradient)来更新权重(weights)。

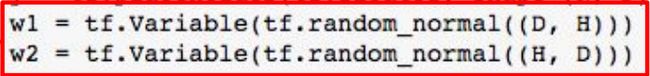

把 w1 和 w2 的相应函数从 placeholder() 改为 Variable()。

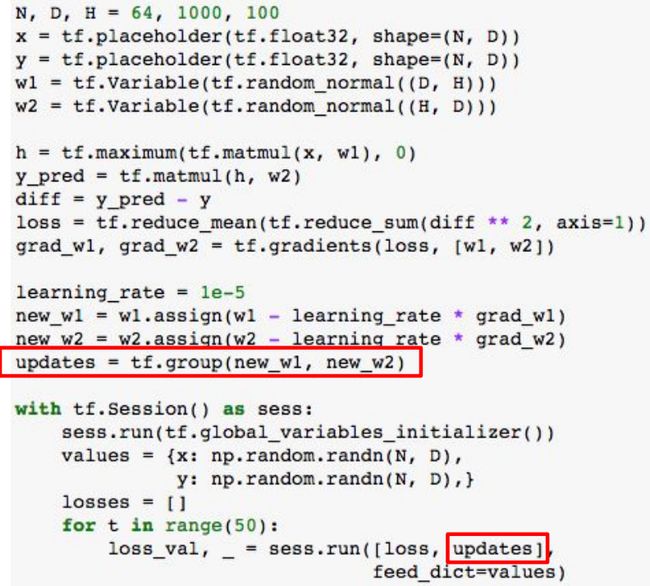

添加 assign 操作来更新 w1 和 w2(图形的一部分)。

对图形进行一次运算来初始化 w1 和 w2,然后进行多次迭代训练。

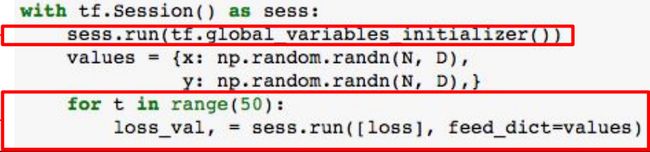

完整代码如下:

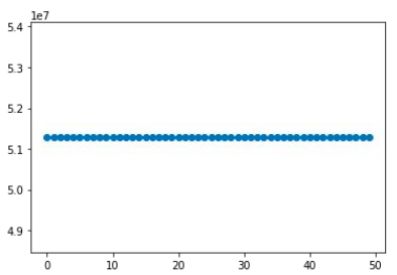

但是产生一个问题:误差损失(loss)并没有下降!这是因为 Assign 指令实际上并没有被执行。

这时我们就需要添加虚拟图形节点,并且告诉图形去计算虚拟节点。

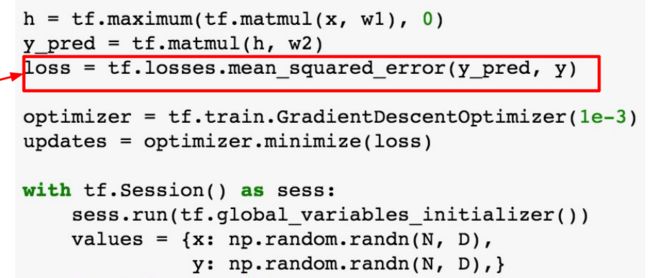

可以使用 optimizer 来计算梯度和更新权重系数;记得要执行 optimizer 的输出!

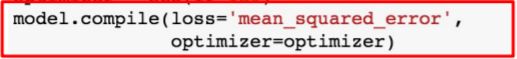

使用预先定义的常用损失函数:

使用 Xavier 进行初始化;tf.layer 会自动设置权重系数(weight)和偏置项(bias)!

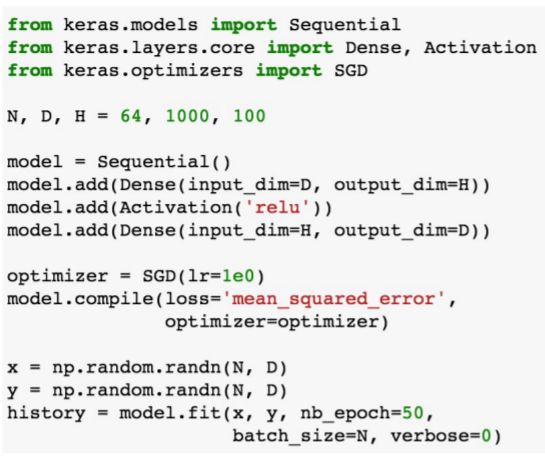

c. 高级 Wrapper——Keras

Keras 可以理解为是一个在 TensorFlow 顶部的 layer,它可以让一些工作变得更加简单(也支持 Theano 后端)。

把模型目标定义成一系列的 layer :

定义优化器目标(optimizer object):

创建模型,明确规定损失函数(loss function):

仅用一行代码就能训练模型!

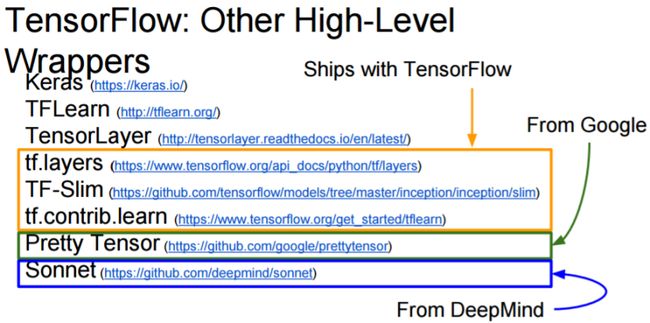

除了 Keras, 还有一些其他类型的高级容器(Wrapper)可供使用:

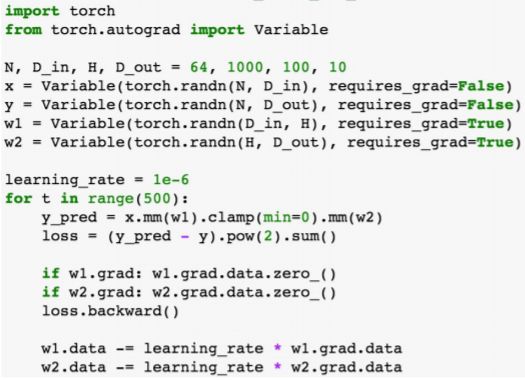

四、PyTorch 实例

PyTorch 是 Facebook 推出的深度学习框架,不论是在工业界还是学术界,它都得到了广泛的应用。它包括三个等级的抽象概念:

- 张量(Tensor):命令式的多维数组对象(ndarray),在 GPU 上运行;

- 变量(Varaible):计算型图形(computational graph)的节点;用于存储数据和梯度(gradient)

- 模块(Module):代表一个神经网络层;可以存储状态(state), 也可以存储可学习的权重系数(learnable weights)

PyTorch 和 TensorFlow 中抽象概念的等价对应关系:

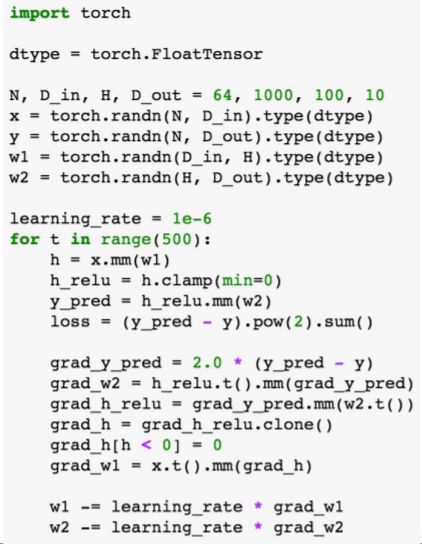

a. Pytorch 中的张量(Tensor)设置

PyTorch 中的张量就像 numpy 中的数组,但是这些张量可以在 GPU 上运行;

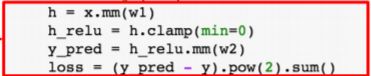

这里我们用 PyTorch 的张量设置了一个两层网络:

下面我们来分步解读:

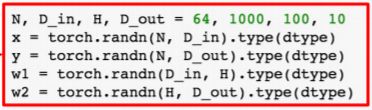

1. 为数据和权重(weights)创建随机张量:

2. 设置前向传播:计算预测值(prediction)和损失(loss):

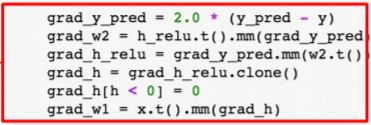

3. 设置反向传播:计算梯度(gradients):

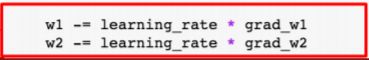

4. 梯度下降(Gradient descent)和权重(weights)相对应:

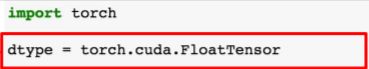

5. 为了在 GPU 上运行,将张量(tensors)设置为 cuda 数据类型:

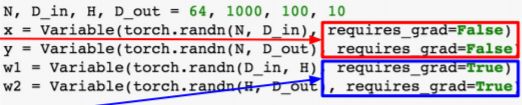

b. PyTorch 中的 Autogradient 设置

PyTorch 的张量(Tensors)和变量(Variables)拥有相同的应用编程接口 API。变量(Variables)可以记忆它们是怎么产生的(因为反向传播的缘故)。

下面仍进行分步解读:

1. 我们不希望(损失 loss 的)梯度和数据(data)有相关性,但我们希望梯度和权重(weights)是相关的。相关设置如图:

2. 这里的前向传播看上去和上述张量(Tensor)的对应版本很相似,但是需要注意的是现在这里全部都是变量(variable)。

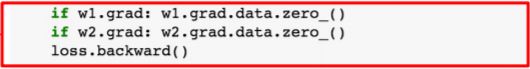

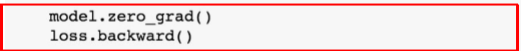

3. 计算损失函数对 w1 和 w2 的梯度(开始的时候梯度置零):

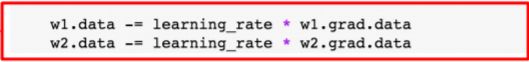

4. 让梯度和权重(weights)相对应:

C. 定义新型 Autograd 函数

通过张量的前向和反向传播来定义你自己的 autograd 函数:

可以在前向传播中使用新的 autograd 函数:

d. PyTorch 中的神经网络(nn)设置

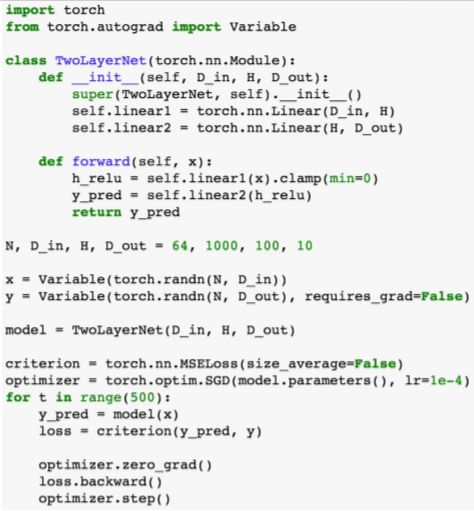

用更高级的「容器」(wrapper)来处理神经网络(neural nets), 和 Keras 相似。完整代码如下:

下面进行分步解读:

把我们的模型定义成一系列的 layers:

也要定义常用损失函数:

![]()

前向传播:给模型输入数据;给损失函数(loss function)输入预测信息(prediction):

反向传播:计算所有的梯度(gradients):

让梯度和每一个模型参数对应:

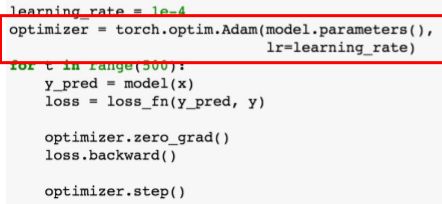

下面我们添加一个优化器(optimizer):

在计算完梯度以后对所有的参数(parameters)进行更新:

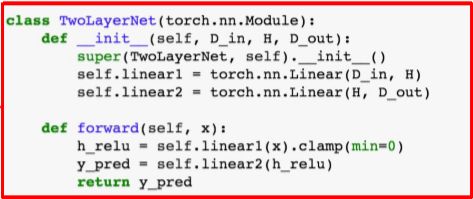

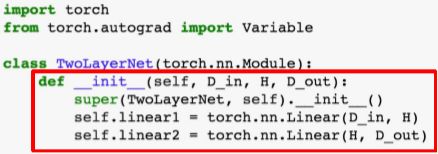

E. PyTorch 中的神经网络——定义新的模型

Pytorch 中的模块(Module)其实是一个神经网络层(neural net layer),需要注意它的输入和输出都是变量;模块(Module)中包含着权重 (当作变量处理) 或者其他模块;你可以使用 autograd 来定义你自己的模块。详细代码如下:

下面进行分步解读:

1. 把我们的整体模型定义成一个单一的模块:

2. 用初始化程序来设置两个子模块(一个父模块可以包含子模块)

3. 用子模块和变量上的 autograd ops 定义前向传播;不需要定义反向传播——因为 autograd 会作相应处理:

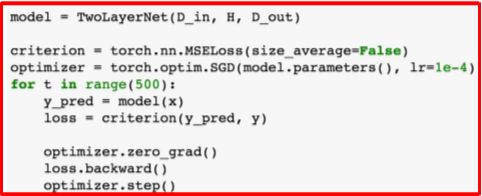

4. 创建并训练一个模型实例:

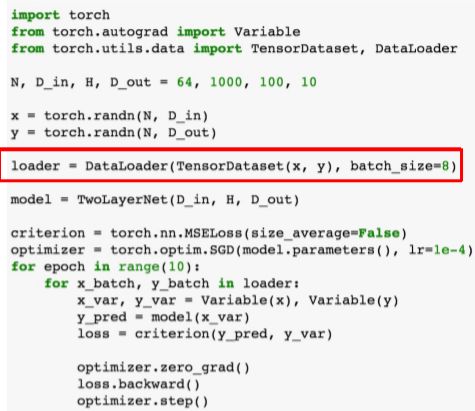

E. PyTorch 中的资料存储器(Dataloaders)

资料存储器(DataLoader)包括一个数据集 (Dataset),而且给你提供了小批量处理(minibatching),「洗牌」处理(shuffling)和多线程处理(multithreading);当你需要载入自定义数据(custom data)时,写下你自己的数据集类型(dataset class)就可以了。

通过遍历存储器(loader)来形成小批量(minibatch);存储器会给你提供张量(Tensors), 所以你需要将其「打包」(wrap)进变量中:

注意:使用带有 torchvision 的预先训练好的模型(pretrained model)将会更加简单易行。

F. Torch 和 pytorch 的简单对比

结论:尽量使用 PyTorch 来做你的新项目。

五、Caffe2 简介

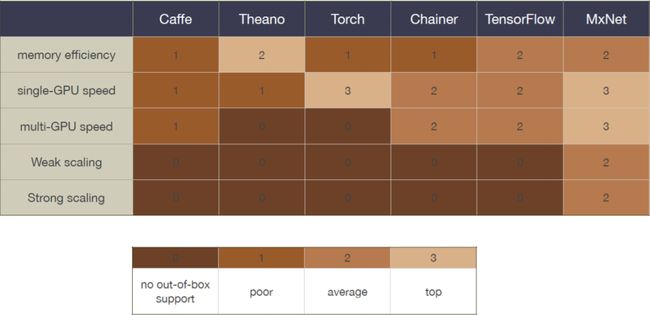

六、深度学习框架之争,究竟谁更胜一筹?

其实具体选择何种框架来进行深度学习取决于我们要做什么。在参阅相关文献之后,我们大致可以得出以下结论(仅供参考):

- PyTorch 和 Torch 更适用于学术研究(research);TensorFlow,Caffe,Caffe2 则更适用于工业界的生产环境部署(industrial production)。

- Caffe 适用于处理静态图像(static graph);Torch 和 PyTorch 更适用于动态图像(dynamic graph);而 TensorFlow 在两种情况下都很实用。

- Tensorflow 和 Caffe2 可在移动端使用。

附主要参考文献CS231n_2017_Lecture8,链接可直接下载PPT:

- http://cs231n.stanford.edu/slides/2017/cs231n_2017_lecture8.pdf

其他参考资料:

- http://203.187.160.132:9011/dl.ee.cuhk.edu.hk/c3pr90ntc0td/slides/tutorial-caffe.pdf

- http://203.187.160.132:9011/dl.ee.cuhk.edu.hk/c3pr90ntc0td/slides/DL_in_Action.pdf