Linux高可用负载均衡集群

集群介绍

集群功能划分:

1:高可用: 高可用集群通常为两台服务器,一台工作,另外一台作为冗余, 当提供服务的机器宕机,冗余将接替继续提供服务 实现高可用的开源软件有:heartbeat、keepalived。

2:负载均衡 负载均衡集群,需要有一台服务器作为分发器,它负责把用户的请求分发给后端的服务器处理, 在这个集群里,除了分发器外,就是给用户提供服务的服务器了,这些服务器数量至少为2 实现负载均衡的开源软件有LVS、keepalived、haproxy、nginx,商业的有F5、Netscaler 。

keepalived介绍:

在这里我们使用keepalived来实现高可用集群,因为heartbeat在centos6上有一些问题,影响实验效果。 keepalived通过VRRP(Virtual Router Redundancy Protocl)来实现高可用。 在这个协议里会将多台功能相同的路由器组成一个小组, 这个小组里会有1个master角色和N(N>=1)个backup角色。 master会通过组播的形式向各个backup发送VRRP协议的数据包, 当backup收不到master发来的VRRP数据包时,就会认为master宕机了。 此时就需要根据各个backup的优先级来决定谁成为新的mater。 Keepalived要有三个模块,分别是core、check和vrrp。 其中core模块为keepalived的核心,负责主进程的启动、维护以及全局配置文件的加载和解析, check模块负责健康检查, vrrp模块是来实现VRRP协议的。

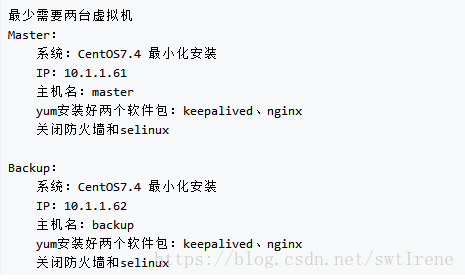

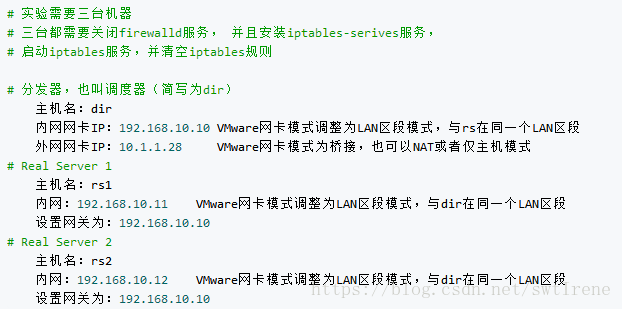

实验环境准备:

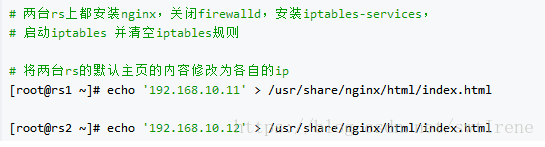

将nginx默认主页的内容修改为各自的ip

Master配置

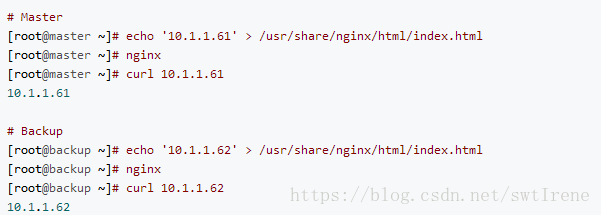

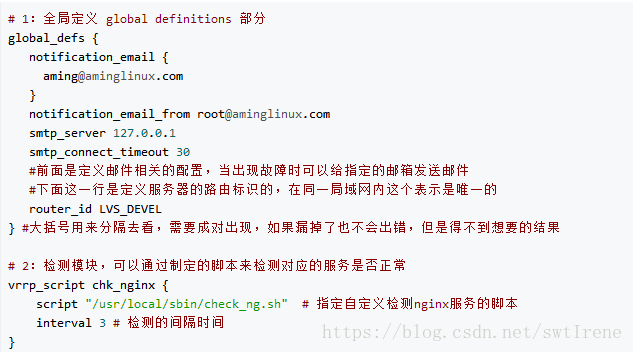

修改的keepalived配置文件/etc/keepalived/keepalived.conf:

# 设定vip为100,具体配置如下:

global_defs {

notification_email {

} notification_email_from [email protected]

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id LVS_DEVEL

}

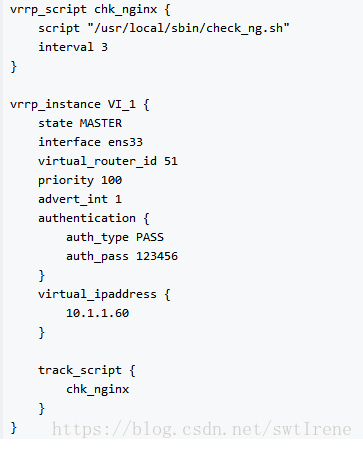

编辑nginx监控脚本 /usr/local/sbin/check_ng.sh 内容如下:

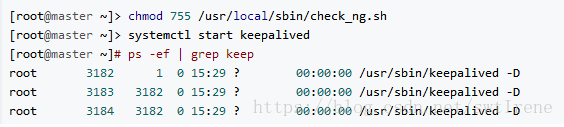

最后给脚本755权限,再启动keepalived

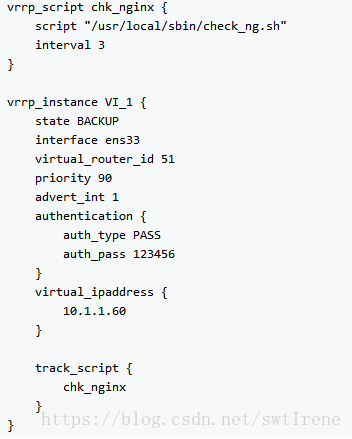

Backup机配置:

修改keepalived配置文件/etc/keepalived/keepalived.conf

global_defs {

notification_email {

} notification_email_from [email protected]

smtp_server 127.0.0.1

smtp_connect_timeout 30

router_id LVS_DEVEL

}

编辑监控nginx脚本 /usr/local/sbin/check_ng.sh 内容如下:

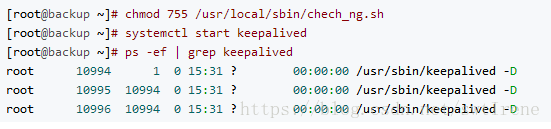

给脚本755权限,再启动keepalived

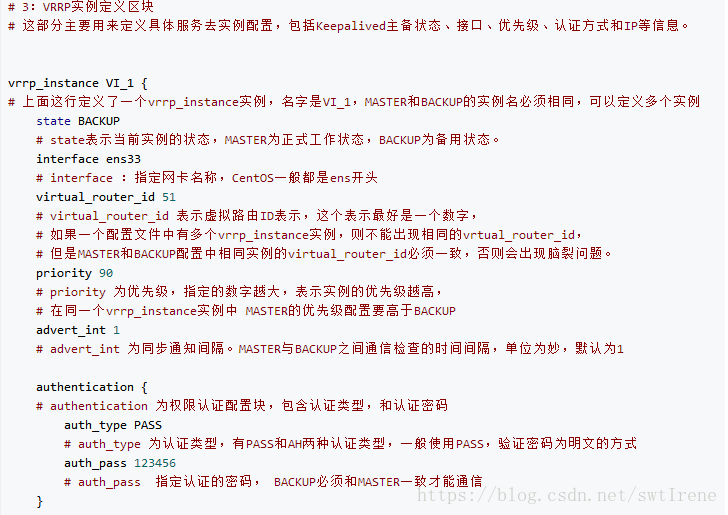

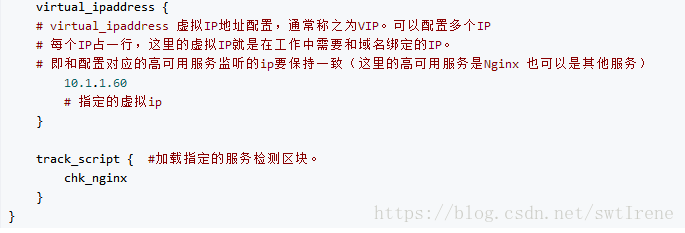

keepalived配置文件说明:

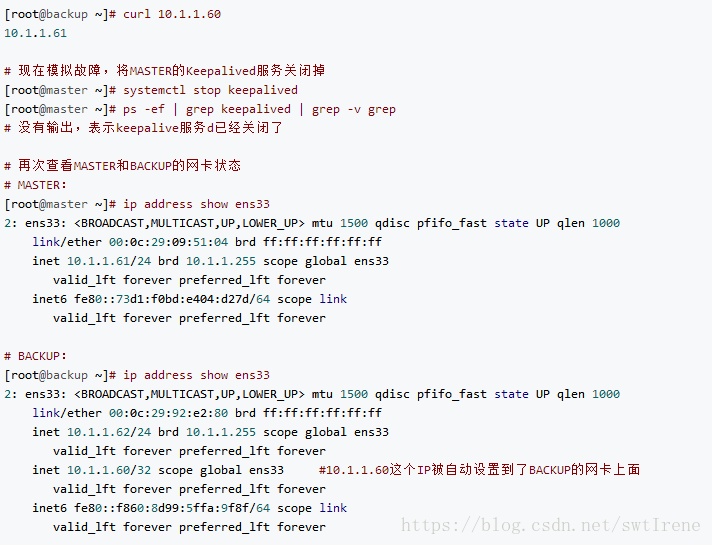

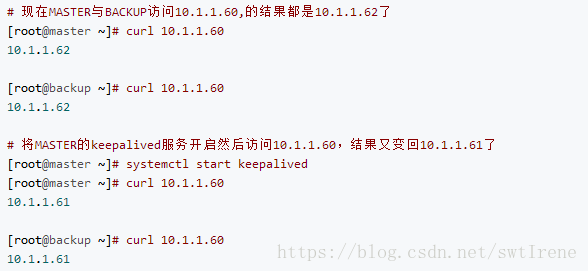

测试效果:

负载均衡集群介绍

主流开源软件LVS、keepalived、haproxy、nginx等 其中LVS属于4层(网络OSI 7层模型), nginx属于7层, haproxy既可以认为是4层,也可以当做7层使用 。keepalived的负载均衡功能其实就是lvs,lvs这种4层的负载均衡是可以分发除80外的其他端口通信的,比如MySQL的, 而nginx仅仅支持http,https,mail, haproxy也支持MySQL这种 相比较来说,LVS这种4层的更稳定,能承受更多的请求, 而nginx这种7层的更加灵活,能实现更多的个性化需求。

LVS介绍

LVS是由国人章文嵩开发,流行度不亚于apache的httpd, 基于TCP/IP做的路由和转发,稳定性和效率很高 LVS最新版本基于Linux内核2.6,有好多年不更新了 LVS有三种常见的模式:NAT、DR、IP Tunnel LVS架构中有一个核心角色叫做分发器(Load balance),它用来分发用户的请求, 还有诸多处理用户请求的服务器(Real Server,简称rs)

LVS NAT模式介绍:

这种模式借助iptables的nat表来实现 用户的请求到分发器后,通过预设的iptables规则,把请求的数据包转发到后端的rs上去,rs需要设定网关为分发器的内网ip,用户请求的数据包和返回给用户的数据包全部经过分发器,所以分发器成为瓶颈 在nat模式中,只需要分发器有公网ip即可,所以比较节省公网ip资源。

LVS IP Tunnel模式介绍:

这种模式,需要有一个公共的IP配置在分发器和所有rs上,我们把它叫做vip 客户端请求的目标IP为vip,分发器接收到请求数据包后, 会对数据包做一个加工,会把目标IP改为rs的IP,这样数据包就到了rs上 rs接收数据包后,会还原原始数据包,这样目标IP为vip,因为所有rs上配置了这个vip,所以它会认为是它自己。

LVS DR 模式介绍:

这种模式,也需要有一个公共的IP配置在分发器和所有rs上,也就是vip 和IP Tunnel不同的是,它会把数据包的MAC地址修改为rs的MAC地址 rs接收数据包后,会还原原始数据包,这样目标IP为vip,因为所有rs上配置了这个vip,所以它会认为是它自己。

LVS调度算法:

Round-Robin rr # 轮询算法,均衡的将用户请求分发到每一个rs上 Weight Round-Robin wrr # 加权轮询 ,带权重的轮循,依照指定的权重比来分发请求 Least-Connection lc # 最小连接 ,将请求分发到连接数比较少的rs上 Weight Least-Connection wlc # 带权重的最小连接, Locality-Based Least Connections lblc # 基于局部性的最小连接 Locality-Based Least Connections with Replication lblcr # 带复制的基于局部性最小连接 Destination Hashing dh # 目标地址散列调度 Source Hashing sh # 源地址散列调度。

LVS相关术语:

1. DS:Director Server。指的是前端负载均衡器节点。 2. RS:Real Server。后端真实的工作服务器。 3. VIP:向外部直接面向用户请求,作为用户请求的目标的IP地址。 4. DIP:Director Server IP,主要用于和内部主机通讯的IP地址。 5. RIP:Real Server IP,后端服务器的IP地址。 6. CIP:Client IP,访问客户端的IP地址。

LVS NAT模式搭建

实验环境准备

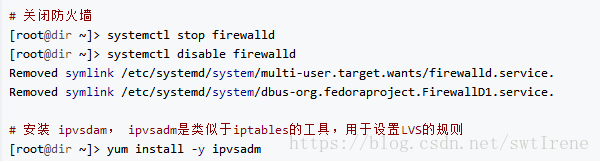

在dir上关闭Firewalld 安装iptables-service和ipvsadm

在dir上编写LVS脚本,vim /usr/local/sbin/lvs_nat.sh 内容如下:

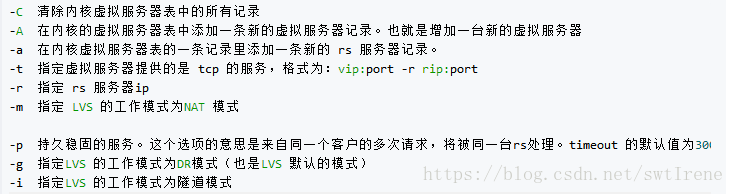

ipvsadm选项说明:

rs机设置:

测试效果

curl请求访问10.1.1.28,多访问几次看结果差异

DR模式搭建

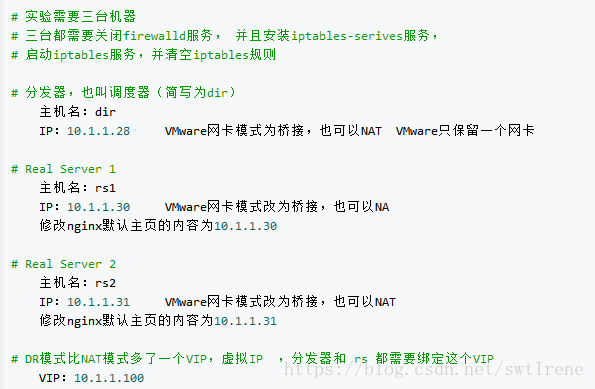

准备实验环境:

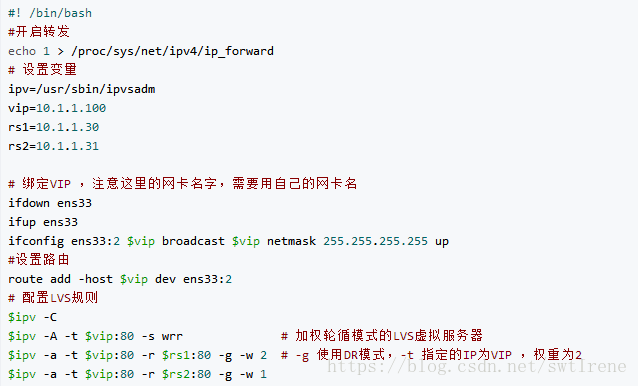

编写 dir 服务器的LVS脚本 vim /usr/local/sbin/lvs_dr.sh:

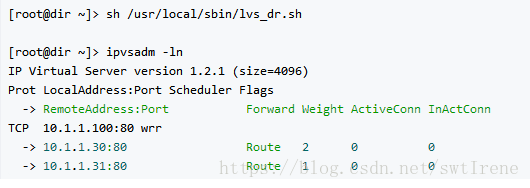

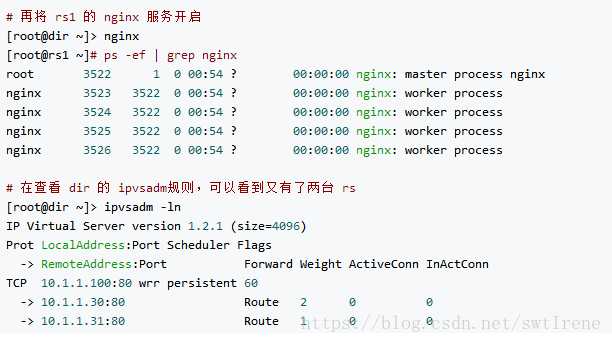

执行/usr/local/sbin/lvs_dr.sh 脚本 ,使用ipvsadm -ln 命令查看ipvsadm规则:

编写 rs 的脚本 vim /usr/local/sbin/lvs_rs.sh # 内容如下:

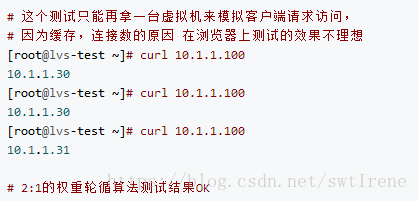

测试效果:

keepalived + LVS

当单独使用LVS负载的时候,如果其中一台 rs 宕机了,就会出问题,所以就需要使用到keepalived+LVS的架构了,keepalived有一个比较好的功能,可以在 rs 宕机时,不再把请求转发过去。

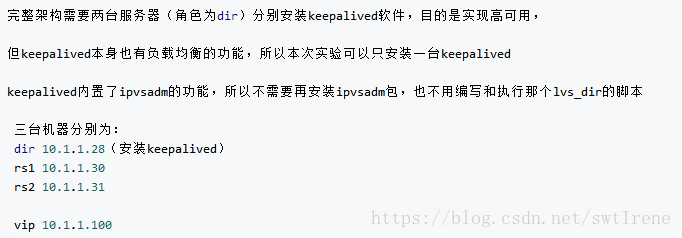

keepalived + LVS实验环境说明:

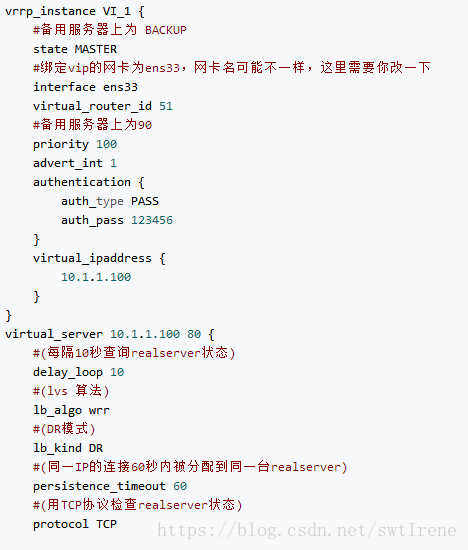

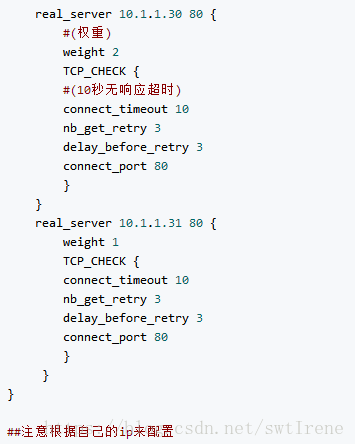

编辑keepalived配置文件 vim /etc/keepalived/keepalived.conf 内容如下:

清空之前的ipvsadm规则和VIP:

ipvsadm -C

systemctl restart network #最好每个主机都执行一遍

两台rs上,依然要执行/usr/local/sbin/lvs_rs.sh脚本

sh /usr/local/sbin/lvs_rs.sh

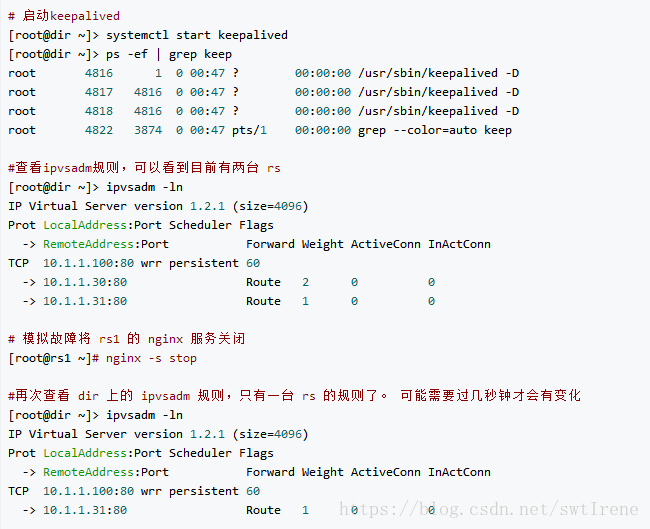

然后启动keepalived:

systemctl start keepalived

测试效果:

扩展阅读

heartbeat和keepalived比较

DRBD工作原理和配置

mysql+keepalived

lvs 三种模式详解

lvs几种算法

关于arp_ignore和 arp_announce

lvs原理相关的

haproxy+keepalived

nginx、lvs、haproxy比较

keepalived中自定义脚本 vrrp_script

lvs dr模式只使用一个公网ip的实现方法