文献阅读:ACCURATE AND FAST FINE-GRAINED IMAGE CLASSIFICATION VIA DISCRIMINATIVE LEARNING

一、文献梳理

1、文献背景

与一般的图像分类不同,弱超可视细粒度图像分类(WFGIC)仅使用图像级标签来识别更详细的类别和粒度下的对象。WFGIC是一个开放的问题在计算机视觉领域,不仅因为图像属于同一子范畴的有很大的差异大小,姿势,颜色,和背景,而图像落入不同的子类可能在这些方面非常相似,而且对提取的难度区别的特性只使用对像级别标签。

图像中局部区域的细微差别对于区分细粒度的子类别非常重要。使用自下而上的过程选取候选框缺乏一种机制来保证隔离的判别斑块在最终分类阶段发挥重要作用。采用自顶向下的方法去除图像中的噪声块,保留含有判别区域块的图像块,可以克服这一问题。但是,所选patch中的内容仍然包含一些噪声信息,如图背景区域。(何为自上而下,或自下而上)

2、文献成果

1)研究成果

在本工作中,我们提出了损失一致的判别先验网络,将patch数量减少到单个图,大约5-8个,以达到实时效率,如图1(c)所示。提出的一致性损失,当(测试集)判别概率尽可能接近所选(训练集)patch的分类概率时,激励判别先验图学习到图像的判别概率值。

我们提出了一种基于判别先验网络(SDN)模型的端到端自回归局部化方法,用于弱监督细粒度图像的分类,该方法能够学习探索更精确的描述斑块大小,并能够对图像进行实时分类。

我们设计了梯度损失和一致性损失来指导SDN网络中的多任务学习,提供自回归系数来降低选择的patch的噪声,并给出有区别的先验映射来减少patch的数量,从而进行准确有效的分类。

2)实验结果

(1)实验细节

在我们的实验中,所有的尺寸都调整为448×448。我们使用resnet - 50作为主干网,批量归一化作优化器。初始学习速为0.001,60个迭代后,0.0001。学习衰减(动量)设定为1e−4。为了减少patch的冗余,我们使用了非最大抑制(non- maximum suppression, NMS),并将NMS阈值设置为0.25。

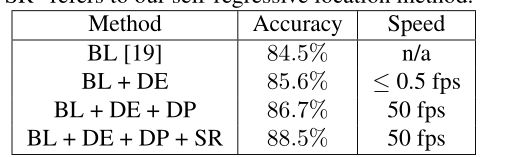

(2)模型简化实验(Ablation Experiments)

BL是指基线法,通过不带任何物体或部分注释的Resnet-50直接从整个图像中提取特征。“DE”表示默认候选框。“DP”是我们提出的判别先验,“SR”是我们的自回归定位方法。

我们通过ResNet-50的分类结果选择默认的patch作为局部特征。大量未过滤的补丁会导致较高的计算成本。当我们加入描述型先验网络(DP)时,cub200 -2011数据集上排名前1的分类精度提高了1.1%,并实现了50帧/秒的实时速度。进一步,我们介绍了自回归定位网络和分类精度,所以所以最终模型为第四种 。

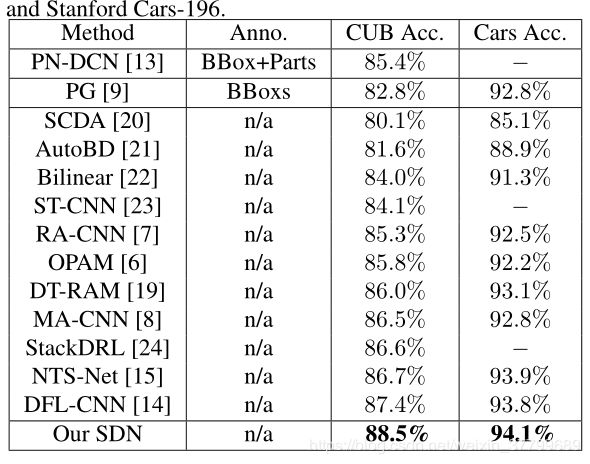

(3)定量对比

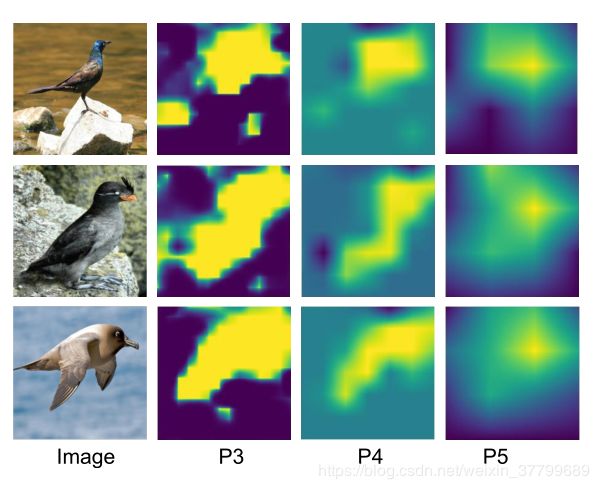

(4)定性分析:从左到右,如何辨别能力(亮度差异)越来越弱。

(5)结论

在本文中,我们提出了一个新的WFGIC框架。该方法将一个自回归定位子网络和一个判别先验子网络集成到一个统一的框架中。自回归定位子网络可以减少所选patch的无用信息,判别先验可以解决计算量大的问题。实验表明,在两个细粒度图像数据集的一致性改进。我们达到了最先进的精度和55帧/秒的实时速度。在未来,我们将探索其他线索,如挑选出最多区分区域,更好地执行细粒度图像分类。

二、基础讲解

1、细粒度图像分类

细粒度图像分类问题是计算机视觉领域一项极具挑战的研究课题, 其目标是对子类进行识别, 如区分不同种类的鸟.

由于子类别间细微的类间差异和较大的类内差异。

传统的图像分类主要处理语义级图像和实例级图像两大类: 前者包括诸如场景识别、对象识别等语义级图像分类任务, 其目标是识别不同类别的对象, 如猫和狗等; 后者则是对不同的个体进行分类, 如人脸识别.细粒度图像分类则位于这两者之间. 不同于对象识别等粗粒度的图像分类任务, 细粒度图像的类别精度更加细致, 类间差异更加细微, 往往只能借助于微小的局部差异才能区分出不同的类别. 由于其分类边界位于同一类别的不同子类之上, 如不同种类的鸟等, 故而又被称作子类别分类. 而与人脸识别等对象级分类任务相比, 细粒度图像的类内差异更加巨大, 存在着姿态、光照、遮挡、背景干扰等诸多不确定因素. 因此, 细粒度图像分类是一项极具挑战的研究任务.

特点:细粒度图像的信噪比很小, 包含足够区分度的信息往往只存在于很细小的局部区域中. 因此, 如何找到并有效利用这些有用的局部区域信息, 成为了决定细粒度图像分类算法成功与否的关键所在.

2、常规细粒度图像分类方法

基础框架:先找到前景对象 (鸟)及其局部区域 (头、脚、翅膀等), 之后分别对这些区域提取特征. 对所得到的特征进行适当的处理之后,用来完成分类器的训练和预测。

影响分类效果的关键因素:1)局部区域的选择,因此算法严重依赖于人工标注信息 (Annotations).一些常用的标注信息就包括标注框 (Bounding box) 和局部区域位置 (Part locations) 等. 2)特征的提取也是决定图像分类准确性的关键因素, 寻找一个更具区分度的特征一直是研究人员所追求的目标. 传统的基于人工特征的分类算法往往面临很大的局限性. 这类算法一般是先从图像中提取 SIFT (Scale invariant feature transform)或者 HOG (Histogram of oriented gradient)这些局部特征, 之后利用 VLAD(Vector of locally aggrgeated descriptors)或者Fisher vector等编码模型进行特征编码, 得到最终所需要的特征表示.

3、常用数据库

1)CUB200-2011: CUB200-2011 是细粒度图像分类领域最经典, 也是最常用的一个数据库, 共包含 200 种不同类别, 共11788 张鸟类图像数据. 同时, 该数据库提供了丰富的人工标注数据, 每张图像包含 15 个局部区域位置, 312个二值属性, 1个标注框, 以及语义分割图像.

2)Stanford Dogs: 该数据库提供了 120 种不同种类的狗的图像数据, 共有 20580 张图, 只提供标注框这一个人工标注数据.

3) Oxford Flowers: 分为两种不同规模的数据库,分别包含17种类别和102种类别的花. 其中, 102种类别的数据库比较常用, 每个类别包含了 40 到258张图像数据, 总共有 8189张图像. 该数据库只提供语义分割图像, 不包含其他额外标注信息.

4)Cars: 提供 196 类不同品牌不同年份不同车型的车辆图像数据, 一共包含有16185 张图像, 只提供标注框信息.

5))FGVC-Aircraft: 提供 102类不同的飞机照片, 每一类别含有100张不同的照片, 整个数据库共有10200张图片, 只提供标注框信息.

4、主要研究方向—强监督的细粒度图像分类研究

所谓强监督的细粒度图像分类算法, 是指在模型训练的时候, 除了图像的类别标签外, 还使用了标注框、局部区域位置等额外的人工标注信息.主流的强监督是使用DeCAF特征(Deep convolutional activation feature)进行分类。

基本步骤:首先使用标注框对图像进行裁剪(自底向上的区域算法产生区域候选,之后, 对每一个候选区域提取卷积特征, 用事先训练好的SVM 模型来对每一个特征进行分类, 判断该候选区域中是否包含想要检测的对象. ),得到前景对象, 再利用预训练的卷积网络对图像提取DeCAF特征. (步骤详解R-CNN、Part R-CNN)

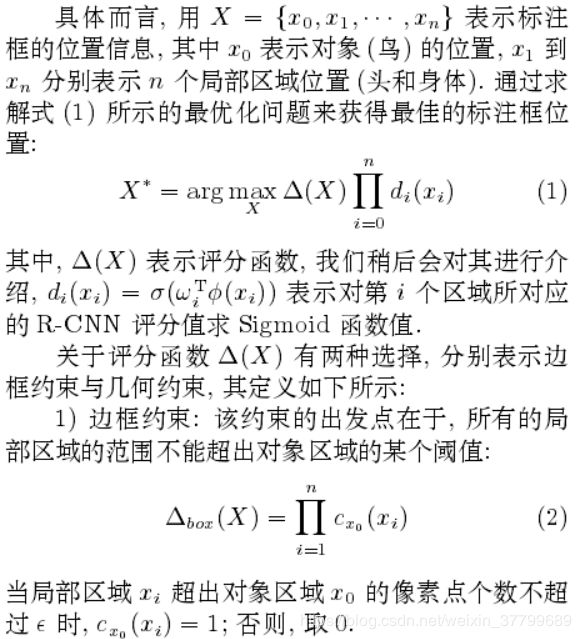

1)Part R-CNN

与R-CNN相比,它只对头和身体产生候选框,并且在确定候选框时加入两个约束使其候选框不会出现大面积重复,这两个约束分别是边框约束与几何约束。

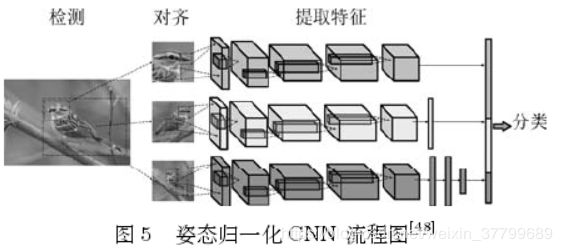

2)姿态归一化CNN

在细粒度图像分类任务中, 除了至关重要的局部区域信息之外, 还有一个十分显著的特点: 其巨大的类内方差会对最终的分类性能造成很大的影响.而在这些不同的干扰信息中, 姿态问题则是一个普遍存在的影响因素. 有鉴于此,Branson等提出了姿态归一化CNN。

流程:对于输入图像,Branson 等利用预先训练好的DPM(Deformable part model)算法完成关键点的检测. DPM 算法能够给出预先定义好的关键位置点的坐标, 以及该点是否可见等信息. 之后, 利用这些关键点进行姿态对齐操作.

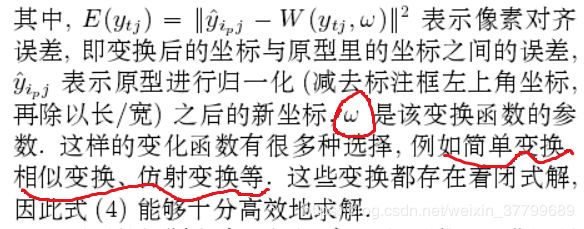

模型:本质是使图像关键点坐标与模板关键点欧式距离最小,并加入特定约束使其可以完成对原型的训练。其中W可以理解为类似神经网络中的映射公式或多元的数值逼近。(下式是求解输入图片的关键定,w已经确定)

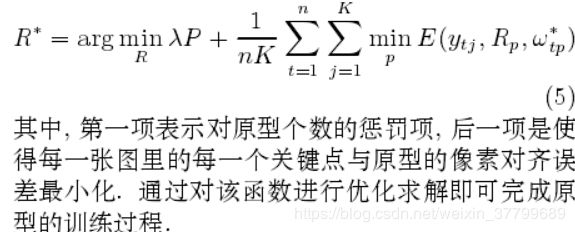

模型的求解:下面的问题变成了如何对P个原型Rp进行训练. 思路是使用受约束的最小化对齐误差, 其约束条件是训练集中的每一个关键点至少与一个原型对齐. 这一约束可以形式化地描述为:(下式是求解w,已知RP)

补充: 实验结果表明, 对于低层对齐图像(原始图像与前景对象) 而言, 后层的卷积特征更具区分度, 能够实现更高的准确度, 相对浅层特征具有绝对的优势. 但对于高层对齐图像 (头部图像) 来说,情况却恰恰相反. 因此, 对于不同的局部区域应当提取不同网络层的特征.

创新之处:使用原型对图像进行了姿态对齐操作, 并针对不同的局部区域提取不同网络层的特征, 以试图构造一个更具区分度的特征表示, 这一方案在先前的研究工作中并不常见. 它在原有的局部区域模型的基础上, 进一步考虑了鸟类的不同姿态的干扰, 减轻了类内方差造成的影响, 从而取得了较好的性能表现. 但是, 该算法对于关键点的检测精度较为敏感, 利用 DPM 算法对关键点进行检测, 其精度为 75.7 %. 而如果在测试时使用真实的关键点标注信息, 则可以达到 85.4 %,达到了一个相当高的分类水平.

4、主要研究方向—弱监督的细粒度图像分类研究

背景:仅仅依赖于类别标签完成分类是近年来细粒度图像研究的一大趋势. 得益于深度学习的发展, 以及相关研究工作的深入, 不借助人工标注信息, 也能实现良好的分类性能. (与强监督相比,其区别为局部区域的检测算法是不依赖标注的)

流程:先找到前景对象 (鸟)及其局部区域 (头、脚、翅膀等), 之后分别对这些区域提取特征. 对所得到的特征进行适当的处理之后,用来完成分类器的训练和预测。

1)局部区域选择算法-两级注意力模型,得到图片的局部区域与区域所指的部分

两级注意力 (Two level attention) 算法是第一个尝试不依赖额外的标注信息, 而仅仅使用类别标签来完成细粒度图像分类的工作, 该模型主要关注两个不同层次的特征, 分别是对象级 (Object-level) 和局部级 (Part-level), 即在以往强监督工作中所使用的标注框和局部区域位置这两层信息. 该模型主要包含三个处理阶段, 对应三个不同的子模型:预处理模型、对象级模型、局部级模型。

预处理模型:在预处理阶段, 主要是从原始图像中检测并提取前景对象, 以减少背景信息带来的干扰. 同样是从候选框中选择具有前景的候选框。

对象级模型:由于一张图像包含多个候选区域, 因此, 最终对一张图片的输出结果是一个集成 (Ensemble). 具体而言, 就是一张图的一

个区域候选, 经过卷积网络之后, 得到一个 Softmax层的输出. 对所有区域的输出求平均, 作为该图像最终的Softmax层输出. 本质上得到的还是各候选框之间的分类结果。

局部级模型:(作用)由于预处理模型选择出来的这些候选区域大小不一, 有些可能包含了头部, 有些可能只有脚. 因此, 局部级模型的作用就是为了选出这些局部区域. (步骤:网络提取特征-特征谱聚类-使用簇对测试集局部区域进行检测)对象级模型得到的网络来对每一个候选区域提取特征. 对这些特征进行谱聚类,得到 k 个不同的聚类簇, 每个簇代表一个局部信息,如头部、脚等.

将不同局部区域的特征级联成一个特征向量,用来训练 SVM, 作为局部级模型给出的分类器. 最后, 将对象级模型的预测结果与局部级模型的结果相结合, 作为模型的最终输出。

2)基于局部区域的图像表示

之前的方法只是使用卷积神经网络提取图片特征,基于局部区域的图像表示一种能够从卷积特征中挑选出具有分辨力的局部区域特征的算法(因为卷积特征对应图像中的感受野,受此思想主导)

对于每一个候选区域, 提取其卷积特征为一个N × N × d 的张量, Zhang等采用 MMP 方法从卷积特征中, 直接提取出局部区域的特征,得到若干d维的特征. 该方法利用一个M × M大小的滑动窗口, 从卷积特征的左上角向右下角扫描, 每次扫描都对窗口内的特征做一次 最大池化编码, 得到一条d维特征. 同时, 通过变化M的取值, 可以得到不同大小的区域的特征表示, 这里 M ∈ [1, N].这样, 利用 MMP 方法就能够直接得到局部候选的特征表示, 避免了基于Selective search方法的巨大计算开销. 但是这些特征中, 包含着大量无关信息, 需要对其进行选择, 去除噪音.

步骤:使用FV编码,将每一张图像的所有局部区域候选表示成一个向量——从众多的聚类簇中, 选择那些重要的聚类簇. 这可以通过计算每一个类的相互信息值 作为该簇的重要程度分值. ——将不同的规模的局部特征编码为最终的特征表示, 用来训练 SVM 分类器。

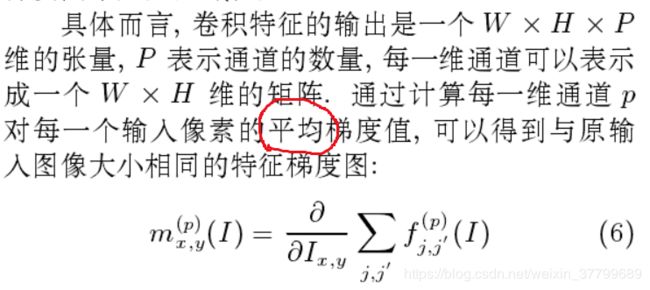

3)星座算法:一种新颖的局部区域检测与提取的方案

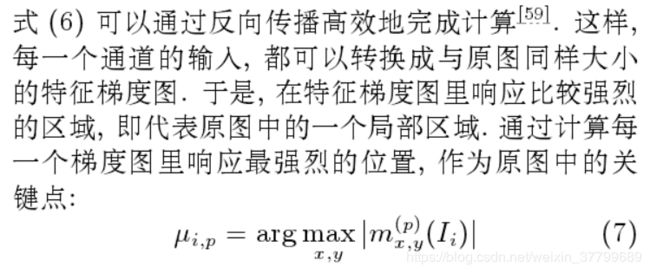

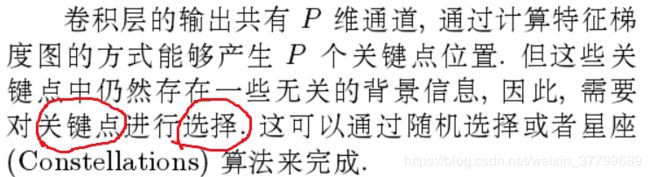

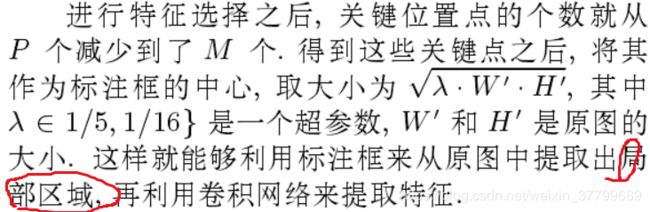

思想:卷积特征可以被视为一种检测分数, 响应值高的区域代表着原图中检测到的局部区域.但是, 特征输出的分辨率与原图相差悬殊, 很难对原图中的区域进行精确定位,因此使用梯度图来产生局部区域位置。(下图中平均指的是什么,j与j'是什么?)

注:此方法主要针对局部信息,不包含对象级的信息(即前景对象)。正常分类最后的特征向量由三部分信息构成:原图的特征、前景对象的特征以及局部区域的特征.

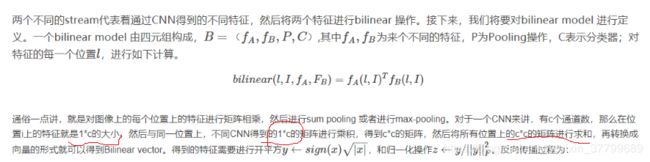

4)双线性CNN:同样是回答如何在不依赖于标记信息的情况下, 完成对局部区域的检测问题

补充:当双线性模型应用到实际的网络中时, 特征提取函数 fA, fB的输出是一个 M × N × P 维的张量,这时位置 L 定义为 M × N 维矩阵上的每一个位置点, 共有 MN 个位置. 每个位置经过双线性操作后转化为一个 P × P 维的矩阵, 经过池化函数之后, 最终得到一个 PP × 1 的特征向量.注:B=dx/dA ;A=dx/dB;参考链接

一种对双线性 CNN 模型的解释是, 网络 A 的作用是对物体进行定位, 即完成传统算法的对象与局部区域检测工作, 而网络 B 则是用来对网络 A 检测到的物体位置进行特征提取. 两个网络相互协调作用, 完成细粒度图像分类过程中两个最重要的任务: 区域检测与特征提取.

5)其他:

空间转换网络:整个系统由两部分组成: 对象检测器与空间转换器. 前者用来完成前景对象的检测工作, 后者则是对检测结果进行对齐操作.

多层次的图像分类: 他们根据生物学上的分类方法, 将数据库重新划分为科、属、种等多个不同的层次. 对于每个不同层次的网络, 使用不同尺度的图像和不同的监督信息进行训练, 以达到粗细互补的目的. 最后的特征由多个不同层次网络的输出拼接而成。

未来:构建更高质量的标准数据库,有效地利用局部区域信息,构造更强大的特征表示,自然场景下的图像识别。

参考文献:罗建豪, 吴建鑫. 基于深度卷积特征的细粒度图像分类研究综述. 自动化学报, 2017, 43(8): 1306−1318

三、论文重点

1、摘要

目前,大多数性能最好的弱监督细粒度图像分类(WFGIC)方案都倾向于选择有区别的patch。但这些小块通常含有较多的噪声信息,影响了分类的准确性。此外,它们依赖于大量的候选补丁来发现有区别的补丁,从而导致较高的计算成本。为了解决这些问题,我们提出了一种新的端到端自回归的判别先验网络(SDN)模型,该模型学会了探索更准确的判别斑块大小,能够实时对图像进行分类。具体地,我们设计了一个多任务判别学习网络、一个自回归定位子网络和一个有引导损失和一致性损失的判别先验子网络,同时学习自回归系数和判别先验映射。自回归系数通过学习判别概率值,将成千上万个残差块过滤到单个图像中,有效地降低了判别块中的噪声信息。大量的实验表明,所提出的SDN网络模型在精度和效率上都达到了最新的水平。

2、思想

在本工作中,我们提出了一种具有引导损耗的自回归定位子网络,通过学习自回归系数来调整所选patch的大小,从而找到准确的判别区域。具体来说,利用原始图像的全局特征,设计梯度损失,当选定区域的预测概率值大于图像预测概率值时,学习自回归系数。

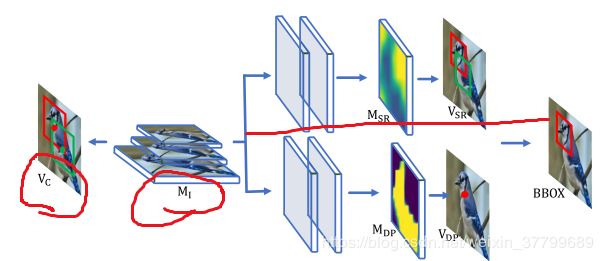

基于判别先验网络(SDN)的自回归定位框架。利用判别先验(DP)网络和自回归网络(SR)的自回归尺度系数,输入特征生成判别先验图(DP)。然后根据DP图和自回归尺度系数对缺省patch (DE)进行处理,选择理想的判别区域。然后,从原始图像中裁剪并调整到224×224的大小,生成判别特征。

3、具体模型

框架主体:DP(判别网络)提取判别图DP Map;自回归网络(SR)提取自回归系数;结合DP Map和自回归系数确定判别区域;然后对原始样本进行裁剪和归一化处理,得到高质量的局部级判别特征。最后,我们将WFGIC的图像级和局部级特征连接起来。

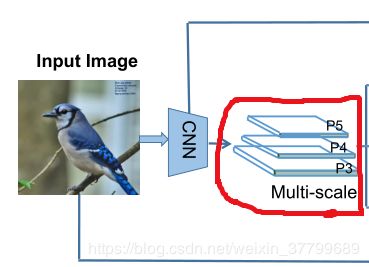

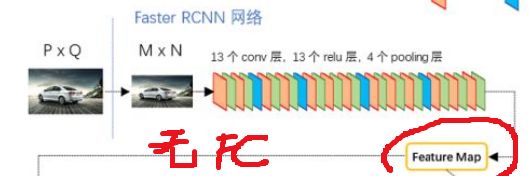

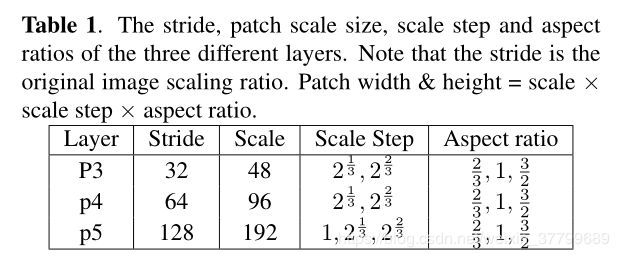

特征图是CNN得来(此时的CNN没有FC层),其中CNN的参数是由图像识别的CNN(它是有FC的,输出为类别向量)迁移而来。本文的CNN为三层结构,对于图像中的多尺度应该由卷积层变化得到,其各层结构如下。面积缩放因子(scales)和长宽比(aspect ratios)

1)SR:我们提出通过一个简单的两层网络将图像特征加入到自回归函数,第一层为卷积层,第二层为回归层

注:通过映射,我们将矩阵表示法M SR∈W×H×2K,对向量表示V SR∈2K。V SR为2K维向量,对应默认patch的宽度和高度的自回归系数。向量的长度等于patch总数的两倍。此时的标签是V C,通过(V C-V SR)的平方和,训练W P。

2)DP:对中心点进行判断是否属于中心区域(因此是K维向量),使用像素点的类别(属于中心或不属于)作为输出。

3)总结:SR相当于卷积层+线性层,主要作用于候选框的宽高;DP相当于卷积层+FC,主要作用于候选框的中心点;DE为初始CNN得到的候选框中心坐标与候选框的宽高。(效果是减少了候选框数量与大小)

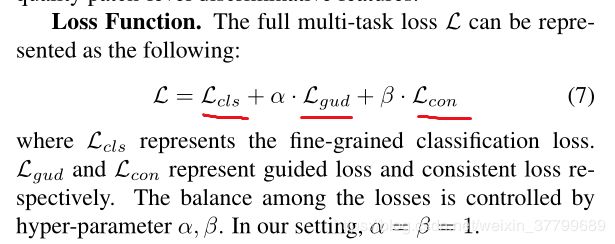

4)补充(后半部分的损失函数,类别损失,中心损失,区域损失)

4、疑问

1)此模型实验了图像的标准信息,难道不算强监督模型吗?