- Jfinal+duckDB

秋林辉

java前端数据库

com.jfinaljfinal3.6org.duckdbduckdb_jdbc1.2.2.0@OverridepublicvoidconfigPlugin(Pluginsme){//配置DuckDB数据源DruidPlugindruidPlugin=newDruidPlugin("jdbc:duckdb:E:/DUCKDB/DuckDB/hrls.duckdb","","","org.duckd

- 虚拟机中 Linux环境下idea 报Java HotSpot(TM) 64-Bit Server VM warning: ignoring option MaxPermSize=350m;

秋林辉

JAVAidealinuxjdkintellijidea

问题JavaHotSpot(TM)64-BitServerVMwarning:ignoringoptionMaxPermSize=350m;supportwasremovedin8.0无法启动原因在Java8中,命令行标志MaxPermSize已被删除。原因是永久代已从热点堆中删除,并已移至本机内存。所以不需要配置,内存足够!第一先看看你是不是使用JDK8,如果是MaxPermSize这个配置无效

- 2019-03-26

泰优汇典当行车贷李娟18221

1:付出不亚于任何人的努力2.要谦虚,不要骄傲3.要每天反省4.活着,就要感谢5.积善行,思利他6不要有感性的烦恼今日分享:所谓不可能,只是现在的自己不可能,对将来的自己而言那是“可能”的。应该用这种“将来时行时”来思考。要相信我们具备还没有发挥出来的巨大力量。“行!我们能做。”衡量自己的能力要用“将来进行时”,用这种积极的态度对待工作。----稻盛和夫

- #晓悦晨享记 283

xuxiaoyue88

对一件事能给够持续地付出时间和精力,并以此为乐,才是真正有耐心,并且长久地坚持下去。以前我总觉得,能够放下耐心的不快,应付原本不喜欢的人和事才叫有耐心,但那应该叫“忍耐”,对于平常人是坚持不了多久的。所以若要把一件事做长久,一定是我们能从中找到乐趣,找到成就感,这样哪怕再大的困难也抵挡不住自己对这件事本身的热爱。就像我在日记星球认识的一位妈妈一样,她非常热爱写日记,她家两个孩子,她每天都会手写两篇

- 51单片机 定时器时钟

微芬

51单片机51单片机单片机

本章博客实现在LCD1602上展示定时器时钟部分1.main.c注:Sec,Min,Hour可不进行赋值#include#include"Delay.h"#include"LCD1602.h"#include"Timer0.h"unsignedcharSec=55,Min=59,Hour=23;voidmain(){LCD_Init();Timer0Init();LCD_ShowString(1,

- 【短篇小说】漫天风雪中的婚礼(齐悦篇)13

柒小七的练习册

文/柒小七第二天早上,齐悦变得比以往更加有精神,是那种从内而外的精神。杨妈妈和杨爸爸也发现了齐悦的变化,虽然不知道发生了什么,但是看到齐悦有精神的样子,两个人也感觉放心了些。早饭后,齐悦拉着杨家父母坐在客厅,齐悦主动地提出了要去墓地祭拜杨浩的事情。杨家父母都有些震惊,又有些担心地看着齐悦。看着杨家父母眼中的震惊和担心,齐悦笑了笑说:“爸妈,放心,我没事儿,只是想通了一些事情罢了。我想去看看杨浩,告

- 2023-08-16

仁德上人

理与事的圆融无障碍,说着容易,落实做到太难了文/仁德上人有人喜欢研究那些空洞自己欺骗自己的空道理,明白得再多再透彻也是空的,是空性不可得之空道理;也有人喜欢在事相上多做一些好事善事,认为是真修行,无论怎么样的做事,都是自己我我我喜欢做而做的。这是修行最怕的两边的邪知邪见邪行为,一边是执理废事,一边是执事废理,总不能达到真正的理与事的圆融,没有障碍。只有真正在事相上落实做到,一天到晚地做好事做善事,

- 2021-11-13

芷灵君

打卡时间:11月12日-11月13日打卡内容:1.“两个教学大纲”具体指什么?两个教学大纲指的是:1、必须学会并记住的材料;2、课外阅读以及其他知识来源。2.“两个教学大纲”,是如何发展学生的思维能力的?为了牢固地记住公式、规则、结论和其他的概括,学生应该阅读和思考许多无需记住的材料。阅读应和学习紧密联系。如果阅读加深了对事实、现象和事物的认识,而这些事实、现象和事物是保存在记忆中的概括的基础,那

- 2022-05-03

不一样的烟火100

人际交往中,什么样的人最受欢迎?有趣,会玩。同学中有个小圈子,有男有女,隔三岔五会有个饭局,或为某人庆祝生日,或贺某人乔迁之喜,或祝子女金榜题名,或庆祝某人嫁女招婿……一群人乌泱泱聚集一起,谈天说地,把酒言欢。其中总会有个核心人物搞气氛,只见他八面玲珑,照顾每个人,什么话题都能扯几句,其间夹杂一半句或诙谐幽默的笑话,或流行网络语,或就社会热间发表高论,最不济也来两句原创的黑色幽默,逗得一桌人爆笑不

- 2023-07-23

弗莱斯曼

凡事预则立,不预则废。记忆力以及理解能力,需要不断的用事情去打磨,越磨越灵光,越刺激越好用。不是在总结,就是在总结的路上。把自己的事情束之高阁的人将终生痛苦。闲言碎语1、上午过去澳新羽毛球馆参加了自己每周都特别期待的活动,这次碰到对的搭档玩的极其酣畅淋漓,基本上整个上午场能妥妥达到50%以上的胜率;简单的小复盘下,针对边线球,自己在处理的时候,除了要把球打到对面足够深的位置,还需要适当的对球做下控

- 中断定时器60秒倒计时

爱摆烂的谢谢谢

单片机嵌入式硬件51单片机物联网c语言

#include//数码管位选控制引脚定义sbitSEG1=P2^2;sbitSEG2=P2^3;sbitSEG3=P2^4;//按键和蜂鸣器引脚定义sbitK1=P3^2;sbitBuzzer=P1^5;//全局变量定义unsignedintsec=60;//倒计时秒数unsignedintcount=0;//定时器计数bitis_counting=0;//倒计时状态标志/***@brief毫秒

- SQLite数据库文件损坏的可能几种情况(一)

界忆

人工智能数据库SQLite数据库sqlitec++

返回:SQLite—系列文章目录上一篇:SQLiteC/C++接口详细介绍sqlite3_stmt类(十三)下一篇:SQLite使用的临时文件(二)概述SQLite数据库具有很强的抗损坏能力。如果应用程序崩溃,或操作系统崩溃,甚至电源故障发生在事务中间,部分写入的事务应在下次自动回滚将访问数据库文件。恢复过程已完全完成自动,不需要用户采取任何行动或应用程序。尽管SQLite可以抵抗数据库损坏,但它

- 高端密码学院笔记228

柚子_b4b4

高端幸福密码学院(高级班)幸福使者:李华第(541)期《幸福》之启动深层心理轻松意识基础篇——“扛得住”成长的喜悦心理案例分析主讲:刘莉一,知识扩充:高尚、伟大的代价就是责任。自由的第一个意义就是担负自己的责任2020.8.20星期三一笔记:1.从接的住到扛得住,心里境界的提升2.看到优秀的家人向别人学习如何去做,什么心里阶段性呈现什么状态。3.学习力越强,承载力越强4.精准,准确,的点评就是对笔

- 7月20日跑步打卡13.86KM

小强聊成长

今日最高气温37度,风很大,感觉没那么热,今日跑步13.86KM,用时1小时37分,平均配速7分1秒,再快两秒就够理想了。基本上没歇,一路慢跑。天热压着速度,没敢太猛。毕竟三伏天,搞中暑了那就要闹笑话了。平时西湖边跑步的人见的少了,但是两级分化,还是有个别大牛,光着膀子,浑身腱子肉,一路挥汗如雨。本月累计跑步14次,跑步167KM,距离200KM,还有33KM,再跑3次就可以完成。距离本月结束,计

- 【静守流年30】练习讲什么

宁超群

1今日发下昨日的练习。首先,对书写特别漂亮的一批学生大力表扬。接着,对书写好,答题准的孩子发了一张“学习之星”的证书,让同学们、也让他们自己看见自己的优秀,在班级起到了正面示范的作用。然后,给了五分钟时间让他们自主反思,自主订正自己的错误。最后开始讲评试卷。讲评什么呢?第一、讲读题习惯和答题习惯。孩子们丢掉了读题勾画关键词、认真书写、答题完整和反复检查的习惯。当然,不是我直接讲,而是让他们自主总结

- 2022年6月时间开销总结与计划

克克克阿

2022年6月本月的重心就是实习工作,没别的了。下月计划:7月份确定好机票事宜,7月底看看父母和老朋友,再找点课上。睡眠休息:244h2m。日均8.13小时,平均每天再加上午休40分钟左右,大概日剧8.8小时。工作:222h28m。日均工作8.5-9小时左右。吃漱杂事:72h5m。主要是四个周末每天日均6小时左右,工作日一般没算。运动:66h58m。打羽毛球大概20次,付费的大概15次,有一周每天

- 真正不充钱的经典复古传奇手游有哪些 真正不充钱的传奇手游排行榜2023

会飞滴鱼儿

游戏一直以来都是游戏玩家们非常喜爱的产品,其便捷的游戏体验和丰富的游戏内容吸引了众多爱好者。在众多的传奇游戏网站中,哪些最热门呢?现在对于传奇手游,玩家最注重的就是游戏内部号的由来,这类账号不仅每日都有运营商328-1688免费充值卡礼包,还有兑换码礼包,道具扶持礼包,所以普通玩家一对比,基本难以生存,好了,下面就给大家盘点几个知名内部号官网!对此推荐的热门传奇游戏网站有三个:1.游人特权站官网2

- 【Java从入门到起飞】初始Java

I'm Joe

Javajava开发语言

文章目录1.Java语言概述1.1Java概述1.2Java语言简史1.3Java之父1.4Java技术体系平台1.5java的主要特性2.Java开发环境2.1Java语言跨平台的原理2.2什么是JDK、JRE、JVM2.3JDK的目录介绍3.注释(comment)4.JavaAPI文档5.Java核心机制:JVM5.1Java语言的优缺点5.1.1优点5.1.2缺点5.2JVM功能说明5.2.

- 2020-04-29 eMAGMA 基于基因的关联分析(Part1)

程凉皮儿

输入数据准备本教程要求eMAGMA文件,软件(MAGMA)和辅助文件都在同一个目录下如果你的文件在不同的目录上,请在命令行加入路径信息cd/path/yourworkingfolder/eMAGMA解压缩软件包及辅助文件:magma_v1.07b.zip,NCBI37.3.zip和MDD2018_excluding23andMe(下载自PGCwebsite).unzip[filename].zip

- 2023-02-11

再见连城诀

电脑还在扫描检测之中,我就选择用手机写了,虽然缓慢,但要坚持,只有坚持,才会越写越好。我检视这两个月以来的作文,能发现自己视野狭窄,题材都是个人生活和写作,首先是写的内容太局限,再加上文笔太差,自己也不满意。但是要从写作惯性中扩宽道路,还需更多的读、写、思、行来慢慢矫正。我不急,再写下去,三年五年,八年十年,会改变的。昨天晚上来到楚雄,打了电话给同学,邀请他来家小坐,他没有来,开车去接远方的朋友了

- 2019-8-12晚间日记

故梦笙笙

今天是什么日子起床:7:00就寝:23:00天气:晴心情:一般纪念日:无叫我起床的不是闹钟是梦想年度目标及关键点:考博,毕业本月重要成果:无成功日志-记录三五件有收获的事务无财务检视正常人际的投入无开卷有益-学习/读书/听书无健康与饮食今日步数:14000今日锻炼:无今日饮食:正常好习惯打卡英语流利说打卡30分钟单词30

- 一路有你的美好Day158

果果儿guoguo132328

我的赞美日记:1.赞美自己手下留情留下了一个未退出的宝藏群,获取了资源,节约了时间成本。2.赞美自己顺风车送了4位同事,接了公公下班。3.赞美自己面对突如其来的撂挑子,迎难而上,调动一切资源自己干。4.赞美自己陪久哥在户外玩了一个小时,看着他撒欢儿的与同学玩,终于认证转学是值得的。5.赞美自己听了宝琪老师的创业力课程,听了阿离的分享,践行莺歌老师的9点站。6.赞美自己给妹妹打气,分享能落地的干货,

- 20211102成就感日志297/365

kidII

我是kid,这是我的18/365进化日课。20211102奋斗是人生的底色,你会经历很多人事物,学会更多的东西。从学习上掌握技能,从学习上享受生活,即便是辛苦也没有关系,生活没有不辛苦的,但是要辛苦的有意义。与其说平凡的过一辈子,不如吃苦耐劳,选择自己喜欢的生活,一点点的付出,积累很多的经验,未来才会有希望。虽然我们渴望成就感,但也需要平衡生活,让自己越来越幸福。1.【日思】:今日最重要的一件事。

- Leetcode 523. Continuous Subarray Sum

SnailTyan

文章作者:Tyan博客:noahsnail.com|CSDN|1.DescriptionContinuousSubarraySum2.Solution解析:Version1,使用前缀和来解决,遍历数组,求前缀和,求前缀和与k的余数,余数在字典中存在时,则意味着当前前缀和减去之前的前缀和等于k的倍数,此时计算两个前缀和的长度差,如果大于等于2,则返回True,如果余数不存在,则将余数保存在字典中并记

- 前端学习笔记:React.js中state和props的区别和联系

文章目录1.`props`(属性)定义用途示例2.`state`(状态)定义用途示例3.核心区别4.常见使用场景props的场景state的场景5.交互模式父组件修改子组件状态子组件通知父组件6.最佳实践总结在React.js中,state和props是两个核心概念,用于管理组件的数据和数据流。它们的设计目的不同,但共同构成了React组件的状态管理系统。1.props(属性)定义外部传入的数据:

- 假传万卷书,真传一句话

刘川丙一年顶十年

【1】人做一件事最大的动力,有两大来源:追求快乐和逃离痛苦!【2】成功和失败最大的分野,来源于你是否下定决心。【3】一个人对钱没欲望,或者行动力不够,要么是不缺钱,要么是不欠钱。【4】在这个世界上你可以欺骗任何人,但你唯一不能欺骗的就是你自己。【5】我们所看到的世界,是我们选择看到的世界。事物本身没有好坏、对错,由我们自身的态度决定!【6】读书不能改变命运,用书才能!读一本书,做一个决定!

- Ansible:强大的自动部署工具

文章目录零、Ansible介绍一、安装ansible二、配置SSH密钥1.检查密钥是否存在2.两边的机器要互相有对方的密钥三、自动部署1.传输文件(1)inventory.ini(2)sync_blt.yml(3)执行命令2.安装软件(1)inventory.ini(2)install_efvs.yml(3)执行命令零、Ansible介绍Ansible是一个开源、易于使用的功能强大的IT自动化工具

- P9280 [AGM 2023 资格赛] Monty Hall 题解

Eason_cyx

数学建模贪心算法

一道数学题,有一点思维难度,代码难度为000。思路:每一次选的数都得相同,才可能打开所有的门。观察题目可以发现,这个数列是单调不下降的,所以我们从后往前考虑。先考虑i=ni=ni=n的情况:站在111号门前,移动nnn步后,又回到了111号门,死循环了,所以不考虑。而在i=n−1i=n-1i=n−1的情况下,可以走到所有的门。以此类推,前面的其实都可以。但是由于数列的单调性,最后一个可行的肯定是代

- 选举人制度下--用推特治国的总统

SCTCapital

特朗普从2017年1月20日正式成为美国第45任总统之后,一天不折腾就难受,花样层次不穷。除了这些,特朗普还有个最大的特点就是用推特治国,举世罕见!距离美国时间11月3日的总统大选日还有几天的时间,我们也会做几期大选专题,让各位更了解美国总统选举。现在、无论是民调还是摇摆州的支持率,都显示拜登领先于特朗普,不过也不见得拜登能躺着进入白宫。大家肯定记得2016年那届选举,希拉里的普通民众投票虽是高于

- SQLite可视化管理工具汇总

班力勤

程序员sqlitejvm数据库

截至2012/9/14最新版本SQLiteSpy1.9.1–28Jul2011单文件,界面设计紧凑,较稳定,功能较少,创建表与添加数据均需sql语句,快捷键教方便,作为数据浏览和修改工具极佳,视图编码为utf-8,对gbk2312显示乱码。能满足一般的应用,但没有导出数据表功能,同时只能打开一个数据库文件不支持二进制字段编辑2、SQLiteStudio(推荐)开源免费单文件http://sqlit

- 对股票分析时要注意哪些主要因素?

会飞的奇葩猪

股票 分析 云掌股吧

众所周知,对散户投资者来说,股票技术分析是应战股市的核心武器,想学好股票的技术分析一定要知道哪些是重点学习的,其实非常简单,我们只要记住三个要素:成交量、价格趋势、振荡指标。

一、成交量

大盘的成交量状态。成交量大说明市场的获利机会较多,成交量小说明市场的获利机会较少。当沪市的成交量超过150亿时是强市市场状态,运用技术找综合买点较准;

- 【Scala十八】视图界定与上下文界定

bit1129

scala

Context Bound,上下文界定,是Scala为隐式参数引入的一种语法糖,使得隐式转换的编码更加简洁。

隐式参数

首先引入一个泛型函数max,用于取a和b的最大值

def max[T](a: T, b: T) = {

if (a > b) a else b

}

因为T是未知类型,只有运行时才会代入真正的类型,因此调用a >

- C语言的分支——Object-C程序设计阅读有感

darkblue086

applec框架cocoa

自从1972年贝尔实验室Dennis Ritchie开发了C语言,C语言已经有了很多版本和实现,从Borland到microsoft还是GNU、Apple都提供了不同时代的多种选择,我们知道C语言是基于Thompson开发的B语言的,Object-C是以SmallTalk-80为基础的。和C++不同的是,Object C并不是C的超集,因为有很多特性与C是不同的。

Object-C程序设计这本书

- 去除浏览器对表单值的记忆

周凡杨

html记忆autocompleteform浏览

&n

- java的树形通讯录

g21121

java

最近用到企业通讯录,虽然以前也开发过,但是用的是jsf,拼成的树形,及其笨重和难维护。后来就想到直接生成json格式字符串,页面上也好展现。

// 首先取出每个部门的联系人

for (int i = 0; i < depList.size(); i++) {

List<Contacts> list = getContactList(depList.get(i

- Nginx安装部署

510888780

nginxlinux

Nginx ("engine x") 是一个高性能的 HTTP 和 反向代理 服务器,也是一个 IMAP/POP3/SMTP 代理服务器。 Nginx 是由 Igor Sysoev 为俄罗斯访问量第二的 Rambler.ru 站点开发的,第一个公开版本0.1.0发布于2004年10月4日。其将源代码以类BSD许可证的形式发布,因它的稳定性、丰富的功能集、示例配置文件和低系统资源

- java servelet异步处理请求

墙头上一根草

java异步返回servlet

servlet3.0以后支持异步处理请求,具体是使用AsyncContext ,包装httpservletRequest以及httpservletResponse具有异步的功能,

final AsyncContext ac = request.startAsync(request, response);

ac.s

- 我的spring学习笔记8-Spring中Bean的实例化

aijuans

Spring 3

在Spring中要实例化一个Bean有几种方法:

1、最常用的(普通方法)

<bean id="myBean" class="www.6e6.org.MyBean" />

使用这样方法,按Spring就会使用Bean的默认构造方法,也就是把没有参数的构造方法来建立Bean实例。

(有构造方法的下个文细说)

2、还

- 为Mysql创建最优的索引

annan211

mysql索引

索引对于良好的性能非常关键,尤其是当数据规模越来越大的时候,索引的对性能的影响越发重要。

索引经常会被误解甚至忽略,而且经常被糟糕的设计。

索引优化应该是对查询性能优化最有效的手段了,索引能够轻易将查询性能提高几个数量级,最优的索引会比

较好的索引性能要好2个数量级。

1 索引的类型

(1) B-Tree

不出意外,这里提到的索引都是指 B-

- 日期函数

百合不是茶

oraclesql日期函数查询

ORACLE日期时间函数大全

TO_DATE格式(以时间:2007-11-02 13:45:25为例)

Year:

yy two digits 两位年 显示值:07

yyy three digits 三位年 显示值:007

- 线程优先级

bijian1013

javathread多线程java多线程

多线程运行时需要定义线程运行的先后顺序。

线程优先级是用数字表示,数字越大线程优先级越高,取值在1到10,默认优先级为5。

实例:

package com.bijian.study;

/**

* 因为在代码段当中把线程B的优先级设置高于线程A,所以运行结果先执行线程B的run()方法后再执行线程A的run()方法

* 但在实际中,JAVA的优先级不准,强烈不建议用此方法来控制执

- 适配器模式和代理模式的区别

bijian1013

java设计模式

一.简介 适配器模式:适配器模式(英语:adapter pattern)有时候也称包装样式或者包装。将一个类的接口转接成用户所期待的。一个适配使得因接口不兼容而不能在一起工作的类工作在一起,做法是将类别自己的接口包裹在一个已存在的类中。 &nbs

- 【持久化框架MyBatis3三】MyBatis3 SQL映射配置文件

bit1129

Mybatis3

SQL映射配置文件一方面类似于Hibernate的映射配置文件,通过定义实体与关系表的列之间的对应关系。另一方面使用<select>,<insert>,<delete>,<update>元素定义增删改查的SQL语句,

这些元素包含三方面内容

1. 要执行的SQL语句

2. SQL语句的入参,比如查询条件

3. SQL语句的返回结果

- oracle大数据表复制备份个人经验

bitcarter

oracle大表备份大表数据复制

前提:

数据库仓库A(就拿oracle11g为例)中有两个用户user1和user2,现在有user1中有表ldm_table1,且表ldm_table1有数据5千万以上,ldm_table1中的数据是从其他库B(数据源)中抽取过来的,前期业务理解不够或者需求有变,数据有变动需要重新从B中抽取数据到A库表ldm_table1中。

- HTTP加速器varnish安装小记

ronin47

http varnish 加速

上午共享的那个varnish安装手册,个人看了下,有点不知所云,好吧~看来还是先安装玩玩!

苦逼公司服务器没法连外网,不能用什么wget或yum命令直接下载安装,每每看到别人博客贴出的在线安装代码时,总有一股羡慕嫉妒“恨”冒了出来。。。好吧,既然没法上外网,那只能麻烦点通过下载源码来编译安装了!

Varnish 3.0.4下载地址: http://repo.varnish-cache.org/

- java-73-输入一个字符串,输出该字符串中对称的子字符串的最大长度

bylijinnan

java

public class LongestSymmtricalLength {

/*

* Q75题目:输入一个字符串,输出该字符串中对称的子字符串的最大长度。

* 比如输入字符串“google”,由于该字符串里最长的对称子字符串是“goog”,因此输出4。

*/

public static void main(String[] args) {

Str

- 学习编程的一点感想

Cb123456

编程感想Gis

写点感想,总结一些,也顺便激励一些自己.现在就是复习阶段,也做做项目.

本专业是GIS专业,当初觉得本专业太水,靠这个会活不下去的,所以就报了培训班。学习的时候,进入状态很慢,而且当初进去的时候,已经上到Java高级阶段了,所以.....,呵呵,之后有点感觉了,不过,还是不好好写代码,还眼高手低的,有

- [能源与安全]美国与中国

comsci

能源

现在有一个局面:地球上的石油只剩下N桶,这些油只够让中国和美国这两个国家中的一个顺利过渡到宇宙时代,但是如果这两个国家为争夺这些石油而发生战争,其结果是两个国家都无法平稳过渡到宇宙时代。。。。而且在战争中,剩下的石油也会被快速消耗在战争中,结果是两败俱伤。。。

在这个大

- SEMI-JOIN执行计划突然变成HASH JOIN了 的原因分析

cwqcwqmax9

oracle

甲说:

A B两个表总数据量都很大,在百万以上。

idx1 idx2字段表示是索引字段

A B 两表上都有

col1字段表示普通字段

select xxx from A

where A.idx1 between mmm and nnn

and exists (select 1 from B where B.idx2 =

- SpringMVC-ajax返回值乱码解决方案

dashuaifu

AjaxspringMVCresponse中文乱码

SpringMVC-ajax返回值乱码解决方案

一:(自己总结,测试过可行)

ajax返回如果含有中文汉字,则使用:(如下例:)

@RequestMapping(value="/xxx.do") public @ResponseBody void getPunishReasonB

- Linux系统中查看日志的常用命令

dcj3sjt126com

OS

因为在日常的工作中,出问题的时候查看日志是每个管理员的习惯,作为初学者,为了以后的需要,我今天将下面这些查看命令共享给各位

cat

tail -f

日 志 文 件 说 明

/var/log/message 系统启动后的信息和错误日志,是Red Hat Linux中最常用的日志之一

/var/log/secure 与安全相关的日志信息

/var/log/maillog 与邮件相关的日志信

- [应用结构]应用

dcj3sjt126com

PHPyii2

应用主体

应用主体是管理 Yii 应用系统整体结构和生命周期的对象。 每个Yii应用系统只能包含一个应用主体,应用主体在 入口脚本中创建并能通过表达式 \Yii::$app 全局范围内访问。

补充: 当我们说"一个应用",它可能是一个应用主体对象,也可能是一个应用系统,是根据上下文来决定[译:中文为避免歧义,Application翻译为应

- assertThat用法

eksliang

JUnitassertThat

junit4.0 assertThat用法

一般匹配符1、assertThat( testedNumber, allOf( greaterThan(8), lessThan(16) ) );

注释: allOf匹配符表明如果接下来的所有条件必须都成立测试才通过,相当于“与”(&&)

2、assertThat( testedNumber, anyOf( g

- android点滴2

gundumw100

应用服务器android网络应用OSHTC

如何让Drawable绕着中心旋转?

Animation a = new RotateAnimation(0.0f, 360.0f,

Animation.RELATIVE_TO_SELF, 0.5f, Animation.RELATIVE_TO_SELF,0.5f);

a.setRepeatCount(-1);

a.setDuration(1000);

如何控制Andro

- 超简洁的CSS下拉菜单

ini

htmlWeb工作html5css

效果体验:http://hovertree.com/texiao/css/3.htmHTML文件:

<!DOCTYPE html>

<html xmlns="http://www.w3.org/1999/xhtml">

<head>

<title>简洁的HTML+CSS下拉菜单-HoverTree</title>

- kafka consumer防止数据丢失

kane_xie

kafkaoffset commit

kafka最初是被LinkedIn设计用来处理log的分布式消息系统,因此它的着眼点不在数据的安全性(log偶尔丢几条无所谓),换句话说kafka并不能完全保证数据不丢失。

尽管kafka官网声称能够保证at-least-once,但如果consumer进程数小于partition_num,这个结论不一定成立。

考虑这样一个case,partiton_num=2

- @Repository、@Service、@Controller 和 @Component

mhtbbx

DAOspringbeanprototype

@Repository、@Service、@Controller 和 @Component 将类标识为Bean

Spring 自 2.0 版本开始,陆续引入了一些注解用于简化 Spring 的开发。@Repository注解便属于最先引入的一批,它用于将数据访问层 (DAO 层 ) 的类标识为 Spring Bean。具体只需将该注解标注在 DAO类上即可。同时,为了让 Spring 能够扫描类

- java 多线程高并发读写控制 误区

qifeifei

java thread

先看一下下面的错误代码,对写加了synchronized控制,保证了写的安全,但是问题在哪里呢?

public class testTh7 {

private String data;

public String read(){

System.out.println(Thread.currentThread().getName() + "read data "

- mongodb replica set(副本集)设置步骤

tcrct

javamongodb

网上已经有一大堆的设置步骤的了,根据我遇到的问题,整理一下,如下:

首先先去下载一个mongodb最新版,目前最新版应该是2.6

cd /usr/local/bin

wget http://fastdl.mongodb.org/linux/mongodb-linux-x86_64-2.6.0.tgz

tar -zxvf mongodb-linux-x86_64-2.6.0.t

- rust学习笔记

wudixiaotie

学习笔记

1.rust里绑定变量是let,默认绑定了的变量是不可更改的,所以如果想让变量可变就要加上mut。

let x = 1; let mut y = 2;

2.match 相当于erlang中的case,但是case的每一项后都是分号,但是rust的match却是逗号。

3.match 的每一项最后都要加逗号,但是最后一项不加也不会报错,所有结尾加逗号的用法都是类似。

4.每个语句结尾都要加分

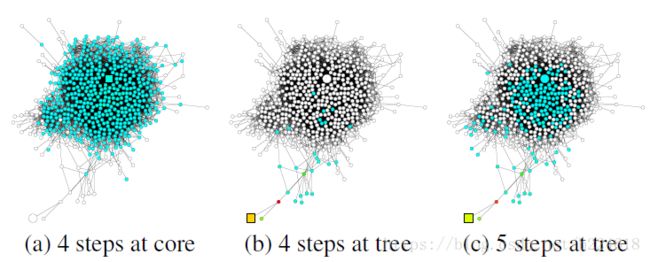

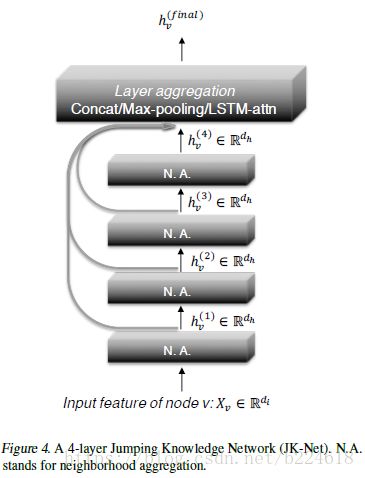

![]() (这里面1~k代表layer的层数,h是hidden state,v代表某一个节点),然后进行线性变换,如果进行线性变换的权重是所有节点共享的,那么这个就不是针对每个节点进行适应、调节的,否则就是。

(这里面1~k代表layer的层数,h是hidden state,v代表某一个节点),然后进行线性变换,如果进行线性变换的权重是所有节点共享的,那么这个就不是针对每个节点进行适应、调节的,否则就是。![]() 给第l层的节点v的输出,这样,每一个节点最终的输出是

给第l层的节点v的输出,这样,每一个节点最终的输出是![]() ,不同的节点分配给不同layer的attention score不同,就能实现每一个节点聚合信息时都可以选择合适自己的neighborhood range。至于LSTM是这样的,

,不同的节点分配给不同layer的attention score不同,就能实现每一个节点聚合信息时都可以选择合适自己的neighborhood range。至于LSTM是这样的,![]() 都输入到一个双向的LSTM中,forward-LSTM和backward-LSTM的结果合并起来,经过线性映射得到每一layer每个节点v的一个importance score,然后这个score经过softmax得到attention。而最终的输出是双向LSTM的输出经过attention score的加权求和得到的。

都输入到一个双向的LSTM中,forward-LSTM和backward-LSTM的结果合并起来,经过线性映射得到每一layer每个节点v的一个importance score,然后这个score经过softmax得到attention。而最终的输出是双向LSTM的输出经过attention score的加权求和得到的。