NuPlayer介绍

简介

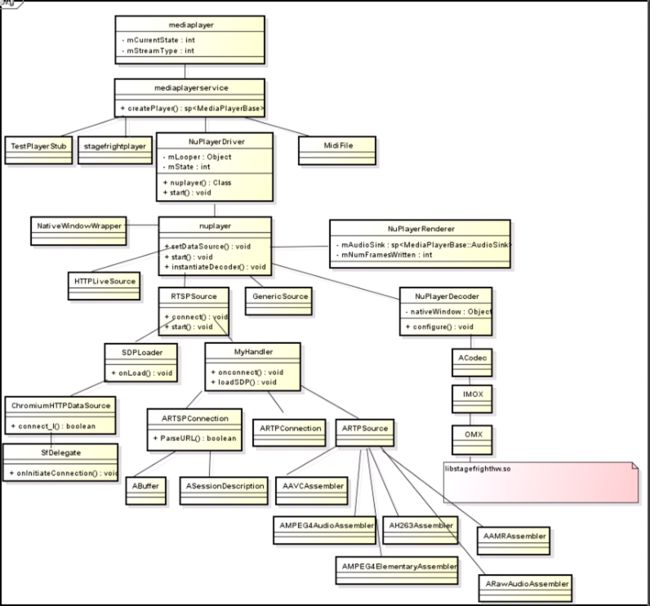

Android2.3时引入流媒体框架,而流媒体框架的核心是NuPlayer。Android4.0之后HttpLive和RTSP协议开始使用NuPlayer播放器,Android5.0(L版本)之后本地播放也开始使用NuPlayer播放器。

视频是如何播放的

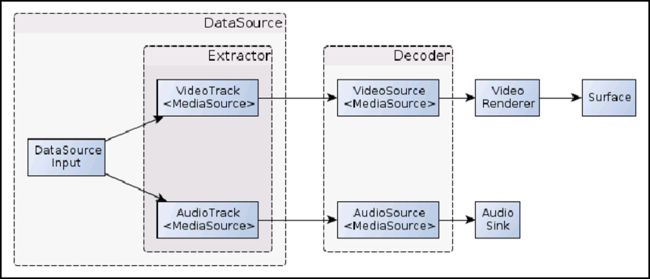

- 上面框图中的DataSourceInput(或者直接叫DataSource)指的是单纯的数据输入(未demux的)。

- 在后文中setDataSource中DataSource指的是从数据输入到demux输出的一个过程(即图中最外层的DataSource)。

VideoTrack与AudioTrack指的是Extractor(即demux)的两个通道,从这里输出的分别就是单纯的解复用后的Video和Audio流。再经过Decoder后输出的就是音、视频的输出了:

- VideoRenderer + Surface即视频的输出;

- AudioSink即音频的输出;

NuPlayerDriver.cpp

Ahandle机制

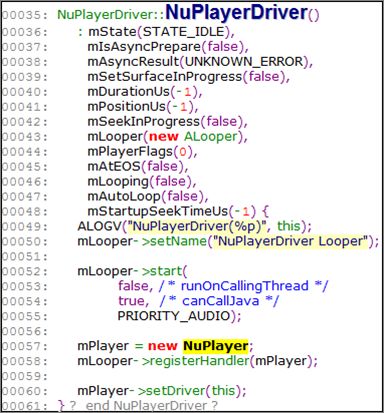

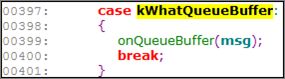

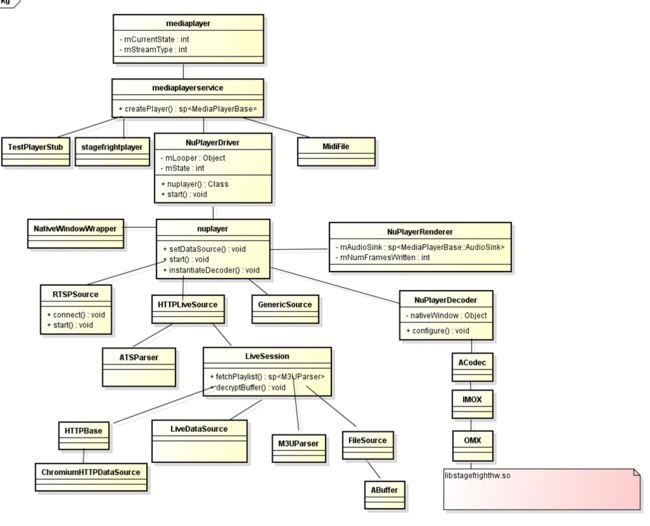

初始化NuPlayer对象,并进入NuPlayer播放流程,其实NuPlayer实现的是Ahandle机制:

![]()

- Android5.0之前,StageFright架构使用的传递消息机制是TimedEventQueue模型

- Android升级到5.0之后,NuPlayer使用的是AHandler消息机制,类似于Handler

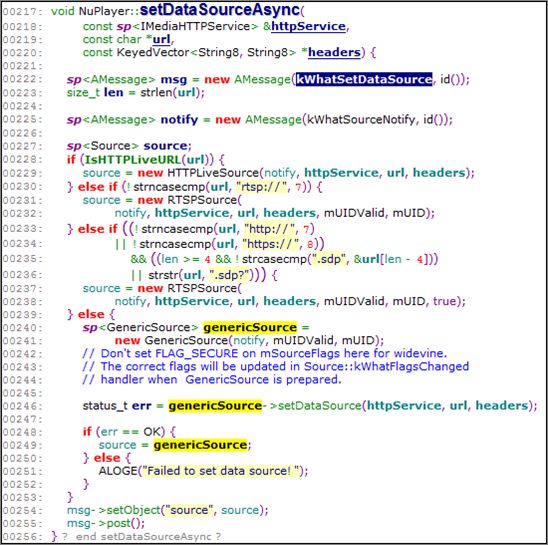

NuPlayer::setDataSourceAsync

NuPlayer获取DataSource通过URI的前缀判断媒体类型,比如http、rtsp,还是本地播放,然后创建相应的DataSource,走入相应流程。根据URI创建相应的DataSource,再进一步的利用DataSource创建MediaExtractor做A/V分离。

NuPlayer::onMessageReceived

OnMessageReceived是Nuplayer的核心部分,大部分消息的实现均在OnMessageReceived中完成

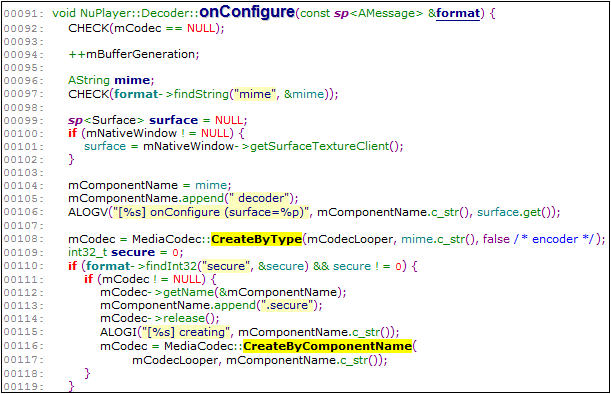

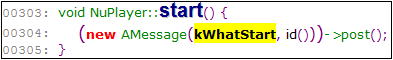

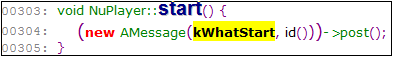

环境及相应DataSource都准备好以后,上层发送start开始播放流程以后,开始创建解码器

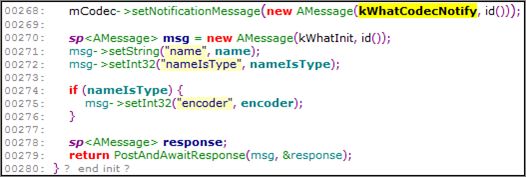

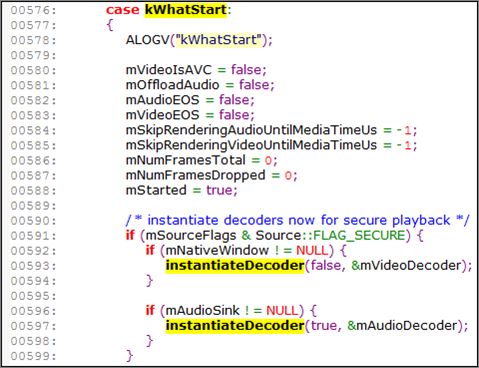

创建解码器

![]()

NuPlayerDecoder.cpp

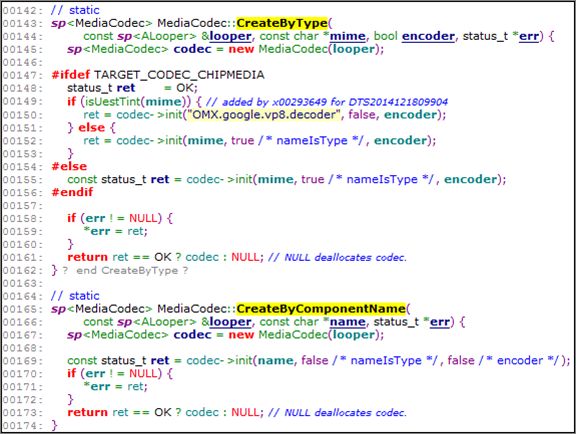

MediaCodec::CreateByType

MediaCodec::onMessageReceived

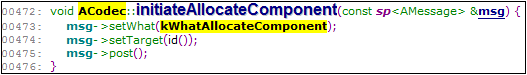

ACodec::initiateAllocateComponent

ACodec::onAllocateComponet

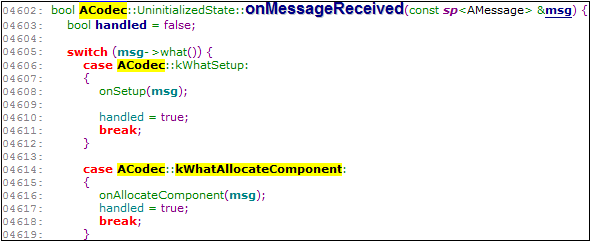

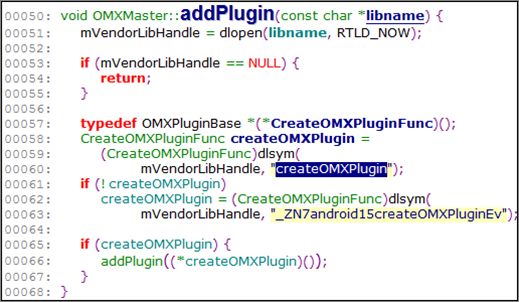

OMXMaster::addPlugin

OMX的创建干了两件事,第一,初始化OMXMaster加载第三方解码器;第二,初始化节点数,为分配正在可用节点。

音视频同步

- 在NuPlayer框架中,音视频同步的工作是由Renderer来完成的,而在StageFright框架, Render是显示用的。

- NuPlayer框架中,音视频同步的策略是音/视频往后delay,被动同步,而不会主动seek;简单讲就是如果视频来早了会等一下音频,如果视频来晚了会通过丢帧机制同步,连续丢帧直到音视频同步上为止,

因为音频太敏感,所以只视频做此处理,而音频不做这样的处理,总之策略就是:视频早等晚丢。 - Stagefright框架中,音视频同步的策略是,视频向前向后双向同步,too late时video会主动往前seek;too early的时候video会delay

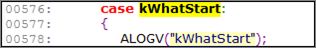

- 在NuPlayer的start步骤中,新建了一个Renderer的循环线程mRendererLooper,并且把mRenderer作为这个循环线程的Handler,在这个线程内对音视频数据进行同步、送显等操作

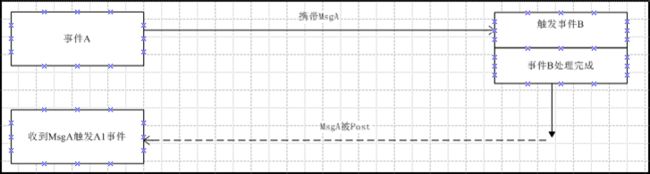

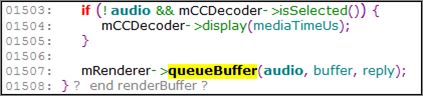

NuPlayer::renderBuffer

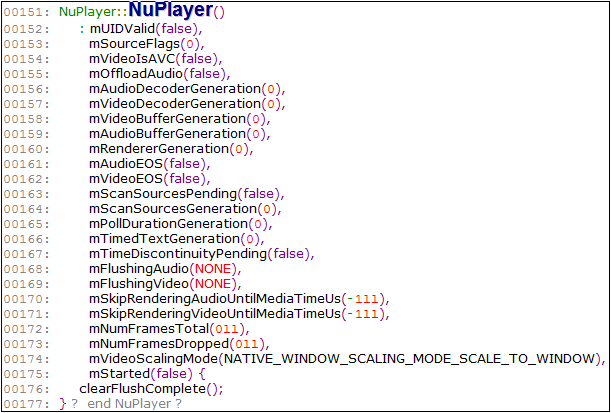

当收到解码器kWhatDrainThisBuffer消息时,NuPlayer会调用到renderBuffer函数,renderBuffer直接调用mRenderer中的queueBuffer函数。

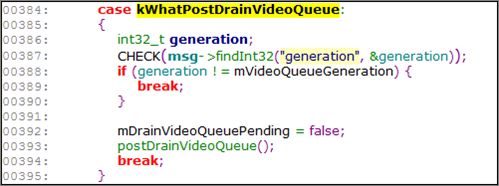

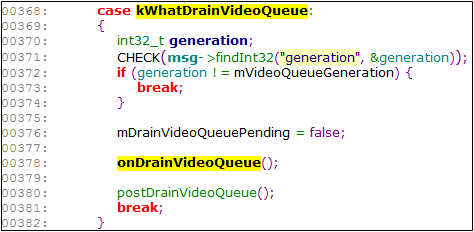

![]()

![]()

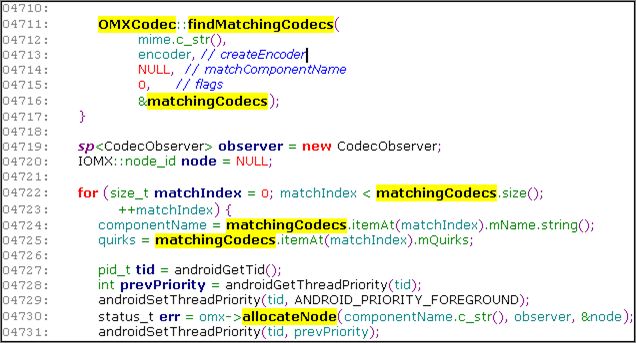

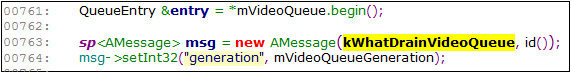

NuPlayerRenderer::queueBuffer

queueBuffer主要发送kWhatQueueBuffer消息,并在接收到kWhatQueueBuffer消息后调用onQueueBuffer函数,函数onQueueBuffer中对于音频和视频数据队列进行push_back和postDrainQueue操作,push_back就是往renderer中的数据队列中存放数据, postDrainQueue就是从renderer的数据队列中取数据,往外送显,因此可以看出renderer中的数据队列实际上只是个中转站,就是为了实现音视频同步。

NuPlayerRenderer::onQueueBuffer

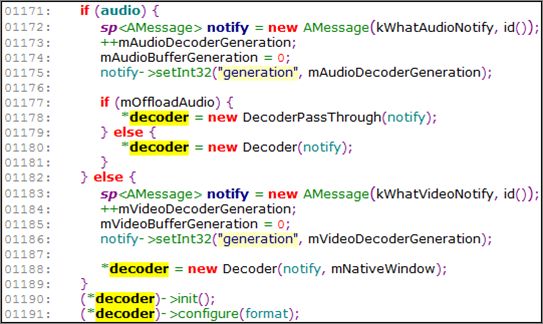

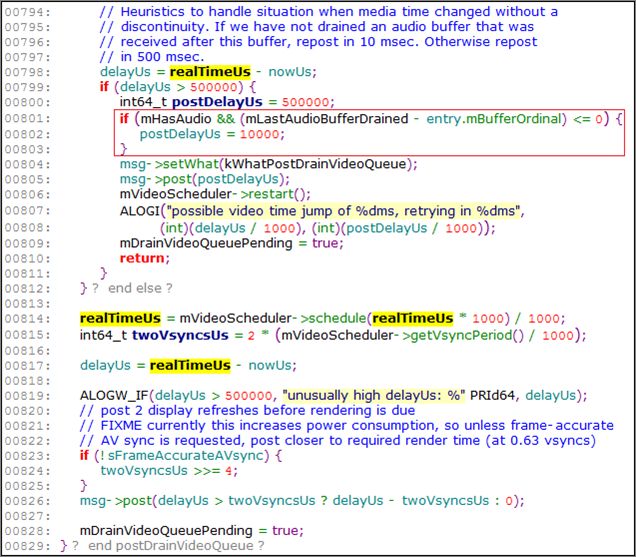

NuPlayerRenderer::postDrainVideoQueue

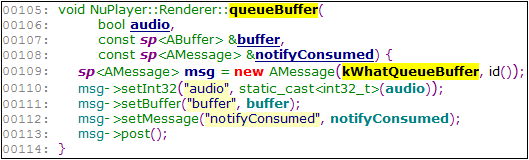

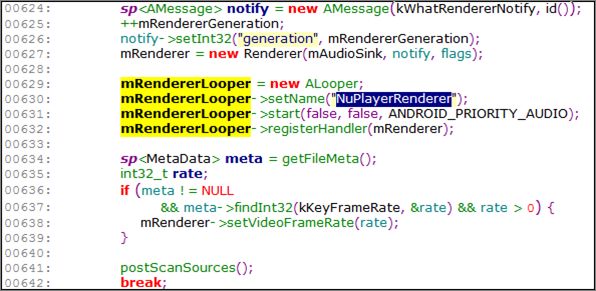

音视频同步的函数postDrainVideoQueue()(视频early情况)

![]()

判断repost的时间是10ms,还是500ms,根据下面分支判断(上一个时间戳序号减去当前时间戳序号) 。mLastAudioBufferDrained - entry.mBufferOrdinal) <= 0,一般情况下这个值均小于0,所以NuPlayer里面一般repost时间为500ms。

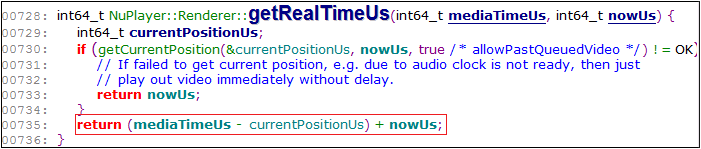

NuPlayerRenderer::postDrainVideoQueue

DelayUs的计算:

delayUs = realTimeUs – nowUs

realTimeUs = (mediaTimeUs - currentPositionUs) + nowUs

currentPositionUs = (nowUs - mAnchorTimeRealUs) + mAnchorTimeMediaUs

==》realTimeUs = mediaTimeUs – mAnchorTimeMediaUs +

mAnchorTimeRealUs

mediaTimeUs为传入的时间, mAnchorTimeMediaUs为音频上一帧的时间戳,mAnchorTimeRealUs为播放的起锚时间戳,前2者相减获取当前播放的时间长度,再加上起锚时间从而得到当前的系统时间戳。

nowUs是当前时间,通过函数GetNowUs()获取,每次重新获取的时间都不一样,若不重新获取,一直沿用前面获取的时间值。

如果现在的时间点比预计要播放的时间点提前了500ms以上,就要等,则延时10ms再发送kWhatPostDrainVideoQueue消息,接收到这个消息后继续走回postDrainVideoQueue函数中,即做了10ms的等待。

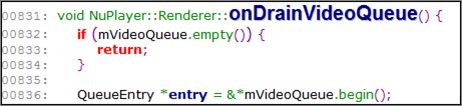

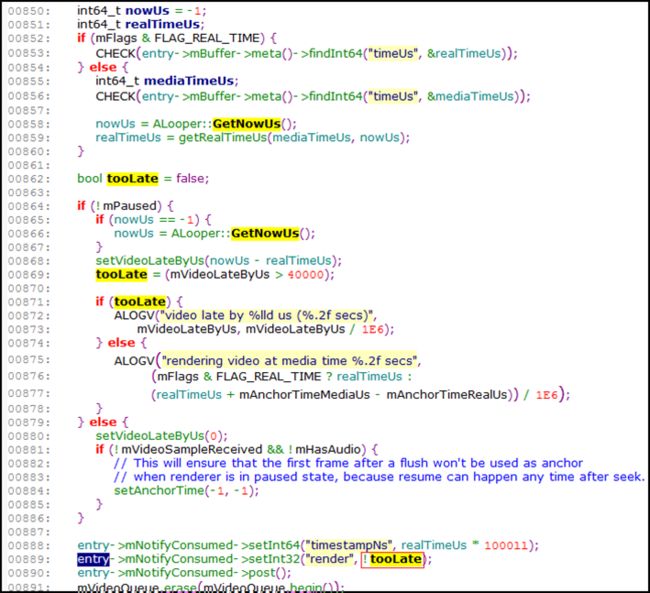

音视频同步的函数onDrainVideoQueue()(视频late情况)

Too Late用来标记是否视频数据现在播放的时间比预期播放的时间晚40ms以上,如果超过40ms,说明现在播放这段数据的时间太晚,要是继续播放这段数据就会主观感觉到视频画面滞后,所以丢弃这段视频数据。

流媒体简介

- 流媒体是Android2.3时引入的,流媒体框架的核心是NuPlayer,目前流媒体的协议类型主要有:HttpLive、RTSP、HTTP

- HttpLive和RTSP协议在Android4.0之后开始使用NuPlayer播放器

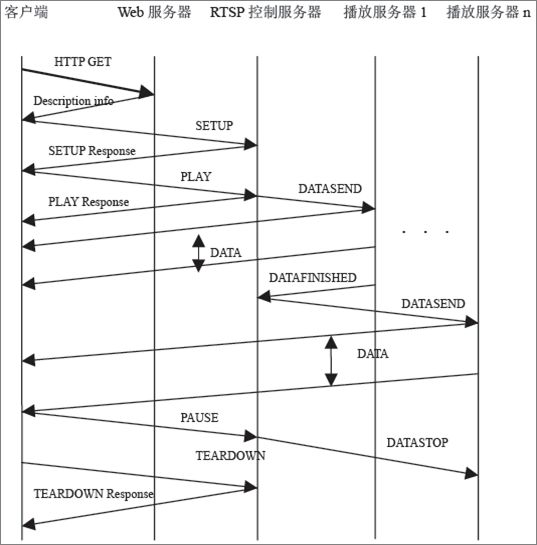

- RTSP是由Real network 和Netscape共同提出的如何有效地在IP网络上传输流媒体数据的应用层实时流协议

- 用于远程建立和控制多媒体流,可以同时进行多个流

- 多媒体流的传输控制部分由RTP/RTCP负责,协议消息的承载可以是TCP和UDP

- 语法上和HTTP相似,但它是有状态协议(HTTP是无状态协议)

RTSP

- RTP(Real-time Transport Protocol)

RTP是用于Internet上针对多媒体数据流的一种传输层协议,它详细说明了在互联网上传递音频和视频的标准数据包格式 - RTCP (Real-time Transport Control Protocol

) RTCP是实时传输协议(RTP)的一个姐妹协议,RTCP为RTP媒体流提供信道外(out-of-band)控制,RTCP本身并不传输数据,但和RTP一起协作将多媒体数据打包和发送,RTCP定期在流多媒体会话参加者之间传输控制数据

简单总结:RTSP发起、终结流媒体,RTP媒体数据载体 、RTCP对RTP进行控制、同步

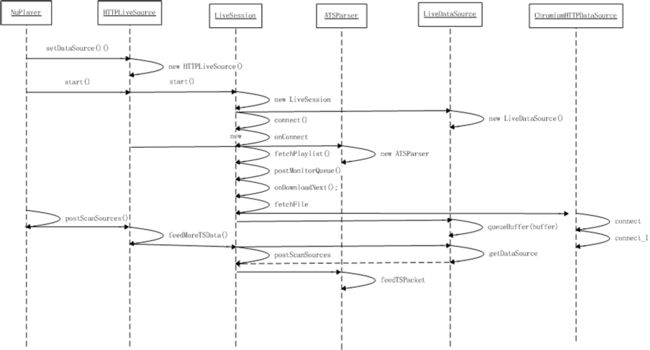

HttpLive

- HTTPLiveStreaming(缩写是HLS)

是一个由苹果公司提出的基于HTTP的流媒体网络传输协议,它允许内容提供者通过普通Web服务器向上述客户端提供接近实时的音视频流媒体服务,包括直播和点播;HLS支持将同一节目编码为不同码率的多个替换流,客户端软件可以根据网络带宽的变化在这些不同码率的替换流之间进行智能切换 - M3U8码流

M3U8文件是HTTPLive服务器在创建视频源的时候,会创建一个包含各媒体文件引用的索引文件,索引文件被保存为.M3U8文件,这是保存MP3播放列表的.m3u格式的一种扩展

媒体库相关代码路径:

*framework/av/media

framework/base/media

vendor/hisi/ap/hardware/vcodec

vendor/hisi/thirdparty/vcodec/chipmedia/

/vendor/opensource/ffmpeg/

vendor/thirdparty/videocodec/helix/*