NIPS2018深度学习(15)|亮点: 新型GAN;新型CNN(论文及代码)

[1] On GANs and GMMs

Eitan Richardson, Yair Weiss

The Hebrew University of Jerusalem

https://papers.nips.cc/paper/7826-on-gans-and-gmms.pdf

在机器学习领域中,学者们一直在研究如何利用无监督方法来学习高维空间中的统计结构。近几年,学者们围绕GANs来解决这个问题,已经有学者利用GAN生成非常真实的高分辨率采样图像。

但是,GANs有一些问题,比如它会丢失一些模式,而不能对完整的分布进行建模,而且除了生成图像之外,GANs所学到的模型很难用于其它任务。

这篇文章主要将GANs与比较简单的统计模型,高斯混合模型,进行对比。首先给出一种简单方法,利用落入实现给定区间的样本占比来评估生成式模型。跟之前评估模型的自动化方法不同,本文的方法不依赖额外的神经网络,也不需要特别复杂的计算。

作者们在相同数据集上对比了GANs和高斯混合模型的效果。高斯混合模型能够对小块的图像进行比较好的建模,作者们尝试将高斯混合模型用于原始的整块的图像。该文作者发现高斯混合模型能够生成真实的样本,也可以学到整体的分布,而GANs就做不到。此外,高斯混合模型的推理比较高效,而且可以得到潜在统计结构的准确表示。

几种方法在CelebA上的效果对比如下

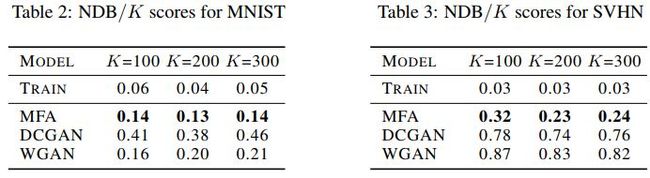

在MNIST和SVHN上的效果对比如下

代码地址

https://github.com/eitanrich/gans-n-gmms

![]() 我是分割线

我是分割线![]()

[2] Deep Generative Models for Distribution-Preserving Lossy Compression

Michael Tschannen, Eirikur Agustsson, Mario Lucic

ETH Zürich, Google AI Perception, Google Brain

https://papers.nips.cc/paper/7833-deep-generative-models-for-distribution-preserving-lossy-compression.pdf

这篇文章主要讨论保分布有损压缩。图像压缩已经可以做到无伪影的重构,即使位速率比较低也可以做到这种重构,在重构的样本服从训练样本分布的前提下,可以对位速率和失真度之间进行折中。在位速率的时候可以得到生成式模型,位速率足够高时所得到的重构效果非常好。对于中间的位速率,既可以学到生成式模型,又可以完美的重构训练样本。

为近似解决本文所提出的优化问题,作者们将Wasserstein GAN和Wasserstein 自编码进行了结合。

本文所提出的方法图示如下

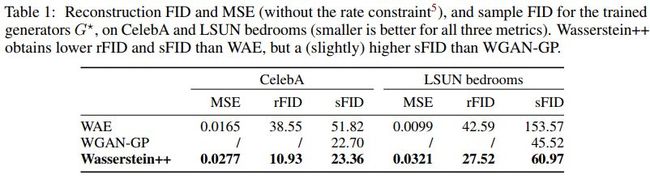

几种方法的效果对比如下

代码地址

https://github.com/mitscha/dplc

![]() 我是分割线

我是分割线![]()

[3] Constructing Fast Network through Deconstruction of Convolution

Yunho Jeon, Junmo Kim

KAIST

https://papers.nips.cc/paper/7835-constructing-fast-network-through-deconstruction-of-convolution.pdf

尽管卷积神经网络在多种计算机视觉任务中取得了很好的效果,但是所需要的计算量也比较大。如果增加网络深度或者宽度,准确率一般可以得以提升,但是,如果资源有限,重量级的网络可能不可用。

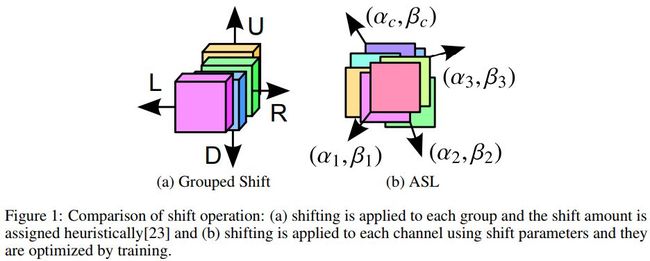

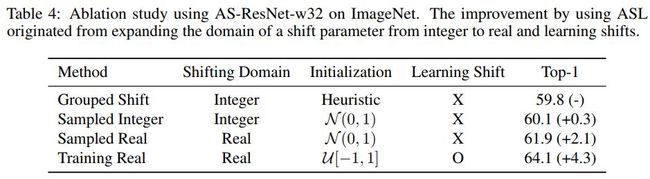

一般的卷积可以分解成平移操作和pointwise卷积。为了处理多个卷积,作者们提出一种新的平移操作,即主动平移层(ASL),该操作将总的平移形成一个可学习的函数,其中带有平移参数。

ASL可以利用反向传播端到端的优化,它可以给出最优的平移量。然后将这一层传入轻量级快速网络中,该框架效果非常好。

这篇文章的主要贡献在于

ASL跟另外一种平移对比图示如下

不同层的复杂度对比如下

不同堆叠单元复杂度对比如下

不同参数下跟ShiftNet的效果对比如下

不同情况下效果对比如下

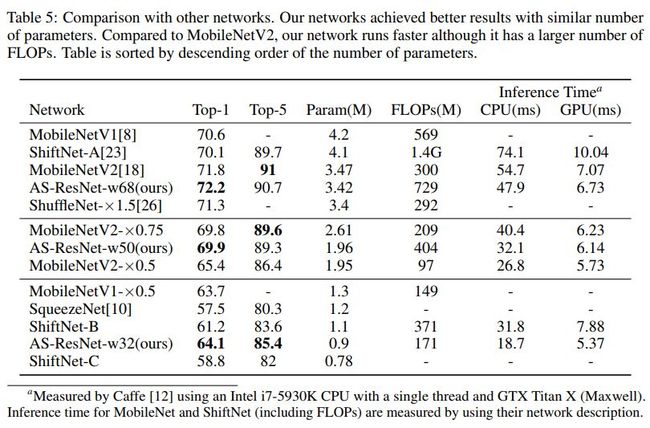

跟其他网络的效果对比如下

其中MobileNetV1对应的论文为

Mobilenets: Efficient convolutional neural networks for mobile vision applications

代码地址

https://github.com/Zehaos/MobileNet

ShiftNet-A对应的论文为

Shift: A zero flop, zero parameter alternative to spatial convolutions, CVPR 2018

代码地址

https://github.com/alvinwan/shiftresnet-cifar

MobileNetV2对应的论文为

Mobilenetv2: Inverted residuals and linear bottlenecks, CVPR 2018

代码地址

https://github.com/MG2033/MobileNet-V2

ShuffleNet-×1.5对应的论文为

Shufflenet: An extremely efficient convolutional neural network for mobile devices, CVPR 2018

代码地址

https://github.com/HolmesShuan/ShuffleNet-An-Extremely-Efficient-CNN-for-Mobile-Devices-Caffe-Reimplementation

https://github.com/camel007/Caffe-ShuffleNet

SqueezeNet对应的论文为

Squeezenet: Alexnet-level accuracy with 50x fewer parameters and< 0.5 mb model size

代码地址

https://github.com/DeepScale/SqueezeNet

AS-ResNet的网络结构如下

代码地址

https://github.com/jyh2986/Active-Shift

![]() 我是分割线

我是分割线![]()

您可能感兴趣