NIPS2018深度学习(10)|亮点:训练技巧;强化学习;GAN(论文及代码)

[1] Step Size Matters in Deep Learning

Kamil Nar, S. Shankar Sastry

University of California, Berkeley

https://papers.nips.cc/paper/7603-step-size-matters-in-deep-learning.pdf

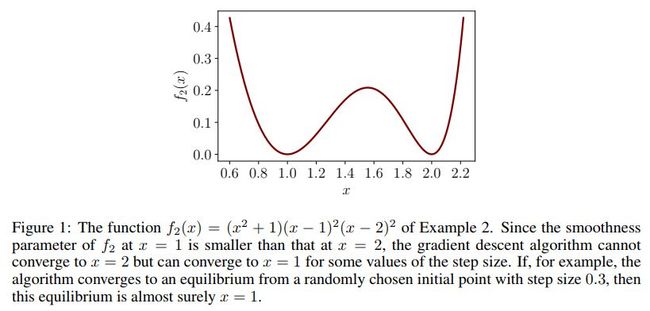

利用梯度下降算法训练神经网络时,能够得到离散的非线性的动态系统。此时,在训练过程中网络会收敛到不定的点,而不是固定的点,而且还依赖于初始状态。

在这些现象中,步长起到非常重要的作用。步长决定了局部最优解的子集,如果算法收敛到一个轨道上,步幅决定了在该轨道震动的幅度。为解释步长对神经网络的影响,作者们将梯度下降算法当做离散的动态系统来研究,通过分析不同解的李雅普诺夫稳定性,给出了步长和相应的解之间的关系。

作者们发现,随深度的增加训练误差会恶化,对具有较大奇异值的线性映射进行估计比较困难,该文作者还发现深度残差网络具有显著不同的性能。

具有多个局部最优解的函数示例如下

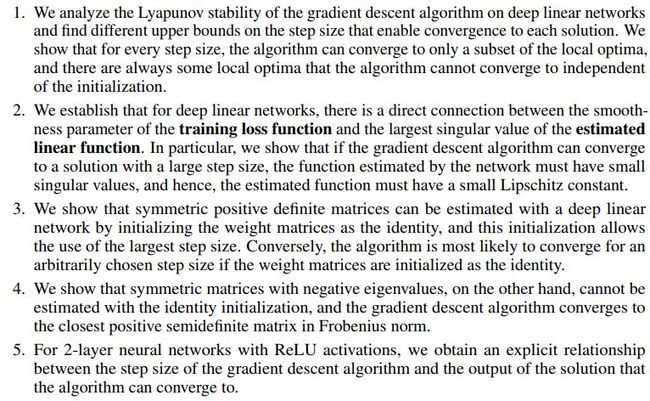

这篇文章的主要贡献如下

该文章跟先前工作的主要不同在于

不同步幅的影响如下

代码地址

https://github.com/nar-k/NeurIPS-2018

![]() 我是分割线

我是分割线![]()

[2] Learn What Not to Learn: Action Elimination with Deep Reinforcement Learning

Tom Zahavy, Matan Haroush, Nadav Merlis, Daniel J. Mankowitz, Shie Mannor

The Technion - Israel Institute of Technology, Google research, Deepmind

https://papers.nips.cc/paper/7615-learn-what-not-to-learn-action-elimination-with-deep-reinforcement-learning.pdf

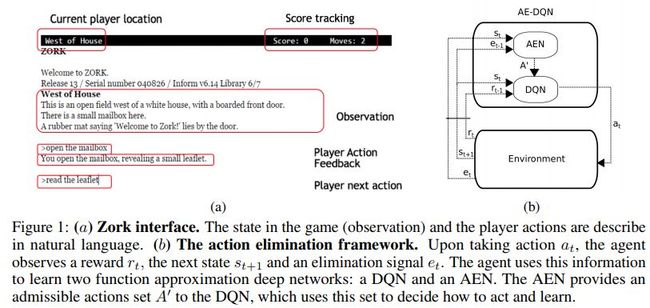

在强化学习中,如果在每个状态有多个可行的行动方案,学习怎么行动就会具有一定的挑战性,尤其是多个行动相互冗余或者不相关时更加具有挑战性。在这种情形下,有时候学习不执行哪些行动会更容易一些。

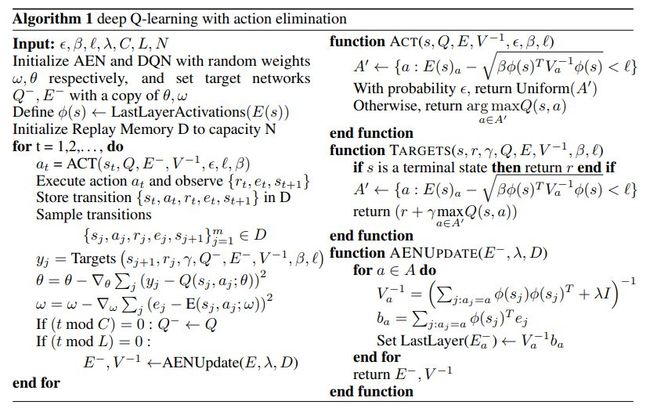

这篇文章提出了行动消除深层Q网络(AE-DQN),该网络结合了深层强化学习算法和行动消除网络(AEN),这里的行动消除网络能够消除掉次优的行动。AEN能够预测无效的行动,该预测中的监督信息是由环境提供的外部消除信号。该方法不仅可以加快训练速度,而且具有一定的鲁棒性。

网络结构示例如下

算法伪代码如下

几种方法的效果对比如下

相关论文

Text-based adventures of the golovin ai agent. CIG 2017

What can you do with a rock? affordance extraction via word embeddings, IJCAI 2017

代码地址

https://github.com/TomZahavy/CB_AE_DQN

![]() 我是分割线

我是分割线![]()

[3] BinGAN: Learning Compact Binary Descriptors with a Regularized GAN

Maciej Zieba, Piotr Semberecki, Tarek El-Gaaly, Tomasz Trzcinski Warsaw University of Technology, Voyage

https://papers.nips.cc/paper/7619-bingan-learning-compact-binary-descriptors-with-a-regularized-gan.pdf

这篇文章针对GAN提出了一种新的正则化方法,这种方法能够使得模型在图像块中学到具有判别性而且紧致的二值表示。该方法在判别性网络的中间层中进行降维,并且在倒数第二层训练二值低维表示,进而用来模拟前面层的高维分布。

作者们提出了两个损失项旨在:

降低在倒数第二层二值低维表示的维度之间的关联性,意即最大化联合熵;

将高维空间中各维度之间的关系传播到低维空间。

本文所提方法在图像匹配和图像检索任务中都取得了很好的效果。

在图像检索任务中,几种方法的效果对比如下

其中KMH对应的论文为

K-means hashing: An affinity-preserving quantization method for learning binary compact codes. CVPR 2013

SphH对应的论文为

Spherical hashing. CVPR 2012

代码地址

https://github.com/jp-sglab/Spherical_Hashing

SpeH对应的论文为

Spectral hashing. NIPS 2009

SH对应的论文为

Semantic hashing. IJAR 2009

PCAH对应的论文为

Semi-supervised hashing for scalable image retrieval. CVPR 2010

LSH对应的论文为

Near-optimal hashing algorithms for approximate nearest neighbor in high dimensions. FOCS 2006

PCA-ITQ对应的论文为

Iterative quantization: A procrustean approach to learning binary codes for large-scale image retrieval. TPAMI 2013

DH对应的论文为

Deep hashing for compact binary codes learning. CVPR 2015

DeepBit对应的论文为

Learning compact binary descriptors with unsupervised deep neural networks. CVPR 2016

DBD-MQ对应的论文为

Learning deep binary descriptor with multiquantization. CVPR 2017

在图像匹配任务中,几种方法的效果对比如下

其中LDAHash对应的论文为

LDAHash: Improved matching with smaller descriptors. TPAMI 2012

D-BRIEF对应的论文为

Efficient discriminative projections for compact binary descriptors. ECCV 2012

BinBoost对应的论文为

Boosting binary keypoint descriptors. CVPR 2013

RFD对应的论文为

Receptive fields selection for binary feature description. TIP 2014

Binary L2-Net对应的论文为

L2-net: Deep learning of discriminative patch descriptor in euclidean space. CVPR 2017

SIFT对应的论文为

Distinctive image features from scale-invariant keypoints. IJCV 2004

BRISK对应的论文为

BRISK: Binary robust invariant scalable keypoints. ICCV 2011

BRIEF对应的论文为

BRIEF: Binary robust independent elementary features. ECCV 2010

不同的参数设置对模型的影响如下

代码地址

https://github.com/maciejzieba/binGAN

![]() 我是分割线

我是分割线![]()

您可能感兴趣