NIPS2018深度学习(17)|亮点: 记忆重现GAN;图GAN;箱卷积(论文及代码)

[1] Memory Replay GANs: learning to generate images from new categories without forgetting

Chenshen Wu, Luis Herranz, Xialei Liu, Yaxing Wang, Joost van de Weijer, Bogdan Raducanu

Universitat Autònoma de Barcelona

https://papers.nips.cc/paper/7836-memory-replay-gans-learning-to-generate-new-categories-without-forgetting.pdf

之前,有学者利用序贯学习来解决判别式模型中的遗忘问题。这篇文章主要考虑生成式模型中如何解决遗忘问题。

作者们研究了如何利用生成式对抗网络 GANs在序列中学习新的类别。他们发现序列式的微调使得网络不能根据先前的类别生成合适的图像,这种现象就是遗忘现象。

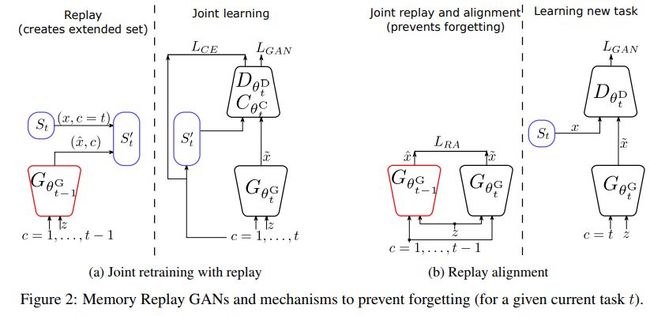

为了解决上述问题,作者们提出记忆重现GANs (MeRGANs),这是一种条件GAN框架,该框架融入了一种记忆重现的生成器。该文作者利用两种方法来防止遗忘,即基于重现的联合训练和重现对齐。

这种方法在MNIST,SVHN,LSUN等数据集上取得了很好的效果。

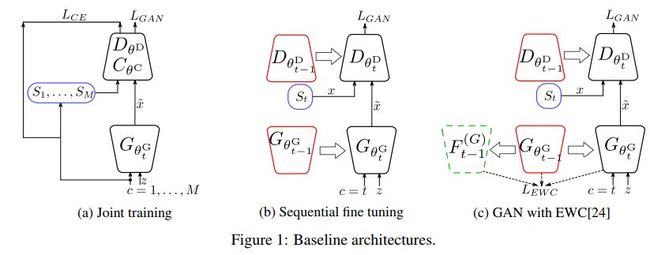

联合训练、序贯微调及弹性权重固定的GAN等图示如下

其中EWC为elastic weight consolidation。

基于重现的重新练以及重现的对齐图示如下

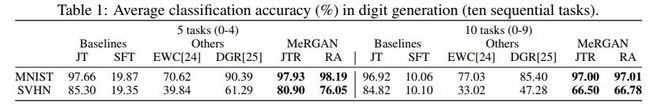

几种方法的准确率对比如下

其中EWC对应的论文为

Continual learning in generative adversarial nets. arXiv prepprint arXiv:1705.08395v1, 2017.

DGR对应的论文为

Continual learning with deep generative replay. NIPS, 2017.

代码地址

https://github.com/kuc2477/pytorch-deep-generative-replay

JT为joint training,SFT为sequential fine tuning,JTR为joint training with replay,RA为replay alignment

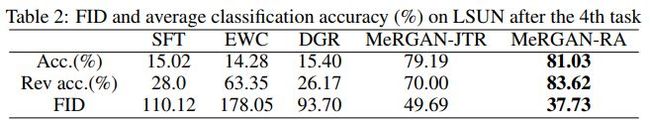

几种方法在数据集LSUN上的效果对比如下

其中FID为Frechet Inception Distance,该标准广泛用于衡量GAN生成的图像。Rev acc.为reverse accuracy,该准确率是在生成数据上训练真实数据上测试得到的准确率。

代码地址

https://github.com/WuChenshen/MeRGAN

![]() 我是分割线

我是分割线![]()

[2] Graphical Generative Adversarial Networks

Chongxuan Li, Max Welling, Jun Zhu, Bo Zhang

https://papers.nips.cc/paper/7846-graphical-generative-adversarial-networks.pdf

这篇文章提出图生成式对抗网络(Graphical-GAN),该网络能够对结构化数据进行建模。贝叶斯网络能够对随机变量之间的依赖结构进行比较好的压缩表示,生成式对抗网络能够很好地学习表达依赖函数,Graphical-GAN结合了上面两种优势。

作者们给出了结构化识别模型,它可以在给定样本之后推理隐含变量的后验分布。他们对期望传播算法进行了泛化,使其能够联合学习生成式模型和识别模型。Graphical-GAN有两种重要的特例,高斯混合GAN (GMGAN),状态空间GAN(SSGAN),前者能够学到数据集中的离散结构,后者能够学到数据集中的时序结构。

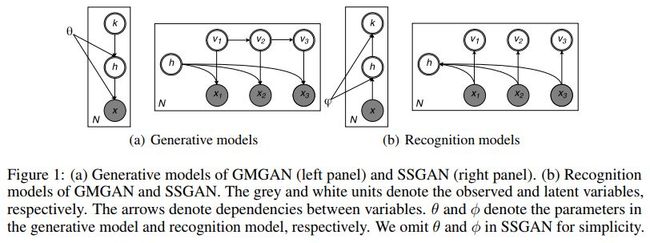

GMGAN和SSGAN两种结构对比如下

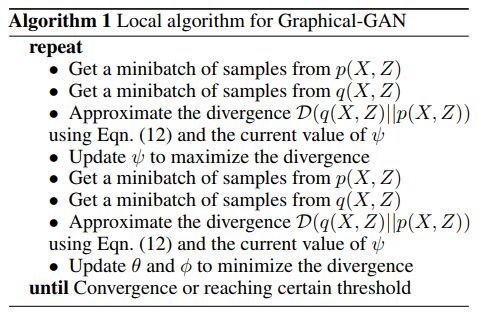

Graphical-GAN的局部算法伪代码如下

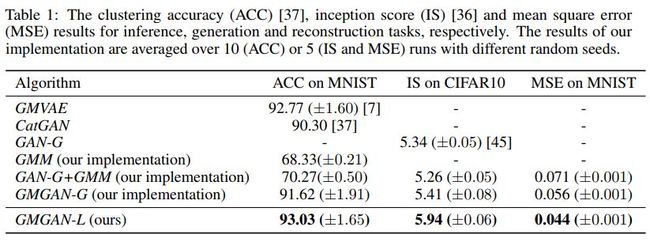

几种算法的效果对比如下

其中GMVAE对应的论文为

Unsupervised learning of video representations using LSTMs. ICML 2015.

代码地址

https://github.com/mansimov/unsupervised-videos

CatGAN对应的论文为

Unsupervised and semi-supervised learning with categorical generative adversarial networks

代码地址

https://github.com/xinario/catgan_pytorch

GAN-G对应的论文为

Improving generative adversarial networks with denoising feature matching. 2016.

代码地址

https://github.com/zhenxuan00/graphical-gan

![]() 我是分割线

我是分割线![]()

[3] Deep Neural Networks with Box Convolutions

Egor Burkov, Victor Lempitsky

Samsung AI Center, Skolkovo Institute of Science and Technology

https://papers.nips.cc/paper/7859-deep-neural-networks-with-box-convolutions.pdf

在计算机视觉工具箱中,有一种常用的方法,即利用积分图像计算箱滤波。以划窗的方式计算箱滤波所得到的卷积层可以用于深层结构,其中的维度和偏置可以通过端到端的损失函数最小化来学习得到。

在训练过程中,箱的大小可以任意大,并且无需额外的计算量,也无需增加需要学习的参数。如果箱比较大,新的层也可以集成其中的信息,这样就有利于长范围的信息传播,进而可以使得网络单元中的接受域快速变大。

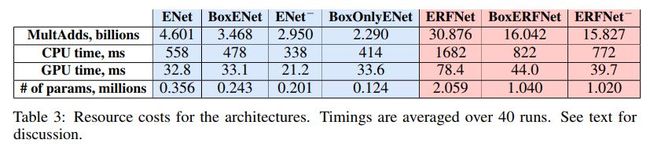

将这种新的层融入到现有结构中用于语义分割时,分割准确率能够得以提升,而且可以降低计算量,减少需要学习的参数。

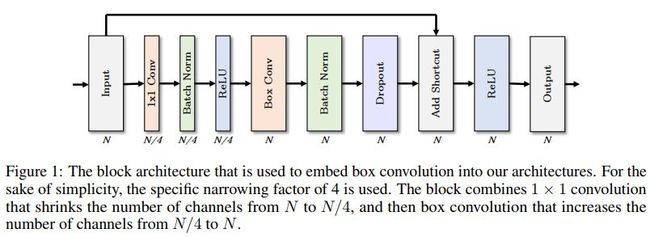

网络结构图示如下

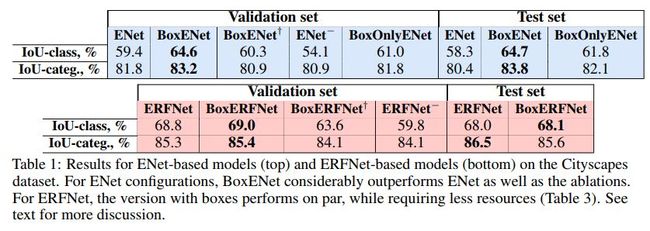

不同网络在验证集和测试集上的效果对比如下

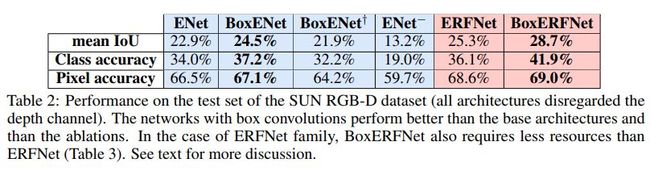

在数据集SUN RGB-D上几种网络的效果对比如下

几种网络的资源耗费对比如下

代码地址

https://github.com/shrubb/box-convolutions

![]() 我是分割线

我是分割线![]()

您可能感兴趣