Ngixn(1)之linux安装以及负载均衡配置

一、什么是负载均衡

早期的互联网应用,由于用户流量比较小,业务逻辑也比较简单,往往一个单服务器就能满足负载需求。随着现在互联网的流量越来越大,稍微好一点的系统,访问量就非常大了,并且系统功能也越来越复杂,那么单台服务器就算将性能优化得再好,也不能支撑这么大用户量的访问压力了,这个时候就需要使用多台机器,设计高性能的集群来应对。

那么,多台服务器是如何去均衡流量、如何组成高性能的集群的呢?

此时就需要请出 「负载均衡器」 入场了。

负载均衡(Load Balancer)是指把用户访问的流量,通过「负载均衡器」,根据某种转发的策略,均匀的分发到后端多台服务器上,后端的服务器可以独立的响应和处理请求,从而实现分散负载的效果。负载均衡技术提高了系统的服务能力,增强了应用的可用性。

二、负载均衡的方式

目前市面上最常见的负载均衡技术方案主要有三种:

-

基于DNS负载均衡

-

基于硬件负载均衡

-

基于软件负载均衡

三种方案各有优劣,DNS负载均衡可以实现在地域上的流量均衡,硬件负载均衡主要用于大型服务器集群中的负载需求,而软件负载均衡大多是基于机器层面的流量均衡。在实际场景中,这三种是可以组合在一起使用。下面来详细讲讲:

基于DNS来做负载均衡其实是一种最简单的实现方案,通过在DNS服务器上做一个简单配置即可。

其原理就是当用户访问域名的时候,会先向DNS服务器去解析域名对应的IP地址,这个时候我们可以让DNS服务器根据不同地理位置的用户返回不同的IP。比如南方的用户就返回我们在广州业务服务器的IP,北方的用户来访问的话,我就返回北京业务服务器所在的IP。

在这个模式下,用户就相当于实现了按照「就近原则」将请求分流了,既减轻了单个集群的负载压力,也提升了用户的访问速度。

使用DNS做负载均衡的方案,天然的优势就是配置简单,实现成本非常低,无需额外的开发和维护工作。

但是也有一个明显的缺点是:当配置修改后,生效不及时。这个是由于DNS的特性导致的,DNS一般会有多级缓存,所以当我们修改了DNS配置之后,由于缓存的原因,会导致IP变更不及时,从而影响负载均衡的效果。

另外,使用DNS做负载均衡的话,大多是基于地域或者干脆直接做IP轮询,没有更高级的路由策略,所以这也是DNS方案的局限所在。

硬件的负载均衡那就比较牛逼了,比如大名鼎鼎的 F5 Network Big-IP,也就是我们常说的 F5,它是一个网络设备,你可以简单的理解成类似于网络交换机的东西,完全通过硬件来抗压力,性能是非常的好,每秒能处理的请求数达到百万级,即 几百万/秒 的负载,当然价格也就非常非常贵了,十几万到上百万人民币都有。

因为这类设备一般用在大型互联网公司的流量入口最前端,以及政府、国企等不缺钱企业会去使用。一般的中小公司是不舍得用的。

采用 F5 这类硬件做负载均衡的话,主要就是省心省事,买一台就搞定,性能强大,一般的业务不在话下。而且在负载均衡的算法方面还支持很多灵活的策略,同时还具有一些防火墙等安全功能。但是缺点也很明显,一个字:贵。

软件负载均衡是指使用软件的方式来分发和均衡流量。软件负载均衡,分为7层协议 和 4层协议。

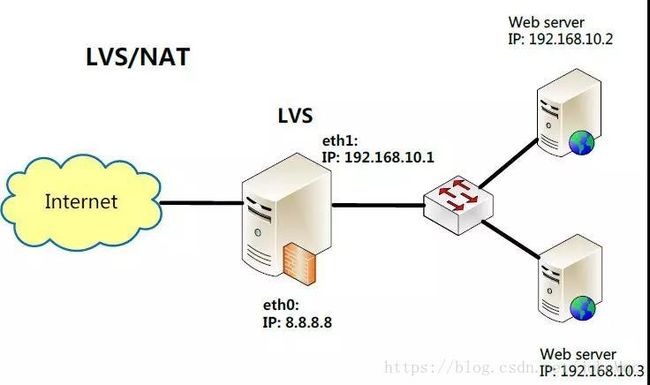

网络协议有七层,基于第四层传输层来做流量分发的方案称为4层负载均衡,例如LVS,而基于第七层应用层来做流量分发的称为7层负载均衡,例如 Nginx。这两种在性能和灵活性上是有些区别的。

基于4层的负载均衡性能要高一些,一般能达到 几十万/秒 的处理量,而基于7层的负载均衡处理量一般只在 几万/秒 。

基于软件的负载均衡的特点也很明显,便宜。在正常的服务器上部署即可,无需额外采购,就是投入一点技术去优化优化即可,因此这种方式是互联网公司中用得最多的一种方式。

三、nginx软件搭建

1.Nginx 需要的安装环境

如果不知道 linux/centOS 上是否安装了下面的软件,那么先尝试安装 Nginx ,如果安装的过程中出现问题,那么根据错误提示,安装相应的必要环境,例如:

./configure: error: the HTTP rewrite module requires the PCRE library.

./configure: error: the HTTP gzip module requires the zlib library.- 安装 gcc

安装Nginx的编译环境gcc

yum install gcc-c++- 安装 pcre pcre-devel

nginx的http模块使用pcre解析正则表达式,所以安装perl兼容的正则表达式库

yum install -y pcre pcre-devel- 安装 zlib

nginx使用zlib对http包的内容进行gzip

yum install -y zlib zlib-devel- 安装 Open SSL

nginx不仅支持http协议,还支持https(即在ssl协议上传输http),如果使用了https,需要安装OpenSSL库

yum install -y openssl openssl-devel2.Nginx安装

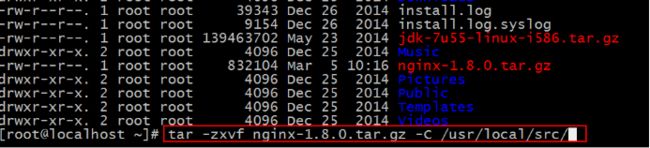

解压

tar -zxvf nginx-1.12.2.tar.gz配置

- 使用默认配置:

cd nginx-1.12.2

./configure 注意:使用默认配置时,nginx 被安装到 /usr/local/nginx 下。

编译、安装

make && make installNginx 的运行

- 启动

cd /usr/local/nginx/sbin/ ./nginx- 查看 nginx 进程

ps -ef | grep nginxTomcat包分别拷贝到CentOS01和CentOS02上, 并且解压好, 这里就不再复述这个过程了.然后我们需要关闭Linux的防火墙, 否则的话启动了Nginx也是连接不上的.

接着我们需要将Nginx和Tomcat包分别拷贝到CentOS01和CentOS02上, 并且解压好, 这里就不再复述这个过程了.

然后我们需要关闭Linux的防火墙, 否则的话启动了Nginx也是连接不上的.

我们还是来再看下解压吧:

解压完之后我们需要编译安装:

![]()

1 ./configure \

2 --prefix=/usr/local/nginx \

3 --pid-path=/var/run/nginx/nginx.pid \

4 --lock-path=/var/lock/nginx.lock \

5 --error-log-path=/var/log/nginx/error.log \

6 --http-log-path=/var/log/nginx/access.log \

7 --with-http_gzip_static_module \

8 --http-client-body-temp-path=/var/temp/nginx/client \

9 --http-proxy-temp-path=/var/temp/nginx/proxy \

10 --http-fastcgi-temp-path=/var/temp/nginx/fastcgi \

11 --http-uwsgi-temp-path=/var/temp/nginx/uwsgi \

12 --http-scgi-temp-path=/var/temp/nginx/scgi![]()

注意:上边将临时文件目录指定为/var/temp/nginx,需要在/var下创建temp及nginx目录

mkdir -p /var/temp/nginx

生成了文件夹后我们直接拷贝上面的编译安装命令进行安装.

执行完上诉步骤后, 我们可以看到nginx目录下生成了Makefile文件,我们接着往下:

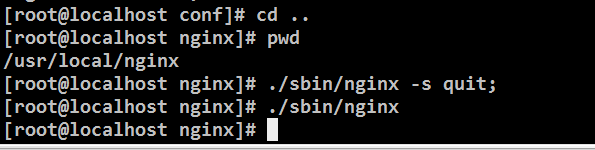

然后使用Make命令, 运行结束后在使用Make install命令进行安装, 最后是启动Nginx:

查看是否启动成功:

配置反向服务代理器:

什么是反向服务呢? 首先说下正向服务, 例如爬虫程序, 我们主动出击去获取资源. 而反向服务我们是等待用户来访问. 区别在于主动和被动.

配置文件Nginx/conf/nginx.conf

配置Nginx转发条件

重启Nginx服务器

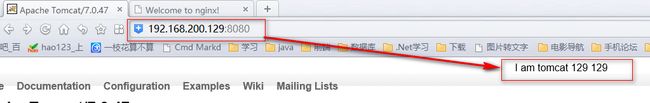

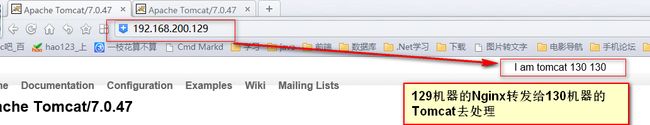

为了测试, 我们在两个Tomcat 服务器的index.jsp中分别加了这是来自于哪个ip下的Tomcat. 如下图所示:

重启好Nginx后, 我们再来访问192.168.200.129 这台机器, 我么可以发现其实访问的是129.168.200.130这台机器.

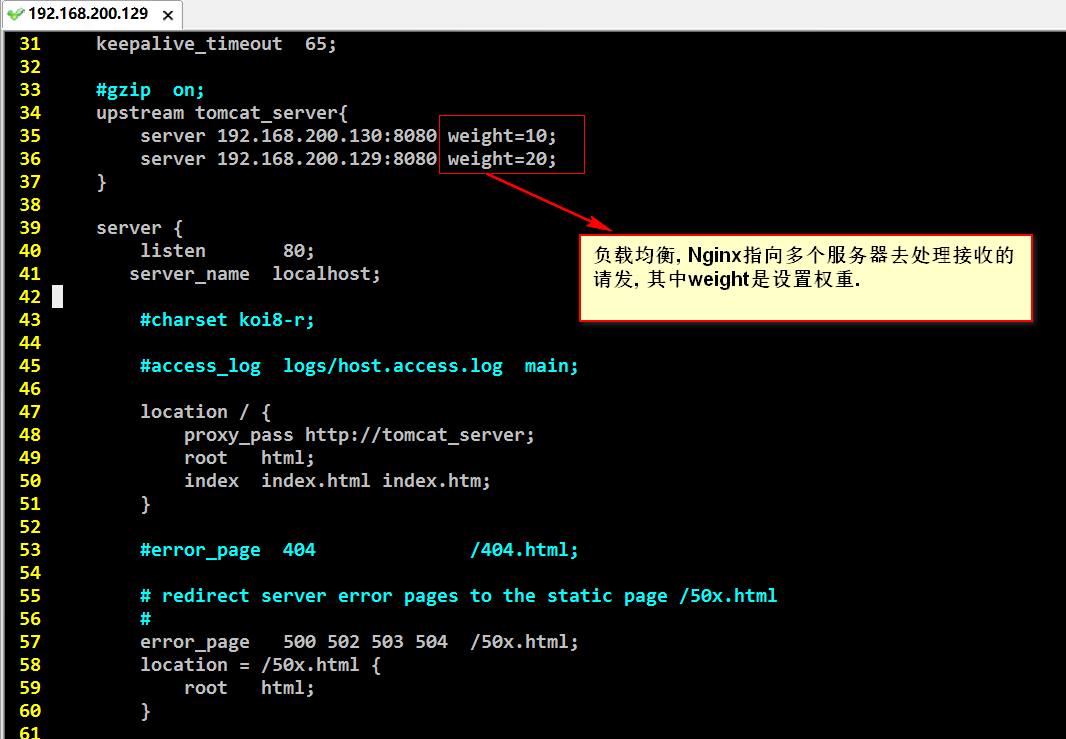

负债均衡的配置, 配置转发的权重: (另一台CentOS02 依然按照CentOS01的配置)

我们在这里配置了两台转发机器: 192.168.200.129和192.168.200.130, 它们的权重分别是2/3 和1/3, 也就是说访问三次192.168.200.129, 有两次是192.168.200.129上的Tomcat来处理, 有一次是192.168.200.130上的Tomcat来处理. 如果我们的Tomcat服务器更多 那么就需要在这里配置更多, 权重根据实际需求来划分.

同上, 搭建另一台机器192.168.200.130的负载均衡:

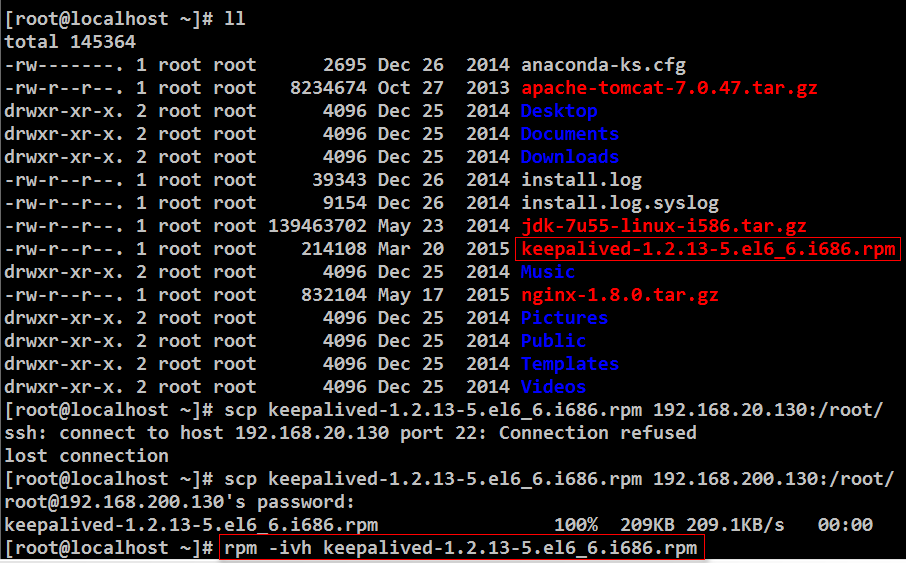

搭建Keepalived:(Keepalived需要依赖openssl)

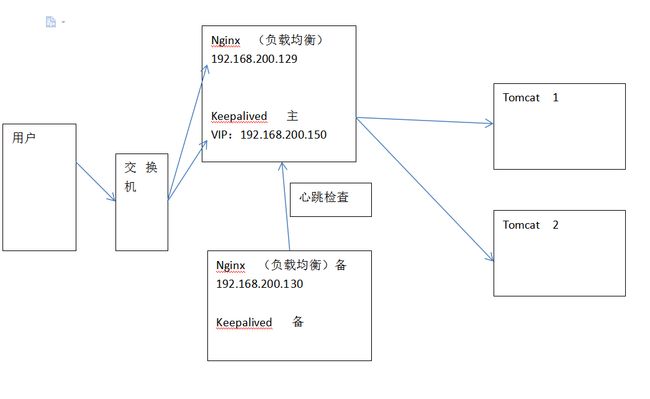

这里如果我们的机器192.168.200.129 出现故障了呢? 那么怎么使用192.168.200.130上的Nginx进行转发呢? 怎么设置主机和备机呢? 如果主机死了怎么进行故障移除呢? 如果主机从不可用到可用状态又怎么进行恢复添加呢? 这些功能都是可以通过Keepalived来进行设置的.

Keepalived原理:

首先Keepalived可以在主机上产生一个虚拟的ip, 这里叫做vip(v是virtual的意思):192.168.200.150, keepalived会将这个vip绑定到交换机上.

当用户访问主机:192.168.200.129时, 交换机会通过这个ip和vip的对应找到192.168.200.129上的Nginx进行处理.

如果当有一天192.168.200.129上的Nginx挂掉的时候, Keepalived会立即在备机上生成一个相同的vip: 192.168.200.150, 当用户继续访问192.168.200.129时, 交换机上已经绑定了vip, 这时发现这个vip是存在于192.168.200.130上面的, 所以直接将请求转发到了备机上.

如果主机被修复好能够继续对外提供服务时, 这时keepalived会将主机上继续生成这个vip, 同时回收在备机上生成的vip. 这个是通过心跳检查来判断主机已恢复使用.

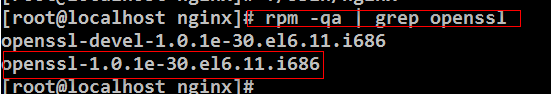

我这里已经提前安装好了oppenssl, 关于具体安装方法大家可以自行百度.

检查openssl 是否安装成功:

Keepalived的安装命令:

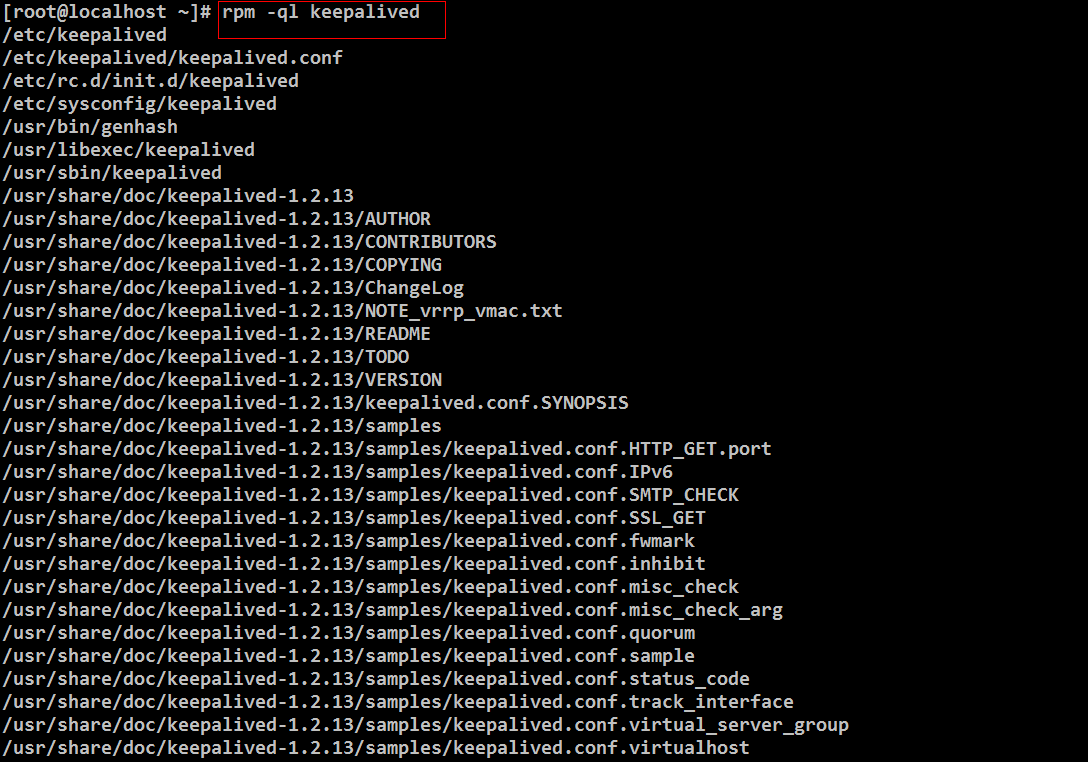

查看Keepalived的安装目录:

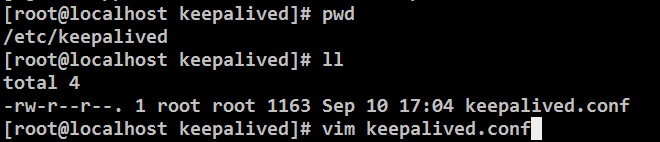

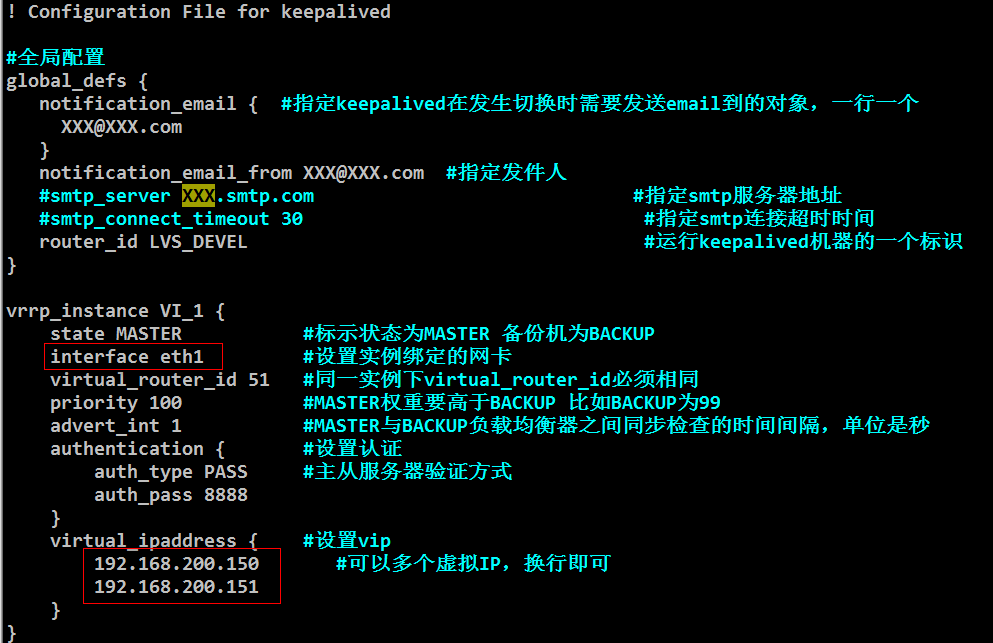

编辑Keepalived的配置文件:

首先我们来清空配置文件(清空后会自动再生成一个keepalived.conf, 但是里面的内容为空)

关于为什么要清空, 因为我们已经配置好了一些相关内容, 直接使用即可.

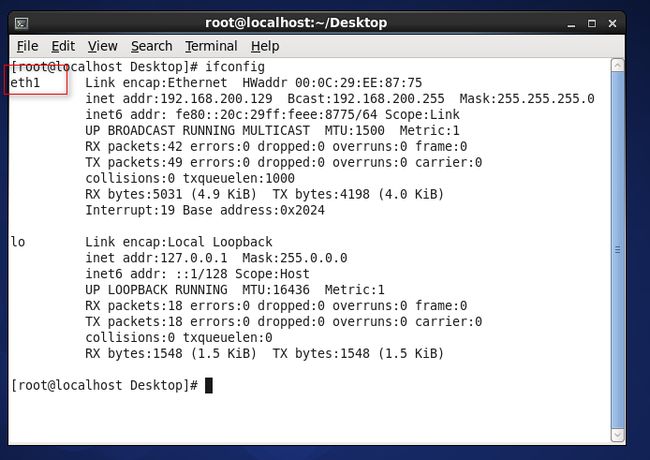

这里是来设置虚拟IP和eth1:

因为我的CentOS是拷贝过来的, 所以这里是eth1, 关于怎么查看, 我们在文章开头有查看本机ip: ifconfig, 那里面有显示我们的网卡就是eth1.

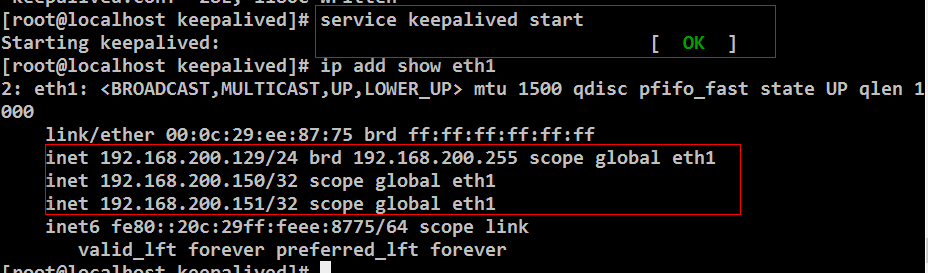

配置完成之后, 启动keepalived:

检测Keepalived是否启动成功:

这里查看 我们的机器多了两个ip, 其实这两个ip都是虚拟ip

设置备机:|

这里的权重只要低于主机的100就好.

启动备机的Keepalived:

当主机停止服务时, 备机即可接管继续服务: