AEB落地:摄像头与毫米波雷达的融合

☛

我们的生活中,总有各种场合需要证明自己。

内心不够坚定的时候,总是活在不断证明自己的循环中。新人刚入职,会努力证明自己是有能力的;遇到心动的男神,会努力证明自己值得被爱;受到质疑否定,会努力证明我行我能我最棒。

你在他人的评价体系中,努力活成别人的样子;而真正内心强大的人,会把工作做成自己的样子,而非把自己做成工作的样子,会慢慢活出自己的风格,到那时候,你可以自成标准,不必去迎合谁。

☚

接触智能驾驶有段时间了~

除了mobileye纯视觉方案的特立独行,其他厂商无一例外的都在谈传感器融合,尤其是在2018年各大公司在争相落地的关键时期~

显然,无论是出于落地成本的考虑、还是交通政策的部分ADAS功能强制要求,传感器融合是一个必然的趋势~

下面简单介绍下自动驾驶常用的传感器:

1.视觉类摄像机(包括单目、双目立体视觉、全景视觉及红外相机)

2.雷达类测距传感器(激光雷达、毫米波雷达、超声波雷达等)

其中呢,单目相机主要用于特征类符号的检测与识别,如车道线检测、交通标志识别、交通灯识别、行人和车辆检测等,尽管目前来说视觉检测可靠性并不是很高,但是基于机器学习的视觉计算在自动驾驶普及之日一定会是必不可少的部分;双目视觉应用于室外场景的确实不多,毕竟双目的同步和标定是个大问题,目前比较通用的双目标定做法是采用张正友标定法,利用Camera Calibration Toolbox进行标定;毫米波雷达可能是当前最受欢迎的传感器了,毫米波,是工作在毫米波波段(millimeter wave),工作频率在 30~100GHz,波长在1~10mm之间的电磁波,通过向障碍物发射电磁波并接收回波来精确探测目标的方向和距离,其全天候全天时以及准确的测速测距深受开发者的喜爱;当然,激光雷达也是一个在自动驾驶领域非常重要的传感器了,Lidar利用激光来进行对目标进行探测,通过每分钟600转或1200转的进行扫射,它能非常详细的获得一个实时的三维点云数据,包括目标的三维坐标、距离、方位角、反射激光的强度、激光编码、时间等等,常用的有单线、4线、16线、32线、64线、128线束的,是一个高精度的传感器,而且其稳定性好、鲁棒性高,然而,它的成本却让众多厂商在落地的路上望而却步,另外,激光受大气及气象影响大,大气衰减和恶劣天气使作用距离降低,大气湍流会降低激光雷达的测量精度,激光束窄的情况难以搜索目标和捕获目标。一般先有其他设备实施大空域、快速粗捕目标,然后交由激光雷达对目标进行精密跟踪测量。

接下来就来说一说如何实现AEB:

目前,实现AEB的技术主要有三类,分别是基于视觉传感器、毫米波雷达和激光雷达。由于成本限制因素,国内主要使用前两种方式。视觉传感器和毫米波雷达实现对车辆的AEB功能的原理不同:毫米波雷达主要是通过对目标物发送电磁波并接收回波来获得目标物体的距离、速度和角度。视觉方案稍复杂,以单目视觉方案为例,它需要先进行目标识别,然后根据目标在图像中的像素大小来估算目标的距离。

这两类技术各有优劣。总体来讲,摄像头方案成本低,可以识别不同的物体,在物体高度与宽度测量精度、车道线识别、行人识别准确度等方面有优势,是实现车道偏离预警、交通标志识别等功能不可缺少的传感器,但作用距离和测距精度不如毫米波雷达,并且容易受光照、天气等因素的影响。毫米波雷达受光照和天气因素影响较小,测距精度高,但难以识别车道线、交通标志等元素。另外,毫米波雷达通过多普勒偏移的原理能够实现更高精度的目标速度探测。

于是就有了第三种方案,将摄像头和雷达进行融合,相互配合共同构成汽车的感知系统,取长补短,实现更稳定可靠的AEB功能。

传感器融合的思路与方法:

基于多传感器信息融合的车辆主动防碰撞控制系统,就是根据多传感器接收到的车辆前方目标信息和本车的状态信息,利用多源信息融合技术,识别出本车前方车辆的距离和速度等状态信息,并进行碰撞危险估计的。显然,基于多传感信息融合的车辆主动防碰撞控制系统是一种主动式的防撞、防抱死的汽车安全系统,它使反应时间、距离、速度三个方面都能得到优化控制,可减少驾驶员的负担和判断错误,对于提高交通安全性将起到重要作用,是实现汽车自动化驾驶的基础。

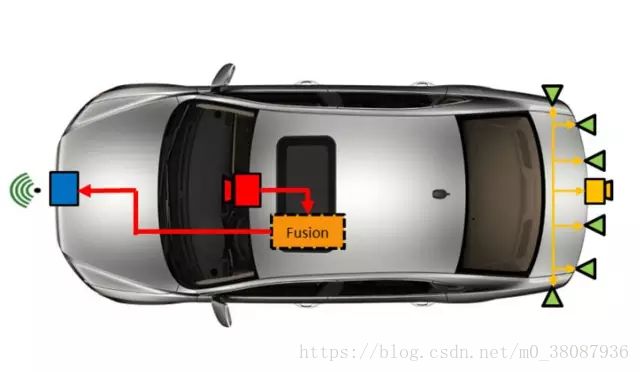

回到驾驶场景上:首先摄像头和毫米波雷达分别针对观测目标收集数据,然后对各传感器的输出数据进行特征提取与模式识别处理,并将目标按类别进行准确关联,最后利用融合算法将同一目标的所有传感器数据进行整合,从而得出关于目标威胁性的一致性结论。

数据融合也有不同的策略,比如有的方案会选择将不同传感器各自处理生成的目标数据进行融合,有些会选择将不同传感器的原始数据进行融合,避免一些原始数据的丢失。在智能驾驶场景下,视觉和毫米波雷达的数据融合大致有3种策略:图像级、目标级和信号级。

图像级融合,是以视觉为主体,将雷达输出的整体信息进行图像特征转化,然后与视觉系统的图像输出进行融合;目标级融合, 是对视觉和雷达输出进行综合可信度加权,配合精度标定信息进行自适应的搜索匹配后融合输出;信号级融合,是对视觉和雷达传感器ECU传出的数据源进行融合。其中,信号级别的融合数据损失最小,可靠性最高,但需要大量的运算。

对于视觉和毫米波雷达的融合,技术实现上的主要难点在于摄像头和雷达观测值的匹配、数据融合、多目标场景下有效目标库的维护等,需要考虑容错性、灵活性、可拓展性、可靠性、安装等多方面的因素,首先就要解决的是传感器之间的时间、空间同步问题。

●空间融合

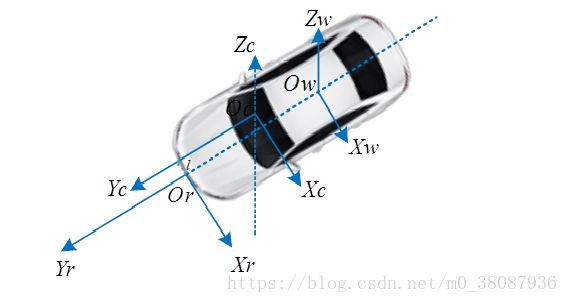

建立精确的雷达坐标系、三维世界坐标系、摄像机坐标系、图像坐标系和像素坐标系之间的坐标转换关系,是实现多传感器数据的空间融合的关键。雷达与视觉传感器空间融合就是将不同传感器坐标系的测量值转换到同一个坐标系中。由于前向视觉系统以视觉为主,只需将雷达坐标系下的测量点通过坐标系转换到摄像机对应的像素坐标系下即可实现多传感器的空间同步。

根据以上转换关系,可以得到雷达坐标系和摄像机像素坐标系之间的转换关系,如下图所示。由此,即可完成空间上雷达检测目标匹配至视觉图像,并在此基础上,将雷达检测对应目标的运动状态信息输出。

●时间融合

雷达和视觉信息在除在空间上需要进行融合,还需要传感器在时间上同步采集数据,实现时间的融合。根据毫米波雷达功能工作手册,其采样周期为50ms,即采样帧速率为 20 帧/秒,而摄像机采样帧速率为25 帧/秒。为了保证数据的可靠性,以摄像机采样速率为基准,摄像机每采一帧图像,选取毫米波雷达上一帧缓存的数据,即完成共同采样一帧雷达与视觉融合的数据,从而保证了毫米波雷达数据和摄像机数据时间上的同步。

许多情况下,在特定的已知外部条件下,仅通过一种传感器或单个系统,就能够执行ADAS功能。然而,考虑到路面上有很多不可预计的情况,这还不足实现可靠运行。传感器融合除了能实现更复杂和自主的功能外,还可以在现有功能中实现更少的误报和漏报。说服消费者和立法者,使他们相信汽车可以由“一台机器”自主驾驶,将会十分关键。

最后,传感器数据融合的核心关键还是在于采用合适的融合算法。作为一个新兴领域,数据融合目前尚无统一的理论和广义有效的融合模型和算法,需要根据具体场景来选择,但可以预见,神经网络和人工智能等新技术在传感器数据融合中将起到越来越重要的作用。这也是各行业参与者打造技术壁垒,建立核心竞争力的关键所在。