Linux--服务器硬件与RAID磁盘阵列配置实战(服务器硬件详解,RAID磁盘阵列,阵列卡介绍与真机配置,构建RAID磁盘阵列)

Linux--服务器硬件与RAID磁盘阵列配置实战(服务器硬件详解,RAID磁盘阵列,阵列卡介绍与真机配置,构建RAID磁盘阵列)

- 前言

- 一:服务器硬件组成

- 二:RAID磁盘阵列详解

- 2.1:RAID 0磁盘阵列介绍

- 2.2:RAID 1磁盘阵列介绍

- 2.3:RAID 5磁盘阵列介绍

- 2.4:RAID 6磁盘阵列介绍

- 2.5:RAID容错对比表

- 2.6:RAID 1+0磁盘阵列介绍

- 三:阵列卡介绍

- 3.1:阵列卡介绍

- 3.2:RAID卡的接口类型

- 3.2.1:IDE接口

- 3.2.2:SCSI接口

- 3.2.3:SATA接口

- 3.2.4:SAS接口

- 3.3:阵列卡的缓存

- 3.4:真机服务器配置

- 四:构建软RAID磁盘阵列实验

- 4.1:RAID 0 实验

- 4.2:RAID 1实验

- 4.3:RAID 5实验

- 4.4:RAID 6实验

- 4.5:RAID 1+0 实验

前言

-

RAID是英文Redundant Array of Independent Disks的缩写,中文简称为独立冗余磁盘阵列。简单的说,RAID是一种把多块独立的硬盘(物理硬盘)按不同的方式组合起来形成一个硬盘组(逻辑硬盘),从而提供比单个硬盘更高的存储性能和提供数据备份技术。

-

组成磁盘阵列的不同方式称为RAID级别(RAID Levels)。在用户看起来,组成的磁盘组就像是一个硬盘,用户可以对它进行分区,格式化等等。总之,对磁盘阵列的操作与单个硬盘一模一样。不同的是,磁盘阵列的存储速度要比单个硬盘高很多,而且可以提供自动数据备份。数据备份的功能是在用户数据一旦发生损坏后,利用备份信息可以使损坏数据得以恢复,从而保障了用户数据的安全性。

一:服务器硬件组成

1.CPU: 运算/控制

几由服务器:服务器上有多少个CPU

CPU核数:处理工作任务 核心数越多 并行处理能力越强

2.内存: 数据先存储到内存(断电易丢失)

名词概念:

程序:所有代码信息构成一个程序

#进程:运行起来的程序

守护进程:一直运行存在的进程

缓存:将数据放入缓存区 加快数据读取 读-缓存(cache)

缓冲:将数据放入缓冲区 加快数据写入 写-缓冲(buffer)

3.硬盘: 存储到硬盘(永久存储)

接口分类:SATA–SCIS–SAS

硬盘转速:家用级别5400、7200企业级别:10K、15K

换算:1024B=1KB 1024KB=1MB 专业级别换算

---------1000B=1KB 1024KB=1MB 工业级别换算

存储单位:B-KB-MB-GB-TB-PB-EB…

4.主板: 南桥、北桥

5.电源: 服务供电(冗余特性)

6.网卡: 实现网络通讯(可多块)

7.陈列卡BAID: 提高单块硬盘的存储量/提高数据安全性/实现提高数据存储效率

8.远程管理卡: 控制服务器启动/远程安装系统

二:RAID磁盘阵列详解

-

RAID分为不同的等级,不同等级的RAID均在数据可靠性及读写性能上做了不同的权衡。

-

是Redundant Array of Independent Disks的缩写,中

文简称为独立冗余磁盘阵列 -

把多块独立的物理硬盘按不同的方式组合起来形成一个硬

盘组(逻辑硬盘),从而提供比单个硬盘更高的存储性能

和提供数据备份技术 -

组成磁盘阵列的不同方式称为RAID级别(RAID Levels)

-

常用的RAID级别有以下几种:

RAID 0

RAID 1

RAID 5

RAID 6

RAID 1+0

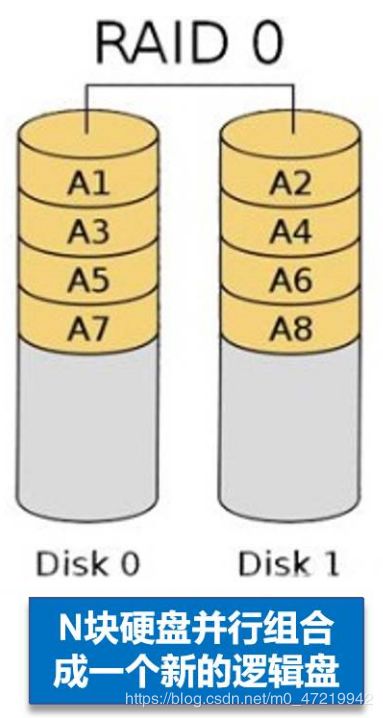

2.1:RAID 0磁盘阵列介绍

- RAID 0称为条带化存储(Striping)(相当于Windows中是带区卷)

- RAID 0以连续位或字节为单位进行数据分割,将数据分段存储于各个硬盘中并进行读/写数据,因此有很高的数据传输率,但它没有数据冗余,因此不能算真正的RAID结构

- RAID 0连续以位或字节为单位分割数据,并行读/写于多个磁盘上,因此具有很高的数据传输率,但它没有数据冗余

- RAID 0只是单纯地提高性能,并没有为数据的可靠性提供保证,而且其中的一个磁盘失效将影响到所有数据

- RAID 0不能应用于数据安全性要求高的场合

2.2:RAID 1磁盘阵列介绍

- RAID 1称为镜像存储(mirroring)(相当于Windows中的镜像卷)

- 通过磁盘数据镜像实现数据冗余,在成对的独立磁盘上产生互为备份的数据

- 当原始数据繁忙时,可直接从镜像拷贝中读取数据,因此RAID 1 可以提高读取性能

- 因为数据被同等的写入成对的磁盘中,所以写性能比较慢,主要受限于最慢的那块磁盘

- RAID 1时磁盘阵列中单位成本最高的,但是提供了很高的数据安全性和可用性。当一个磁盘失效时,系统可以自动切换到镜像磁盘上读写,而不需要重组失效的数据

- RAID 1是磁盘利用率最低的一个,如果N(偶数)块硬盘组合成一组镜像,只能利用其中N/2的容量

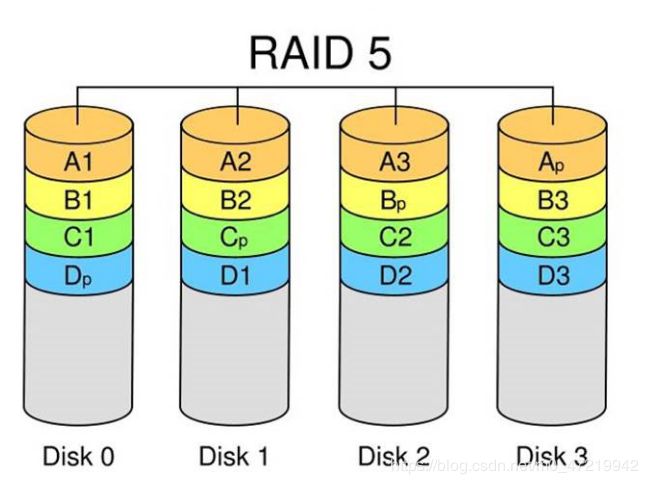

2.3:RAID 5磁盘阵列介绍

- RAID 5是一种存储性能,数据安全与存储成本兼顾的存储解决方案,可以理解为是RAID 0和 RAID 1 的这种方案

- N(N>=3)块盘组成阵列,一份数据产生N-1个条带,同时还有一份校验数据,共N份数据在N块盘上循环均衡存储

- N块盘同时读写,读性能很高,但由于有校验机制的问题,写性能相对不高

- 磁盘利用率为(N-1)/N容量,相当于一块磁盘的容量空间用于存储奇偶校验信息

- 可靠性高,允许坏1块盘,不影响所有数据

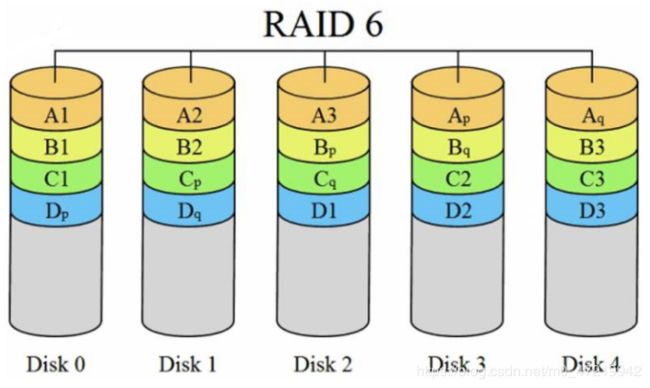

2.4:RAID 6磁盘阵列介绍

- RAID 6采用双重校验技术,在RAID 5的技术上增加了第二个独立的奇偶校验信息块,两个独立的奇偶系统使用不同的算法,即使两块磁盘同时失效也不会影响数据的使用,进一步加强了对数据的保护。

- N(N>=4)块盘组成阵列,(N-2)/N容量 (相当于2块磁盘的容量空间用于存储奇偶校验信息)

- RAID 6需要分配给奇偶校验信息更大的磁盘空间,相对于RAID 5有更大的“写损失”,因此写性能较差

2.5:RAID容错对比表

- RAID 1 , RAID 5, RAID 6都具有容错性,我们做个对比

| RAID 1 | RAID 5 | RAID 6 | |

|---|---|---|---|

| 是否有校验 | 无 | 有 | 有 |

| 保护能力 | 允许一个设备故障 | 允许一个设备故障 | 允许两个设备故障 |

| 写性能 | 需写两个存储设备 | 需写计算校验 | 需双重写计算校验 |

| 磁盘利用率 | 50% | N-1/N(N>=3) | N-2/N(N>=4) |

- 相对于其他几种RAID来说,当N>2时,RAID 6的磁盘利用率得到了提高。又因为允许同时两块存储设备故障,显然提供了更好的可用性。

2.6:RAID 1+0磁盘阵列介绍

- RAID 1+0是RAID 1和RAID 0的结合,先做镜像(1),再做条带(0)

- 兼顾了RAID 1的容错能力与RAID 0的条带化读写数据的优点,性能好,可靠性高。属于混合型RAID

- N(偶数,N>=4)块盘两两镜像后,在组合成一个RAID 0,最多允许所有磁盘基组中的磁盘各损坏一个,但是不允许同一基组中的磁盘同时有坏的。

- 磁盘的利用率为N/2

- N/2块盘同时写入数据,N快盘同时读取数据

- 类似的混合RAID还有RAID 0+1,二者在读写性能上差别不大,但是在安全性上 RAID 1+0 要好于 RAID 0+1

三:阵列卡介绍

3.1:阵列卡介绍

- 阵列卡全称为磁盘阵列卡,是用来实现RAID 功能的板卡

- RAID卡一般分为硬RAID卡和软RAID卡两种

- 通过硬件来实现RAID功能的就是硬RAID,通常是由I/O处理器,硬盘控制器,硬盘连接器和缓存等一些列组件构成

- 通过软件并使用CPU的RAID卡我们成为软RAID,因为软RAID占用CUP资源比较高,所以绝大部分的服务器设备都使用的硬RAID

- 不同的RAID卡支持的RAID功能不同,例如支持RAID 0,RAID 1,RAID 5,RAID1+0等

- RAID卡的第一个重要功能就是他可以达到单个磁盘驱动器的几倍,几十倍甚至上百倍的速率,这也是RAID最初想要解决的问题

- RAID卡的第二个重要功能就是提供容错能力,现在服务器基本上集成了RAID卡

3.2:RAID卡的接口类型

- RAID卡的接口指的是支持的接口,目前有IDE 接口,SCSI接口,SATA接口和SAS接口

3.2.1:IDE接口

- IDE的英文全称为“Integrated Drive Electronics”,即“电子集成驱动器”,属于并行接口。

- 它是把“硬盘控制器”与“盘体”集成在一起的硬盘驱动器,这样使得硬盘接口的电缆数目与长度有所减少,从而数据传输的可靠性得到增强

- IDE接口价格低廉,兼容性强

- 在实际的应用中,这种类型的接口随着接口技术的不断发展已经很少用了,逐渐被后续发展分支出更多类型的硬盘接口所取代。

3.2.2:SCSI接口

- SCSI 的英文全称为“Small Computer System Interface”(小型计算机系统接口),是和IDE完全不同的接口,IDE接口是普通PC的标准接口,而SCSI是一种通用的接口标准,具备与不同类型外部设备进行通信的能力,是一种广泛应用于小型机上的高速数据传输技术

- SCSI是个多任务接口,设有母线仲裁功能,挂在一个SCSI母线上的多个外部设备可以同时工作,并平等占有总线

- SCSI接口可以同步或异步传输数据,同步传输数据可以达到10M/s,异步传输速率可以达到1.5M/s

- SCSI接口的CPU占用率低,支持热插热拔,但价格较高,因此SCSI硬盘主要用于中,高端工作站中

3.2.3:SATA接口

-

SATA是“Serial ATA”的缩写,主要用在主板和大量存储设备之间传输数据。拥有这种接口的硬盘又叫串口硬盘,以采用串行方式传输数据

-

SATA总线使用了嵌入式时钟信号,使得其具备更强的纠错能力。如果发现数据传输中的错误会自动进行矫正,很大程度上提高了数据传输的可靠性,也是一种支持热拔热插的接口

3.2.4:SAS接口

- SAS的英文全称为“Serial Attached SCSI”是新一代的SCSI技术,称为序列式SCSI

- SAS可以看做是SATA与SCSI的结合体,是同时发挥两者的优势产生的,主要用在周边零件的数据传输上

- 和SATA硬盘相同,都是采用串行技术以获得更高的传输速度

- SAS的接口技术可以向下兼容SATA设备

3.3:阵列卡的缓存

- 缓存(Cache)是RAID卡与外部总线交换数据的场所,是RAID卡电路板上的一块存储芯片,与硬盘盘片相比,具有极快的存取速度。RAID卡现将数据传送到缓存,再经由缓存和外边数据总线交换数据

- 缓存的大小与速度是直接关系到RAID卡的实际传输速度的重要因素,大缓存能够大幅度的提高数据命中率从而提高RAID卡整体性能

- 不同的RAID卡出厂时配备的内存容量不同,一般为几兆到数百兆容量不等,主要取决于磁盘阵列产品所应用的范围

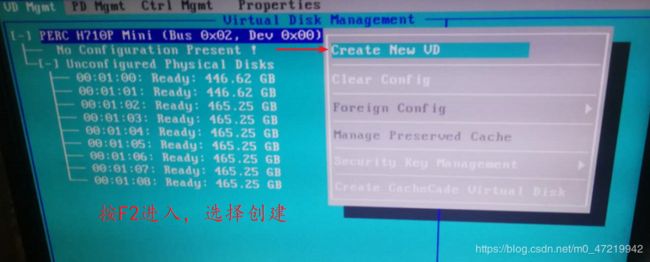

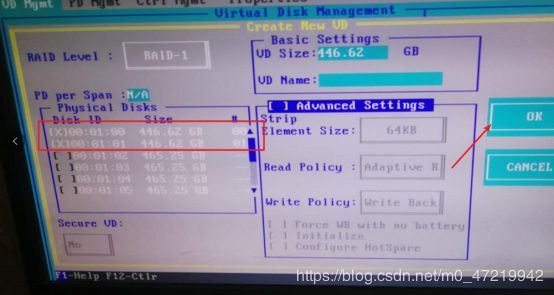

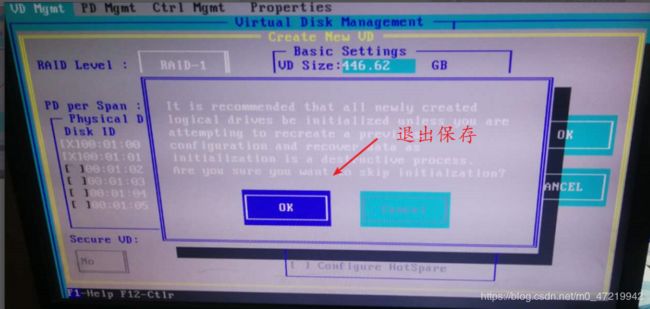

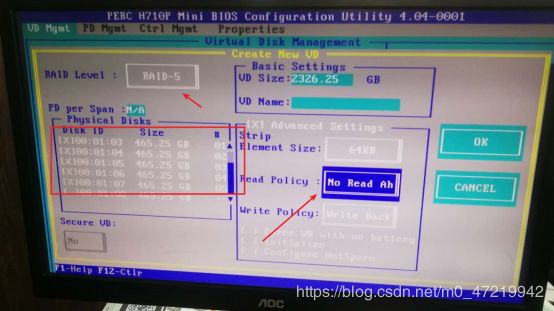

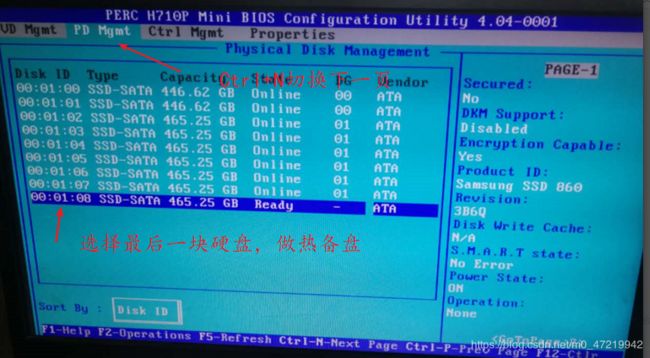

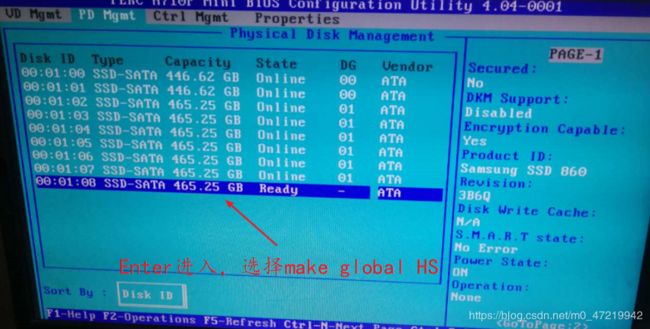

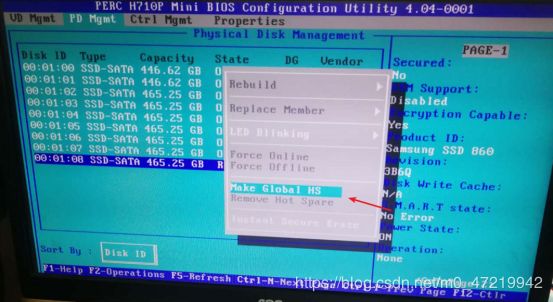

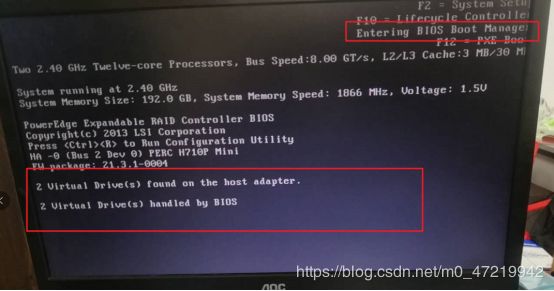

3.4:真机服务器配置

同样的配置RAID 5,选择NO read ah

退出保存

Ctrl+alt+delete重启系统

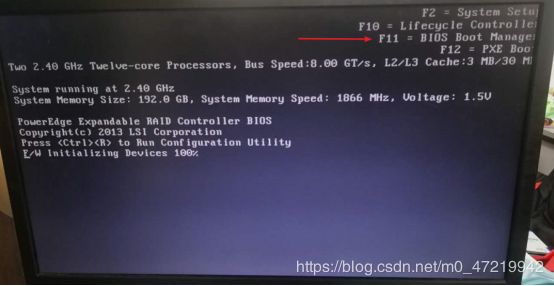

按F11等待进入

选择HARD sevice C

选择从U盘进行安装

之后就是跟装CentOS是一样的,这里就不再做阐述了。

四:构建软RAID磁盘阵列实验

- 我们需要用到mdadm工具创建RAID磁盘

- 因为我们做的是RAID,所以文件系统格式需要改为fd

mdadm工具指令基本格式

[root@localhost ~]# mdadm -C -v 目录 -l级别 -n磁盘数量 设备

常用选项

l 指定级别

C 创建

v 指定目录

n 磁盘数量

- 查看RAID级别的两个方法

第一个方法

cat /proc/mdstat '//查看状态'

第二个方法

mdadm -D 目录 '//查看更详细信息'

4.1:RAID 0 实验

- 需要两块磁盘

- 磁盘分区格式需要改为fd(raid格式)

1.创建好两个磁盘分区

设备 Boot Start End Blocks Id System

/dev/sdb1 2048 41943039 20970496 fd Linux raid autodetect

设备 Boot Start End Blocks Id System

/dev/sdc1 2048 41943039 20970496 fd Linux raid autodetect

2.创建RAID0

[root@localhost ~]# mdadm -C -v /dev/md0 -l0 -n2 /dev/sd[b-c]1 '//在/dev/md0目录下创建RAID 0'

mdadm: chunk size defaults to 512K

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md0 started.

[root@localhost ~]# cat /proc/mdstat '//查看raid 第一种方法'

Personalities : [raid0]

md0 : active raid0 sdc1[1] sdb1[0]

41908224 blocks super 1.2 512k chunks

unused devices:

[root@localhost ~]# mdadm -D /dev/md0 '//查看raid 第二种方法'

/dev/md0:

Version : 1.2

Creation Time : Mon Nov 4 23:13:21 2019

Raid Level : raid0

Array Size : 41908224 (39.97 GiB 42.91 GB)

Raid Devices : 2

Total Devices : 2

Persistence : Superblock is persistent

Update Time : Mon Nov 4 23:13:21 2019

State : clean

Active Devices : 2

Working Devices : 2

Failed Devices : 0

Spare Devices : 0

Chunk Size : 512K

Consistency Policy : none

Name : localhost.localdomain:0 (local to host localhost.localdomain)

UUID : e6803bdd:e42b94df:8a0475cd:a1ef6f04

Events : 0

Number Major Minor RaidDevice State

0 8 17 0 active sync /dev/sdb1

1 8 33 1 active sync /dev/sdc1

3.格式化分区

[root@localhost ~]# mkfs.xfs /dev/md0

meta-data=/dev/md0 isize=512 agcount=16, agsize=654720 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=10475520, imaxpct=25

= sunit=128 swidth=256 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=5120, version=2

= sectsz=512 sunit=8 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

4.格式化后并挂载

[root@localhost ~]# mkdir /raid0 '//创建raid0挂载目录'

[root@localhost ~]# mount /dev/md0 /raid0/ '//将/dev/md0 挂载到/raid0'

[root@localhost ~]# df -hT '//查看挂载是否成功'

文件系统 类型 容量 已用 可用 已用% 挂载点

/dev/sda2 xfs 20G 3.1G 17G 16% /

devtmpfs devtmpfs 898M 0 898M 0% /dev

tmpfs tmpfs 912M 0 912M 0% /dev/shm

tmpfs tmpfs 912M 9.0M 903M 1% /run

tmpfs tmpfs 912M 0 912M 0% /sys/fs/cgroup

/dev/sda5 xfs 10G 37M 10G 1% /home

/dev/sda1 xfs 6.0G 174M 5.9G 3% /boot

tmpfs tmpfs 183M 12K 183M 1% /run/user/42

tmpfs tmpfs 183M 0 183M 0% /run/user/0

/dev/md0 xfs 40G 33M 40G 1% /raid0

4.2:RAID 1实验

-x:备用磁盘

1.创建raid1

[root@localhost ~]# mdadm -C -v /dev/md1 -l1 -n2 /dev/sd[d-e]1 -x1 /dev/sdf1 '//创建将sdd1,sde1创建raid1,并将sdf1作为备用磁盘'

mdadm: Note: this array has metadata at the start and

may not be suitable as a boot device. If you plan to

store '/boot' on this device please ensure that

your boot-loader understands md/v1.x metadata, or use

--metadata=0.90

mdadm: size set to 20954112K

Continue creating array? y

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md1 started.

2.查看状态信息

[root@localhost ~]# cat /proc/mdstat '//查看状态信息'

Personalities : [raid0] [raid1]

md1 : active raid1 sdf1[2](S) sde1[1] sdd1[0]

20954112 blocks super 1.2 [2/2] [UU]

[===========>.........] resync = 59.1% (12402304/20954112) finish=0.6min speed=206292K/sec

md0 : active raid0 sdc1[1] sdb1[0]

41908224 blocks super 1.2 512k chunks

unused devices:

[root@localhost ~]# mdadm -D /dev/md1 '//查看详细信息'

/dev/md1:

Version : 1.2

Creation Time : Mon Nov 4 23:41:52 2019

Raid Level : raid1

Array Size : 20954112 (19.98 GiB 21.46 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 2

Total Devices : 3

Persistence : Superblock is persistent

Update Time : Mon Nov 4 23:43:18 2019

State : clean, resyncing

Active Devices : 2

Working Devices : 3

Failed Devices : 0

Spare Devices : 1

Consistency Policy : resync

Resync Status : 82% complete

Name : localhost.localdomain:1 (local to host localhost.localdomain)

UUID : cbd878ef:8ad679a4:2ee73455:99f429de

Events : 13

Number Major Minor RaidDevice State

0 8 49 0 active sync /dev/sdd1

1 8 65 1 active sync /dev/sde1

2 8 81 - spare /dev/sdf1

3.格式化并挂载

[root@localhost ~]# mkfs.xfs /dev/md1 '//格式化分区'

meta-data=/dev/md1 isize=512 agcount=4, agsize=1309632 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=5238528, imaxpct=25

= sunit=0 swidth=0 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=2560, version=2

= sectsz=512 sunit=0 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

[root@localhost ~]# mkdir /raid1 '//创建raid1挂载目录'

[root@localhost ~]# mount /dev/md1 /raid1 '//挂载'

[root@localhost ~]# df -hT

文件系统 类型 容量 已用 可用 已用% 挂载点

/dev/sda2 xfs 20G 3.1G 17G 16% /

devtmpfs devtmpfs 898M 0 898M 0% /dev

tmpfs tmpfs 912M 0 912M 0% /dev/shm

tmpfs tmpfs 912M 9.1M 903M 1% /run

tmpfs tmpfs 912M 0 912M 0% /sys/fs/cgroup

/dev/sda5 xfs 10G 37M 10G 1% /home

/dev/sda1 xfs 6.0G 174M 5.9G 3% /boot

tmpfs tmpfs 183M 12K 183M 1% /run/user/42

tmpfs tmpfs 183M 0 183M 0% /run/user/0

/dev/md0 xfs 40G 33M 40G 1% /raid0

/dev/md1 xfs 20G 33M 20G 1% /raid1

4.3:RAID 5实验

1.创建raid5

[root@localhost ~]# mdadm -C -v /dev/md5 -l5 -n3 /dev/sd[g-j]1 -x1 /dev/sdk1 '//用sdg1,sdh1,sdj1创建raid5,将sdk1作为备用磁盘'

mdadm: layout defaults to left-symmetric

mdadm: layout defaults to left-symmetric

mdadm: chunk size defaults to 512K

mdadm: size set to 20954112K

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md5 started.

2.查看磁盘信息

[root@localhost ~]# cat /proc/mdstat '//查看状态信息'

Personalities : [raid0] [raid1] [raid6] [raid5] [raid4]

md5 : active raid5 sdj1[4] sdk1[3](S) sdh1[1] sdg1[0]

41908224 blocks super 1.2 level 5, 512k chunk, algorithm 2 [3/3] [UUU]

md1 : active raid1 sdf1[2](S) sde1[1] sdd1[0]

20954112 blocks super 1.2 [2/2] [UU]

md0 : active raid0 sdc1[1] sdb1[0]

41908224 blocks super 1.2 512k chunks

unused devices:

[root@localhost ~]# mdadm -D /dev/md5 '//查看详细信息'

/dev/md5:

Version : 1.2

Creation Time : Mon Nov 4 23:53:59 2019

Raid Level : raid5

Array Size : 41908224 (39.97 GiB 42.91 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 3

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Mon Nov 4 23:55:43 2019

State : clean

Active Devices : 3

Working Devices : 4

Failed Devices : 0

Spare Devices : 1

Layout : left-symmetric

Chunk Size : 512K

Consistency Policy : resync

Name : localhost.localdomain:5 (local to host localhost.localdomain)

UUID : e473255b:68d70fc5:3e26dce3:9a98f13e

Events : 18

Number Major Minor RaidDevice State

0 8 97 0 active sync /dev/sdg1

1 8 113 1 active sync /dev/sdh1

4 8 145 2 active sync /dev/sdj1

3 8 161 - spare /dev/sdk1

3.删除一块磁盘,看备用磁盘是否自动顶替掉坏掉的磁盘

[root@localhost ~]# mdadm -f /dev/md5 /dev/sdg1 '//删除sdg1'

mdadm: set /dev/sdg1 faulty in /dev/md5 '//提示sdg1已经损坏'

[root@localhost ~]# mdadm -D /dev/md5 '//查看详细信息'

/dev/md5:

Version : 1.2

Creation Time : Mon Nov 4 23:53:59 2019

Raid Level : raid5

Array Size : 41908224 (39.97 GiB 42.91 GB)

Used Dev Size : 20954112 (19.98 GiB 21.46 GB)

Raid Devices : 3

Total Devices : 4

Persistence : Superblock is persistent

Update Time : Tue Nov 5 00:00:54 2019

State : clean, degraded, recovering

Active Devices : 2

Working Devices : 3

Failed Devices : 1

Spare Devices : 1

Layout : left-symmetric

Chunk Size : 512K

Consistency Policy : resync

Rebuild Status : 22% complete

Name : localhost.localdomain:5 (local to host localhost.localdomain)

UUID : e473255b:68d70fc5:3e26dce3:9a98f13e

Events : 23

Number Major Minor RaidDevice State

3 8 161 0 spare rebuilding /dev/sdk1 '//发现备用sdk1已经顶替上来'

1 8 113 1 active sync /dev/sdh1

4 8 145 2 active sync /dev/sdj1

0 8 97 - faulty /dev/sdg1

4.格式化并挂载

[root@localhost ~]# mkdir /raid5 '//创建挂载点目录'

[root@localhost ~]# mkfs.xfs /dev/md5 '//格式化'

meta-data=/dev/md5 isize=512 agcount=16, agsize=654720 blks

= sectsz=512 attr=2, projid32bit=1

= crc=1 finobt=0, sparse=0

data = bsize=4096 blocks=10475520, imaxpct=25

= sunit=128 swidth=256 blks

naming =version 2 bsize=4096 ascii-ci=0 ftype=1

log =internal log bsize=4096 blocks=5120, version=2

= sectsz=512 sunit=8 blks, lazy-count=1

realtime =none extsz=4096 blocks=0, rtextents=0

[root@localhost ~]# mount /dev/md5 /raid5 '//挂载'

4.4:RAID 6实验

同RAID 5实验

4.5:RAID 1+0 实验

RAID 1+0是用两个RAID1来创建的

1.连续创建两个raid1

[root@localhost ~]# mdadm -C -v /dev/md0 -l1 -n2 /dev/sd[b-c]1 '//创建第一个raid1'

mdadm: Note: this array has metadata at the start and

may not be suitable as a boot device. If you plan to

store '/boot' on this device please ensure that

your boot-loader understands md/v1.x metadata, or use

--metadata=0.90

mdadm: size set to 20954112K

Continue creating array? y

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md0 started.

[root@localhost ~]# mdadm -C -v /dev/md1 -l1 -n2 /dev/sd[d-e]1 '//创建第二个raid1'

mdadm: Note: this array has metadata at the start and

may not be suitable as a boot device. If you plan to

store '/boot' on this device please ensure that

your boot-loader understands md/v1.x metadata, or use

--metadata=0.90

mdadm: size set to 20954112K

Continue creating array? y

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md1 started.

2.查看详细信息

[root@localhost ~]# mdadm -D /dev/md0

[root@localhost ~]# mdadm -D /dev/md1

3.创建raid1+0

[root@localhost ~]# mdadm -C -v /dev/md10 -l0 -n2 /dev/md0 /dev/md1

mdadm: chunk size defaults to 512K

mdadm: Defaulting to version 1.2 metadata

mdadm: array /dev/md10 started.

4.查看详细信息

[root@localhost ~]# mdadm -D /dev/md10

/dev/md10:

Version : 1.2

Creation Time : Tue Nov 5 00:19:07 2019

Raid Level : raid0

Array Size : 41875456 (39.94 GiB 42.88 GB) '//创建成功'

Raid Devices : 2

Total Devices : 2

Persistence : Superblock is persistent

Update Time : Tue Nov 5 00:19:07 2019

State : clean

Active Devices : 2

Working Devices : 2

Failed Devices : 0

Spare Devices : 0

Chunk Size : 512K

Consistency Policy : none

Name : localhost.localdomain:10 (local to host localhost.localdomain)

UUID : 6c3209a3:71bece7a:9b3129be:05a436e0

Events : 0

Number Major Minor RaidDevice State

0 9 0 0 active sync /dev/md0

1 9 1 1 active sync /dev/md1