Qt与FFmpeg联合开发指南(二)-- 解码本地视频

由于FFmpeg是使用C语言开发,所有和函数调用都是面向过程的。以我目前的学习经验来说,通常我会把一个功能的代码全部放在main函数中实现。经过测试和修改认为功能正常,再以C++面向对象的方式逐步将代码分解和封装。

一、开发前的准备工作(详见上章节)

开发工具为Qt5.10.1,目录结构:

- bin:工作和测试目录

- doc:开发文档目录

- src:源码目录

- include:ffmpeg头文件配置目录

- lib:ffmpeg静态库配置目录

二、编解码基础知识

(1)封装格式

所谓封装格式是指音视频的组合格式,例如最常见的封装格式有mp4、mp3、flv等。简单来说,我们平时接触到的带有后缀的音视频文件都是一种封装格式。不同的封装格式遵循不同的协议标准。有兴趣的同学可以自行扩展,更深的东西我也不懂。

(2)编码格式

以mp4为例,通常应该包含有视频和音频。视频的编码格式为YUV420P,音频的编码格式为PCM。再以YUV420编码格式为例。我们知道通常图像的显示为RGB(红绿蓝三原色),在视频压缩的时候会首先将代表每一帧画面的RGB压缩为YUV,再按照关键帧(I帧),过渡帧(P帧或B帧)进行运算和编码。解码的过程正好相反,解码器会读到I帧,并根据I帧运算和解码P帧以及B帧。并最终根据视频文件预设的FPS还原每一帧画面的RGB数据。最后推送给显卡。所以通常我们说的编码过程就包括:画面采集、转码、编码再封装。

(3)视频解码和音频解码有什么区别

玩游戏的同学肯定对FPS不陌生,FPS太低画面会感觉闪烁不够连贯,FPS越高需要显卡性能越好。一些高速摄像机的采集速度能够达到11000帧/秒,那么在播放这类影片的时候我们是否也需要以11000帧/秒播放呢?当然不是,通常我们会按照25帧/秒或者60帧/秒设定图像的FPS值。但是由于视频存在关键帧和过渡帧的区别,关键帧保存了完整的画面而过渡帧只是保存了与前一帧画面的变化部分,需要通过关键帧计算获得。因此我们需要对每一帧都进行解码,即获取画面的YUV数据。同时只对我们真正需要显示的画面进行转码,即将YUV数据转换成RGB数据,包括计算画面的宽高等。

但是音频则不然,音频的播放必须和采集保持同步。提高或降低音频的播放速度都会让音质发生变化,这也是变声器的原理。因此在实际开发中为了保证播放的音视频同步,我们往往会按照音频的播放速度来控制视频的解码转码速度。

( 4 ) 框架图

三、代码实现

第一步:注册所有组件

av_register_all();第二步:打开视频输入文件

QString filename = QCoreApplication::applicationDirPath();

qDebug()<<"获取程序运行目录 "<AVFormatContext->包含了视频信息(视频格式、大小等等...)

//参数二:打开文件(入口文件)->url

int avformat_open_result = avformat_open_input(&avformat_context,cinputFilePath,NULL,NULL);

if (avformat_open_result != 0)

{

//获取异常信息

char* error_info = new char[32];

av_strerror(avformat_open_result, error_info, 1024);

qDebug()< 第三步:查找视频流信息 //参数一:封装格式上下文->AVFormatContext

//参数二:配置

//返回值:0>=返回OK,否则失败

int avformat_find_stream_info_result = avformat_find_stream_info(avformat_context, NULL);

if (avformat_find_stream_info_result < 0){

//获取失败

char* error_info = new char[32];

av_strerror(avformat_find_stream_info_result, error_info, 1024);

qDebug()<第四步:查找解码器 //第一点:获取当前解码器是属于什么类型解码器->找到了视频流

//音频解码器、视频解码器、字幕解码器等等...

//获取视频解码器流引用

int av_stream_index = -1;

for (int i = 0; i < avformat_context->nb_streams; ++i) {

//循环遍历每一流

//视频流、音频流、字幕流等等...

if (avformat_context->streams[i]->codec->codec_type == AVMEDIA_TYPE_VIDEO){

//找到了

av_stream_index = i;

break;

}

}

if (av_stream_index == -1){

qDebug()<查找到视频解码器上下文->视频压缩数据

AVCodecContext* avcodec_context = avformat_context->streams[av_stream_index]->codec;

//第三点:根据解码器上下文->获取解码器ID

AVCodec* avcodec = avcodec_find_decoder(avcodec_context->codec_id);

if (avcodec == NULL)

{

qDebug()< 第五步:打开解码器 int avcodec_open2_result = avcodec_open2(avcodec_context,avcodec,NULL);

if (avcodec_open2_result != 0)

{

char* error_info = new char[32];

av_strerror(avformat_find_stream_info_result, error_info, 1024);

qDebug()<以上基本就是打开多媒体文件的主要步骤,解码和转码的所有参数都可以在这里获取。接下来我们就需要循环进行读取、解码、转码直到播放完成。

可以使用以下方式进行打印

qDebug()<iformat->name);

//输出:解码器名称

qDebug()<name);

qDebug()<width).arg(avcodec_context->height);

//此函数自动打印输入或输出的详细信息

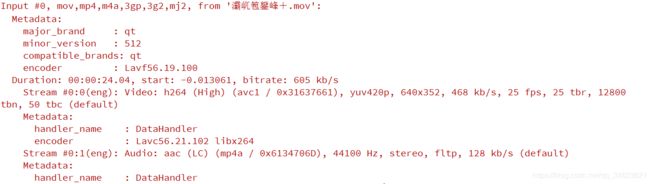

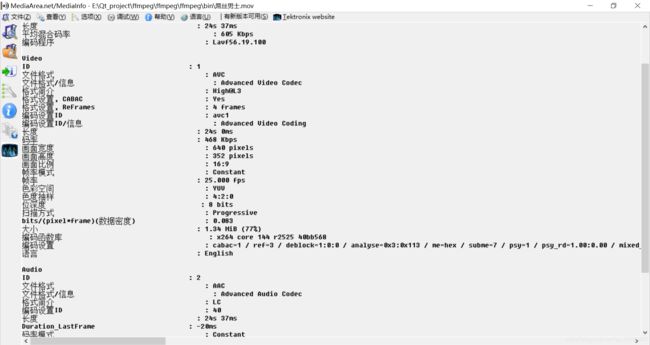

av_dump_format(avformat_context, 0, cinputFilePath, 0); 如下图所示(可以和MediaInfo软件进行对照查看):

第六步:循环读取视频帧,进行循环解码,转码输出YUV420P视频->格式:yuv格式解码流程:

//读取帧数据换成到哪里->缓存到packet里面

AVPacket* av_packet = (AVPacket*)av_malloc(sizeof(AVPacket));

//输入->环境一帧数据->缓冲区->类似于一张图

AVFrame* av_frame_in = av_frame_alloc();

//输出->帧数据->视频像素数据格式->yuv420p

AVFrame* av_frame_out_yuv420p = av_frame_alloc();

//缓冲区分配内存

uint8_t *out_buffer = (uint8_t *)av_malloc(avpicture_get_size(AV_PIX_FMT_YUV420P, avcodec_context->width, avcodec_context->height));

//初始化缓冲区

avpicture_fill((AVPicture *)av_frame_out_yuv420p, out_buffer, AV_PIX_FMT_YUV420P, avcodec_context->width, avcodec_context->height);

//解码的状态类型(0:表示解码完毕,非0:表示正在解码)

int av_decode_result, y_size, u_size, v_size, current_frame_index = 0;

SwsContext* sws_context = sws_getContext(avcodec_context->width,

avcodec_context->height,

avcodec_context->pix_fmt,

avcodec_context->width,

avcodec_context->height,

AV_PIX_FMT_YUV420P,

SWS_BICUBIC,NULL,NULL,NULL);

//打开文件

FILE* out_file_yuv = fopen("diao.yuv","wb+");

if (out_file_yuv == NULL){

qDebug()<第七步:关闭解码组件 av_packet_free(&av_packet);

//关闭流

fclose(out_file_yuv);

av_frame_free(&av_frame_in);

av_frame_free(&av_frame_out_yuv420p);

avcodec_close(avcodec_context);

avformat_free_context(avformat_context);解码后存储地yuv视频文件使用:YUV Player Deluxe 软件进行查看