Nginx学习及配置文件详解

Nginx学习笔记

- 1.Nginx基本概念

- 1.1nginx是什么,做什么事情

- 1.2Nginx作为web服务器

- 1.3反向代理

- 1.3.1正向代理

- 1.3.2反向代理

- 1.4负载均衡

- 1.5动静分离

- 2.nginx安装、命令和配置文件

- 2.1在linux中安装nginx

- 2.2nginx常用命令

- 2.2.1查看nginx版本号

- 2.2.2启动nginx

- 2.2.3关闭nginx

- 2.2.4重新加载nginx 配置文件

- 2.3nginx配置文件

- 3.nginx配置实例1-反向代理

- 4.nginx配置实例2-负载均衡

- 5.nginx配置实例3-动静分离

- 6.nginx配置高可用集群

- 附录:

- 1.nginx检查是否运行脚本

1.Nginx基本概念

1.1nginx是什么,做什么事情

Nginx (engine x)

是一个高性能的HTTP和反向代理web服务器,同时也提供了IMAP/POP3/SMTP服务。Nginx是由伊戈尔·赛索耶夫为俄罗斯访问量第二的Rambler.ru站点(俄文:Рамблер)开发的,第一个公开版本0.1.0发布于2004年10月4日。

其将源代码以类BSD许可证的形式发布,因它的稳定性、丰富的功能集、示例配置文件和低系统资源的消耗而闻名。2011年6月1日,nginx

1.0.4发布。 Nginx是一款轻量级的Web 服务器/反向代理服务器及电子邮件(IMAP/POP3)代理服务器,在BSD-like 协议下发行。其特点是占有内存少,并发能力强,事实上nginx的并发能力在同类型的网页服务器中表现较好,中国大陆使用nginx网站用户有:百度、京东、新浪、网易、腾讯、淘宝等。

1.2Nginx作为web服务器

Nginx可以作为静态页面的web服务器,同事还支持CGI协议的动态语言,比如perl、php等。但是不支持java。Java程序只能通过与tomcat配合完成。Nginx专为性能优化而开发,性能是其最重要的考量,实现上非常注重效率,有报告表名支持高达50000个并发连接数。

支持热部署,不间断更新

1.3反向代理

Nginx不仅可以做反向代理,实现负载均衡。还能用作正向代理来进行上网等功能。

1.3.1正向代理

如果吧局域网外的Internet想象成一个巨大的资源库,则局域网中的客户端要访问Internet,则需要通过代理服务器来访问,这种代理服务就称为正向代理。

在浏览器端配置代理服务器,你知道你请求的服务器真实的IP地址

1.3.2反向代理

反向代理,其实客户端是无感知的,因为客户端不需要任何配置就可以访问,我们只需要将请求发送到反向代理服务器,由反向代理服务器去选择目标服务器获取数据后,再返回给客户端,此时反向代理服务器和目标服务器对外就是一个服务器,暴露的是代理服务器地址,隐藏真实的服务器IP地址。

在服务器端配置代理服务器 ,访问的只是代理服务器

1.4负载均衡

客户端发送多个请求到了服务器,服务器处理请求,有一些可能要与数据库进行交互,服务器处理完毕后,再将结果返回给客户端。

这种架构模式对于早期的系统相对单一,并发请求相对较少的情况下是比较合适的,成本也低。但是随着信息数量的不断增长,访问量和数据量的飞速增长,以及系统业务的复杂度增加,这种架构会造成服务器响应的客户端的请求日益缓慢,并发量特别大的时候,还容易造成服务器直接崩溃。很明显这是由于服务器性能的瓶颈造成的问题,那么如何解决这种情况呐?

我们首先想到的可能是升级服务器的配置,比如提高CPU的执行频率,加大内存等提高机器的物理性能来解决此问题,但是我们知道摩尔定律的日益失效,硬件的性能提升已经不能满足日益提升的需求了。最明显的一个例子,天猫双十一当天,某个热销的商品瞬时访问量是及其庞大的,那么类似上面的系统架构,将机器都增加到现有的顶级物理配置,都是不能够满足需求的。那么该怎么办呐?

上面的分析我们去掉了增加服务器物理配置来解决问题的办法,也就是说纵向解决问题的办法是行不通了,那么横向增加服务器的数量,然后将请求分发的各个服务器上,将原来请求集中到单个服务器上的情况改为将请求分发到多个服务器上,将负载分发到不同的服务器,也就是我们所说的负载均衡*

1.5动静分离

为了加快网站的解析速度,可以把动态页面和静态页面由不同的服务器来解析,加快解析速度。降低原来单个服务器的压力。

静态资源:html、css、js

动态资源:jsp、servlet

2.nginx安装、命令和配置文件

2.1在linux中安装nginx

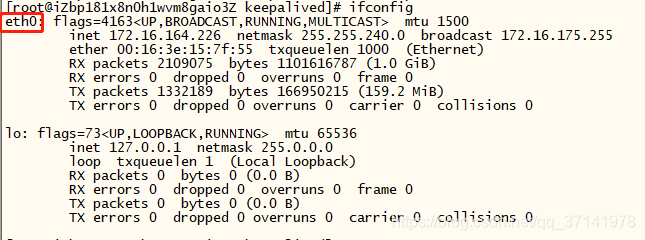

1、服务器端输入 ifconfig查看当前服务器的IP地址;用远程软件连接linux服务器;

2、进入Nginx官网(http://nginx.org)下载 nginx-X.XX.tar.gz安装包 3、需要一些依赖:

pcre-X.XX.tar.gz、openssl-X.X.Xt.tar.gz、zlib-X.X.X.tar.gz

方式1:例如安装pcre 可以通过wget命令把相关依赖下载下来(能连接外网)(纯内网的话,可以考虑内网上传安装包),然后tar -zxf

解压相关依赖包,然后回到解压包的目录下,./configure ,执行make &&make

install(编译并且安装)

方式2:yum -y install gcc zlib zlib-devel pcre-devel openssl openssl-devel 一键安装上面四个依赖 4、安装nginx 上传压缩包、解压、./configure、make&&make

install

cd /local、ll 就能查看到nginx目录了

nginx目录中有sbin目录,里面就有启动脚本nginx 直接./nginx就能启动了

ps -ef|grep nginx 就能看到nginx的进程了

配置文件在nginx/conf/nginx.conf,打开查看 里面有server默认走的 80端口5、关于端口,如果服务器打开防火墙了,可以通过命令设置nginx配置的指定的端口 firewall -cmd --list-all

查看开放的端口号 设置开放的端口号 firewall-cmd --add-service=http -permanent sudo

firewall-cmd --add-port=80/tcp --permanent 重启防火墙 firewall-cmd -reload

2.2nginx常用命令

使用nginx命令的前提条件,要进入到nginx的命令目录下

即:/nginx/sbin目录下

2.2.1查看nginx版本号

./nginx -v

2.2.2启动nginx

./nginx //启动nginx

2.2.3关闭nginx

ps -ef|grep nginx //查看nginx当前是否运行

./nginx -s stop //关闭nginx

2.2.4重新加载nginx 配置文件

./nginx -s -reload //重新加载nginx配置文件

2.3nginx配置文件

配置文件位置:/nginx/conf/nginx.conf

默认内容:

# For more information on configuration, see:

# * Official English Documentation: http://nginx.org/en/docs/

# * Official Russian Documentation: http://nginx.org/ru/docs/

user nginx;#设置nginx服务的系统使用用户

worker_processes auto;#工作进程数 一般情况与CPU核数保持一致

error_log /var/log/nginx/error.log;#nginx的日志

pid /run/nginx.pid;#nginx启动

# Load dynamic modules. See /usr/share/doc/nginx/README.dynamic.

#包含的配置项的目录

include /usr/share/nginx/modules/*.conf;

events {

worker_connections 1024;#每个进程允许最大连接数

#use #nginx使用的内核模型

}

#我们使用nginx的http服务,再配置文件nginx.conf中的http区域内,配置无数个server,每一个server对应这一个虚拟主机或者域名

http {

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /var/log/nginx/access.log main;#日志保存地址 格式代码 main

sendfile on;#高效传输文件的模式 一定要开启

tcp_nopush on;#tcp_nopush 配置和 tcp_nodelay "互斥"。它可以配置一次发送数据的包大小。也就是说,它不是按时间累计 0.2 秒后发送包,而是当包累计到一定大小后就发送。在 nginx 中,tcp_nopush 必须和 sendfile 搭配使用。

tcp_nodelay on;#禁用了Nagle 算法,跳过TCP堆栈实现了等待数据 0.2秒钟,使缓冲区中的数据立即发送出去

keepalive_timeout 65;#客⼾端服务端请求超时时间

types_hash_max_size 2048;#影响散列表的冲突率。types_hash_max_size越大,就会消耗更多的内存,但散列key的冲突率会降低,检索速度就更快。越小,消耗的内存就越小,但散列key的冲突率可能上升。默认为1024

include /etc/nginx/mime.types;

default_type application/octet-stream;

# Load modular configuration files from the /etc/nginx/conf.d directory.

# See http://nginx.org/en/docs/ngx_core_module.html#include

# for more information.

include /etc/nginx/conf.d/*.conf;

#一个server可以出现多个lication,我们对于不同的访问路径进行不同情况的配置

server {

listen 80 default_server;#监听端口

listen [::]:80 default_server;

server_name _;#地址

root /usr/share/nginx/html;#默认目录

# Load configuration files for the default server block.

include /etc/nginx/default.d/*.conf;

location / {#访问首页路径

#root /xxx/xxx/index.html #默认⽬录

#index index.html index.htm #默认⽂件

}

error_page 404 /404.html;#当出现以上状态码时重新定义到40X.html

location = /40x.html {#当访问到40X.html时

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

}

}

# Settings for a TLS enabled server.

#

# server {

# listen 443 ssl http2 default_server;

# listen [::]:443 ssl http2 default_server;

# server_name _;

# root /usr/share/nginx/html;

#

# ssl_certificate "/etc/pki/nginx/server.crt";

# ssl_certificate_key "/etc/pki/nginx/private/server.key";

# ssl_session_cache shared:SSL:1m;

# ssl_session_timeout 10m;

# ssl_ciphers HIGH:!aNULL:!MD5;

# ssl_prefer_server_ciphers on;

#

# # Load configuration files for the default server block.

# include /etc/nginx/default.d/*.conf;

#

# location / {

# }

#

# error_page 404 /404.html;

# location = /40x.html {

# }

#

# error_page 500 502 503 504 /50x.html;

# location = /50x.html {

# }

# }

}

3.nginx配置实例1-反向代理

#代理端⼝

#场景:服务器80端⼝开放,8080端⼝对外关闭,客⼾端需要访问到8080

#在nginx中配置proxy_pass代理转发时,如果在proxy_pass后⾯的url加/,表⽰绝对根路径;如果没有/,表⽰相对路径,把匹配的路径部分也给代理⾛

server {

listen 80;

location / {

proxy_pass http://127.0.0.1:8080/;

proxy_redirect default;

proxy_set_header Host $http_host;

proxy_set_header X-Real-IP $remote_addr;#获取客⼾端真实IP

proxy_connect_timeout 30; #超时时间

proxy_send_timeout 60;

proxy_read_timeout 60;

proxy_buffer_size 32k;

proxy_buffering on; #开启缓冲区,减少磁盘io

proxy_buffers 4 128k;

proxy_busy_buffers_size 256k;

proxy_max_temp_file_size 256k; #当超过内存允许储蓄⼤⼩,存到⽂件

}

}

4.nginx配置实例2-负载均衡

#负载均衡的实现⽅法就是我们上章介绍的反向代理 。将客⼾的请求通过 nginx 分发(反向代理)到⼀组多台不同的服务器上,这⼀组服务器我们称为 服务池(upstream server),池内的每⼀个服务器称为⼀个 单元,服务池内将对每⼀个单元进⾏请求轮训,实现负载均衡

upstream #⾃定义组名 {

server x1.baidu.com; #可以是域名

server x2.baidu.com;

#server x3.baidu.com

#down 不参与负载均衡

#weight=5; 权重,越⾼分配越多

#backup; 预留的备份服务器

#max_fails 允许失败的次数

#fail_timeout 超过失败次数后,服务暂停时间

#max_coons 限制最⼤的接受的连接数

#根据服务器性能不同,配置适合的参数

#server 106.xx.xx.xxx; 可以是ip

#server 106.xx.xx.xxx:8080; 可以带端⼝号

#server unix:/tmp/xxx; ⽀出socket⽅式

}

#假设我们有三台服务器,并且假设它们的IP地址,前端负载均衡服务器A(127.0.0.1),后台服务器B(127.0.0.2),后台服务器C(127.0.0.3)新建⽂件 proxy.conf,内容如下,上⼀章介绍的反向代理配置

proxy_redirect default;

proxy_set_header Host $http_host;

proxy_set_header X-Real-IP $remote_addr;

proxy_connect_timeout 30;

proxy_send_timeout 60;

proxy_read_timeout 60;

proxy_buffer_size 32k;

proxy_buffering on;

proxy_buffers 4 128k;

proxy_busy_buffers_size 256k;

proxy_max_temp_file_size 256k;

#服务器A的配置

http {

...

upstream xxx {

server 127.0.0.2;

server 127.0.0.3;

}

server {

liseten 80;

server_name localhost;

location / {

proxy_pass http://xxx #upstream 对应⾃定义名称

include proxy.conf;

}

}

}

#服务器B、服务器C的配置

server {

liseten 80;

server_name localhost;

location / {

index index.html

}

}

5.nginx配置实例3-动静分离

upstream test{

server localhost:8080;

server localhost:8081;

}

server {

listen 80;

server_name localhost;

location / {

root e:\wwwroot;

index index.html;

}

# 所有静态请求都由nginx处理,存放⽬录为html

location ~ \.(gif|jpg|jpeg|png|bmp|swf|css|js)$ {

root e:\wwwroot;

}

# 所有动态请求都转发给tomcat处理

location ~ \.(jsp|do)$ {

proxy_pass http://test;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root e:\wwwroot;

}

}

6.nginx配置高可用集群

keepalived软件,绑定虚拟ip地址进行nginx主备切换

nginx主备master、backup

(1)需要两台nginx服务器

(2)需要keepalived

(3)需要虚拟ip

准备工作:

(1)两台服务器

(2)在两台服务器安装nginx

(3)在两台服务器安装keepalived

服务器安装keepalived

(1)使用yum命令安装

yum install keepalived -y

(2)安装之后,在etc里面生成目录keepalived,有文件keepalived.conf配置文件

完成高可用配置(主从)

! Configuration File for keepalived

global_defs {

notification_email {

acassen@firewall.loc

failover@firewall.loc

sysadmin@firewall.loc

}

notification_email_from Alexandre.Cassen@firewall.loc

smtp_server 192.168.200.1

smtp_connect_timeout 30

router_id LVS_DEVEL

vrrp_skip_check_adv_addr

vrrp_strict

vrrp_garp_interval 0

vrrp_gna_interval 0

}

#检测nginx是否运行的脚本(脚本内容附录)

vrrp_scrip chk_http_port{

script ""#脚本路径

interval 2#检测脚本执行的间隔时间

weight 2

}

vrrp_instance VI_1 {

state MASTER #备分服务器上将MASTER改为BACKUP

interface eth0 //网卡

virtual_router_id 51 #主、备机的virtual_router_id必须相同

priority 100 #主、备机取不同的优先级,主机值较大,备份机值较小

advert_int 1

authentication {

auth_type PASS

auth_pass 1111

}

virtual_ipaddress { //VRRP H虚拟地址

192.168.200.16

192.168.200.17

192.168.200.18

}

}

virtual_server 192.168.200.100 443 {

delay_loop 6

lb_algo rr

lb_kind NAT

persistence_timeout 50

protocol TCP

real_server 192.168.201.100 443 {

weight 1

SSL_GET {

url {

path /

digest ff20ad2481f97b1754ef3e12ecd3a9cc

}

url {

path /mrtg/

digest 9b3a0c85a887a256d6939da88aabd8cd

}

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

}

virtual_server 10.10.10.2 1358 {

delay_loop 6

lb_algo rr

lb_kind NAT

persistence_timeout 50

protocol TCP

sorry_server 192.168.200.200 1358

real_server 192.168.200.2 1358 {

weight 1

HTTP_GET {

url {

path /testurl/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334d

}

url {

path /testurl2/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334d

}

url {

path /testurl3/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334d

}

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

real_server 192.168.200.3 1358 {

weight 1

HTTP_GET {

url {

path /testurl/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334c

}

url {

path /testurl2/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334c

}

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

}

virtual_server 10.10.10.3 1358 {

delay_loop 3

lb_algo rr

lb_kind NAT

persistence_timeout 50

protocol TCP

real_server 192.168.200.4 1358 {

weight 1

HTTP_GET {

url {

path /testurl/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334d

}

url {

path /testurl2/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334d

}

url {

path /testurl3/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334d

}

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

real_server 192.168.200.5 1358 {

weight 1

HTTP_GET {

url {

path /testurl/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334d

}

url {

path /testurl2/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334d

}

url {

path /testurl3/test.jsp

digest 640205b7b0fc66c1ea91c463fac6334d

}

connect_timeout 3

nb_get_retry 3

delay_before_retry 3

}

}

}

启动keepalived:systemctl start keepalived.service

附录:

1.nginx检查是否运行脚本

#!/bin/bash

A='ps -c nginx -no-header |wc -l'

if [ $A -eq 0];then

/user/local/nginx/sbin/nginx #进程目录

sleep 2

if [ 'ps -C nginx --no-header |wc -l' -eq 0];then

killall keepalived

fi

fi